LeCun、谢赛宁团队重磅论文:RAE能大规模文生图了,且比VAE更好

LeCun、谢赛宁团队重磅论文:RAE能大规模文生图了,且比VAE更好编辑|Panda 在文生图模型的技术版图中,VAE 几乎已经成为共识。从 Stable Diffusion 到 FLUX,再到一系列扩散 Transformer,主流路线高度一致:先用 VAE 压缩视

编辑|Panda 在文生图模型的技术版图中,VAE 几乎已经成为共识。从 Stable Diffusion 到 FLUX,再到一系列扩散 Transformer,主流路线高度一致:先用 VAE 压缩视

比如前些天,Vercel 创始人 Guillermo Rauch 推出了所谓的「AI skill 的 npm」,让用户仅需一个简单命令 npx skills add [package],就能为自己的 AI 智能体轻松注入专业能力。

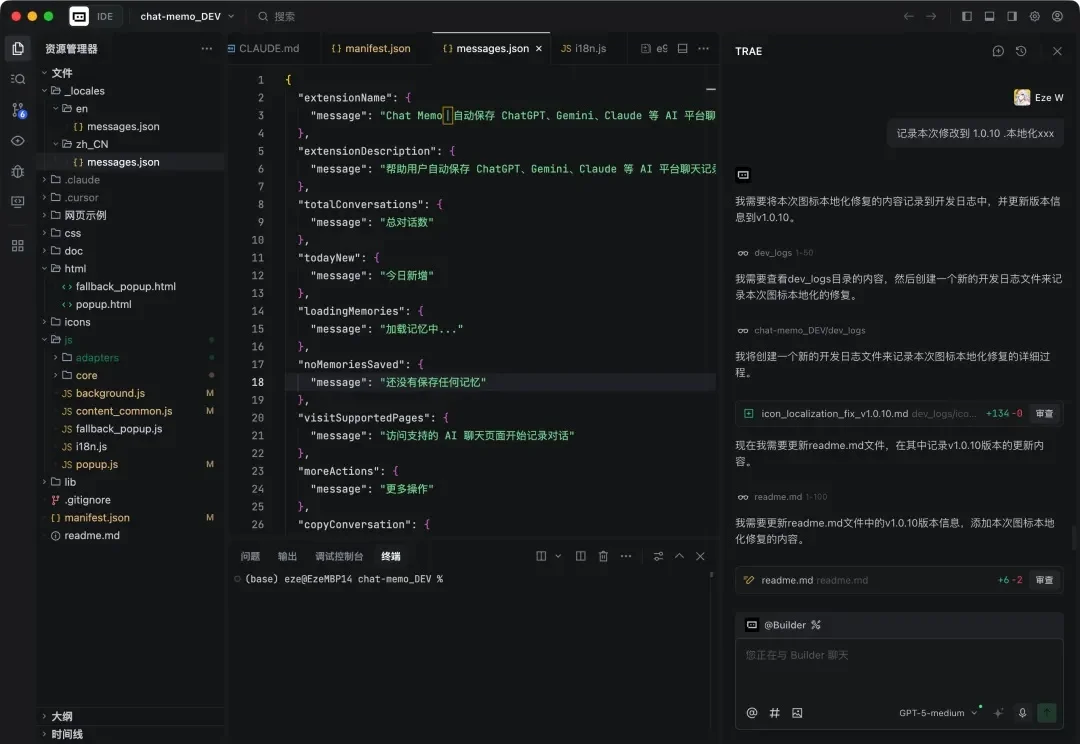

很多人可能不知道,我是 Trae 的老用户。

TRAE在一年里写了1000亿行代码!如果按照一个程序员每天写100行有效代码计算,这相当于300万个程序员不吃不喝、没日没夜干了一整年。而这也仅仅是《TRAE 2025年度产品报告》中的冰山一角,更多惊人的数据还包括:

TRAE国内版终于上线SOLO模式了,且全部功能完全免费!一口气带来了SOLO Coder、Plan模式、多任务并行等多个核心能力。

针对这类复杂编程任务场景,字节 TRAE,推出了 SOLO 模式,想要解决上述这类复杂问题。SOLO 模式 7 月份在 TRAE 海外版上线了内测版本;11 月 12 日,SOLO 在 TRAE 海外版全面开放;11 月 25 日,SOLO 模式正式登陆 TRAE 国内版,而且完全免费使用。

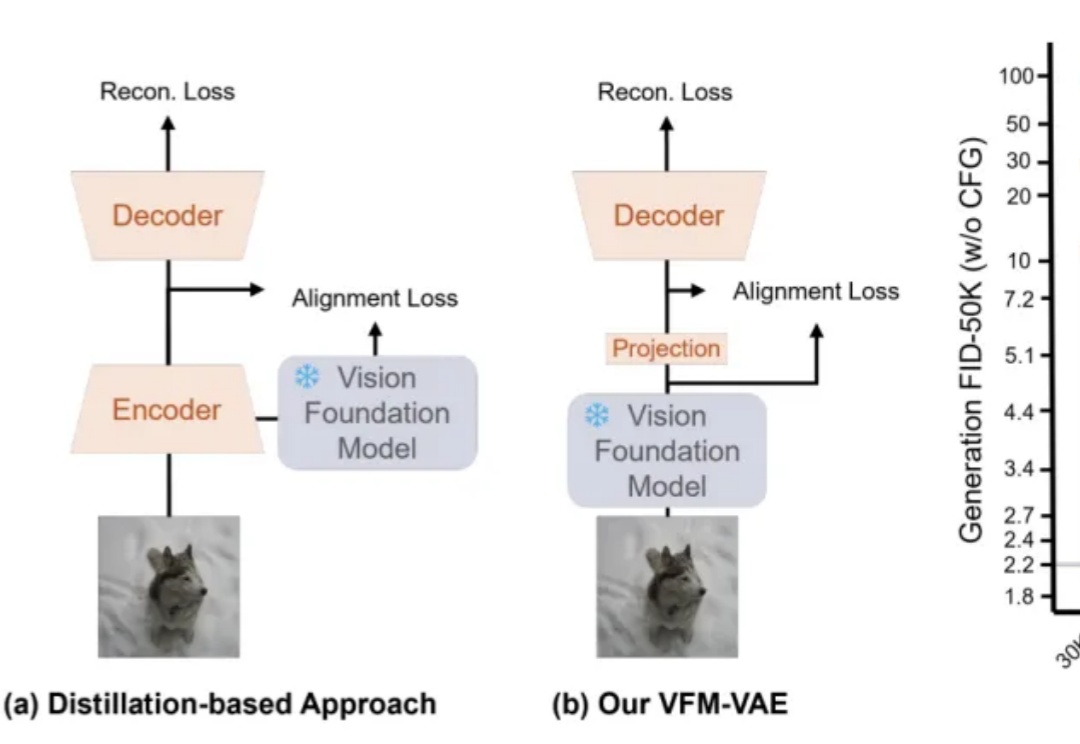

近期,RAE(Diffusion Transformers with Representation Autoencoders)提出以「 冻结的预训练视觉表征」直接作为潜空间,以显著提升扩散模型的生成性能。

昨天晚上,我一直很喜欢的字节家的TRAE SOLO,终于正式上线了。 自从他们之前7月21号发了以来,其实就一直在内测,一直能用到的人都不多,而现在,终于全量了。 而且,限时免费。 TRAE国内版正式

试了一下 TRAE 刚更新的 Solo 正式版,发现还是挺厉害的。尤其是这个Solo coder Agent 很强。

前段时间Trae下架了Claude,标志着但凡跟中国沾边AI工具都禁止使用 Claude 但我一点都不慌,因为已经很久没用 Claude 了 尤其在编程赛道上,国产大模型已经通过内部互卷站起来了。