SOTA自动绑骨开源框架来了!3D版DeepSeek-UniRig开源月大礼包持续开箱ing

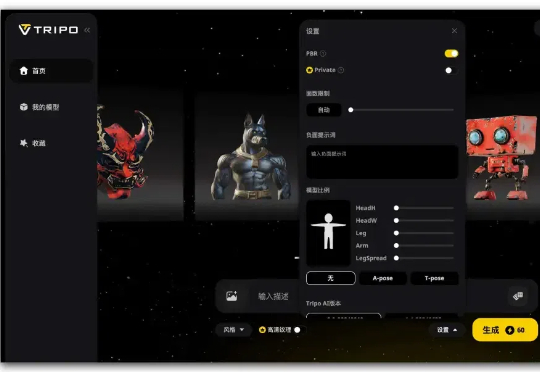

SOTA自动绑骨开源框架来了!3D版DeepSeek-UniRig开源月大礼包持续开箱ing面向3D生成,来自VAST和清华大学的自动绑骨框架开源了!3D内容创作领域正经历前所未有的爆发,无论是成熟的传统工作流,还是以VAST(Tripo)为代表的AI驱动生成工具的飞速发展,都体现了市场对高质量3D资产需求的日益激增

面向3D生成,来自VAST和清华大学的自动绑骨框架开源了!3D内容创作领域正经历前所未有的爆发,无论是成熟的传统工作流,还是以VAST(Tripo)为代表的AI驱动生成工具的飞速发展,都体现了市场对高质量3D资产需求的日益激增

3D生成版DeepSeek再上新高度!

3 月 28 日,专注于构建通用 3D 大模型的 VAST 一口气开源了两个 3D 生成项目 ——TripoSG 和 TripoSF。前者是一款基础 3D 生成模型,在图像到 3D 生成任务上远超所有闭源模型;后者则是 VAST 新一代三维基础模型 TripoSF 能在所有闭源模型中同样取得 SOTA 的基础组件,用于高分辨率的三维重建和生成任务。

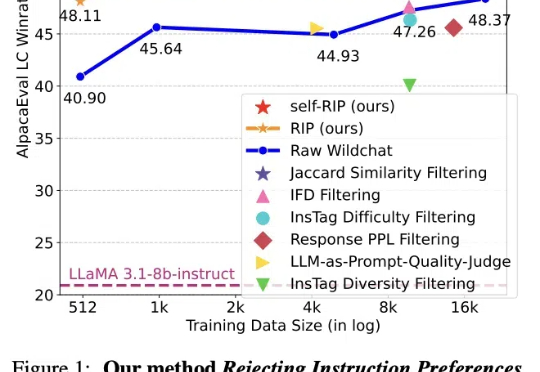

近日,Meta等机构发表的论文介绍了一种通过进化算法构造高质量数据集的方法:拒绝指令偏好(RIP),得到了Yann LeCun的转赞。相比未经过滤的数据,使用RIP构建的数据集让模型在多个基准测试中都实现了显著提升。

刚刚,港大字节联手发布最新视频生成模型,让歪果网友直呼疯狂。有人甚至直接RIP市场营销、TikTok用户和YouTube创作者。你敢信,下面这一幕不是来自欧巴电视剧,而是AI生成的!

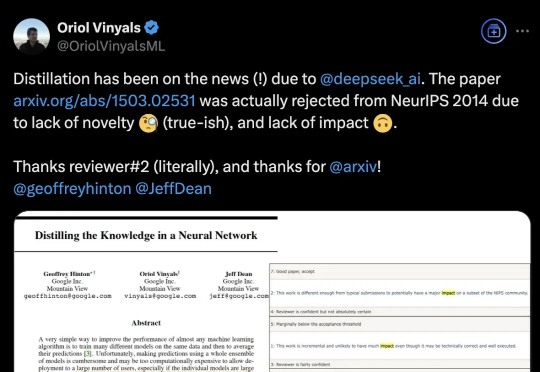

DeepSeek带火知识蒸馏,原作者现身爆料:原来一开始就不受待见。称得上是“蒸馏圣经”、由Hinton、Oriol Vinyals、Jeff Dean三位大佬合写的《Distilling the Knowledge in a Neural Network》,当年被NeurIPS 2014拒收。

Ilya Sutskever 在 NeurIPS 会上直言:大模型预训练这条路可能已经走到头了。上周的 CES 2025,黄仁勋有提到,在英伟达看来,Scaling Laws 仍在继续,所有新 RTX 显卡都在遵循三个新的扩展维度:预训练、后训练和测试时间(推理),提供了更佳的实时视觉效果。

就在刚刚,腾讯混元3D全新版本上线了。这一周内我在混元3D、Tripo3D、Meshy这三家AI 3D里跑了上百次案例,在文生3D、图生3D、纹理材质生成、3D工作流四个维度,让小白也能最大程度体验到AI 3D能做到什么,以及将如何影响AI生图、AI视频的工作流。

大连理工大学的研究人员提出了一种基于Wasserstein距离的知识蒸馏方法,克服了传统KL散度在Logit和Feature知识迁移中的局限性,在图像分类和目标检测任务上表现更好。

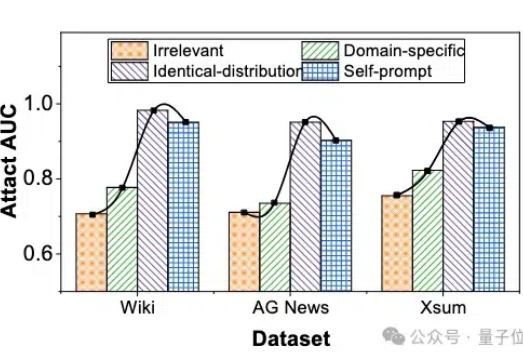

微调大模型的数据隐私可能泄露? 最近华科和清华的研究团队联合提出了一种成员推理攻击方法,能够有效地利用大模型强大的生成能力,通过自校正机制来检测给定文本是否属于大模型的微调数据集。