谢赛宁敲响学界警钟!AI研究可能陷入一场注定失败的有限游戏

谢赛宁敲响学界警钟!AI研究可能陷入一场注定失败的有限游戏凌晨三点的 AI 实验室,键盘敲击声在空荡的房间回响。屏幕上,博士生小王、小李、小赵正疯狂调整模型参数,只为在 NeurIPS 截稿前将准确率从 98.2% 刷到 98.5%。

凌晨三点的 AI 实验室,键盘敲击声在空荡的房间回响。屏幕上,博士生小王、小李、小赵正疯狂调整模型参数,只为在 NeurIPS 截稿前将准确率从 98.2% 刷到 98.5%。

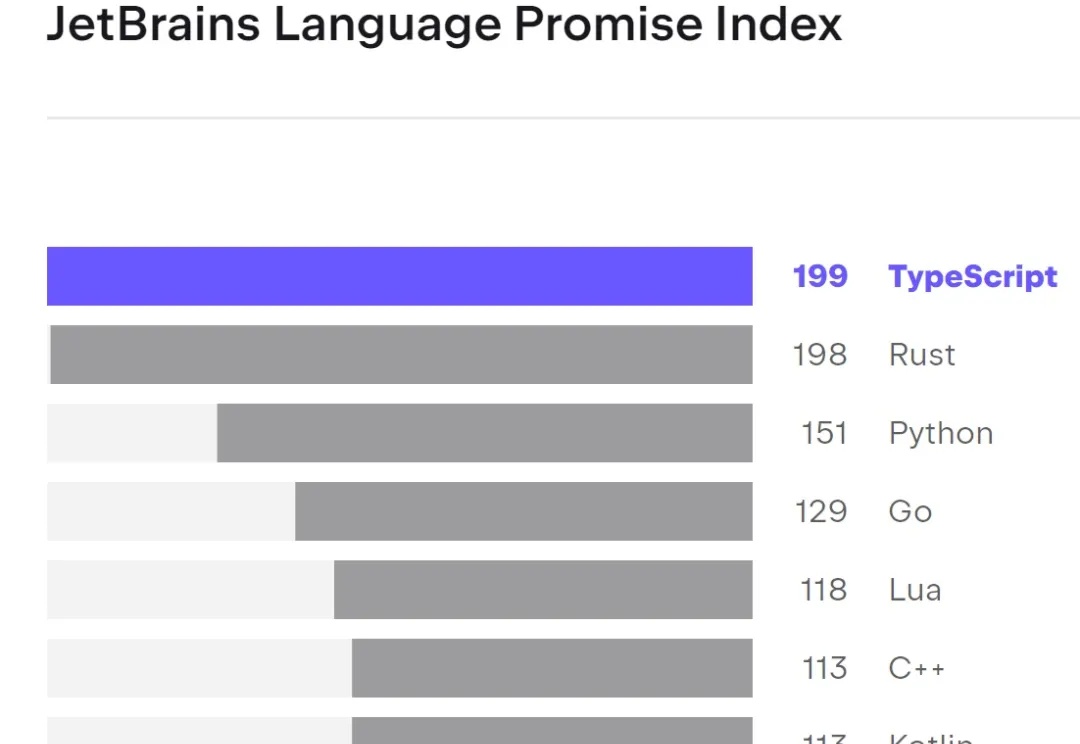

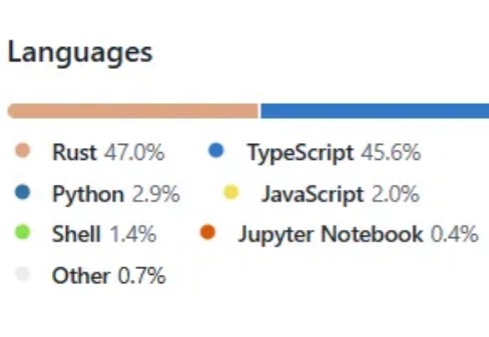

近日, Mastra AI 创始人 Sam Bhagwat 在 X 上发布了一条推文,称其中提到大约 60~70% 的 YC X25 Agent 公司正在使用 TypeScript 构建他们的 AI Agent。

刚刚,OpenAI 正式对外推出了 AI 编码神器 Codex,其目前向 ChatGPT Plus 用户开放。据悉,Codex 在限定时段内提供宽松的使用额度,但在需求高峰期间,可能会对 Plus 用户设置速率限制,以确保其能广泛可用。

Agent 能力边界正在快速演进,未来随着更强的规划和推理能力的不断提升,Agent 们将参与到社会经济运作中。在这一趋势下,将可能诞生类似 Visa 或 Stripe 级别的商业基础设施的机会。

最近,大家开始用3d打印整活了:

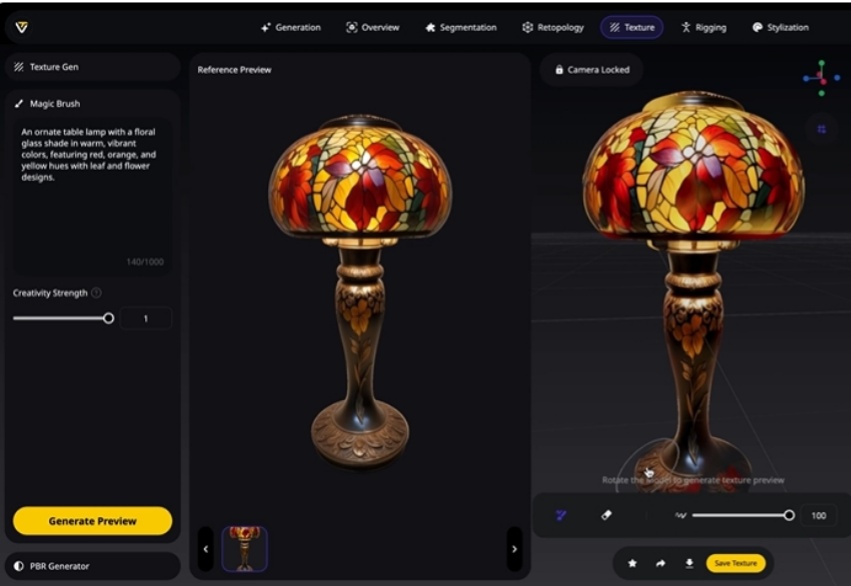

AI建模界的“作弊神器”真的来了!

NeurIPS投稿数量破纪录了!Deadline还有不到一个月,如何让论文更容易中?

金融科技巨头Stripe 周三在其年度用户大会 Stripe Sessions 上宣布了一系列新产品发布。

谢赛宁十年前被NeurIPS(当时还叫NIPS)拒收的论文,刚在今年获得了AISTATS 2025年度时间检验奖。

3D生成明星玩家VAST,又又又又又开源了!Tripo Doodle(内部代号TripoSG Scribble) ,能够将简单的2D草图和文本提示(Text Prompt)实时转化为精细的3D模型。它改进了传统3D建模学习曲线陡峭、耗时耗力的痛点,尤其是在初期“打形”阶段。