大模型RL不止数学代码!7B奖励模型搞定医学法律经济全学科, 不用思维链也能做题

大模型RL不止数学代码!7B奖励模型搞定医学法律经济全学科, 不用思维链也能做题一个7B奖励模型搞定全学科,大模型强化学习不止数学和代码。

一个7B奖励模型搞定全学科,大模型强化学习不止数学和代码。

在大模型推理能力提升的探索中,工具使用一直是克服语言模型计算局限性的关键路径。不过,当今的大模型在使用工具方面还存在一些局限,比如预先确定了工具的使用模式、限制了对最优策略的探索、实现透明度不足等。

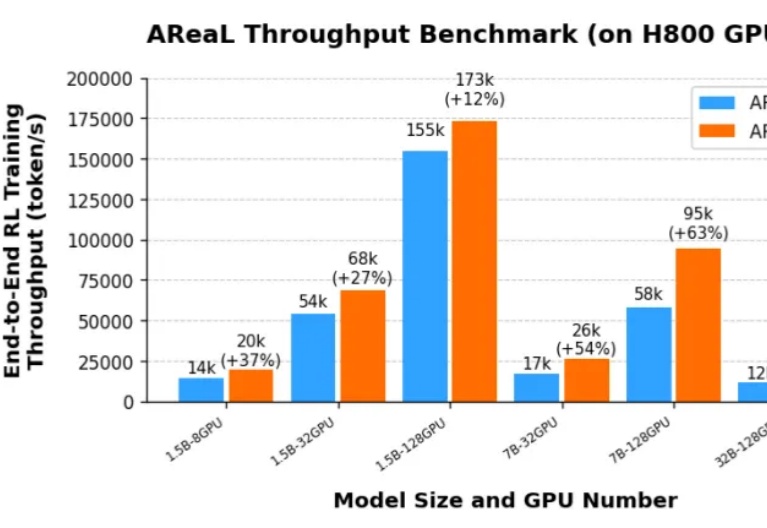

由于 DeepSeek R1 和 OpenAI o1 等推理模型(LRM,Large Reasoning Model)带来了新的 post-training scaling law,强化学习(RL,Reinforcement Learning)成为了大语言模型能力提升的新引擎。然而,针对大语言模型的大规模强化学习训练门槛一直很高:

你是否注意过人类观察世界的独特方式?

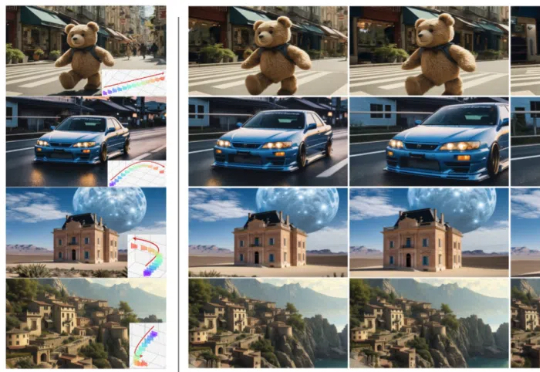

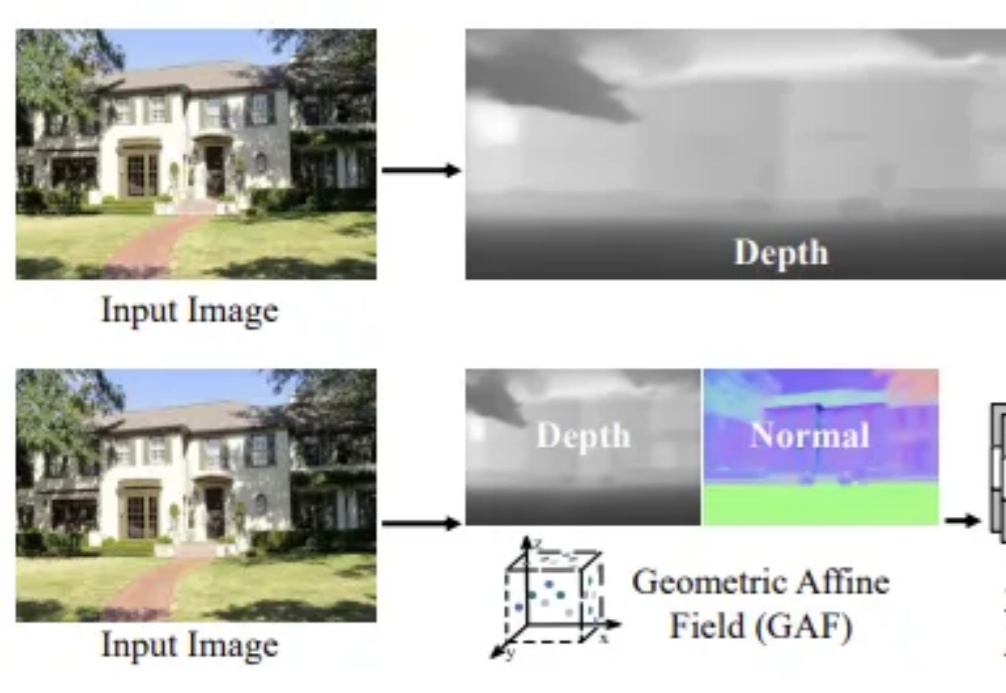

从单张图像生成灵活视角3D场景的技术来了,在考古保护、自主导航等直接获取3D数据成本高昂或不可行的领域具有重要应用价值。

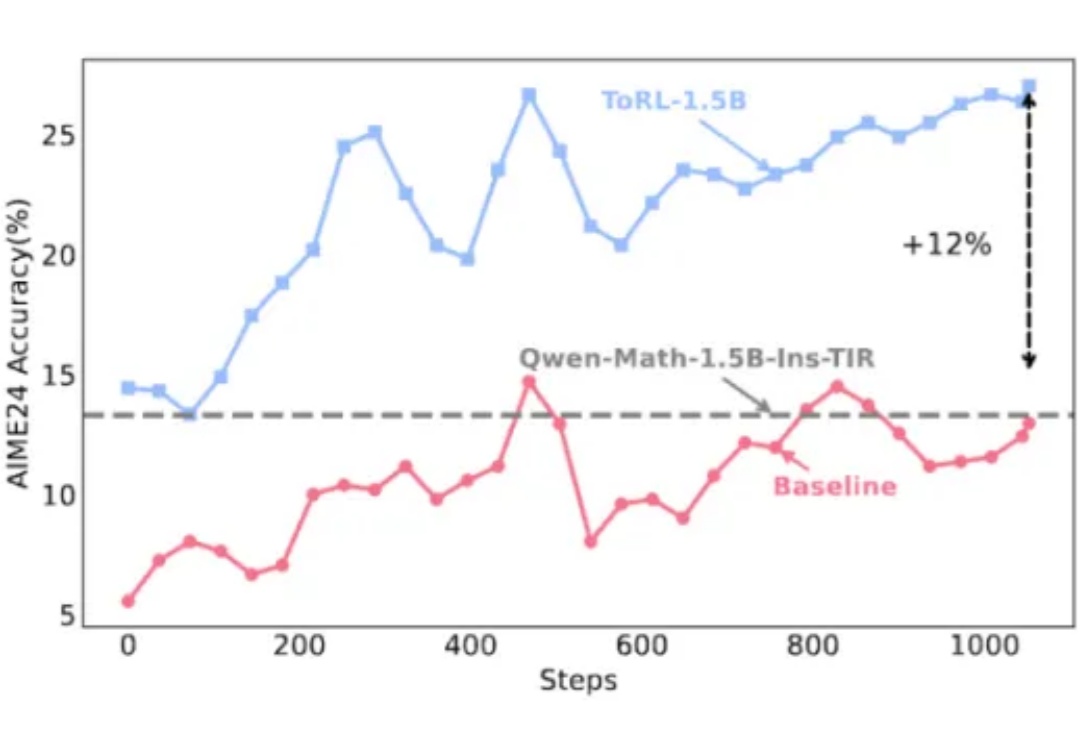

强化学习提升了 LLM 各方面的能力,而强化学习本身也在进化。

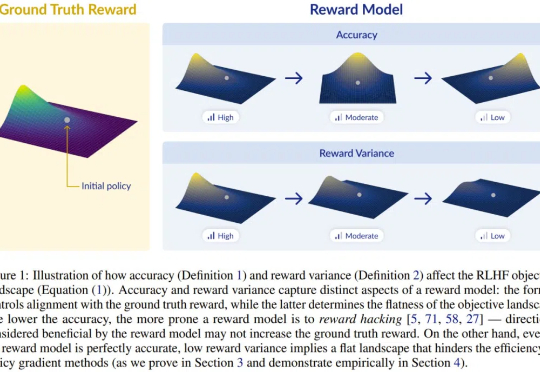

训练狗时不仅要让它知对错,还要给予差异较大的、不同的奖励诱导,设计 RLHF 的奖励模型时也是一样。

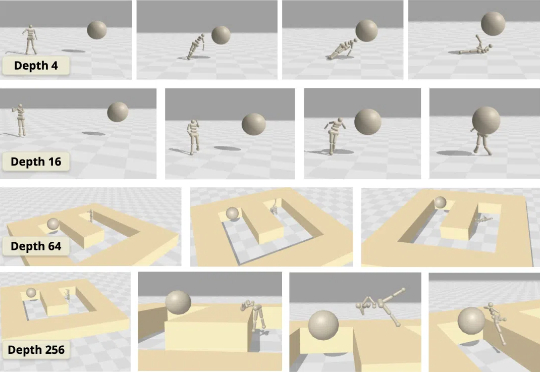

虽然大多数强化学习(RL)方法都在使用浅层多层感知器(MLP),但普林斯顿大学和华沙理工的新研究表明,将对比 RL(CRL)扩展到 1000 层可以显著提高性能,在各种机器人任务中,性能可以提高最多 50 倍。

3月18日,美国哥伦比亚特区巡回上诉法院就科学家Stephen Thaler(史蒂芬·泰勒博士,下称泰勒)诉Shira Perlmutter(美国版权局注册官及美国版权办公室主任)以及美国版权局作出标志性判决,认定所有受版权保护的作品必须首先由人类创作。尽管AI技术的发展使得非人类创作的作品越来越多,但根据现有的法律框架,这些作品无法获得版权保护。

单视角三维场景重建一直是计算机视觉领域中的核心挑战之一,尤其在捕捉高保真室外场景细节时,如何确保结构一致性和几何精度显得尤为困难。