李飞飞:World Labs这样实现「空间智能」

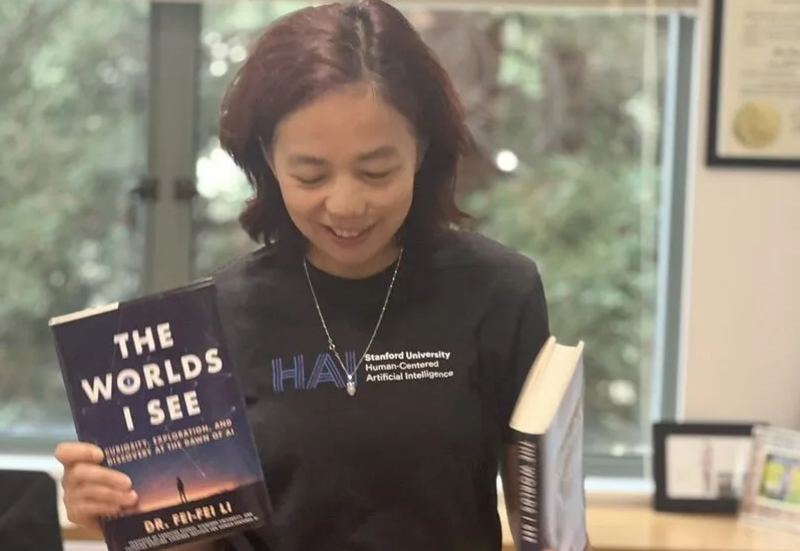

李飞飞:World Labs这样实现「空间智能」遵循世界的 3D 特性,很多事就会变得自然而然。 说到斯坦福大学教授李飞飞(Fei-Fei Li),她提倡的「空间智能」最近正在引领 AI 发展方向。

遵循世界的 3D 特性,很多事就会变得自然而然。 说到斯坦福大学教授李飞飞(Fei-Fei Li),她提倡的「空间智能」最近正在引领 AI 发展方向。

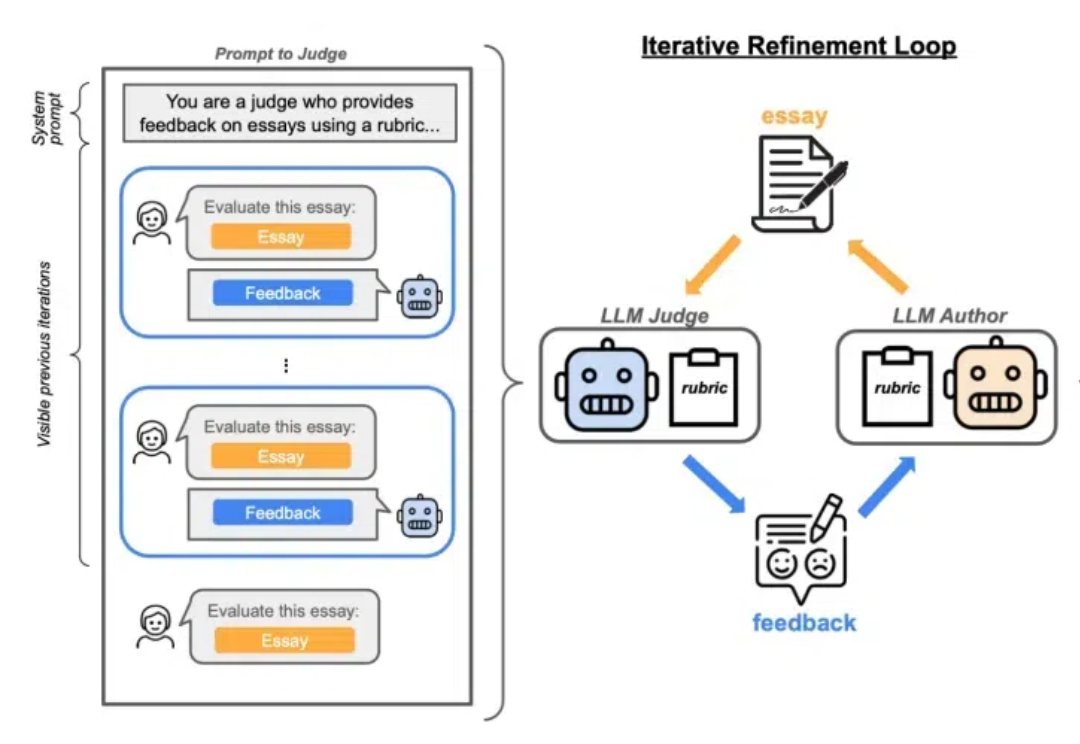

传闻反转了,Claude 3.5 Opus没有训练失败。 只是Anthropic训练好了,暗中压住不公开。 semianalysis分析师爆料,Claude 3.5超大杯被藏起来,只用于内部数据合成以及强化学习奖励建模。 Claude 3.5 Sonnet就是如此训练而来。

最近OpenAI Day2展示的demo可能把ReFT带火了。实际上这不是一个很新的概念,也不是OpenAI原创的论文。 接下来,本文对比SFT、ReFT、RHLF、DPO、PPO这几种常见的技术。

现在几乎每家公司都会有内部文档系统,如阿里的语雀、钉钉,字节的飞书,Confluence,印象笔记等等都可以提供给B端在局域网部署。因此,如果能把搜索功能做得高效,就能提高自家产品的竞争力。

2024 年 12 月 6 号加州时间上午 11 点,OpenAI 发布了新的 Reinforcement Finetuning 方法,用于构造专家模型。对于特定领域的决策问题,比如医疗诊断、罕见病诊断等等,只需要上传几十到几千条训练案例,就可以通过微调来找到最有的决策。

作为计算机视觉领域的开拓者,李飞飞在人工智能革命中扮演了重要角色。她的新回忆录《我所看到的世界》(The Worlds I See)详细讲述了她从学术到技术突破的旅程,以及如何在人工智能的最前沿找到自己的使命。

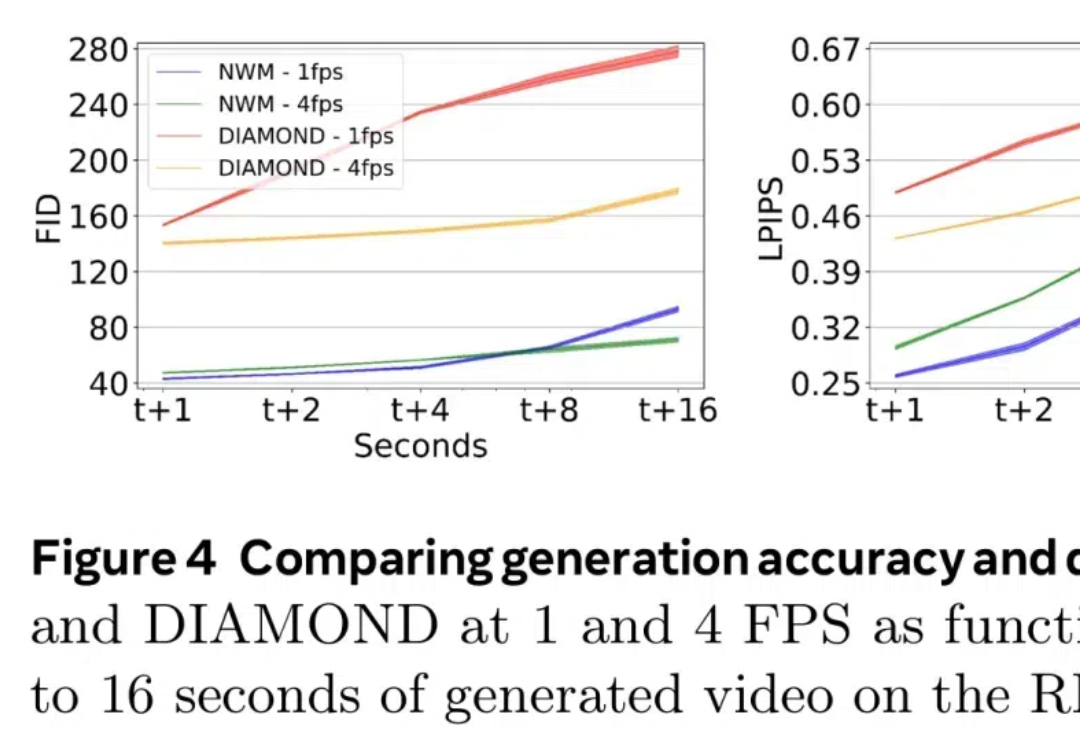

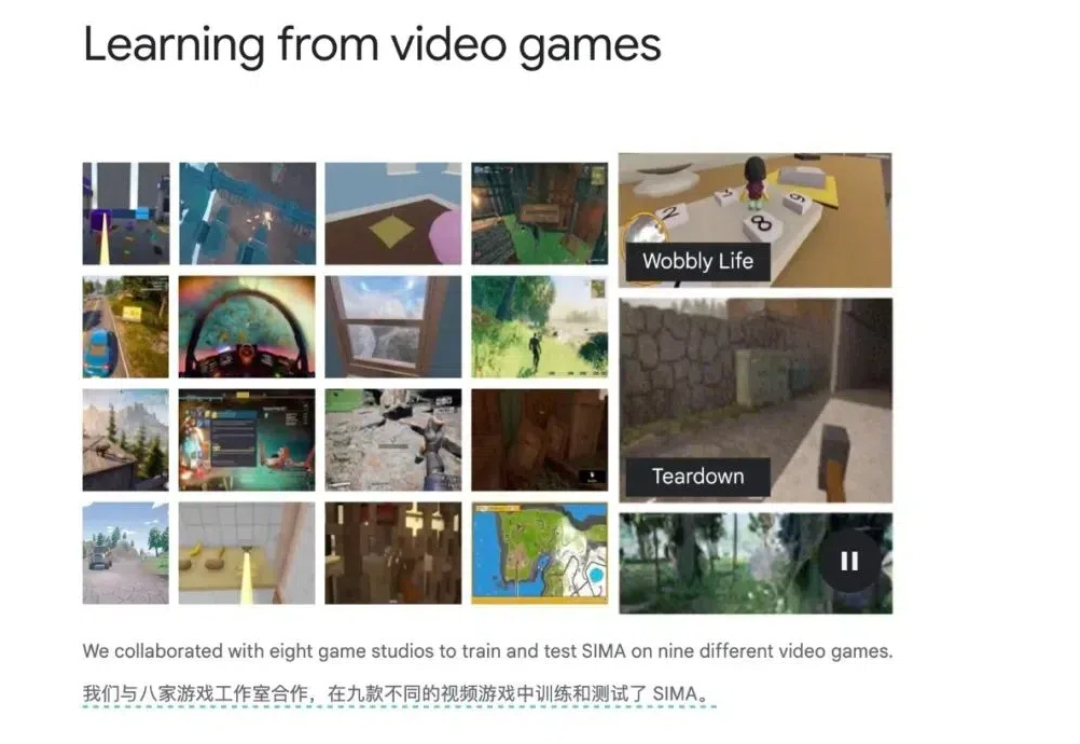

最近,世界模型(World Models)似乎成为了 AI 领域最热门的研究方向。

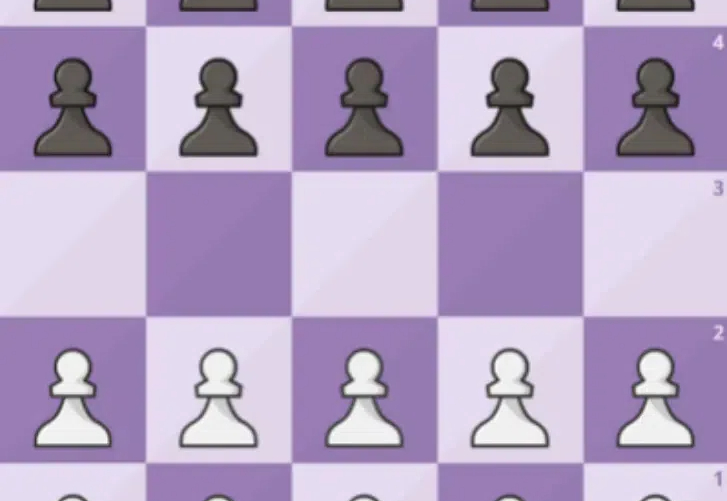

在人工智能发展史上,强化学习 (RL) 凭借其严谨的数学框架解决了众多复杂的决策问题,从围棋、国际象棋到机器人控制等领域都取得了突破性进展。

Lilian Weng离职OpenAI后首篇博客发布!文章深入讨论了大模型强化学习中的奖励欺骗问题。随着语言模型在许多任务上的泛化能力不断提升,以及RLHF逐渐成为对齐训练的默认方法,奖励欺骗在语言模型的RL训练中已经成为一个关键的实践性难题。

当前构建数字世界有三条路线:OpenAI的Sora追求视觉真实,谷歌的Genie 2注重实时交互,World Labs专注空间准确。这三条路线各有优势,也各有无法在短期内解决的问题。