“Transformer就像燃油车,attention-free才是新能源” | 对话RWKV创始人彭博

“Transformer就像燃油车,attention-free才是新能源” | 对话RWKV创始人彭博当DeepSeek引发业界震动时,元始智能创始人彭博正专注于一个更宏大的愿景。

当DeepSeek引发业界震动时,元始智能创始人彭博正专注于一个更宏大的愿景。

要做大模型领域的安卓和Linux。

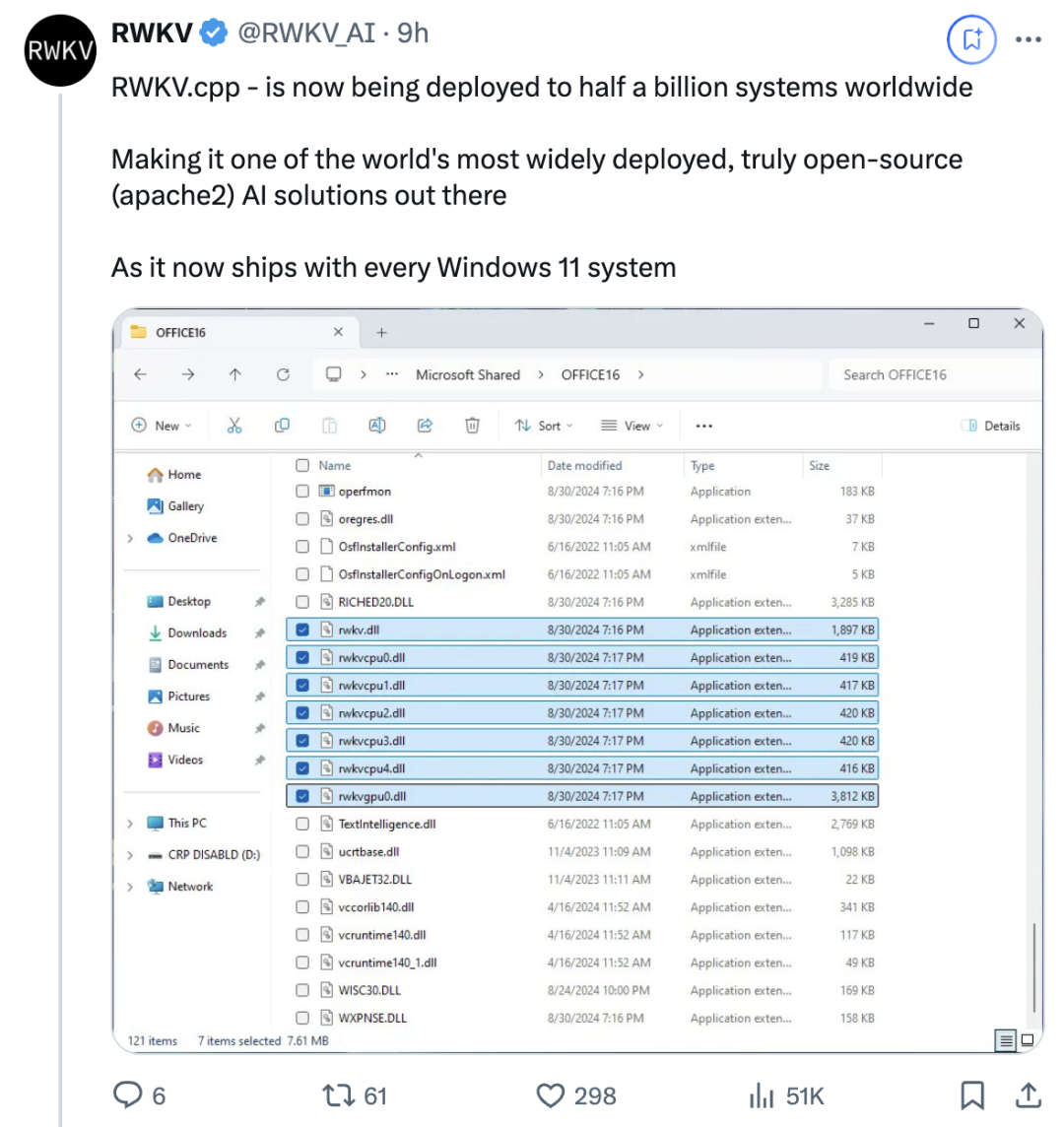

微软正尝试在Office中集成国产开源大模型RWKV!

一个人,待在家里,“懒散”的有一搭没一搭,训练一个要挑战已经“一统世界”的Transformer 的模型。这听起来足够夸张。

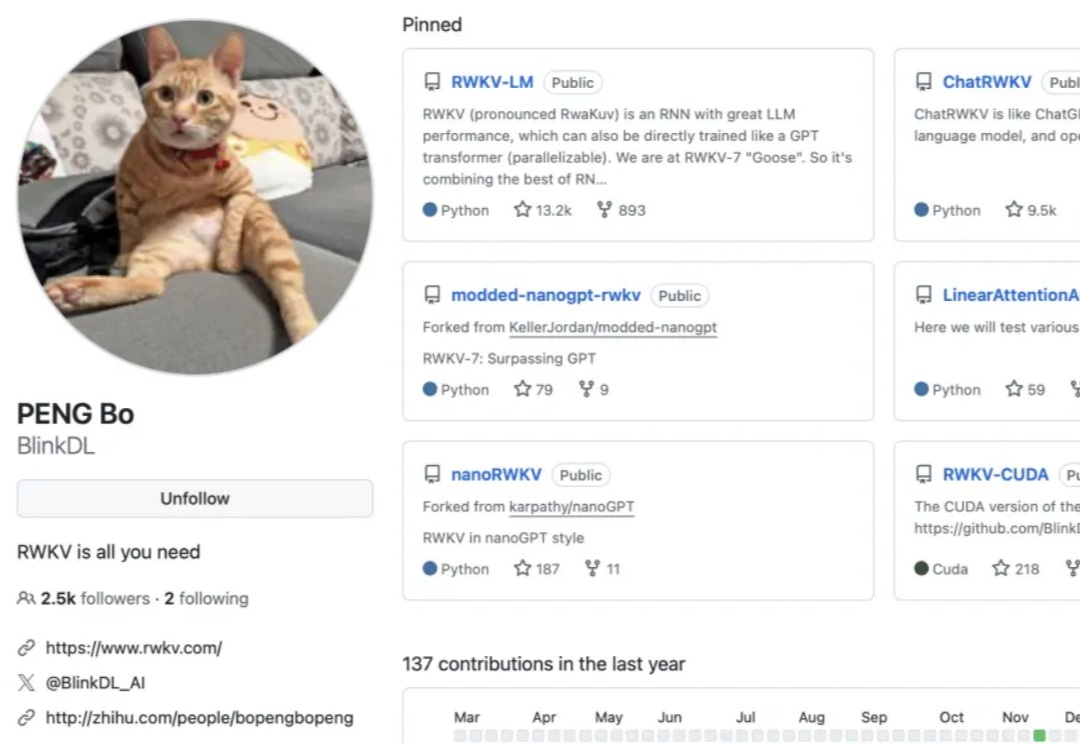

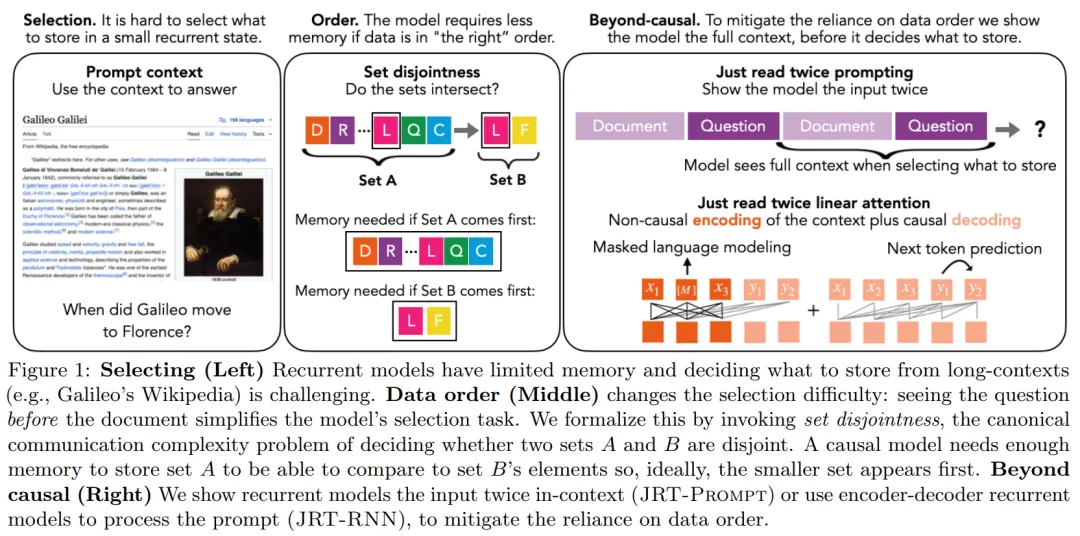

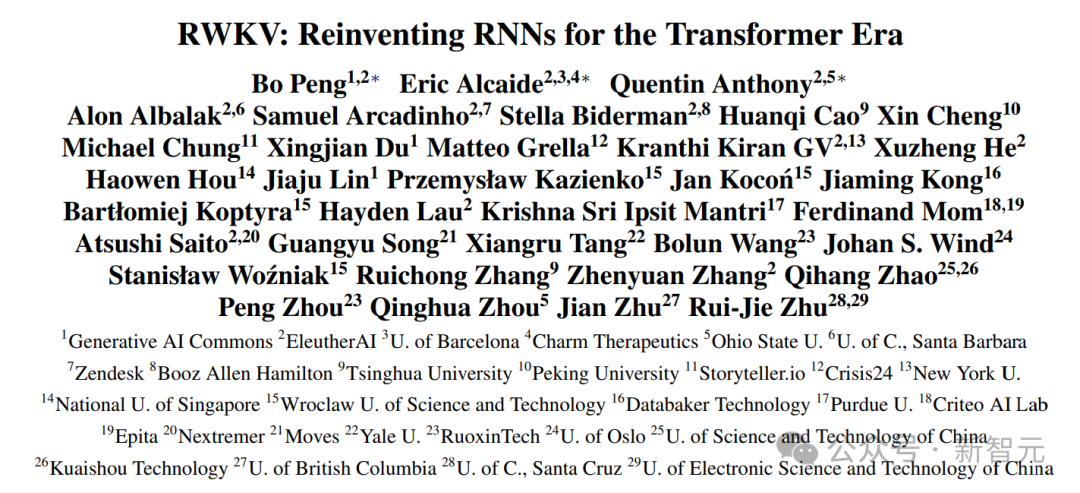

在当前 AI 领域,大语言模型采用的主流架构是 Transformer。不过,随着 RWKV、Mamba 等架构的陆续问世,出现了一个很明显的趋势:在语言建模困惑度方面与 Transformer 较量的循环大语言模型正在快速进入人们的视线。

6 月 6 日下午,奇绩创坛在北京中关村举办了 2024 年春季创业营路演日,共有 53 家奇绩加速的公司参与了路演。

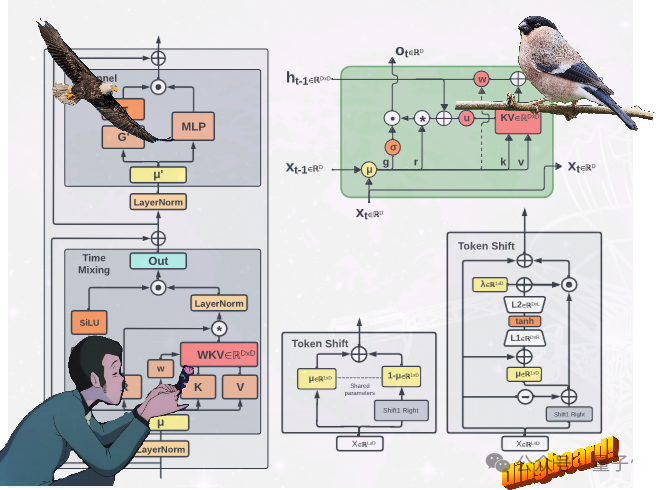

不走Transformer寻常路,魔改RNN的国产新架构RWKV,有了新进展: 提出了两种新的RWKV架构,即Eagle (RWKV-5) 和Finch(RWKV-6)。

大模型内卷时代,也不断有人跳出来挑战Transformer的统治地位,RWKV最新发布的Eagle 7B模型登顶了多语言基准测试,同时成本降低了数十倍

在 AI 赛道中,与动辄上千亿参数的模型相比,最近,小模型开始受到大家的青睐。比如法国 AI 初创公司发布的 Mistral-7B 模型,其在每个基准测试中,都优于 Llama 2 13B,并且在代码、数学和推理方面也优于 LLaMA 1 34B。