Attention Sink产生的起点?清华&美团首次揭秘MoE LLM中的超级专家机制

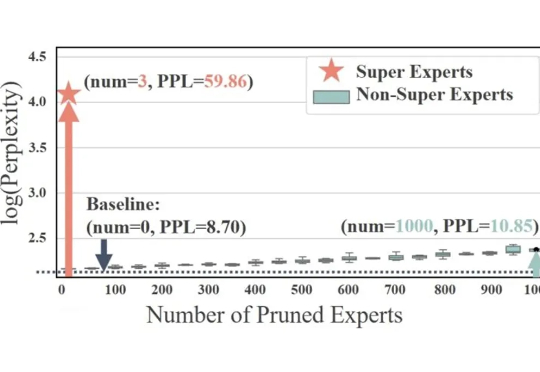

Attention Sink产生的起点?清华&美团首次揭秘MoE LLM中的超级专家机制稀疏激活的混合专家模型(MoE)通过动态路由和稀疏激活机制,极大提升了大语言模型(LLM)的学习能力,展现出显著的潜力。基于这一架构,涌现出了如 DeepSeek、Qwen 等先进的 MoE LLM。

稀疏激活的混合专家模型(MoE)通过动态路由和稀疏激活机制,极大提升了大语言模型(LLM)的学习能力,展现出显著的潜力。基于这一架构,涌现出了如 DeepSeek、Qwen 等先进的 MoE LLM。

AutoGame 创始人张昊阳从腾讯制作人转型为 AI 沙盒游戏创业者,其团队打造的 AI 游戏《麦琪的花园》以零推广在 Steam 首发登上新品榜 Top50,并在一个月内积累超过 5000 愿望单。它让普通人也能“一句话生成 NPC、任务与副本”,通过 AI 驱动的 UGC 系统,让内容创作从金字塔走向“十字型”,成为 Z 世代表达与社交的新方式。

FlowSpeech的开发初衷源于一个感人故事。一位年过八旬的美国老人因长期病痛失去说话能力,但通过AI工具ListenHub继续与他人分享自己的人生经历。这个真实案例启发了开发团队,促使他们研发出专门针对书面语向口语转换的TTS技术解决方案。

AI大模型浪潮汹涌澎湃,00后创业者正一步步走上创业舞台,成为这场技术革新的主心骨。身处这股技术新浪潮之中的Celine和Kejin,两个刚走出校园里的年轻人瞄准的是AI教育。

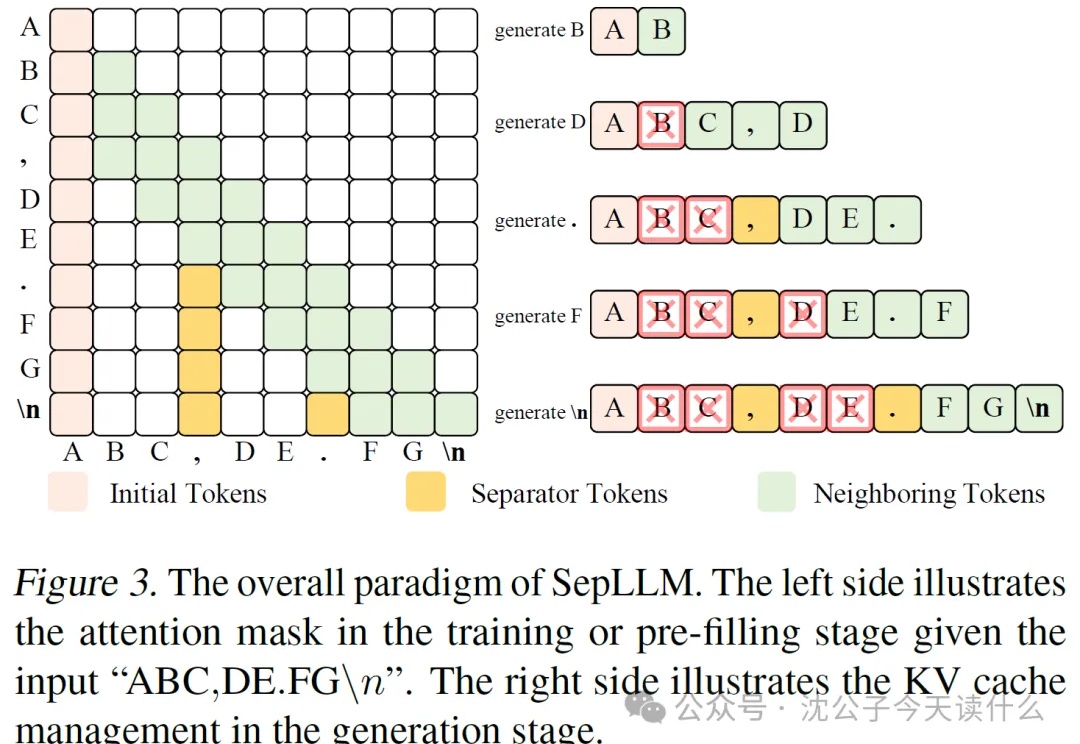

近年来,大语言模型(LLM)的能力越来越强,但它们的“饭量”也越来越大。这个“饭量”主要体现在计算和内存上。当模型处理的文本越来越长时,一个叫做“自注意力(Self-Attention)”的核心机制会导致计算量呈平方级增长。这就像一个房间里的人开会,如果每个人都要和在场的其他所有人单独聊一遍,那么随着人数增加,总的对话次数会爆炸式增长。

自 ChatGPT 引爆公众认知以来,AI 开始渗透进写作、编程、设计等多个应用场景,推动人类进入“智能体(Agent)”时代。曾经遥不可及的自动化交互,如今正在成为现实。在这背后,一场关于基础设施的重构也悄然展开——从模型能力到部署体验,谁能打通智能 Agent 的“最后一公里”,谁就掌握了这场范式变革的主动权。

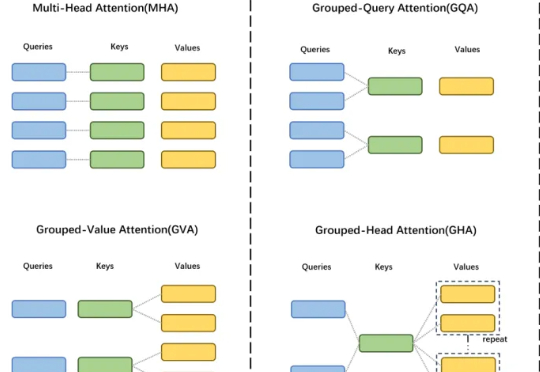

GTA 工作由中国科学院自动化研究所、伦敦大学学院及香港科技大学(广州)联合研发,提出了一种高效的大模型框架,显著提升模型性能与计算效率。

不经意间,这场燃烧了三年的AI热潮,已经悄然改变了我们的生活方式。我们开始习惯用AI写作、咨询,向它提出各种问题,搜索引擎的使用频率也在减少。这场改变世界的技术革命,正让那些有想法却不会写代码的普通用户,第一次有机会接触代码世界,体验创造产品的“酷”感。 Same.new正是这样一款AI开发利器。

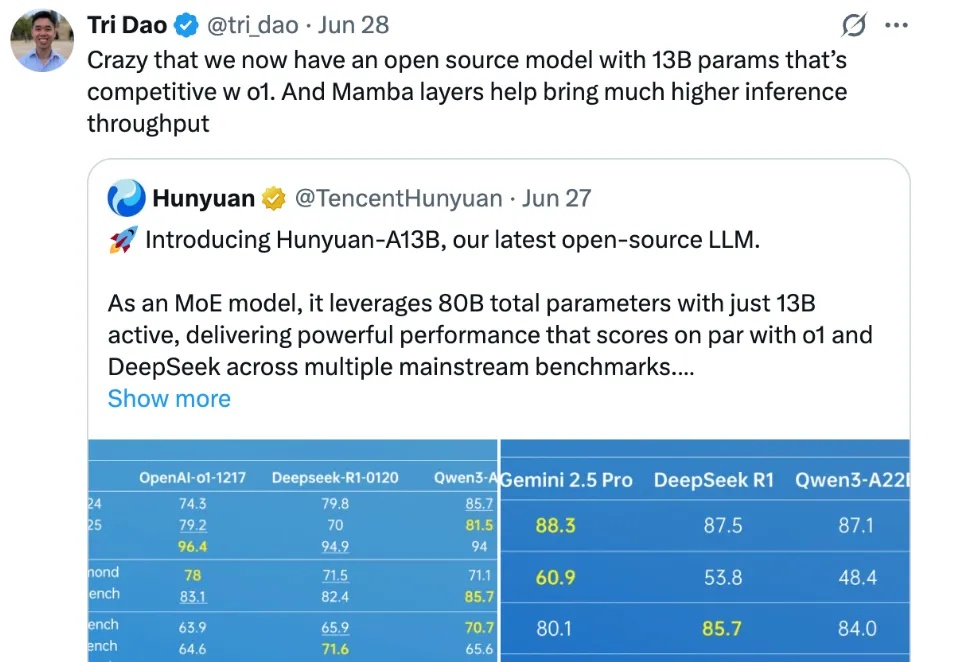

腾讯混元,在开源社区打出名气了。

DeepSeek火爆全球,现在美国版“梁文锋”来了。来自美国的互联网券商巨头Robinhood的CEO——Vlad Tenev决定投身人工智能创业浪潮,与Tudor Achim联合打造了一家专注于人工智能的初创公司——Harmonic AI。