ICML 2025 | 视频生成模型无损加速两倍,秘诀竟然是「抓住attention的时空稀疏性」

ICML 2025 | 视频生成模型无损加速两倍,秘诀竟然是「抓住attention的时空稀疏性」自 OpenAI 发布 Sora 以来,AI 视频生成技术进入快速爆发阶段。凭借扩散模型强大的生成能力,我们已经可以看到接近现实的视频生成效果。但在模型逼真度不断提升的同时,速度瓶颈却成为横亘在大规模应用道路上的最大障碍。

自 OpenAI 发布 Sora 以来,AI 视频生成技术进入快速爆发阶段。凭借扩散模型强大的生成能力,我们已经可以看到接近现实的视频生成效果。但在模型逼真度不断提升的同时,速度瓶颈却成为横亘在大规模应用道路上的最大障碍。

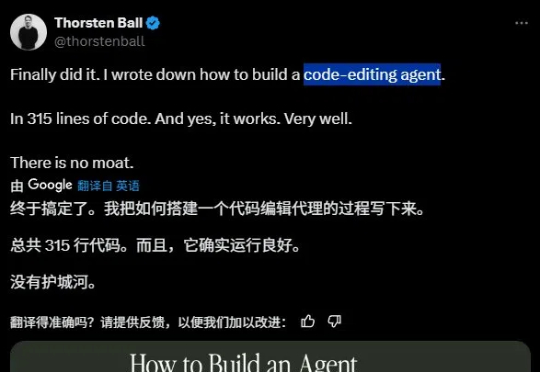

知名 Go 大佬 Thorsten Ball 最近用 315 行代码构建了一个编程智能体,并表示「它运行得非常好」且「没有护城河」(指它并非难以复制)。

在全球大模型快速爆发与AIGC应用加速落地的时代,中国的人工智能创业者也在经历从“算法至上”到“产品为王”的重大转变。过去十年,AI行业几度热潮:从2016年AlphaGo引爆的认知革命,到2022年ChatGPT带来的生成式AI浪潮,技术的跃迁正在倒逼产品逻辑重构。而真正决定一家AI公司能否走得远的,从来不是技术demo,而是“有没有真正被用起来”。

「未来,99% 的 attention 将是大模型 attention,而不是人类 attention。」这是 AI 大牛 Andrej Karpathy 前段时间的一个预言。这里的「attention」可以理解为对内容的需求、处理和分析。也就是说,他预测未来绝大多数资料的处理工作将由大模型来完成,而不是人类。

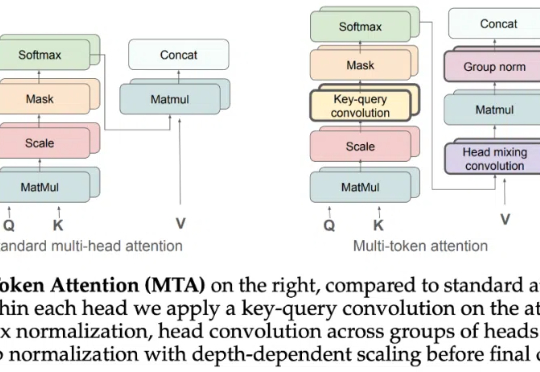

Attention 还在卷自己。

晚点:过去将近 6 个月,AI 领域最重要的两件事,一是 OpenAI 去年 9 月 o1 发布,另一个是近期 DeepSeek 在发布 R1 后掀起全民狂潮。我们可以从这两个事儿开始聊。你怎么看 o1 和 R1 分别的意义?

就在刚刚,2024 ACM计算奖出炉!苏黎世联邦理工学院Torsten Hoefler教授获奖,理由是对高性能计算HPC及持续推进的AI革命的贡献。在20多岁时,他就完成了许多重要工作,这证明年龄绝非在CS取得突破的障碍!

本期我们邀请到了沈振宇作为访谈嘉宾。这位曾被张一鸣直接招募、亲历字节跳动崛起的产品人,如今已经完成了从图虫到千岛的两次创业蜕变。

开发者工具正在随着 AI 的快速发展而改变。因此,那些在其工作流程中更容易采用 AI 的公司正受到广泛关注。2022 年,一家名为 n8n(发音为“enay-ten”)的初创公司将其工作流自动化平台转向更加 AI 友好,该公司表示其收入增长了 5 倍,仅在过去两个月就翻了一番。

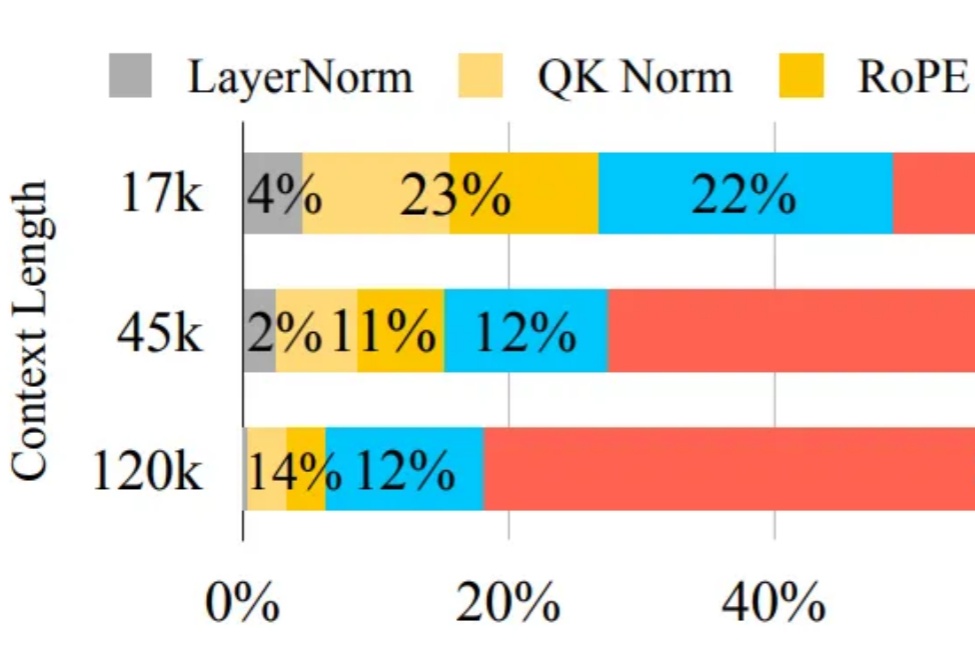

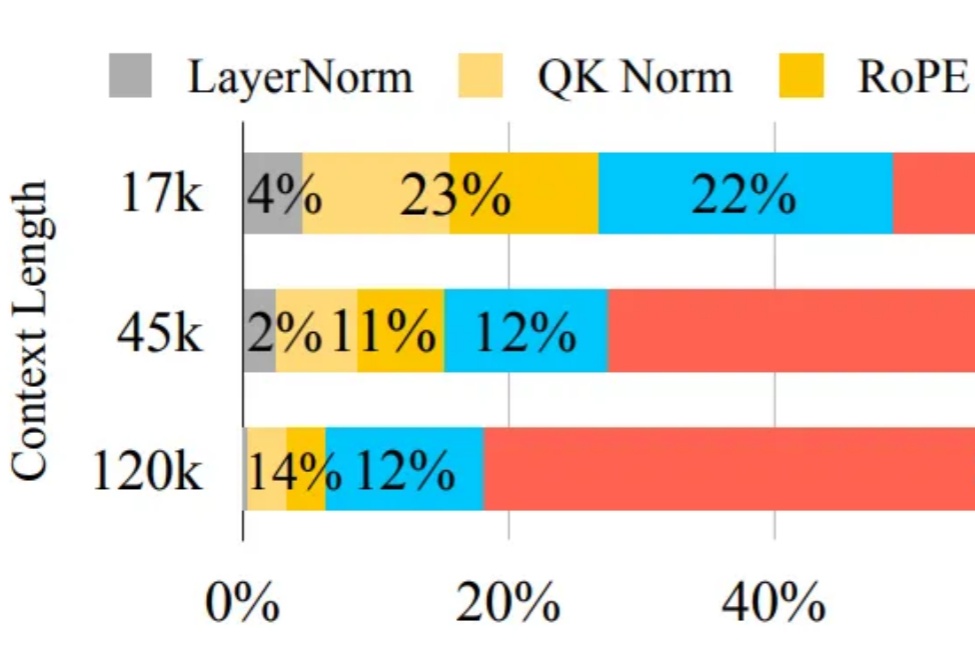

大模型同样的上下文窗口,只需一半内存就能实现,而且精度无损? 前苹果ASIC架构师Nils Graef,和一名UC伯克利在读本科生一起提出了新的注意力机制Slim Attention。