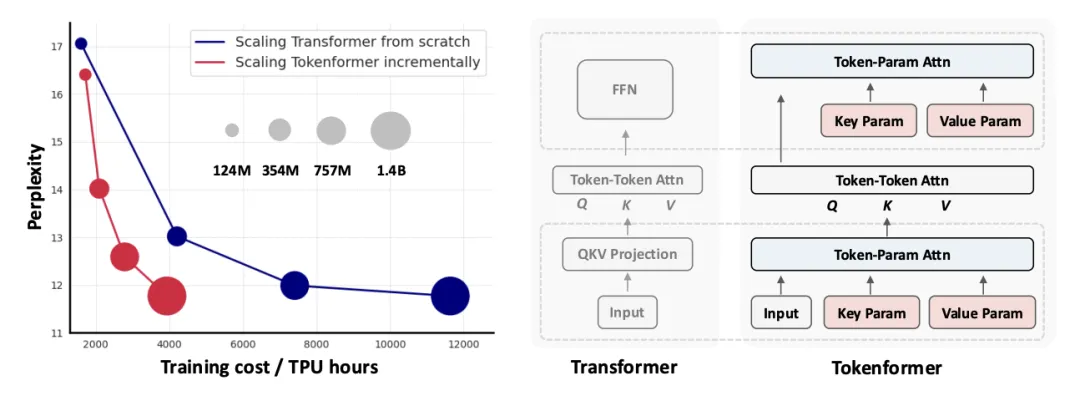

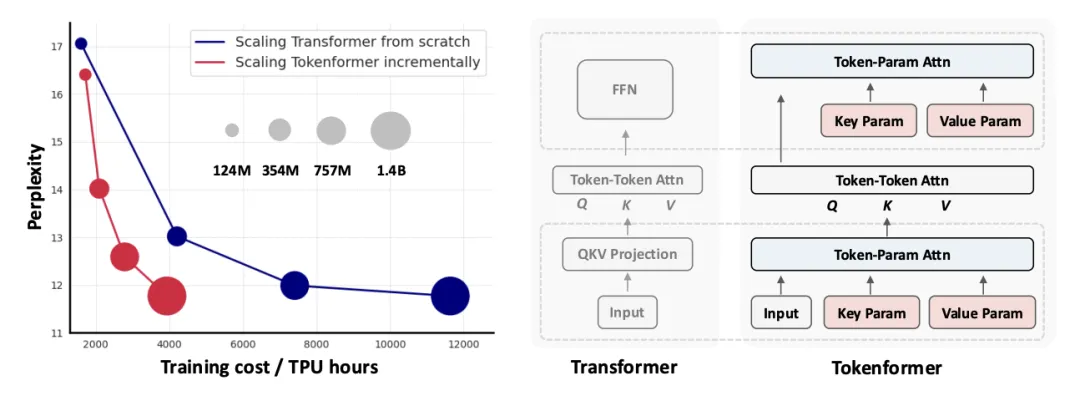

Token化一切,甚至网络!北大&谷歌&马普所提出TokenFormer,Transformer从来没有这么灵活过!

Token化一切,甚至网络!北大&谷歌&马普所提出TokenFormer,Transformer从来没有这么灵活过!新一代通用灵活的网络结构 TokenFormer: Rethinking Transformer Scaling with Tokenized Model Parameters 来啦!

新一代通用灵活的网络结构 TokenFormer: Rethinking Transformer Scaling with Tokenized Model Parameters 来啦!

30多年的数学猜想首次获得了进展!Meta等学者提出的PatternBoost,使用Transformer构造了一个反例,反驳了一个已悬而未决30年的猜想。是否所有数学问题都适合机器学习技术?这样的未来太令人期待了。

周期性现象广泛存在,深刻影响着人类社会和自然科学。作为最重要的基本特性之一,许多规律都显式或隐式地包含周期性,例如天文学中的行星运动、气象学中的季节变化、生物学中的昼夜节律、经济学中的商业周期、物理学中的电磁波以及数学运算和逻辑推理等。因此,在许多任务和场景中,人们希望对周期进行建模,以便根据以往的经验进行推理。

近日,伊利诺伊大学香槟分校的研究团队发布了一篇开创性论文,首次从理论层面证明了大语言模型(LLM)中的prompt机制具有图灵完备性。这意味着,通过合适的prompt设计,一个固定大小的Transformer模型理论上可以计算任何可计算函数。这一突破性发现为prompt工程提供了坚实的理论基础。

Transformer自问世后就大放异彩,但有个小毛病一直没解决: 总爱把注意力放在不相关的内容上,也就是信噪比低。 现在微软亚研院、清华团队出手,提出全新改进版Differential Transformer,专治这个老毛病,引起热议。

TimeMixer++是一个创新的时间序列分析模型,通过多尺度和多分辨率的方法在多个任务上超越了现有模型,展示了时间序列分析的新视角,在预测和分类等任务带来了更高的准确性和灵活性。

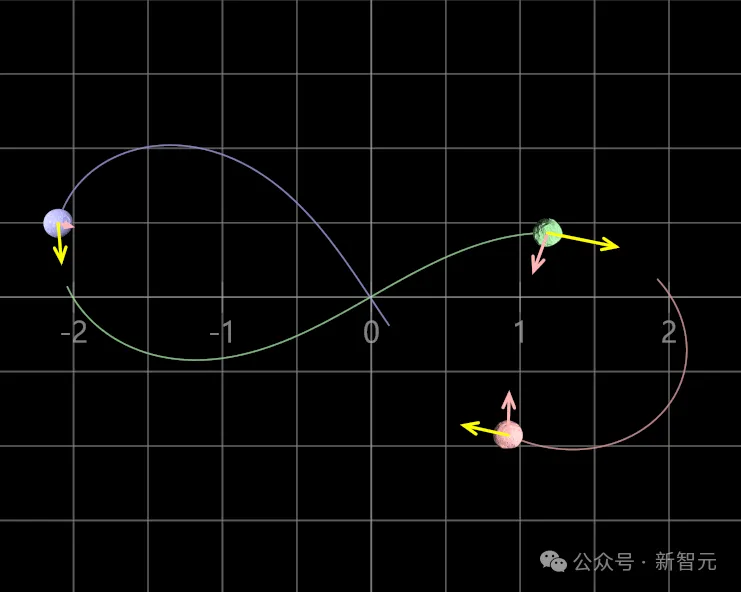

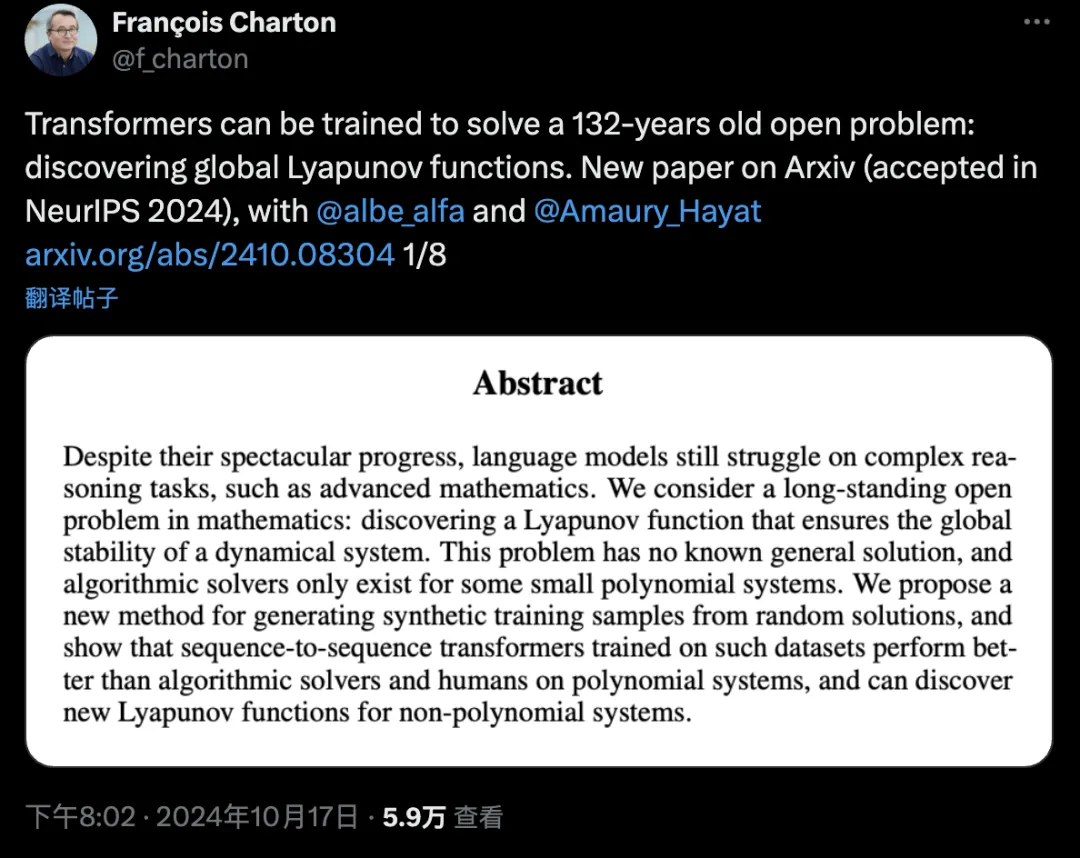

Transformer解决了三体问题?Meta研究者发现,132年前的数学难题——发现全局李雅普诺夫函数,可以被Transformer解决了。「我们不认为Transformer是在推理,它可能是出于对数学问题的深刻理解,产生了超级直觉。」AI可以搞基础数学研究了,陶哲轩预言再成真。

近日,深度学习三巨头之一的Yoshua Bengio,带领团队推出了全新的RNN架构,以大道至简的思想与Transformer一较高下。

LLM训练速度还可以再飙升20倍!英伟达团队祭出全新架构归一化Transformer(nGPT),上下文越长,训练速度越快,还能维持原有精度。

牛顿没解决的问题,AI给你解决了? AI的推理能力一直是研究的焦点。作为最纯粹、要求最高的推理形式之一,能否解决高级的数学问题,无疑是衡量语言模型推理水平的一把尺。