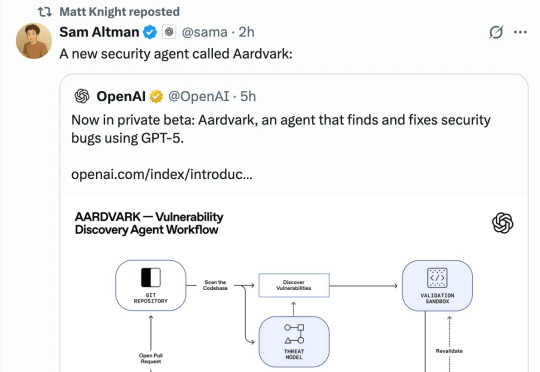

OpenAI首个GPT-5找Bug智能体:全自动读代码找漏洞写修复

OpenAI首个GPT-5找Bug智能体:全自动读代码找漏洞写修复AI Coding火了大半年,AI Debugging也来了!刚刚,OpenAI发布由GPT-5驱动的“白帽”Agent——Aardvark(土豚)。这只“AI安全研究员”能帮助开发者和安全团队,在大规模代码库中自动发现并修复安全漏洞。

AI Coding火了大半年,AI Debugging也来了!刚刚,OpenAI发布由GPT-5驱动的“白帽”Agent——Aardvark(土豚)。这只“AI安全研究员”能帮助开发者和安全团队,在大规模代码库中自动发现并修复安全漏洞。

OpenAI正酝酿一场史诗级IPO,估值或高达1万亿美元,标志其从非营利探索者向AI巨头全面转型。通过削弱微软控制、强化自身独立性,OpenAI正为资本市场铺路,谋求支撑其万亿级AGI战略的资金弹药。若上市成功,这不仅将改写AI产业格局,也将考验其能否在商业利益与「让全人类受益」的使命之间保持平衡。

最新进展,Cursor 2.0正式发布,并且首次搭载了「内部」大模型。 没错,不是GPT、不是Claude,如今模型栏多了个新名字——Composer。实力相当炸裂:据官方说法,Composer仅需30秒就能完成复杂任务,比同行快400%

今年三月,Liam Fedus 在推特上宣布离开 OpenAI。这条推文的影响力超出了所有人的预期——硅谷的风投们几乎是立刻行动起来,争相联系这位 ChatGPT 最初小团队的核心成员、曾领导 OpenAI 关键的后训练部门的研究者,他的离职甚至一度引发了一场“反向竞标”。

OpenAI完成史上最重要的一次组织架构调整后,紧接着开了一场直播。首次公开了内部研究目标的具体时间表,其中最引人注目的是“在2028年3月实现完全自主的AI研究员”,具体到月份。

凌晨三点,一个用户在 ChatGPT 的对话框里输入,「我已经没有办法再坚持了。」

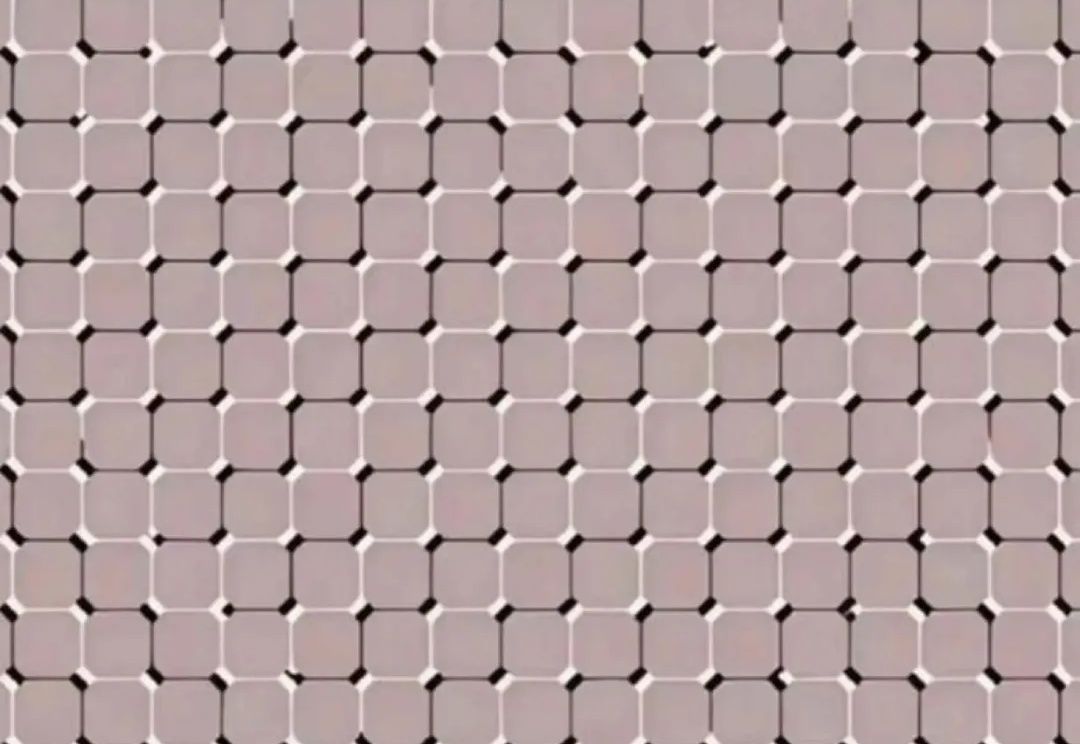

人眼秒懂,AI抓瞎!网友用光学错觉玩坏大模型,全网百万人围观。

2023 年的秋天,当全世界都在为 ChatGPT 和大语言模型疯狂的时候,远在澳大利亚悉尼的一对兄弟却在为一个看似简单的问题发愁:为什么微调一个开源模型要花这么长时间,还要用那么昂贵的 GPU?

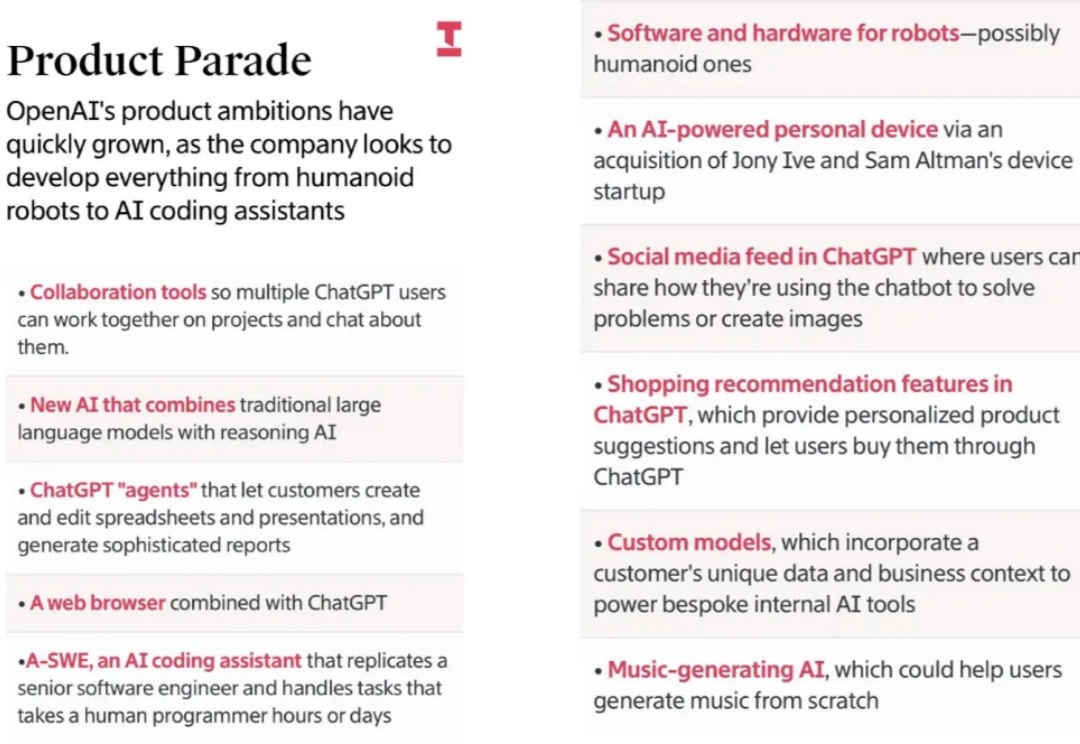

OpenAI现在已经完全是互联网大厂的路数了。

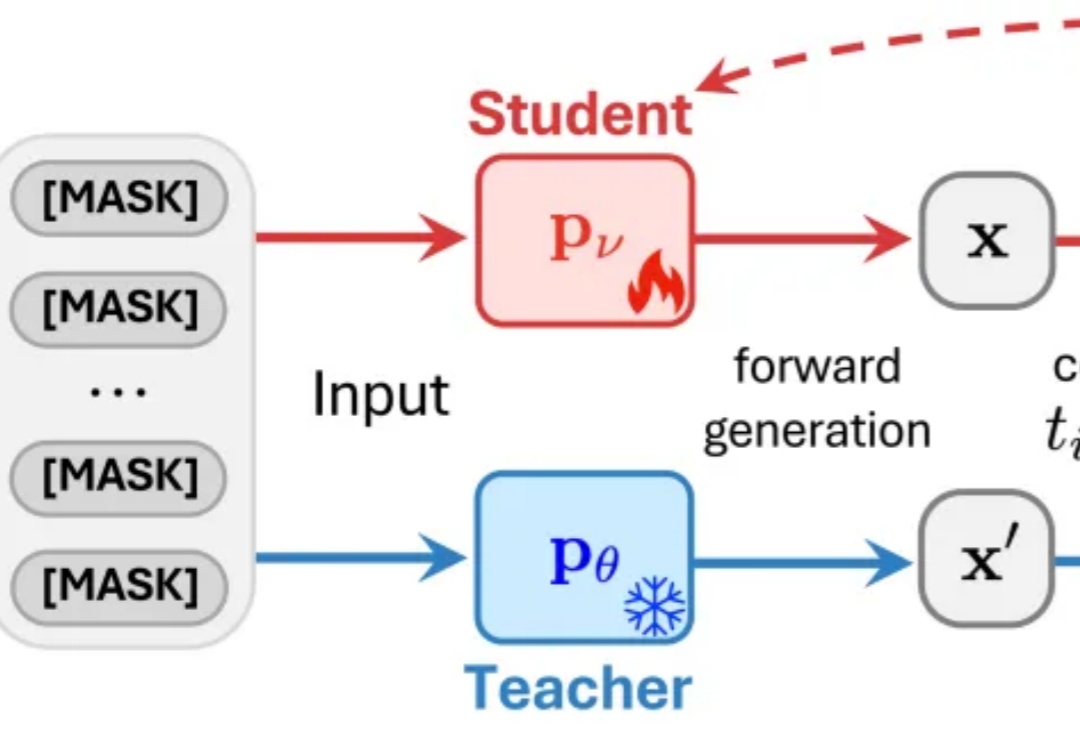

近日,来自普渡大学、德克萨斯大学、新加坡国立大学、摩根士丹利机器学习研究、小红书 hi-lab 的研究者联合提出了一种对离散扩散大语言模型的后训练方法 —— Discrete Diffusion Divergence Instruct (DiDi-Instruct)。经过 DiDi-Instruct 后训练的扩散大语言模型可以以 60 倍的加速超越传统的 GPT 模型和扩散大语言模型。