AAAI 2026 Oral|LENS:基于统一强化推理的分割大模型

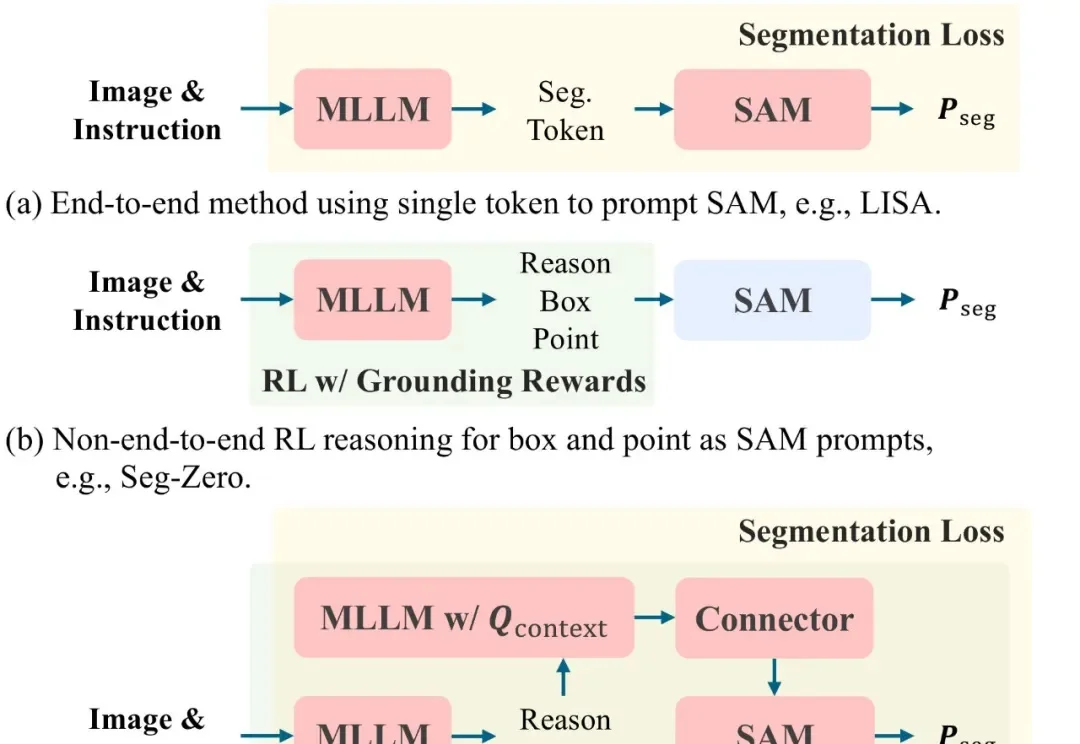

AAAI 2026 Oral|LENS:基于统一强化推理的分割大模型文本提示图像分割(Text-prompted image segmentation)是实现精细化视觉理解的关键技术,在人机交互、具身智能及机器人等前沿领域具有重大的战略意义。这项技术使机器能够根据自然语言指令,在复杂的视觉场景中定位并分割出任意目标。

文本提示图像分割(Text-prompted image segmentation)是实现精细化视觉理解的关键技术,在人机交互、具身智能及机器人等前沿领域具有重大的战略意义。这项技术使机器能够根据自然语言指令,在复杂的视觉场景中定位并分割出任意目标。

硅谷宠物情感智能公司Traini宣布已完成超5000万元人民币融资,资金将主要用于多模态情感模型研发、软硬件产品迭代及海外市场扩张。老股东Tao Foundation及小米联合创始人洪峰继续跟投。

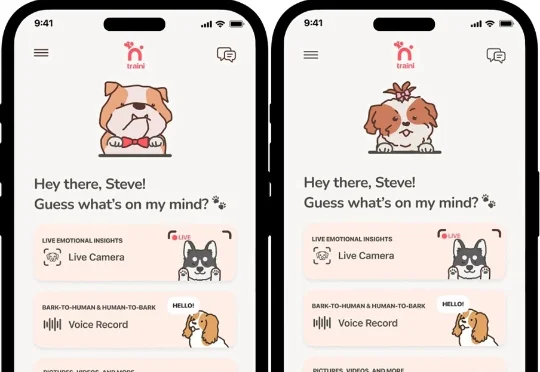

别被 2025 年的模型乱战骗了!这可能是一个巨大的误判。 LifeArchitect在上帝视角复盘:当下的喧嚣不过是爆发前的「基建期」。 到2026年,从6T规模的Grok-5到消失在后台的GPT-6,全行业正迎来一场蓄谋已久的「集体解锁」。 真正的换代不再是变聪明,而是像iPhone焊死iOS那样,让AI彻底成为文明的基础设施。

直到刚刚,用最新的图像模型NextStep-1.1,扳回一球。总体来看,这次开源的NextStep-1.1解决了之前NextStep-1中出现的可视化失败(visualization failures )问题。其通过扩展训练和基于流的强化学习(RL)后训练范式,大幅提升了图像质量。

在一场技术演讲中,Netflix 工程部的资深大牛 Jake Nations,开场就抛出了一个几乎所有工程师都心照不宣的“坦白”。几乎每个正在使用 Copilot、Cursor、Claude 写代码的人,都干过同一件事:让 AI 生成代码,看起来没问题,就直接交付。测试通过、功能可用、部署成功,但当系统真的在凌晨三点出问题时,没人能再说清楚它为什么还能跑。

现在生成一个视频,比你刷视频还要快。

最近,Notion 创始人 Ivan Zhao 写了一篇年终总结《Steam, Steel, and Infinite Minds》。Ivan 讲了一个特别有趣的观点:AI 是我们这个时代的「革命性材料」。就像工业时代的钢铁、数字时代的半导体一样。

什么?决定 AI 上限的已不再是底座模型,而是外围的「推理编排」(Orchestration)。

视频生成领域的「DeepSeek时刻」来了!清华开源TurboDiffusion,将AI视频生成从「分钟级」硬生生拉进「秒级」实时时代,单卡200倍加速让普通显卡也能跑出大片!

为什么大模型厂商给了 128K 的上下文窗口,却在计费上让长文本显著更贵?