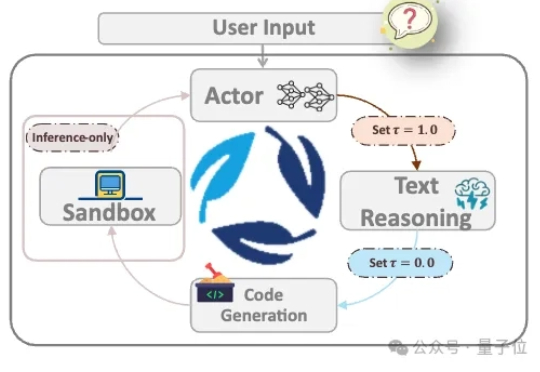

开源复现o3图像思考!快手让AI不再被动看图,模型自主生成代码调用工具

开源复现o3图像思考!快手让AI不再被动看图,模型自主生成代码调用工具在Openai 发布o3后,think with image功能得到了业界和学术界的广泛关注。

在Openai 发布o3后,think with image功能得到了业界和学术界的广泛关注。

4 个月前,OpenAI 的 o3 模型凭借视觉推理能力模块和智能的进化,在 AI 创投圈子引起新一轮的震撼与海啸,解锁了一大批新的「套壳」创业机会。正如我们在《谢谢 OpenAI,谢谢 o3,新的「套壳」创业机会来了 | 附 12 个潜力方向》一文中预测的那样,VLM 确实带来了新的创业机会。

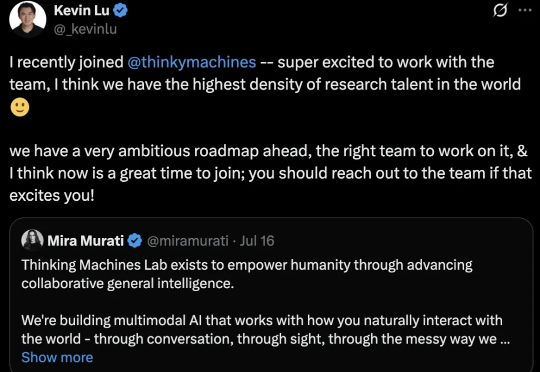

哦豁,OpenAI奥特曼又痛失一员大将。 Kevin Lu,领导4o-mini发布,并参与o1-mini、o3发布,主要研究强化学习、小模型和合成数据。

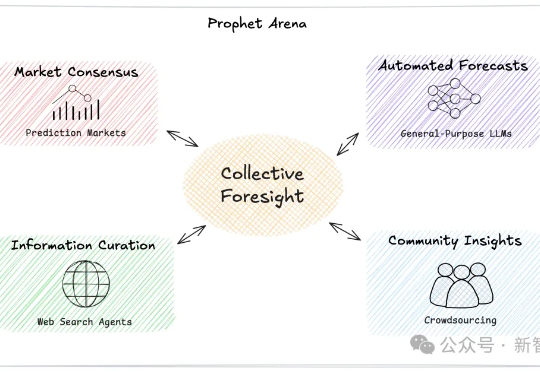

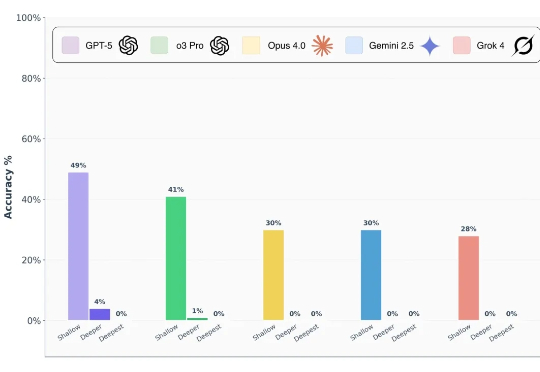

AI能像科幻电影中的先知一样预测未来吗?一个名为「Prophet Arena」的全新基准测试,正通过预测真实世界事件来评估AI的「预言」能力。

前沿 AI 模型真的能做到博士级推理吗? 前段时间,谷歌、OpenAI 的模型都在数学奥林匹克(IMO)水平测试中达到了金牌水准,这样的表现让人很容易联想到 LLM 是不是已经具备了解决博士级科研难题的推理能力?

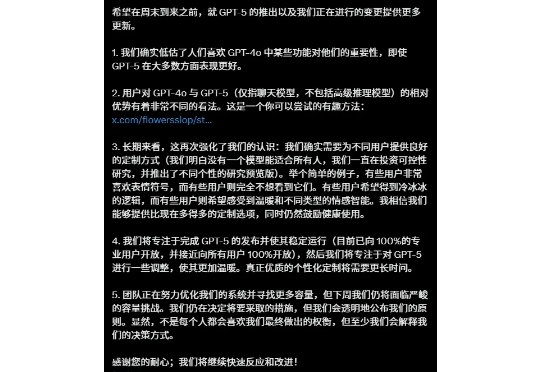

GPT-5和“还我GPT-4o”的风波,闹得沸沸扬扬。 今天,奥特曼还有一次认怂了,不仅调了UI,还把o3这些老模型还了回来。

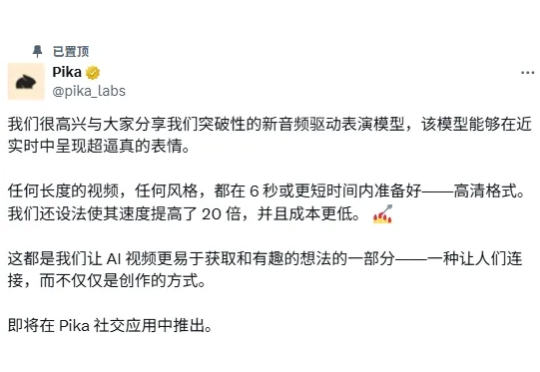

制作一个视频需要几步?可以简单概括为:拍摄 + 配音 + 剪辑。 还记得 veo3 发布时引起的轰动吗?「音画同步」功能的革命性直接把其他视频生成模型按在地上摩擦,拍摄 + 配音 + 粗剪一键搞定。

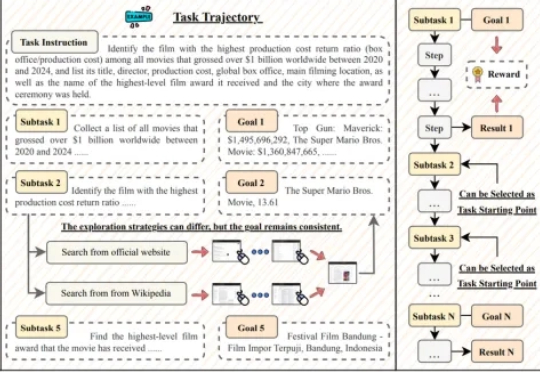

GUI 智能体正以前所未有的速度崛起,有望彻底改变人机交互的方式。然而,这一领域的进展正面临瓶颈:现有数据集大多聚焦于 10 步以内的短程交互,且仅验证最终结果,无法有效评估和训练智能体在真实世界中的长时程规划与执行能力。

这个周末,对OpenAI的抗诉,好像从未如此热闹过。 起因自然还是因为GPT-5。 OpenAI上了GPT-5当天,做了一个非常神奇的操作,他们只保留了GPT-5,然后把GPT-4.5、GPT-4o、o3什么的,全都砍掉了。

27M小模型超越o3-mini-high和DeepSeek-R1!推理还不靠思维链。 开发者是那位拒绝了马斯克、还要挑战Transformer的00后清华校友,Sapient Intelligence的创始人王冠。