哈萨比斯:谷歌想创造第二个Transformer,还想把AlphaGo和Gemini强强联合

哈萨比斯:谷歌想创造第二个Transformer,还想把AlphaGo和Gemini强强联合当一家人工智能公司的首席执行官更像是计算机科学家而不是推销员时,我感觉更舒服

当一家人工智能公司的首席执行官更像是计算机科学家而不是推销员时,我感觉更舒服

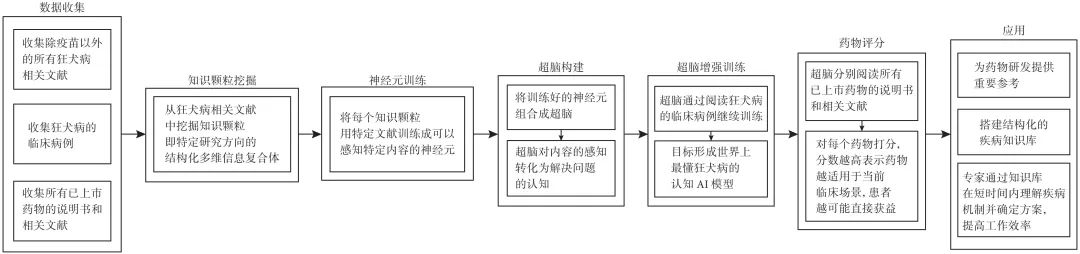

在当今数字化时代,人工智能(artificial intelligence,AI)技术迅猛发展,尤其是生成式技术,如ChatGPT(chat generative pre-trained transformer),对人类生活的影响日益深远。

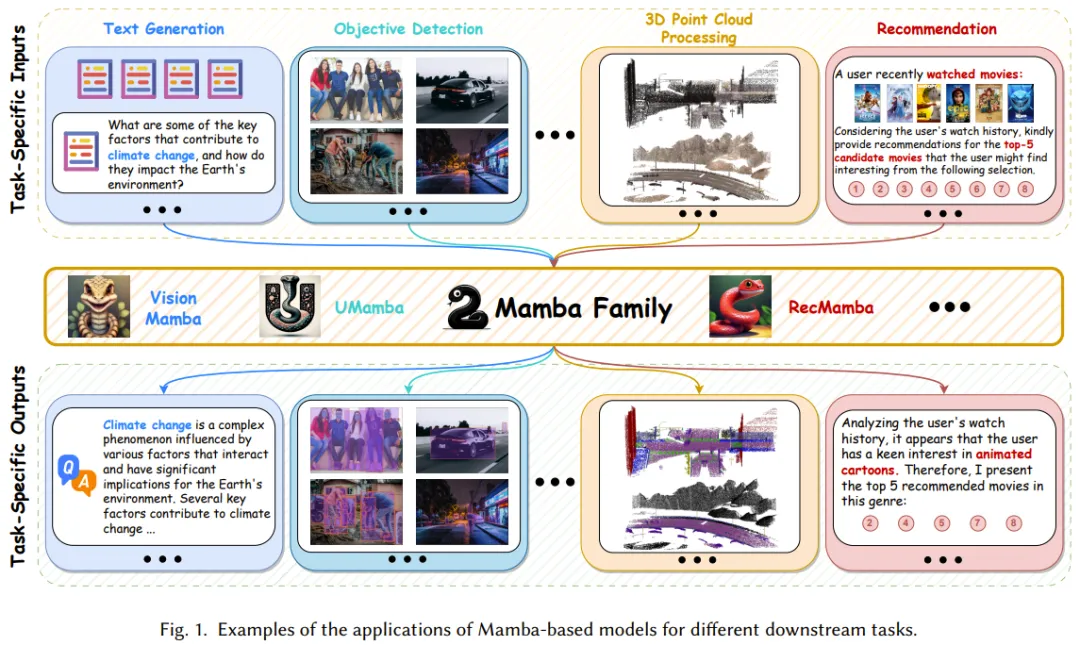

Mamba 虽好,但发展尚早。

过去几年间,Transformer 架构已经取得了巨大的成功,同时其也衍生出了大量变体,比如擅长处理视觉任务的 Vision Transformer(ViT)。本文要介绍的 Body Transformer(BoT) 则是非常适合机器人策略学习的 Transformer 变体。

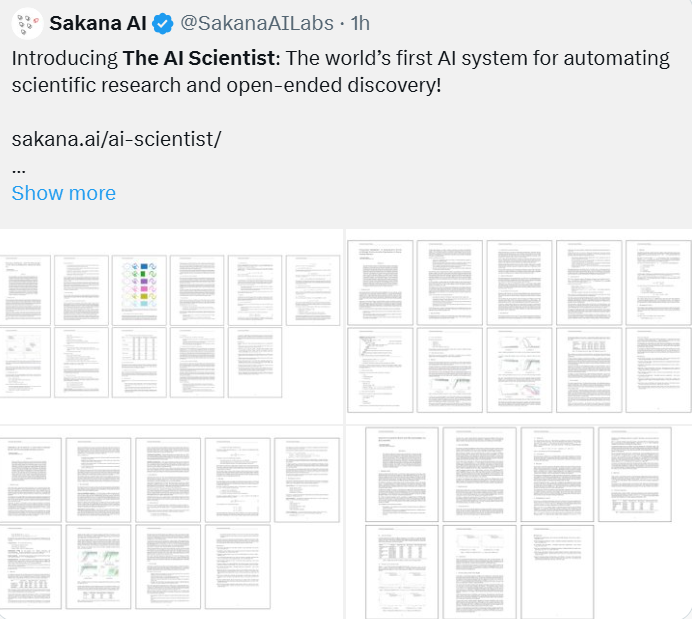

一年前,谷歌最后一位 Transformer 论文作者 Llion Jones 离职创业,与前谷歌研究人员 David Ha共同创立人工智能公司 Sakana AI。Sakana AI 声称将创建一种基于自然启发智能的新型基础模型! 现在,Sakana AI 交上了自己的答卷。

然而不到 24 小时,就被骂得删视频道歉。

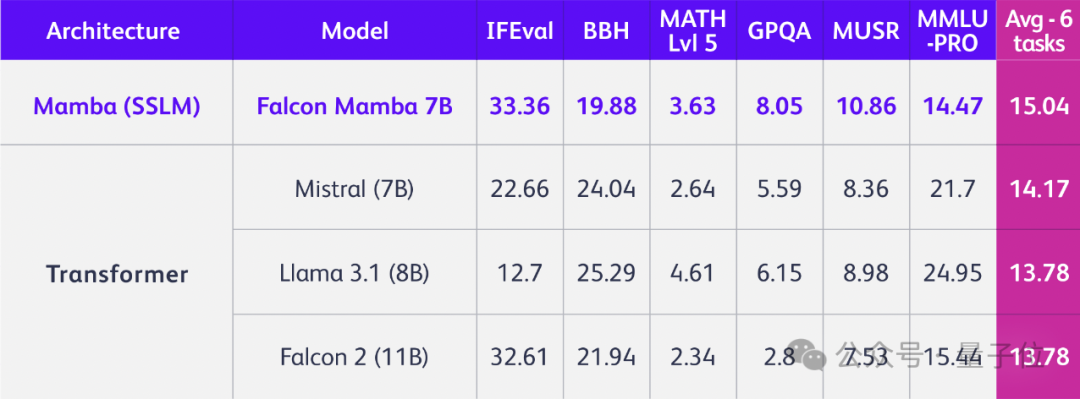

Mamba 架构的大模型又一次向 Transformer 发起了挑战

TII开源全球第一个通用的大型Mamba架构模型Falcon Mamba 7B,性能与Transformer架构模型相媲美,在多个基准测试上的均分超过了Llama 3.1 8B和Mistral 7B。

只是换掉Transformer架构,立马性能全方位提升,问鼎同规模开源模型!

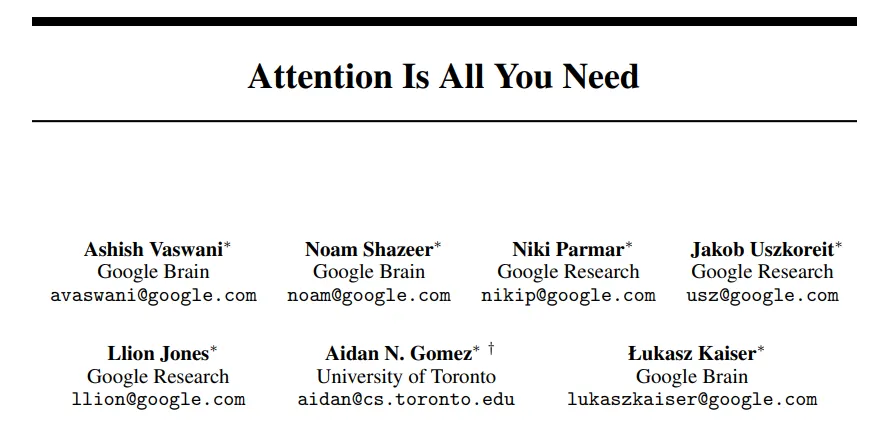

2017 年,谷歌在论文《Attention is all you need》中提出了 Transformer,成为了深度学习领域的重大突破。该论文的引用数已经将近 13 万,后来的 GPT 家族所有模型也都是基于 Transformer 架构,可见其影响之广。 作为一种神经网络架构,Transformer 在从文本到视觉的多样任务中广受欢迎,尤其是在当前火热的 AI 聊天机器人领域。