Transformer作者回流谷歌,Character.AI创始团队被「收购」,只要人不要公司

Transformer作者回流谷歌,Character.AI创始团队被「收购」,只要人不要公司AI 初创者的归宿还是大厂?

AI 初创者的归宿还是大厂?

Transformer大模型尺寸变化,正在重走CNN的老路!

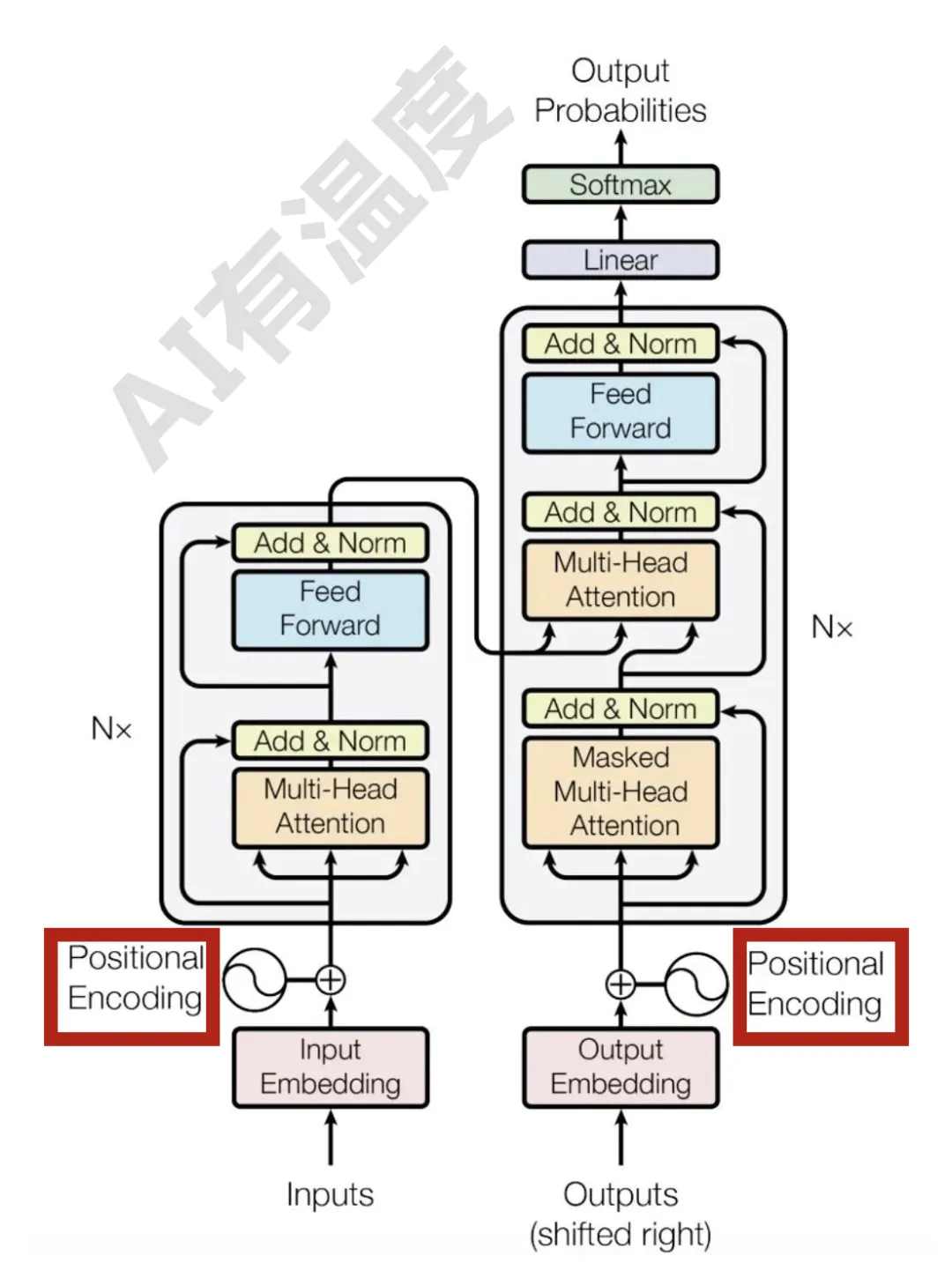

RNN每个step的隐状态都取决于上一个step的输出,这种连续的状态转移方式使得RNN天然带有位置信息。

Transformer中的信息流动机制,被最新研究揭开了:

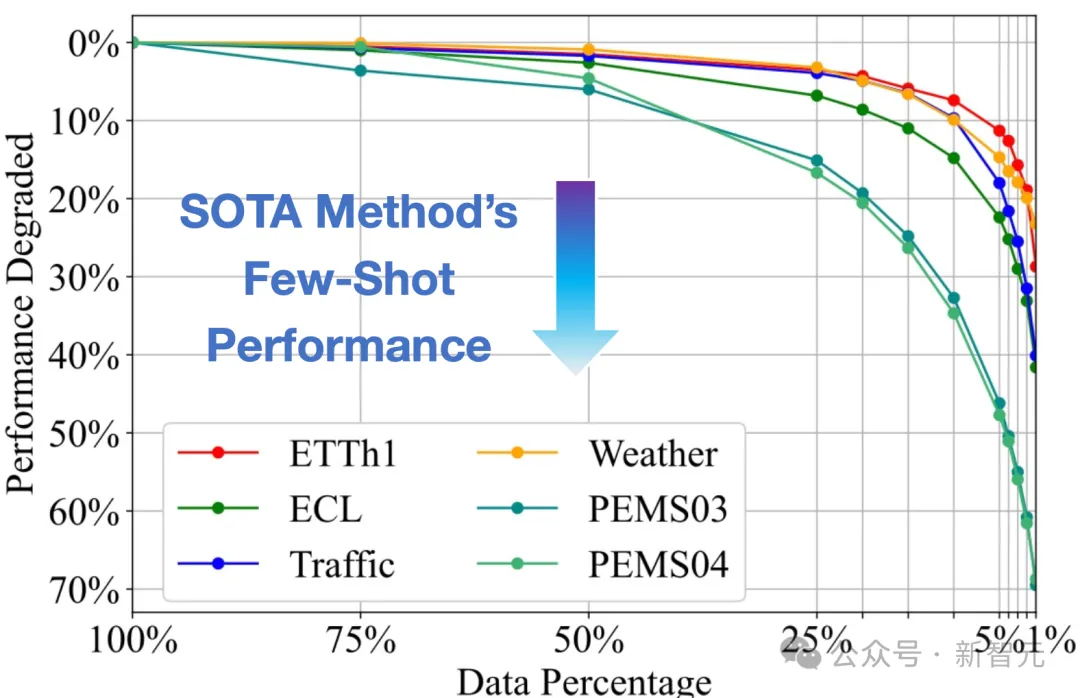

大模型在语言、图像领域取得了巨大成功,时间序列作为多个行业的重要数据类型,时序领域的大模型构建尚处于起步阶段。近期,清华大学的研究团队基于Transformer在大规模时间序列上进行生成式预训练,获得了任务通用的时序分析模型,展现出大模型特有的泛化性与可扩展性

好家伙!为了揭秘Transformer内部工作原理,陈丹琦团队直接复现——

“欧洲OpenAI”和“Transformer挑战者”强强联合了!

把因果链展示给 LLM,它就能学会公理。

来自微软、MIT等机构的学者提出了一种创新的训练范式,攻破了大模型的推理缺陷。他们通过因果模型构建数据集,直接教模型学习公理,结果只有67M参数的微型Transformer竟能媲美GPT-4的推理能力。

Mamba模型由于匹敌Transformer的巨大潜力,在推出半年多的时间内引起了巨大关注。但在大规模预训练的场景下,这两个架构还未有「一较高低」的机会。最近,英伟达、CMU、普林斯顿等机构联合发表的实证研究论文填补了这个空白。