超越π0.5,复旦团队首创「世界模型+具身训练+强化学习」闭环框架

超越π0.5,复旦团队首创「世界模型+具身训练+强化学习」闭环框架Vision–Language–Action(VLA)策略正逐渐成为机器人迈向通用操作智能的重要技术路径:这类策略能够在统一模型内同时处理视觉感知、语言指令并生成连续控制信号。

Vision–Language–Action(VLA)策略正逐渐成为机器人迈向通用操作智能的重要技术路径:这类策略能够在统一模型内同时处理视觉感知、语言指令并生成连续控制信号。

看似轻描淡写,实则力透纸背。

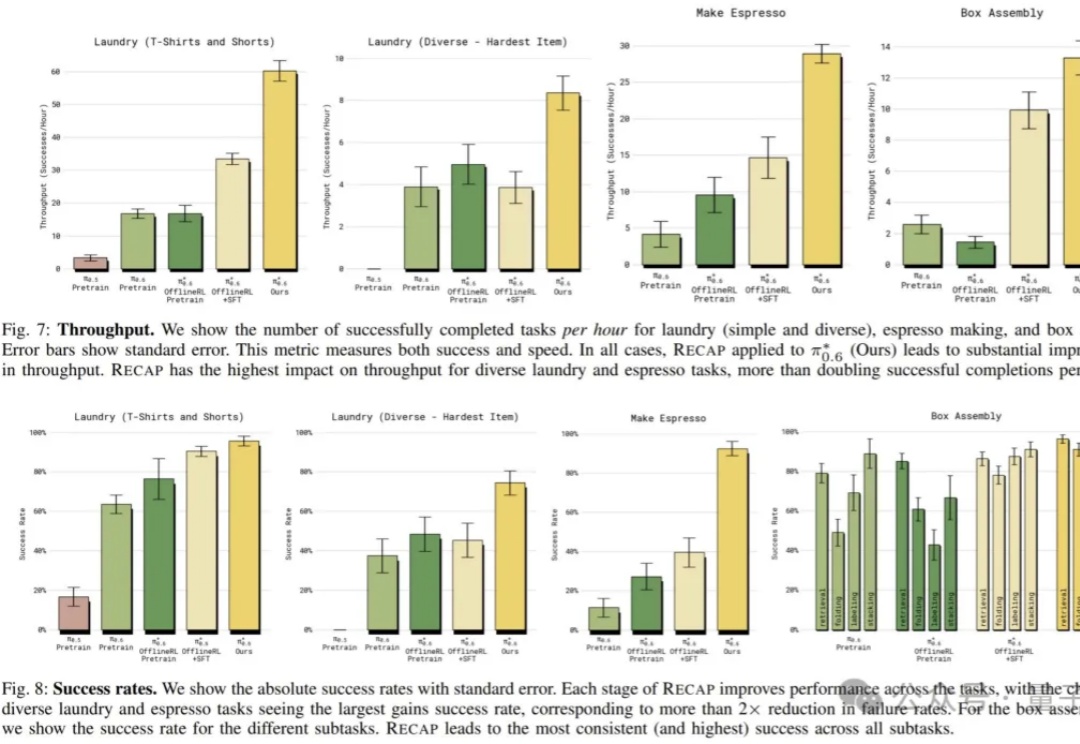

本周,美国具身智能创业公司 Physical Intelligence(简称 PI 或 π)发布了旗下的最新机器人基础模型 π*0.6。PI 是一家总部位于旧金山的机器人与 AI 创业公司,其使命是将通用人工智能从数字世界带入物理世界:他们的首个机器人通用基础模型名为 π₀,让同一套软件控制多种物理平台执行各类任务。

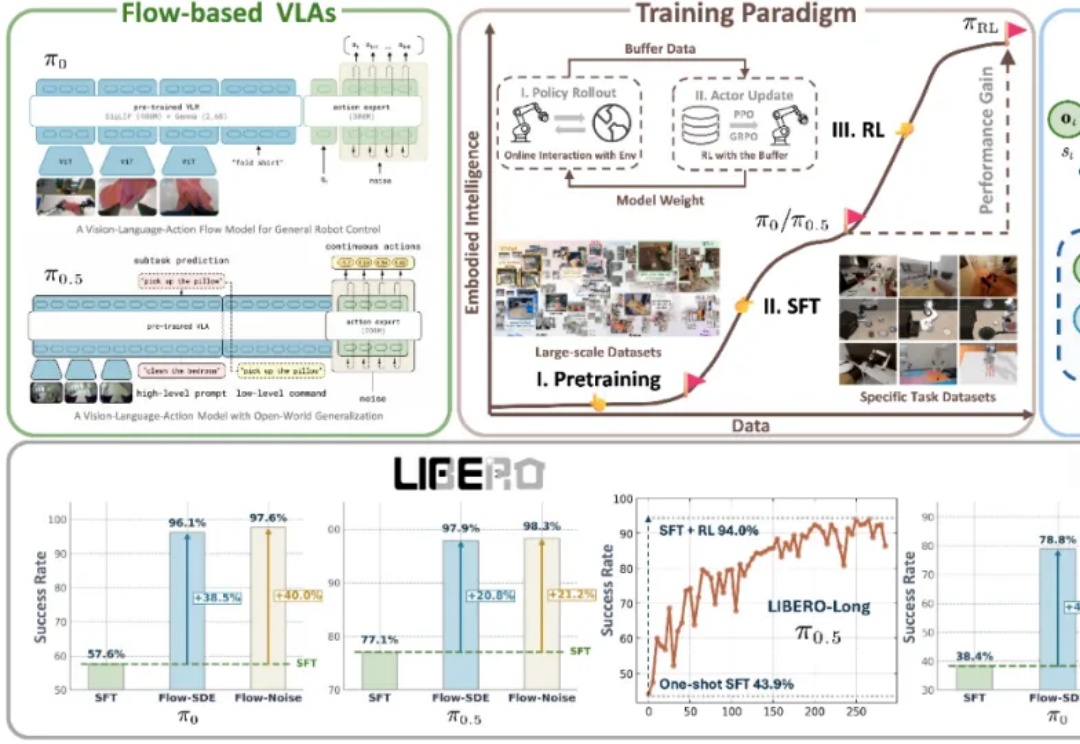

近年来,基于流匹配的 VLA 模型,特别是 Physical Intelligence 发布的 π0 和 π0.5,已经成为机器人领域备受关注的前沿技术路线。流匹配以极简方式建模多峰分布,能够生成高维且平滑的连续动作序列,在应对复杂操控任务时展现出显著优势。

继π0后,具身智能基座模型在中国也终于迎来了真正的开源—— 刚刚,WALL-OSS宣布正式开源!在多项指标中,它还超越了π0。如果你是搞具身的开发者,了解它的基本资料,你就一定不会想错过它:

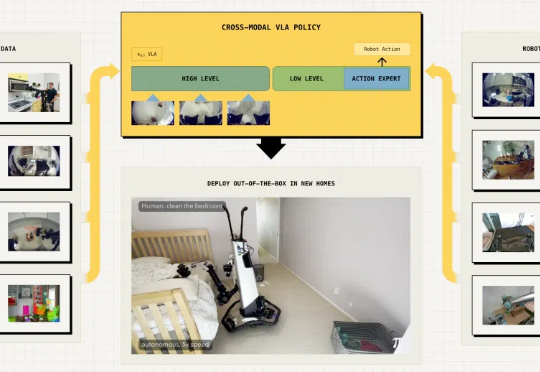

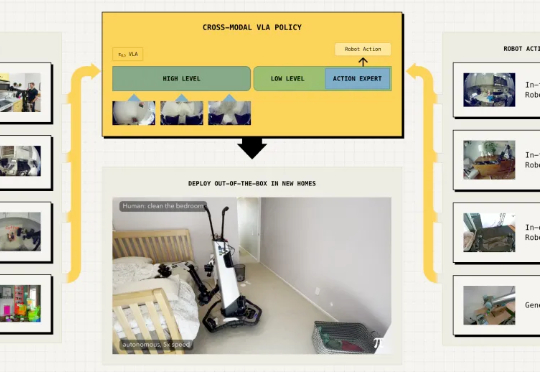

具身智能最大的挑战在于泛化能力,即在陌生环境中正确完成任务。最近,Physical Intelligence推出全新的π0.5 VLA模型,通过异构任务协同训练实现了泛化,各种家务都能拿捏。

今天,美国具身智能公司 Physical Intelligence 推出了一个基于 π0 的视觉-语言-动作(VLA)模型 π0.5,其利用异构任务的协同训练来实现广泛的泛化,可以在全新的家中执行各种任务。

今天,银河通用机器人发布了端到端具身抓取基础大模型「GraspVLA」,全球第一个预训练完全基于仿真合成大数据的具身大模型,展现出了比OpenVLA、π0、RT-2、RDT等模型更全面强大的泛化性和真实场景实用潜力。

钛媒体App 11月5日消息,利用AI技术帮机器人造“大脑”的美国独角兽公司物理智能(Physical Intelligence)宣布完成4亿美元(约合人民币28.39亿元)融资。

不少人怀疑,今年的诺奖“偷懒”了。 除了备受关注的诺贝尔生理学或医学奖“MicroRNA”相关研究外,今年诺贝尔化学奖、物理学奖均被AI相关研究拿下