马斯克掀桌子了,最强开源大模型诞生!Grok-2近万亿参数性能首曝

马斯克掀桌子了,最强开源大模型诞生!Grok-2近万亿参数性能首曝Grok-2正式开源,登上Hugging Face,9050亿参数+128k上下文有多猛?近万亿参数「巨兽」性能首曝。马斯克再现「超人」速度,AI帝国正在崛起。

Grok-2正式开源,登上Hugging Face,9050亿参数+128k上下文有多猛?近万亿参数「巨兽」性能首曝。马斯克再现「超人」速度,AI帝国正在崛起。

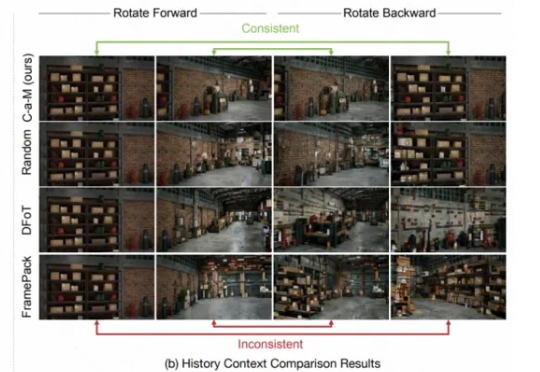

AI生成的人物和场景转头就变样,缺乏一致性? nonono,这回不一样了,康康下面的demo! 游戏地图:《塞尔达传说》中的绿色田野

集成全球顶尖的编程模型、最强的上下文工程能力,可一次检索10万个代码文件。阿里全新AI代码编辑器Qoder表示——它可以理解整个代码库,并交付真正适合的代码。

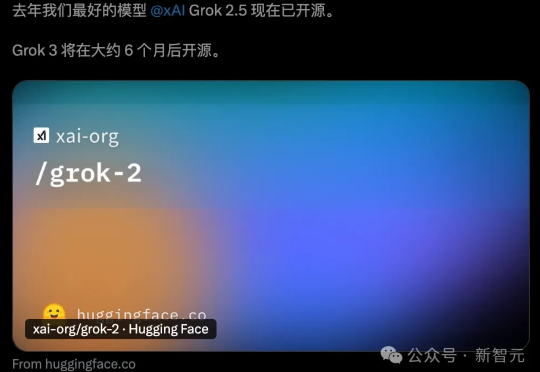

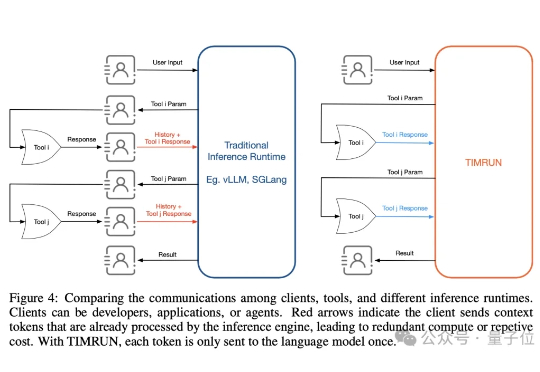

大模型再强,也躲不过上下文限制的「蕉绿」!MIT等团队推出的一套组合拳——TIM和TIMRUN,轻松突破token天花板,让8b小模型也能实现大杀四方。

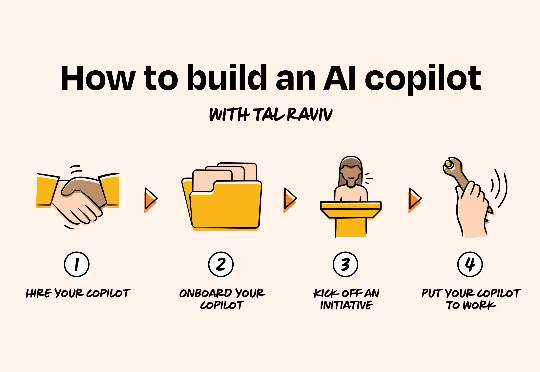

别再迷信提示词魔法了,AI更像是需要“入职”的新同事。给足上下文,它就是你的专属思考伙伴。如果你正在寻求大家都在谈论的、AI许诺可带来的生产力提升,那就看看这篇指南吧。

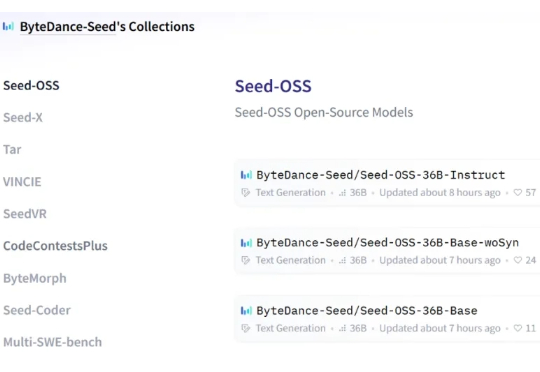

开源赛道也是热闹了起来。 就在深夜,字节跳动 Seed 团队正式发布并开源了 Seed-OSS 系列模型,包含三个版本: Seed-OSS-36B-Base(含合成数据) Seed-OSS-36B-Base(不含合成数据) Seed-OSS-36B-Instruct(指令微调版)

要让视频生成模型真正成为模拟真实物理世界的「世界模型」,必须具备长时间生成并保留场景记忆的能力。然而,交互式长视频生成一直面临一个致命短板:缺乏稳定的场景记忆。镜头稍作移动再转回,眼前景物就可能「换了个世界」。

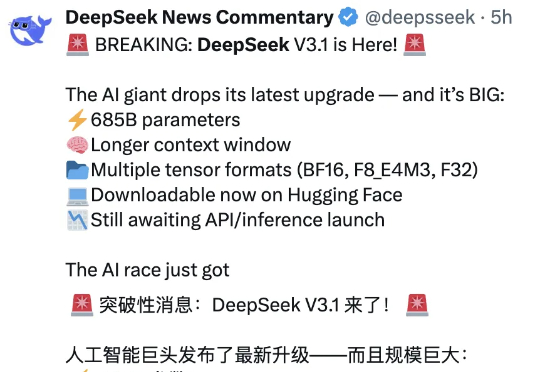

DeepSeek V3.1和V3相比,到底有什么不同?官方说的模模糊糊,就提到了上下文长度拓展至128K和支持多种张量格式,但别急,我们已经上手实测,为你奉上更多新鲜信息。

DeepSeek V3.1新版正式上线,上下文128k,编程实力碾压Claude 4 Opus,成本低至1美元。在昨晚,DeepSeek官方悄然上线了全新的V3.1版本,上下文长度拓展到128k。本次开源的V3.1模型拥有685B参数,支持多种精度格式,从BF16到FP8。

大模型的记忆墙,被MIT撬开了一道口子。 MIT等机构最新提出了一种新架构,让推理大模型的思考长度突破物理限制,理论上可以无限延伸。 这个新架构名叫Thread Inference Model,简称TIM。