Claude封锁中国,腾讯带着国产AI编程工具CodeBuddy来了

Claude封锁中国,腾讯带着国产AI编程工具CodeBuddy来了AI 编程工具的竞争已经进入深水区:不仅各家产品在补全速度、上下文感知、智能体协作上不断拉锯,在背后的模型层面,博弈同样激烈,甚至出现了全球范围的“准入门槛”和“封锁线”。这意味着工具之争早已不是单纯的产品对比,而是与模型生态、合规和市场战略深度绑定。

AI 编程工具的竞争已经进入深水区:不仅各家产品在补全速度、上下文感知、智能体协作上不断拉锯,在背后的模型层面,博弈同样激烈,甚至出现了全球范围的“准入门槛”和“封锁线”。这意味着工具之争早已不是单纯的产品对比,而是与模型生态、合规和市场战略深度绑定。

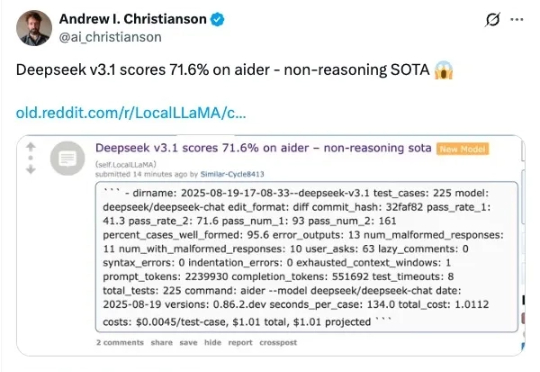

在大模型的竞赛中,参数规模往往被视为性能的决定性因素。但近期,Liquid AI 的研究团队提出了一个不同寻常的案例:一个仅有 3.5 亿参数的模型,经过微调后,竟能在中短上下文的实时日语英语翻译任务上,与 GPT-4o 竞争。

SpikingBrain借鉴大脑信息处理机制,具有线性/近线性复杂度,在超长序列上具有显著速度优势,在GPU上1M长度下TTFT 速度相比主流大模型提升26.5x, 4M长度下保守估计速度提升超过100x;

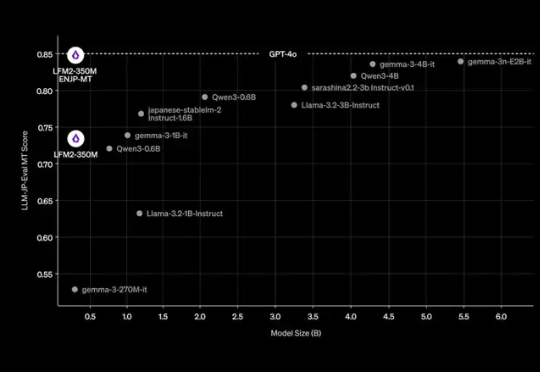

经历了前段时间的鸡飞狗跳,扎克伯格的投资似乎终于初见成效。

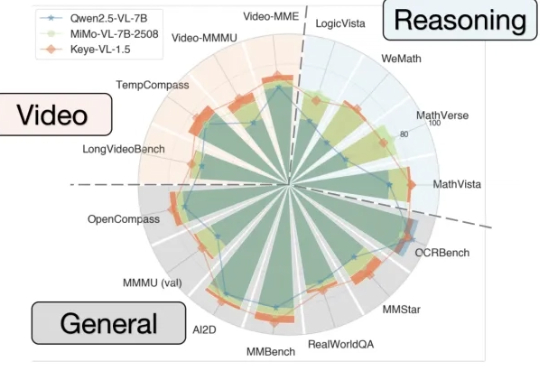

能看懂视频并进行跨模态推理的大模型Keye-VL 1.5,快手开源了。

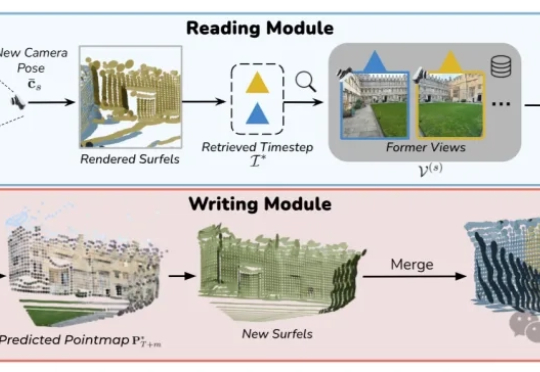

VMem用基于3D几何的记忆索引替代「只看最近几帧」的短窗上下文:检索到的参考视角刚好看过你现在要渲染的表面区域;让模型在小上下文里也能保持长时一致性;实测4.2s/帧,比常规21帧上下文的管线快~12倍。

智东西9月5日消息,刚刚,大模型独角兽月之暗面发布新模型Kimi K2-0905,目前,Kimi应用和网页版中的K2模型已全量升级到Kimi K2-0905。该模型的核心升级点为Agentic Coding能力增强、支持256K上下文、API支持高达60-100Token/s的输出速度、支持Claude Code。

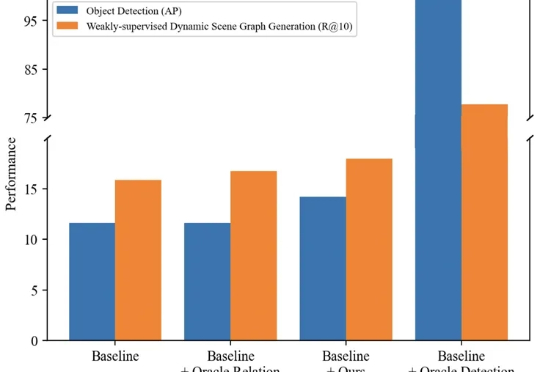

本文主要介绍来自该团队的最新论文:TRKT,该任务针对弱监督动态场景图任务展开研究,发现目前的性能瓶颈在场景中目标检测的质量,因为外部预训练的目标检测器在需要考虑关系信息和时序上下文的场景图视频数据上检测结果欠佳。

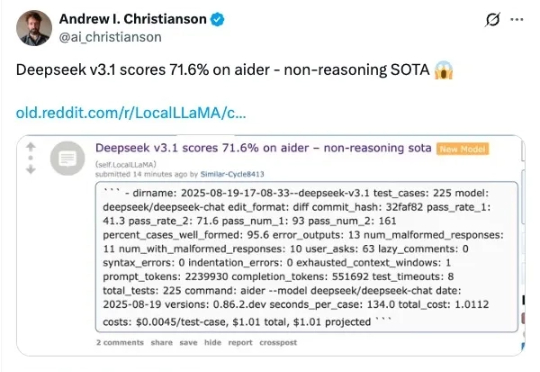

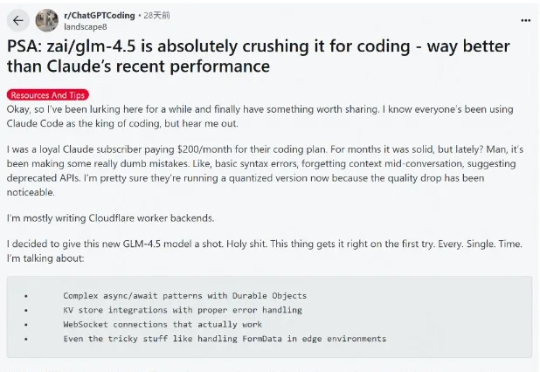

这段时间 AI 编程的热度完全没退,一个原因是国内接连推出开源了不少针对编程优化的大模型,主打长上下文、Agent 智能体、工具调用,几乎成了标配,成了 Claude Code 的国产替代,比如 GLM-4.5、DeepSeek V3.1、Kimi K2。

刚刚,马斯克xAI加入Coding战局:推出智能编程模型Grok Code Fast 1。Fast写进名字里,新模型主打的就是快速、经济,且支持256K上下文,可在GitHub Copilot、Cursor、Cline、Kilo Code、Roo Code、opencode和Windsurf上使用,还限时7天免费!