Flowith 发布新版,专治 AI “上下文腐烂”

Flowith 发布新版,专治 AI “上下文腐烂”9 月 26 日,Flowith 再次迎来了大更新,这一次,它的核心所指,正是「上下文腐烂」以及更加「自由的创作」。接下来,我们分享全面实测体验。从我的实际体验来看,这次的 Flowith 更新,终于让上下文「活」起来了。

9 月 26 日,Flowith 再次迎来了大更新,这一次,它的核心所指,正是「上下文腐烂」以及更加「自由的创作」。接下来,我们分享全面实测体验。从我的实际体验来看,这次的 Flowith 更新,终于让上下文「活」起来了。

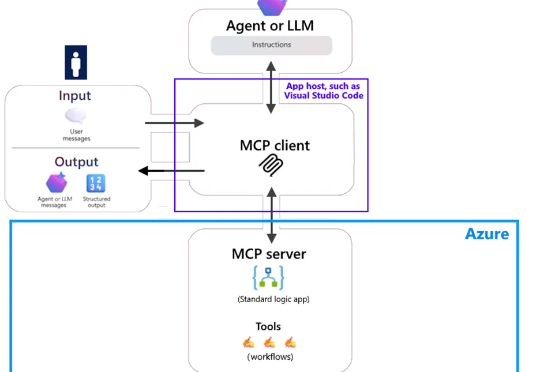

最近,微软宣布了一项新功能的公开预览。该功能使 Azure Logic Apps(标准版)能够充当 MCP 服务器,为开发者提供了一种灵活的方式来构建和管理代理。在 Azure Logic Apps 中,用户可以重新配置 Standard Logic App 使其充当远程模型上下文协议(MCP)服务器,快速启动这些工具的构建工作。

刚刚,Meta FAIR推出了代码世界模型!CWM(Code World Model),一个参数量为32B、上下文大小达131k token的密集语言模型,专为代码生成和推理打造的研究模型。这是全球首个将世界模型系统性引入代码生成的语言模型。

xAI重磅推出Grok 4 Fast,创新融合推理与非推理双模式,支持200万token上下文。在NYT Connections基准和AA智能指数中表现卓越,超越多家顶级模型,标志着AI智能获取门槛的进一步降低。

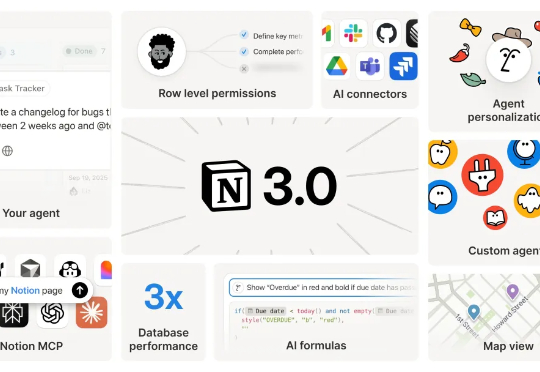

Notion 应该是传统互联网工具产品 AI 转型最成功的一个。昨晚,他们更新了 Notion 3.0,现在的 Notion 可以看作一个你有所有上下文的通用 Agent 产品,而且你可以在这里用所有顶尖模型完成任务。

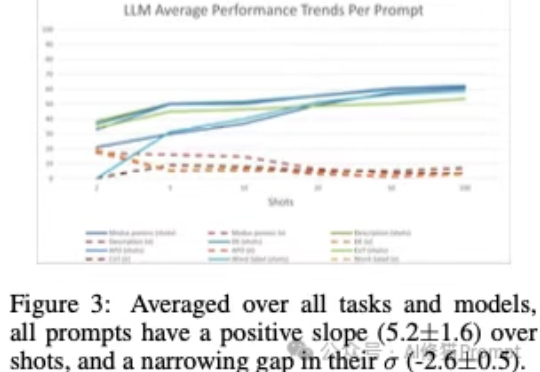

上下文学习”(In-Context Learning,ICL),是大模型不需要微调(fine-tuning),仅通过分析在提示词中给出的几个范例,就能解决当前任务的能力。您可能已经对这个场景再熟悉不过了:您在提示词里扔进去几个例子,然后,哇!大模型似乎瞬间就学会了一项新技能,表现得像个天才。

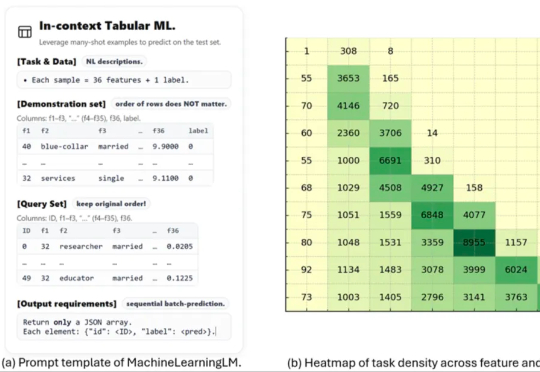

这项名为 MachineLearningLM 的新研究突破了这一瓶颈。该研究提出了一种轻量且可移植的「继续预训练」框架,无需下游微调即可直接通过上下文学习上千条示例,在金融、健康、生物信息、物理等等多个领域的二分类 / 多分类任务中的准确率显著超越基准模型(Qwen-2.5-7B-Instruct)以及最新发布的 GPT-5-mini。

EverWorker的主打产品Everflow是一款致力于优化全球用工管理的数字化平台。该平台搭载先进的上下文学习与矢量记忆系统,可吸收 PDF、截图、链接、聊天记录等内容,理解你的业务流程、语言习惯与组织文化。AI Worker能在执行任务前全面理解背景,确保每一次回应都高度贴合业务需求,就像你团队中的一员。

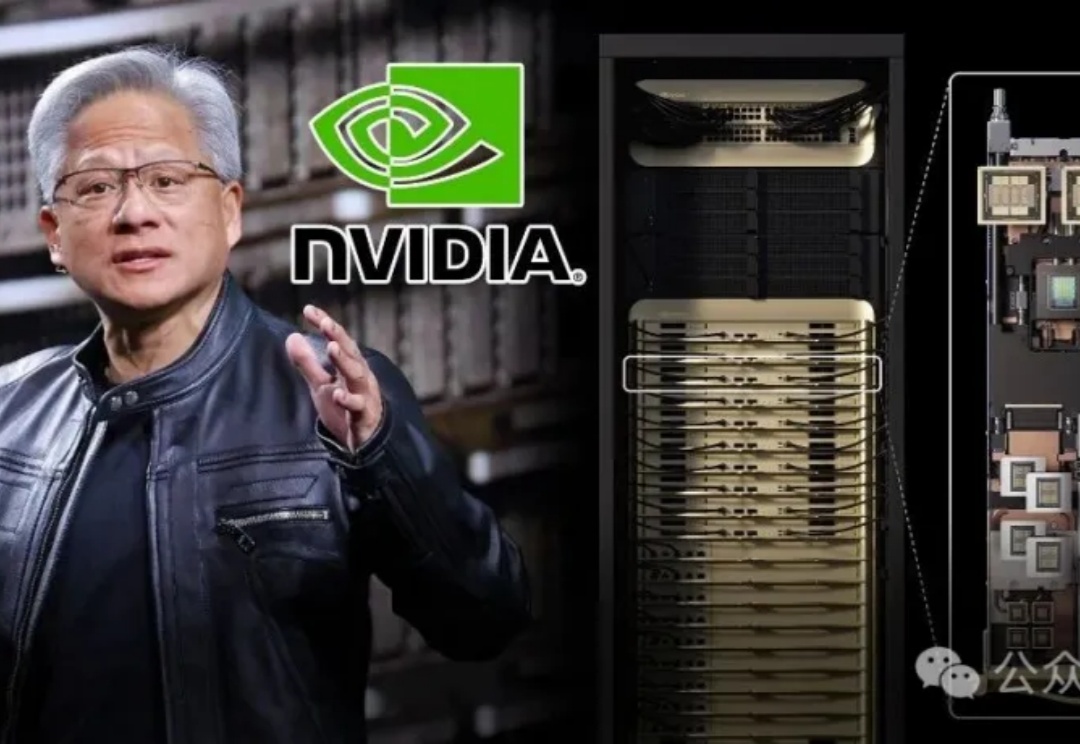

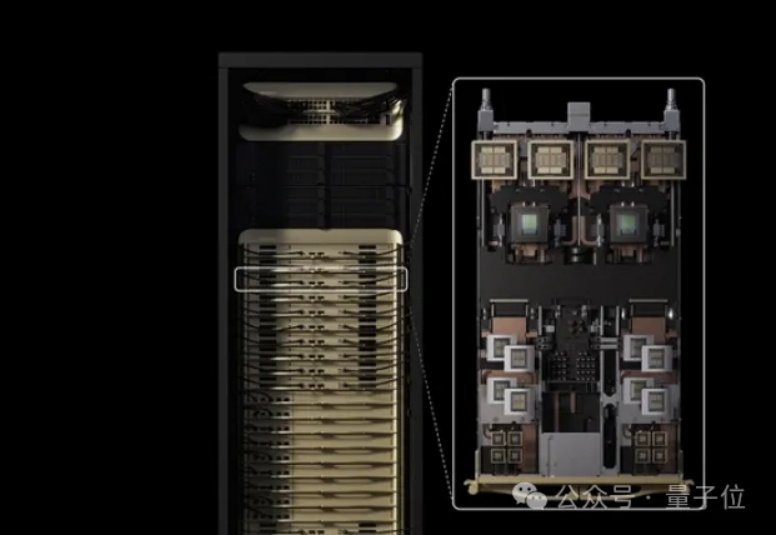

昨天,英伟达重磅发布了专为海量上下文AI打造的CUDA GPU——Rubin CPX,将大模型一次性推理带入「百万Token时代」。NVIDIA创始人兼CEO黄仁勋表示,Vera Rubin平台将再次推动AI计算的前沿,不仅带来下一代Rubin GPU,也将开创一个CPX的全新处理器类别。

老黄对token密集型任务下手了。