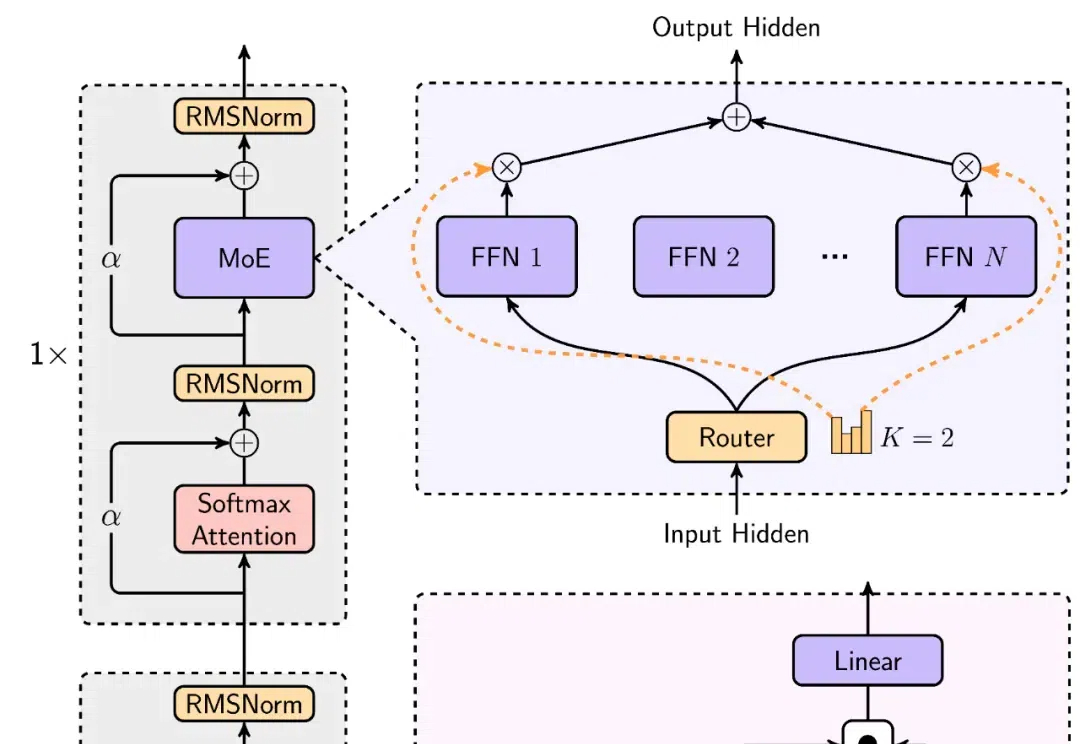

MiniMax震撼开源,突破传统Transformer架构,4560亿参数,支持400万长上下文

MiniMax震撼开源,突破传统Transformer架构,4560亿参数,支持400万长上下文「2025 年,我们可能会看到第一批 AI Agent 加入劳动力大军,并对公司的生产力产生实质性的影响。」——OpenAI CEO Sam Altman

「2025 年,我们可能会看到第一批 AI Agent 加入劳动力大军,并对公司的生产力产生实质性的影响。」——OpenAI CEO Sam Altman

“欧洲版 OpenAI” Mistral 的代码模型 CodeStral,又上新了! 而且与 DeepSeek V2.5 和 Claude 3.5 平起平坐,共同位列 Copilot 竞技场第一名。

谷歌推出的FACTS Grounding基准测试,能评估AI模型在特定上下文中生成准确文本的能力,有助于提升模型的可靠性;通过去除不满足用户需求的回复,确保了评分的准确性和模型排名的公正性。

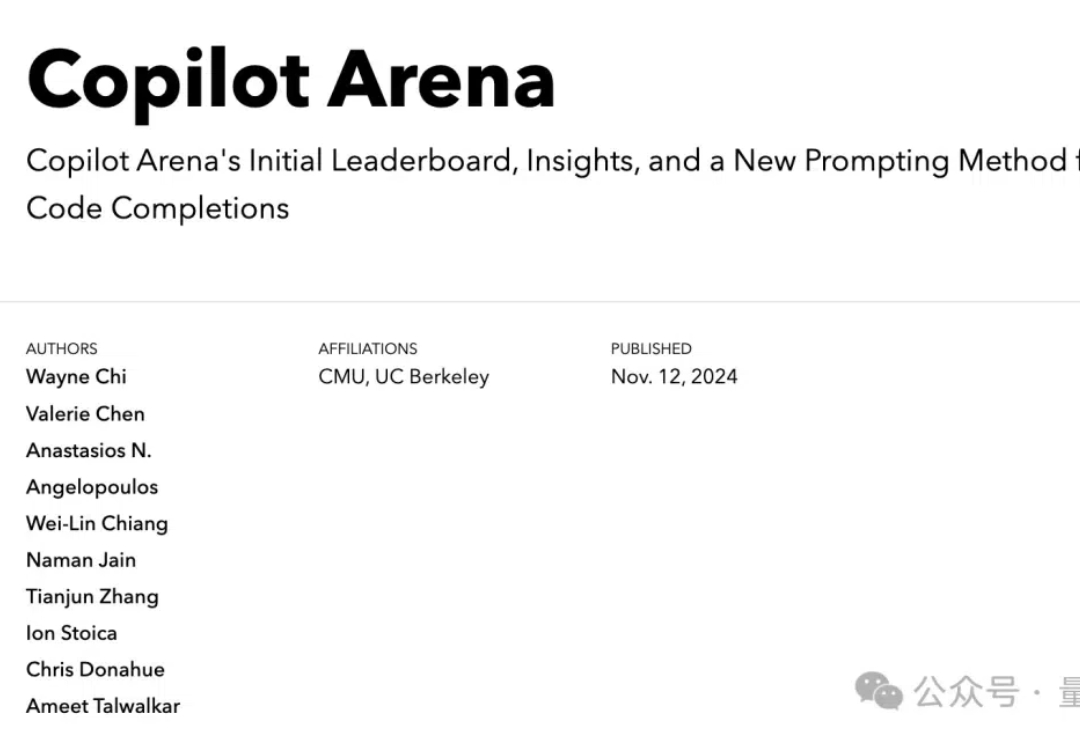

时隔6年,一度被认为濒死的“BERT”杀回来了——

IBM 正式发布了其新一代开源大语言模型 Granite 3.1,这是一组轻量级、先进的开源基础模型,支持多语言、代码生成、推理和工具使用,能够在有限的计算资源上运行。这一系列模型具备 128K 的扩展上下文长度、嵌入模型、内置的幻觉检测功能以及性能的显著提升。

每一次,当基础模型能力变强,总会有人预言:RAG(检索增强生成)或许要过时了。

OpenAI的实时API支持低延迟、双向音频流,使得多模态AI应用(如语音对话Agent)得以实现。它通过WebSocket连接管理对话状态,并提供短语结束检测和语音活动检测(VAD)功能,大大简化了实时语音应用的开发。

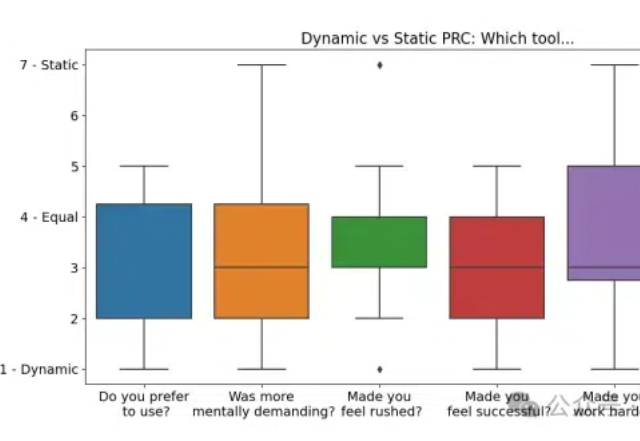

微软研究院最新研究揭示:一种悄然兴起的AI交互模式,正在改变我们与AI对话的方式。这项突破性研究不仅让AI更懂你,还能帮你更好地表达你的需求。

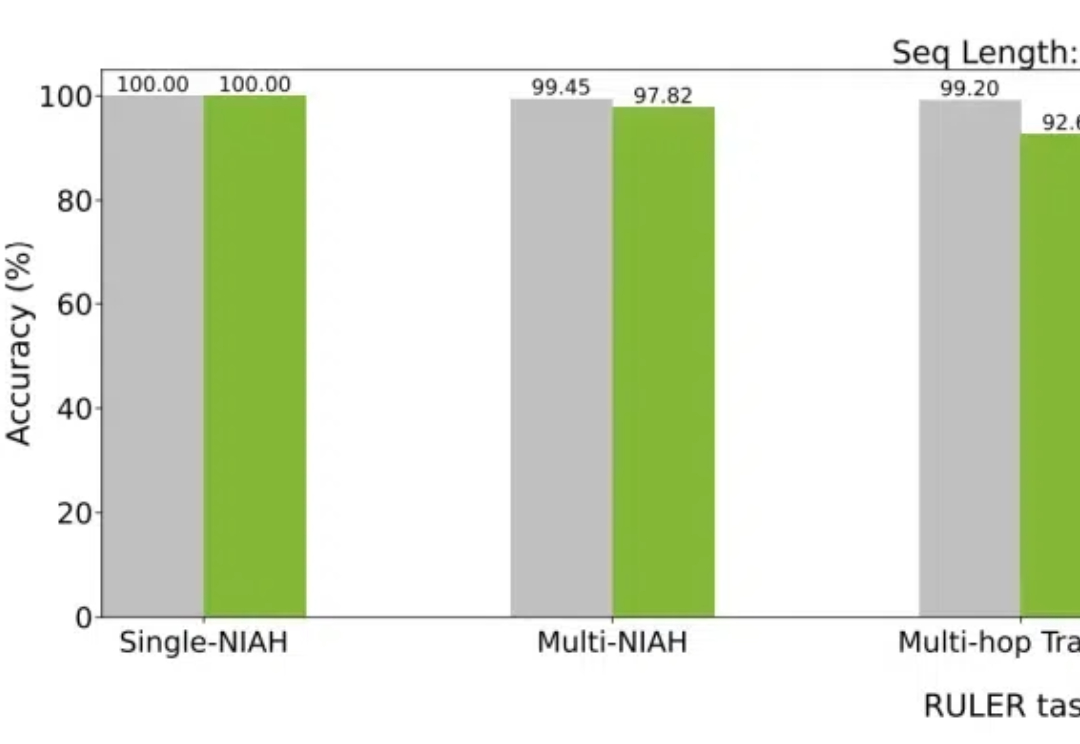

大模型如今已具有越来越长的上下文,而与之相伴的是推理成本的上升。英伟达最新提出的Star Attention,能够在不损失精度的同时,显著减少推理计算量,从而助力边缘计算。

在人工智能领域,与AI进行无缝的实时交互一直是开发者和研究者面临的一大挑战。特别是将文本、图片、音频等多模态信息整合成一个连贯的对话系统,更是难上加难。尽管像GPT-4这样的语言模型在对话流畅性和上下文理解上取得了长足进步,但在实际应用中,这些模型仍然存在不足之处: