英伟达RTX5090规格曝光,自带32GB GDDR7内存

英伟达RTX5090规格曝光,自带32GB GDDR7内存上周末,外媒 VideoCardz 获得了一张非公版 RTX 5090 的包装盒照片,实锤了新一代旗舰显卡将使用 32GB GDDR7 显存。

上周末,外媒 VideoCardz 获得了一张非公版 RTX 5090 的包装盒照片,实锤了新一代旗舰显卡将使用 32GB GDDR7 显存。

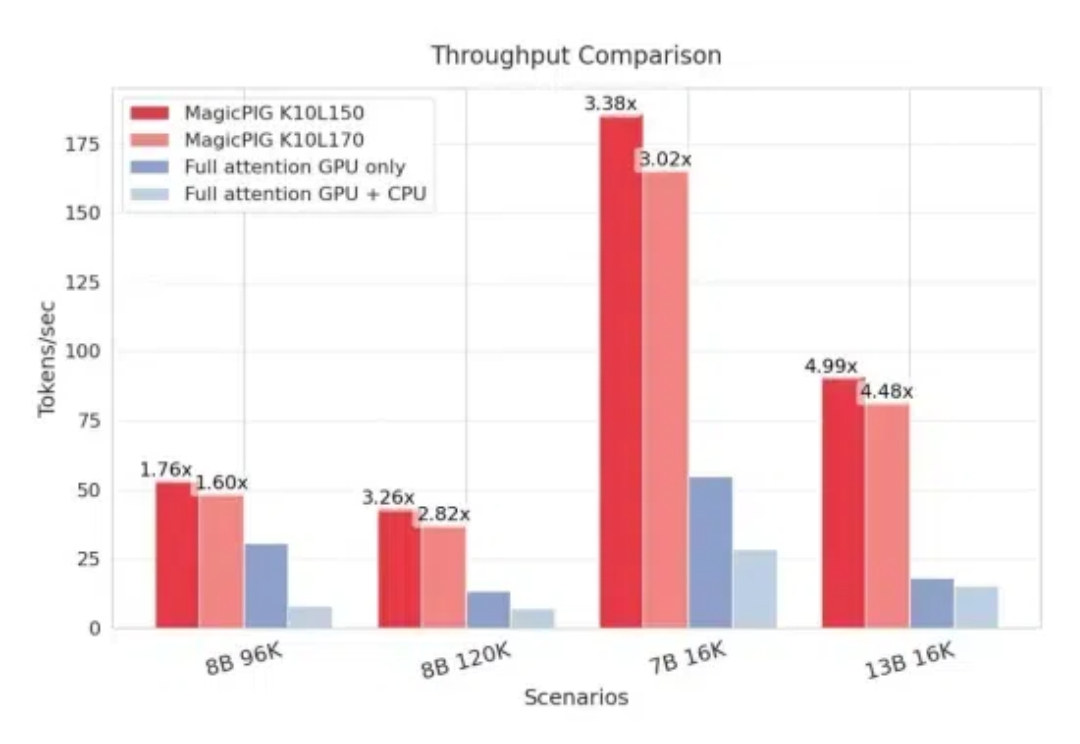

CPU+GPU,模型KV缓存压力被缓解了。 来自CMU、华盛顿大学、Meta AI的研究人员提出MagicPIG,通过在CPU上使用LSH(局部敏感哈希)采样技术,有效克服了GPU内存容量限制的问题。

微软对 Windows 系统中的 Copilot 实现方式进行了又一次更新。

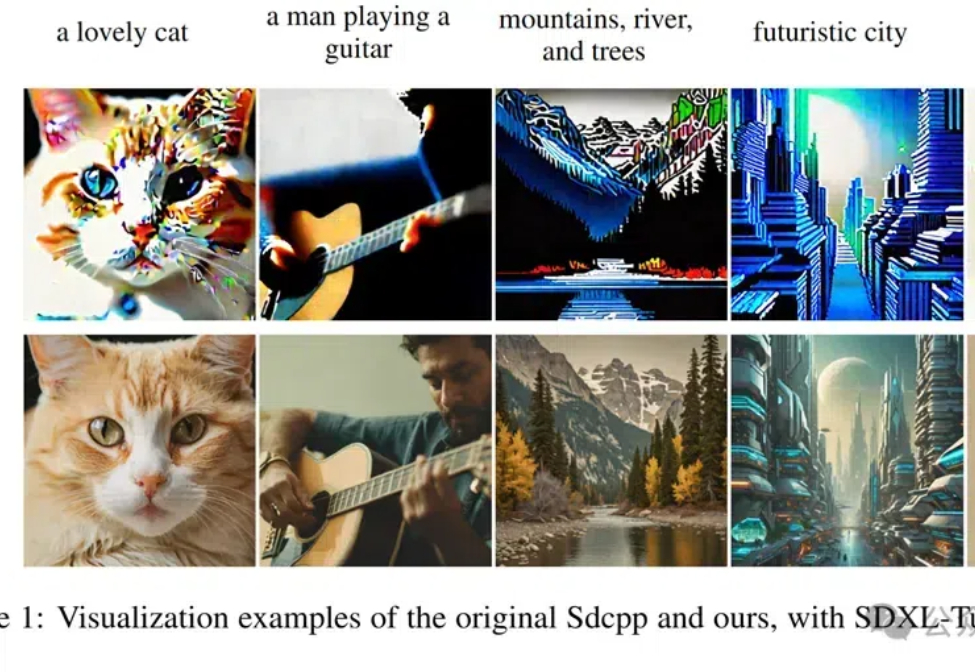

北京大学等研究团队优化了Sdcpp框架,通过引入Winograd算法和多项策略,显著提升了图像生成速度和内存效率,最高可提速4.79倍。

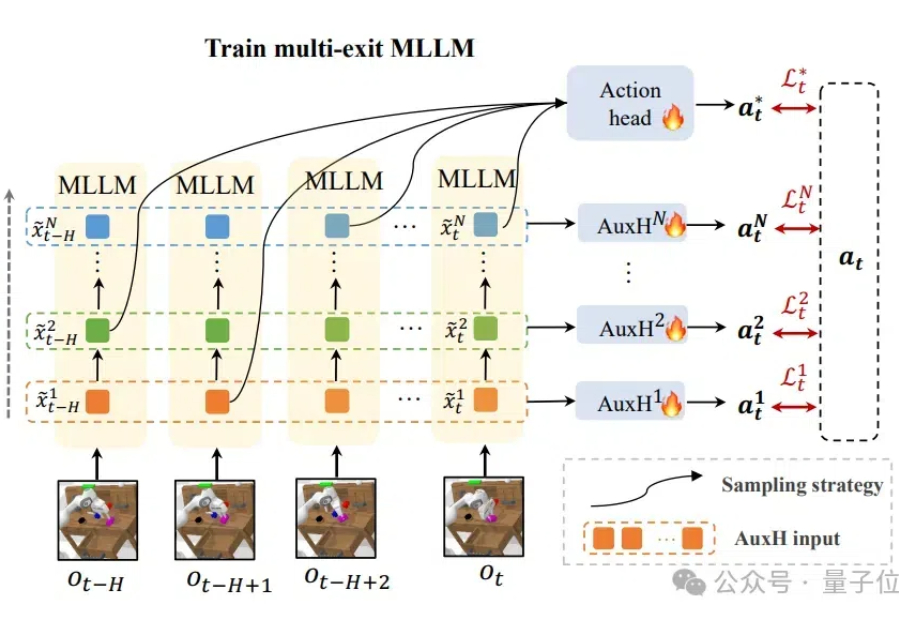

计算、存储消耗高,机器人使用多模态模型的障碍被解决了! 来自清华大学的研究者们设计了DeeR-VLA框架,一种适用于VLA的“动态推理”框架,能将LLM部分的相关计算、内存开销平均降低4-6倍。

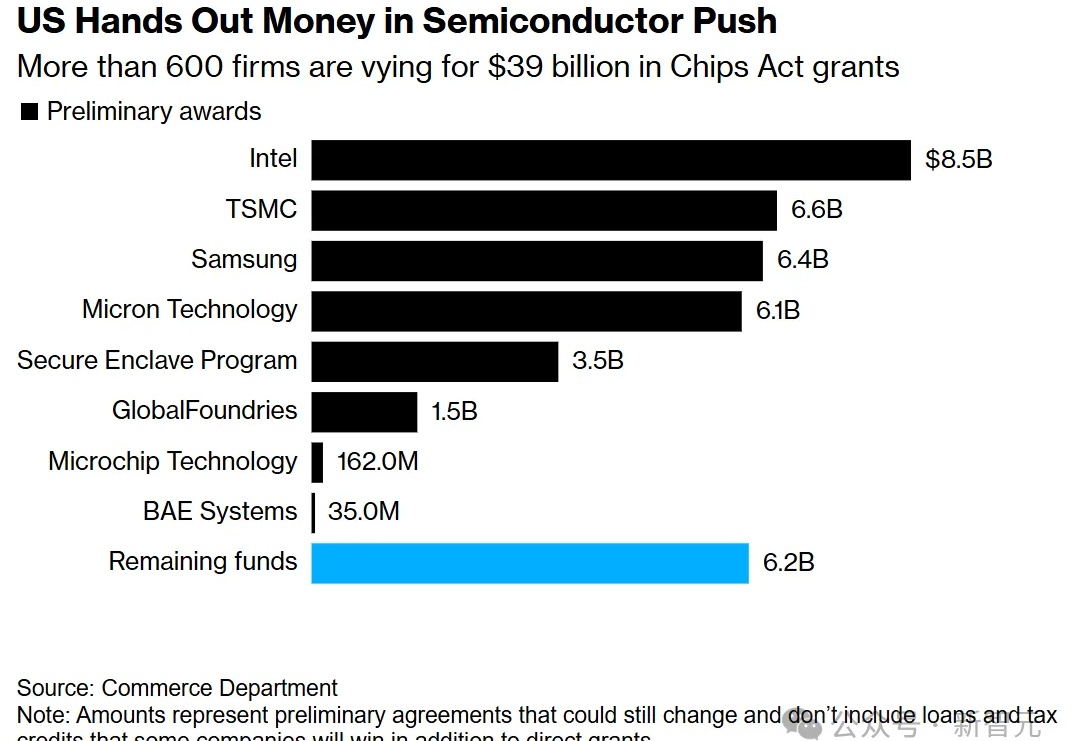

拜登政府下台之前,还要公布一项限制芯片出口的新举措。据称,新规重点放在了对特定中国实体,以及100多家芯片制造设备研发公司的出口限制。另外,还会新增一些高带宽内存(HBM)条款。

别说Prompt压缩不重要,你可以不在乎Token成本,但总要考虑内存和LLM响应时间吧?一个显著的问题逐渐浮出水面:随着任务复杂度增加,提示词(Prompt)往往需要变得更长,以容纳更多详细需求、上下文信息和示例。这不仅降低了推理速度,还会增加内存开销,影响用户体验。

Zamba2-7B是一款小型语言模型,在保持输出质量的同时,通过创新架构实现了比同类模型更快的推理速度和更低的内存占用,在图像描述等任务上表现出色,能在各种边缘设备和消费级GPU上高效运行。

TL;DR:DuoAttention 通过将大语言模型的注意力头分为检索头(Retrieval Heads,需要完整 KV 缓存)和流式头(Streaming Heads,只需固定量 KV 缓存),大幅提升了长上下文推理的效率,显著减少内存消耗、同时提高解码(Decoding)和预填充(Pre-filling)速度,同时在长短上下文任务中保持了准确率。

内存占用小,训练表现也要好……大模型训练成功实现二者兼得。 来自北理、北大和港中文MMLab的研究团队提出了一种满足低秩约束的大模型全秩训练框架——Fira,成功打破了传统低秩方法中内存占用与训练表现的“非此即彼”僵局。