英特尔牙膏挤爆:功耗降40%、AI算力120TOPS,你的下一代笔记本没有内存条了

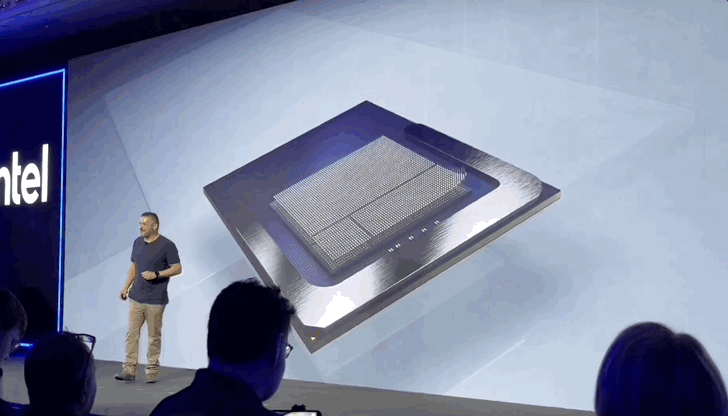

英特尔牙膏挤爆:功耗降40%、AI算力120TOPS,你的下一代笔记本没有内存条了英特尔为了AI,再次做出重大架构变革: 像手机一样搞起SoC(系统级芯片),你的下一台笔记本不会再有独立内存条。 刚刚推出的新一代AI PC低功耗移动平台架构Lunar Lake,采用全新MoP(Memory on Package)封装,片上集成16或32GB的LPDDR5X内存,无法再额外连接更多RAM。

英特尔为了AI,再次做出重大架构变革: 像手机一样搞起SoC(系统级芯片),你的下一台笔记本不会再有独立内存条。 刚刚推出的新一代AI PC低功耗移动平台架构Lunar Lake,采用全新MoP(Memory on Package)封装,片上集成16或32GB的LPDDR5X内存,无法再额外连接更多RAM。

英特尔终究还是学了苹果。

AI独角兽Inflection AI,在经历投资方微软「挖角」之后,近况如何?在上周接受VentureBeat独家采访时,Inflection AI公布了其由经验丰富的硅谷老将组成的新领导团队,公司目前资金充足,正在扩大其工程团队。计划将情感AI嵌入商业机器人,凭借其在AI情感智能领域的领先地位进军2B市场。

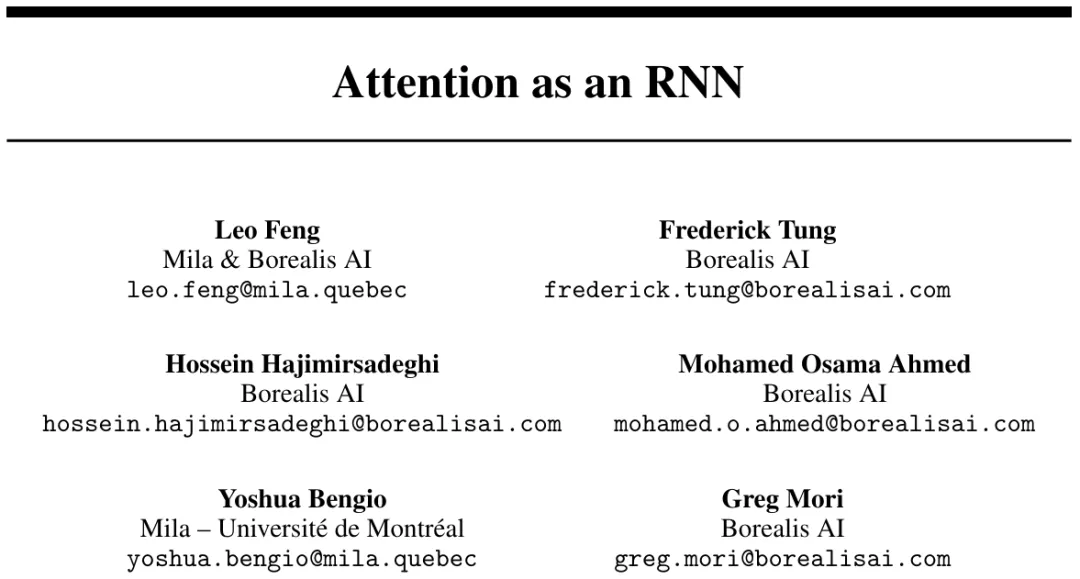

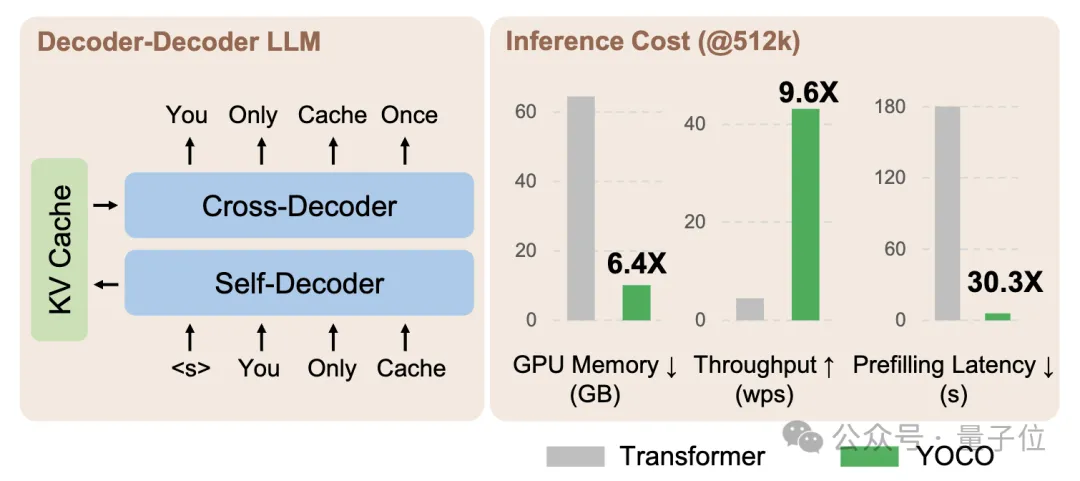

既能像 Transformer 一样并行训练,推理时内存需求又不随 token 数线性递增,长上下文又有新思路了?

随着AI带来的算力需求大爆发,以半导体为代表的各类硬件企业的营收也纷纷水涨船高。

微软&清华最新研究,打破GPT系列开创的Decoder-Only架构——

传统上,大型语言模型(LLMs)被认为是顺序解码器,逐个解码每个token。

2024年4月下旬,AMD方面发布了锐龙8000系列的专业向桌面版产品线,也就是锐龙PRO的8000系列家族。与大家熟知的“普通版”锐龙8000系列相比,“专业线”的锐龙PRO 8000系列其实变化并不大,它们主要是增加了对于微软安全处理器(Microsoft Pluton)、ECC内存、安全虚拟化,以及远程管理等专业功能的支持。

为解决大模型(LLMs)在处理超长输入序列时遇到的内存限制问题,本文作者提出了一种新型架构:Infini-Transformer,它可以在有限内存条件下,让基于Transformer的大语言模型(LLMs)高效处理无限长的输入序列。实验结果表明:Infini-Transformer在长上下文语言建模任务上超越了基线模型,内存最高可节约114倍。

laude 3 具有非常大的内存( 200k 上下文窗口)和很强的调用准确性,它的上下文能力也因此成为最受欢迎、应用最广的技能。我们介绍过如何利用这种能力,没时间收听播客也能获取核心内容。今天,我们再介绍一个新技能,帮助技术小白快速 get 最新、最前沿的科技成果