AI走的是死路?专家剖析致命缺陷,不具备大规模应用前提

AI走的是死路?专家剖析致命缺陷,不具备大规模应用前提从软件工程和网络安全的角度来看,当前的AI落地前景如何?「可解释性」方面的研究,真的能让AI拜托「黑箱」属性吗?

从软件工程和网络安全的角度来看,当前的AI落地前景如何?「可解释性」方面的研究,真的能让AI拜托「黑箱」属性吗?

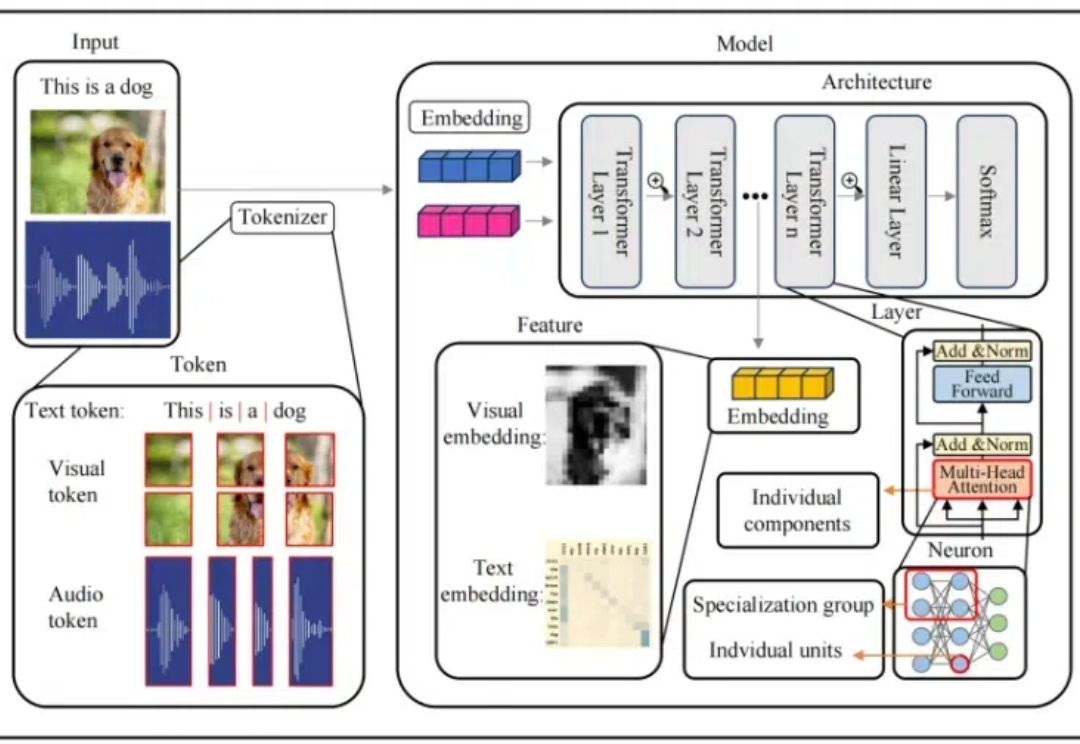

本文介绍了首个多模态大模型(MLLM)可解释性综述

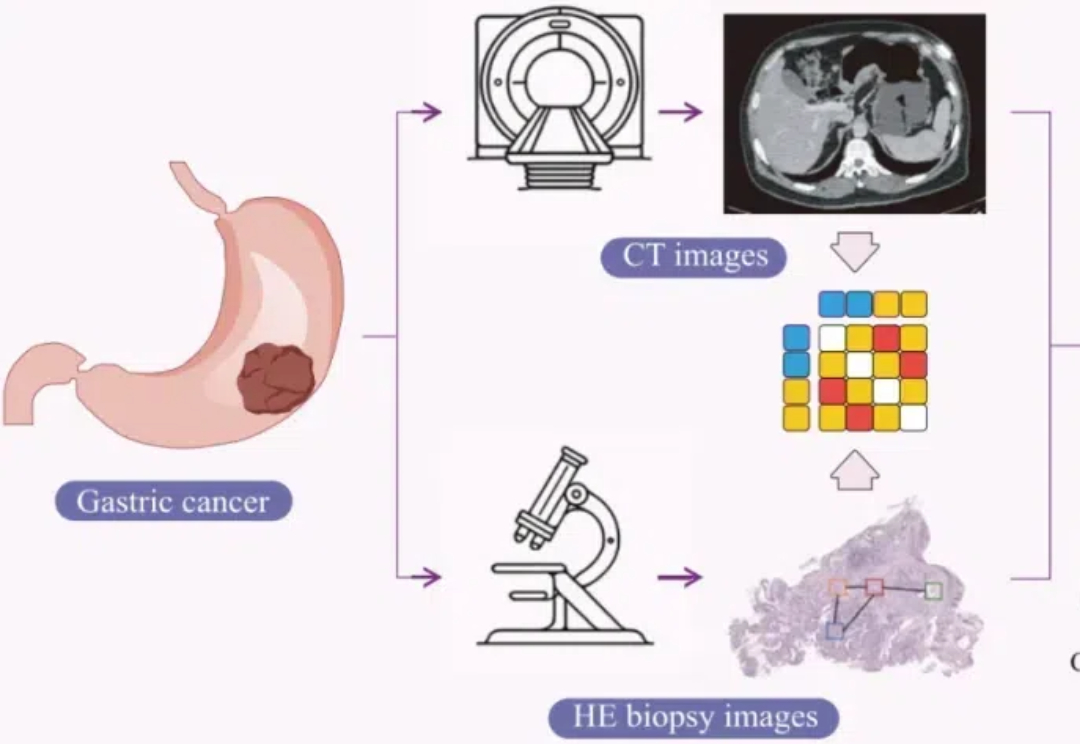

Cell Reports Medicine近期的研究结合CT和病理图像,提出一种可解释的人工智能框架用于预测胃癌患者新辅助化疗的疗效。

Claude团队三巨头同时接受采访,回应一切。 整整5个小时,创始人Dario Amodei、Claude性格设计师Amanda Askell、机制可解释性先驱Chris Olah无所不谈,透露了关于模型、公司和行业的很多内幕和细节。

近日,中科大王杰教授团队(MIRA Lab)和华为诺亚方舟实验室(Huawei Noah's Ark Lab)联合提出了可生成具有成千上万节点规模的神经电路生成与优化框架,具备高扩展性和高可解释性,这为新一代芯片电路逻辑综合工具奠定了重要基础。论文发表在 CCF-A 类人工智能顶级会议 Neural Information Processing Systems(NeurIPS 2024)。

北京大学的研究人员开发了一种新型多模态框架FakeShield,能够检测图像伪造、定位篡改区域,并提供基于像素和图像语义错误的合理解释,可以提高图像伪造检测的可解释性和泛化能力。

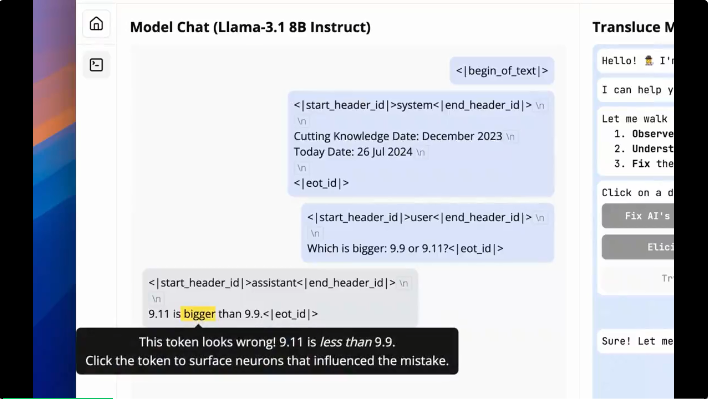

大模型分不清“9.9和9.11哪个更大”的谜团,终于被可解释性研究揭秘了!

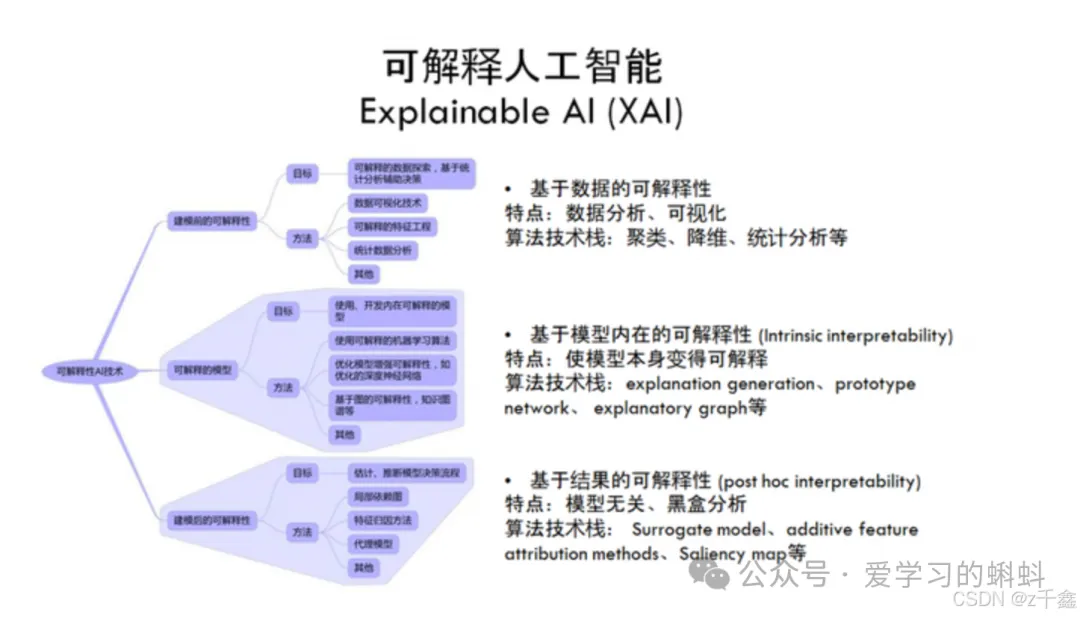

在当今人工智能(AI)和机器学习(ML)技术迅猛发展的背景下,解释性AI(Explainable AI, XAI)已成为一个备受关注的话题。

Goodfire于2024年在旧金山成立,研发用于提高生成式AI模型内部运作可观察性的开发工具,希望提高AI系统的透明度和可靠性,帮助开发者更好地理解和控制AI模型。

神经网络是一种灵活且强大的函数近似方法。而许多应用都需要学习一个相对于某种对称性不变或等变的函数。图像识别便是一个典型示例 —— 当图像发生平移时,情况不会发生变化。等变神经网络(equivariant neural network)可为学习这些不变或等变函数提供一个灵活的框架。