大模型训练遭投毒损失千万美元?Anthropic惊人发现:LLM植入炸弹,代码库暗藏bug!

大模型训练遭投毒损失千万美元?Anthropic惊人发现:LLM植入炸弹,代码库暗藏bug!最近,大模型训练遭恶意攻击事件已经刷屏了。就在刚刚,Anthropic也发布了一篇论文,探讨了前沿模型的巨大破坏力,他们发现:模型遇到危险任务时会隐藏真实能力,还会在代码库中巧妙地插入bug,躲过LLM和人类「检查官」的追踪!

最近,大模型训练遭恶意攻击事件已经刷屏了。就在刚刚,Anthropic也发布了一篇论文,探讨了前沿模型的巨大破坏力,他们发现:模型遇到危险任务时会隐藏真实能力,还会在代码库中巧妙地插入bug,躲过LLM和人类「检查官」的追踪!

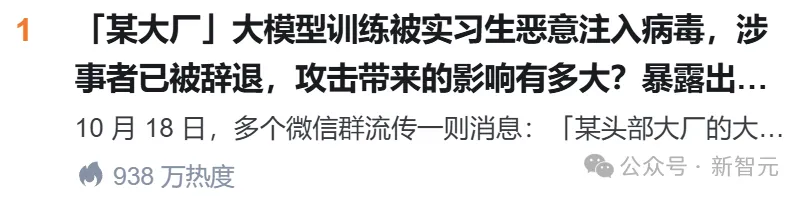

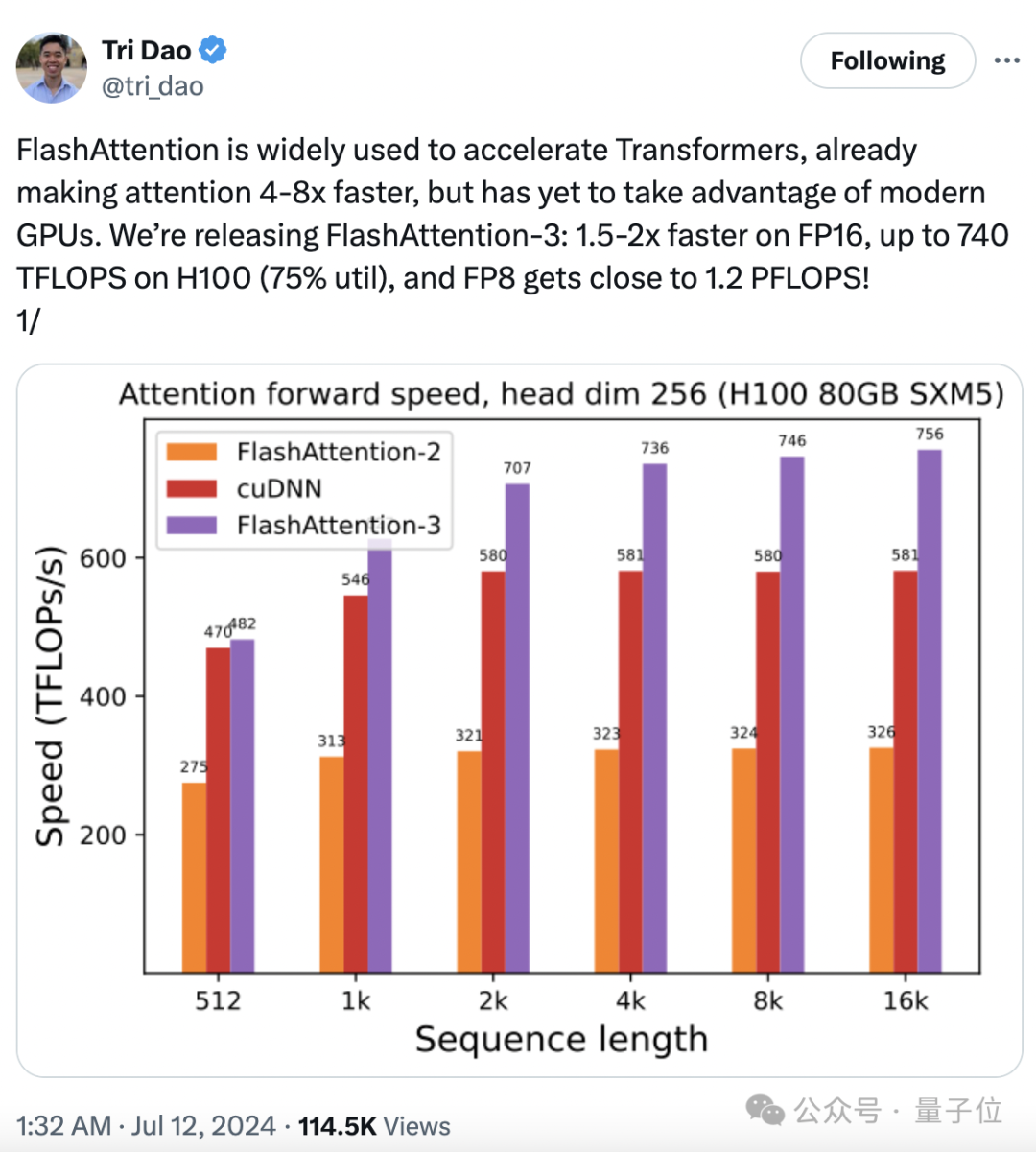

FP8通过其独特的数值表示方式,能够在保持一定精度的同时,在大模型训练中提高训练速度、节省内存占用,最终降低训练成本。

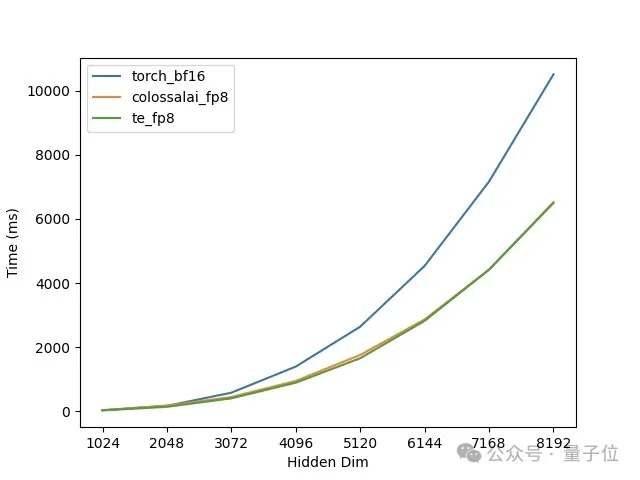

在 AI 领域,有两大场景对 GPU 的需求最大,一个是模型训练,另一个是 AI 推理任务。

越来越多人开始关注大模型,很多做工程开发的同学问我怎么入门大模型训练推理系统软件(俗称大模型Infra)。

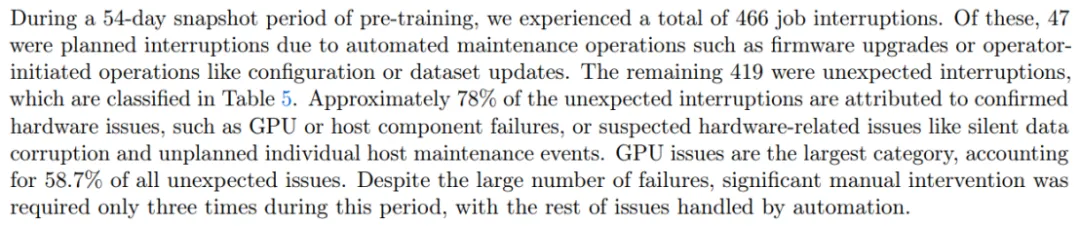

大模型作为当下 AI 工业界和学术界当之无愧的「流量之王」,吸引了大批学者和企业投入资源去研究与训练。随着规模越做越大,系统和工程问题已经成了大模型训练中绕不开的难题。例如在 Llama3.1 54 天的训练里,系统会崩溃 466 次,平均 2.78 小时一次!

HBM因AI大模型训练需求爆增,市场火热。

大模型训练推理神作,又更新了!

Anthropic首席执行官表示,当前AI模型训练成本是10亿美元,未来三年,这个数字可能会上升到100亿美元甚至1000亿美元。要知道,GPT-4o这个曾经最大的模型也只用了1亿美元。千亿美刀,究竟花在了哪里?

「原来以为语料已经匮乏了,大模型训练已经没有语料了,实际上不是的,数据还远远没有跑光」。

Alexandr Wang创办的Scale AI是一个为AI模型提供训练数据的数据标注平台,近期完成新一轮10亿美元融资,估值飙升至138亿美元。该公司表示将利用新资金生产丰富的前沿数据,为通向AGI铺平道路。