独立游戏小团队也能在GDC开讲座?|AI原生游戏《1001夜》在旧金山的1周收获

独立游戏小团队也能在GDC开讲座?|AI原生游戏《1001夜》在旧金山的1周收获一个月前,在旧金山全球游戏开发者大会上,AI原生独立游戏《1001夜》的制作人担任GDC Al Summit的演讲者,分享游戏中大语言模型驱动的核心玩法设计,与世界各地的游戏开发者进行了深入的交流。

一个月前,在旧金山全球游戏开发者大会上,AI原生独立游戏《1001夜》的制作人担任GDC Al Summit的演讲者,分享游戏中大语言模型驱动的核心玩法设计,与世界各地的游戏开发者进行了深入的交流。

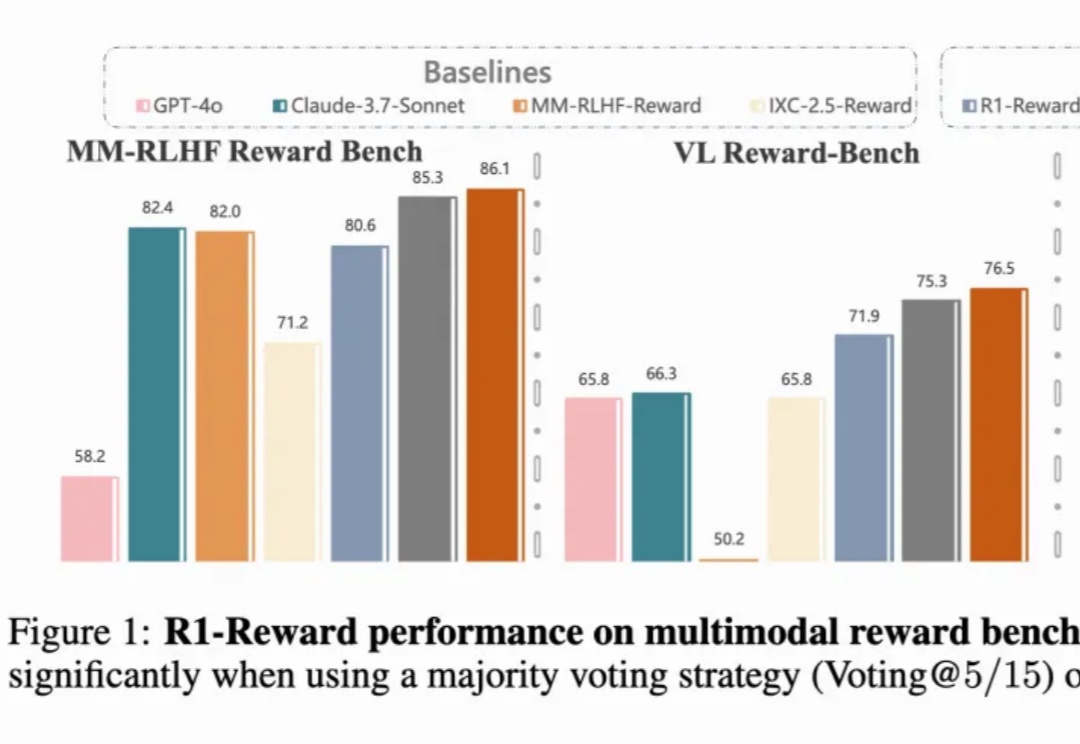

多模态奖励模型(MRMs)在提升多模态大语言模型(MLLMs)的表现中起着至关重要的作用:

随着 Deepseek 等强推理模型的成功,强化学习在大语言模型训练中越来越重要,但在视频生成领域缺少探索。复旦大学等机构将强化学习引入到视频生成领域,经过强化学习优化的视频生成模型,生成效果更加自然流畅,更加合理。并且分别在 VDC(Video Detailed Captioning)[1] 和 VBench [2] 两大国际权威榜单中斩获第一。

大型语言模型(LLMs)在上下文知识理解方面取得了令人瞩目的成功。

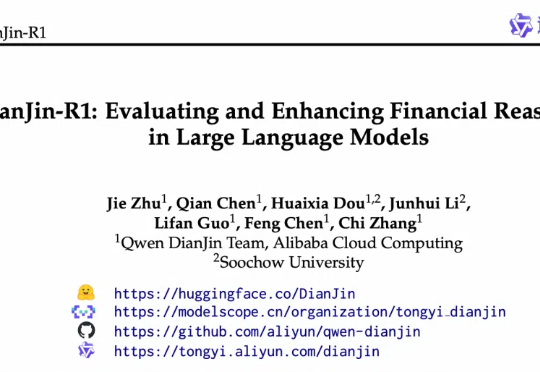

近日,阿里云通义点金团队与苏州大学携手合作,在金融大语言模型领域推出了突破性的创新成果:DianJin-R1。

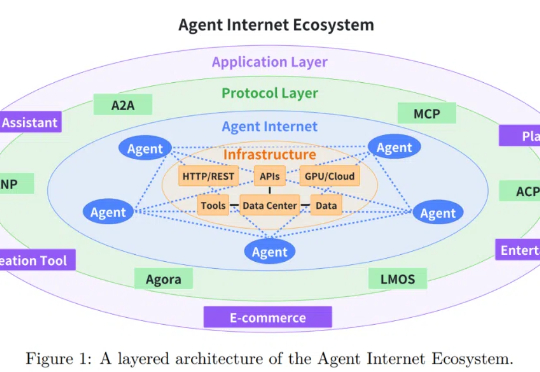

随着大语言模型 (LLM) 技术的迅猛发展,基于 LLM 的智能智能体在客户服务、内容创作、数据分析甚至医疗辅助等多个行业领域得到广泛应用。

在当前大语言模型(LLMs)广泛应用于问答、对话等任务的背景下,如何更有效地结合外部知识、提升模型对复杂问题的理解与解答能力,成为 RAG(Retrieval-Augmented Generation)方向的核心挑战。

自回归模型,首次生成2048×2048分辨率图像!来自Meta、西北大学、新加坡国立大学等机构的研究人员,专门为多模态大语言模型(MLLMs)设计的TokenShuffle,显著减少了计算中的视觉Token数量,提升效率并支持高分辨率图像合成。

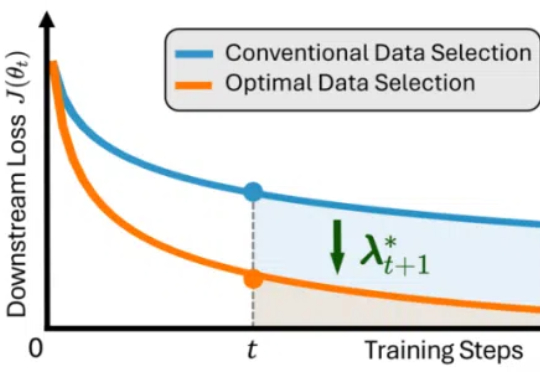

近年来,大语言模型(LLMs)在自然语言理解、代码生成与通用推理等任务上取得了显著进展,逐步成为通用人工智能的核心基石。

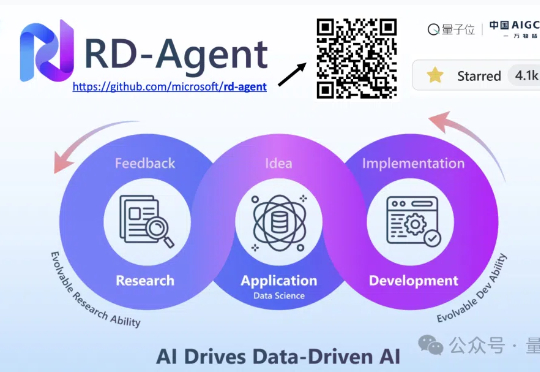

2025,随着大语言模型技术的迅猛发展,数据科学领域正经历一场静默的革命。传统的特征工程、模型训练与迭代优化流程,正被智能化的研发助手所改变。