扩散语言模型推理太慢?北大团队提出ODB-dLLM框架,破解计算访存双重瓶颈

扩散语言模型推理太慢?北大团队提出ODB-dLLM框架,破解计算访存双重瓶颈基于扩散的大语言模型 (dLLM) 凭借全局解码和双向注意力机制解锁了原生的并行解码和受控生成的潜力,最近吸引了广泛的关注。例如 Fast-dLLM 的现有推理框架通过分块半自回归解码进一步实现了 dLLM 对 KV cache 的支持,挑战了传统自回归 LLMs 的统治地位。

基于扩散的大语言模型 (dLLM) 凭借全局解码和双向注意力机制解锁了原生的并行解码和受控生成的潜力,最近吸引了广泛的关注。例如 Fast-dLLM 的现有推理框架通过分块半自回归解码进一步实现了 dLLM 对 KV cache 的支持,挑战了传统自回归 LLMs 的统治地位。

当AI不再仅仅是渲染队列中的一个工具,而是开始以智能体的身份,深度参与到剧本构思、视觉预览乃至最终剪辑的每一个环节,我们正站在一场影像文明变革的临界点。

有关大语言模型的理论基础,可能要出现一些改变了。

在Meta和Instacart历练之后,Fidji Simo这位从法国渔村走出的「硅谷奇才」,以OpenAI应用业务CEO的身份开启了新的冒险。她职业生涯的每一次跃升,都源于押注了那些在他人看来「并不显而易见」的选择。

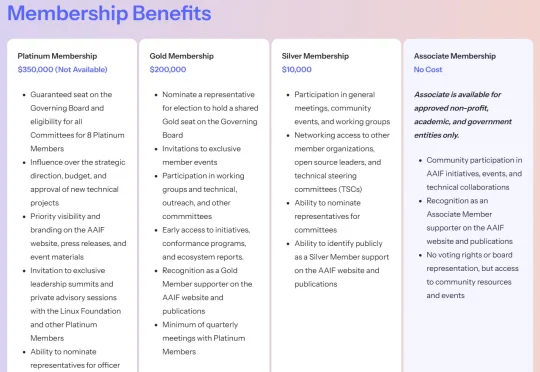

刚刚,Linux 基金会正式宣布推出智能体 AI 基金会(Agentic AI Foundation,简称 AAIF)。据公告披露,AAIF 定位为 AI 智能体(AI agents)相关开源项目的中立托管平台,全球几乎所有科技巨头均已签约成为该基金会成员。Anthropic、OpenAI 与 Block 三家公司作为联合创始成员,将贡献三大开源项目,构成基金会启动初期的支柱。

最近,Prime Intellect正式发布了INTELLECT-3。这是一款拥有106B参数的混合专家(Mixture-of-Experts)模型,基于Prime Intellect的强化学习(RL)技术栈训练。在数学、代码、科学与推理的各类基准测试上,它达成了同规模中最强的成绩,甚至超越了不少更大的前沿模型。

人工智能初创公司Fal 获得红杉资本和英伟达等投资方的新一轮融资,据知情人士透露,公司估值达到 45 亿美元,较数月前增长两倍。该公司表示,本轮由红杉资本领投的融资规模达1.4亿美元,标志着其年内第三次募资。如此快速的融资节奏反映出投资者对人工智能工具在开发者和企业端日益增长的应用需求充满信心。

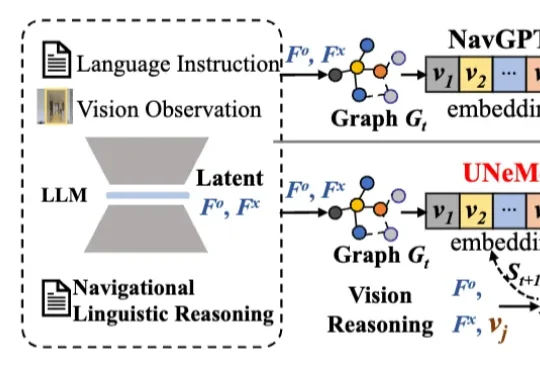

深圳大学李坚强教授团队最近联合北京理工莫斯科大学等机构,提出视觉-语言导航(VLN)新框架——UNeMo。让机器人听懂指令,精准导航再升级!

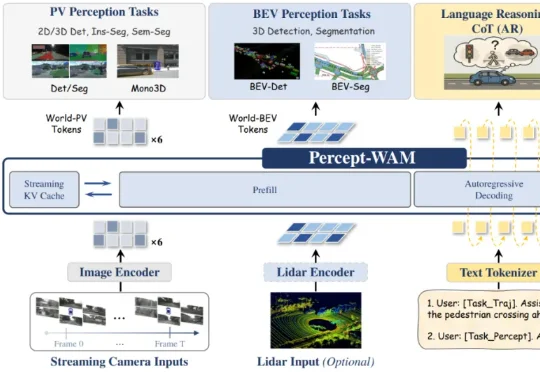

近日,来自引望智能与复旦大学的研究团队联合提出了一个面向自动驾驶的新一代大模型 ——Percept-WAM(Perception-Enhanced World–Awareness–Action Model)。该模型旨在在一个统一的大模型中,将「看见世界(Perception)」「理解世界(World–Awareness)」和「驱动车辆行动(Action)」真正打通,形成一条从感知到决策的完整链路。

Plan Coach 创始人苏晓江的故事,是一人公司最真切的写照。他曾是大厂的技术主管,但也会因「不想刷碗」而开始拖延。当 AI 将他的拖延症状拆解成「你只要站起来就算赢」时,他通过这个微小的洞察,用一天时间做成了一个抗拖延 APP 的原型。当他将这个不完美的「雏形」扔进社区,回应是山呼海啸般的热情,在贴文下,他获得了 26 万赞,和 1000 多条用户真实反馈。用户成为了他产品的「精神股东」。