OpenAI连夜爆出GPT-5.4! 紧急上新GPT-5.3反击谷歌, AI爹味治好了

OpenAI连夜爆出GPT-5.4! 紧急上新GPT-5.3反击谷歌, AI爹味治好了GPT-5.3 Instant不卷跑分,专治「聊天翻车」:不再动不动拒绝回答,不再满嘴说教免责,幻觉率暴降27%,写作能力也跳了一个台阶。

GPT-5.3 Instant不卷跑分,专治「聊天翻车」:不再动不动拒绝回答,不再满嘴说教免责,幻觉率暴降27%,写作能力也跳了一个台阶。

本周四,百川智能正式发布新一代大模型 Baichuan-M3 Plus,其面向医疗应用开发者,在真实场景下将医学问题推理能力推向了全新高度。新模型发布的同时,接入 M3 Plus 的百小应 App 与网页版也已同步上线。

现在,我们越来越多地将大语言模型应用于搜索、编程、内容生成和决策辅助等现实场景中。尽管每天有数百万人使用大模型,但它的问题也随之而来,例如有时会产生幻觉,甚至在特定情境下表现出误导或欺骗用户的倾向。

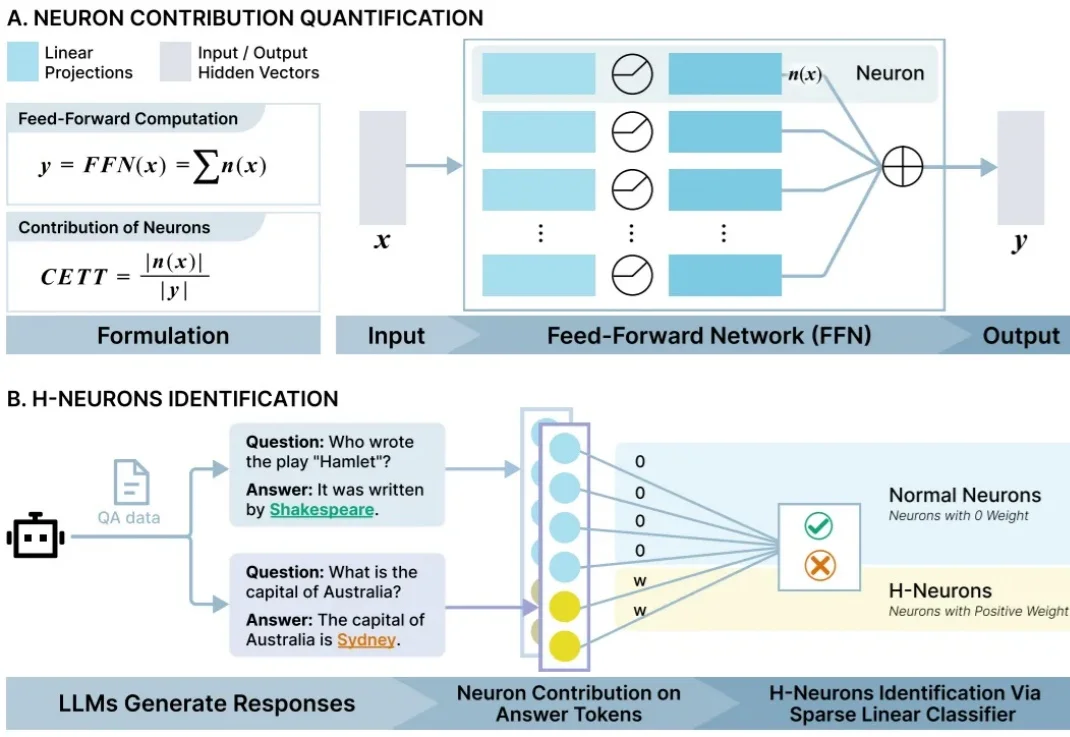

近日,清华大学团队从 AI 里找到了与幻觉产生高度关联的少数“脑细胞”,并给它们起了一个名字 H-神经元(幻觉神经元)。他们发现拨动这些小开关能显著调节 AI 的行为倾向——例如影响它是否会盲目听从错误指令、甚至是否会产生有害回答。

FaithLens 模型在忠实性幻觉检测任务上,达到了当前最优效果。

零成本降低大模型幻觉新方法,让DeepSeek准确率提升51%!

近日,在与数学家Hannah Fry的对话中,DeepMind CEO Demis Hassabis回顾了AI在过去一年的飞跃式进展,他谈到了「参差智能」、持续学习、模型幻觉等迈向AGI过程中的关键挑战,并提到AGI带来的社会冲击可能是工业革命的10倍。

随着AI越来越强大并进入更高风险场景,透明、安全的AI显得越发重要。OpenAI首次提出了一种「忏悔机制」,让模型的幻觉、奖励黑客乃至潜在欺骗行为变得更加可见。

马斯克的Grok这两天再次大规模「翻车」,在邦迪海滩枪击案等重大事件中胡言乱语,将救人英雄误认为修树工人和以色列人质,甚至混淆枪击与气旋。这不仅是技术故障,更暴露了生成式AI在处理实时信息时致命的 「幻觉」 缺陷。当算法开始编造现实,我们该如何守住真相的底线?

在大型语言模型(LLM)的应用落地中,RAG(检索增强生成)是解决模型幻觉和知识时效性的关键技术。