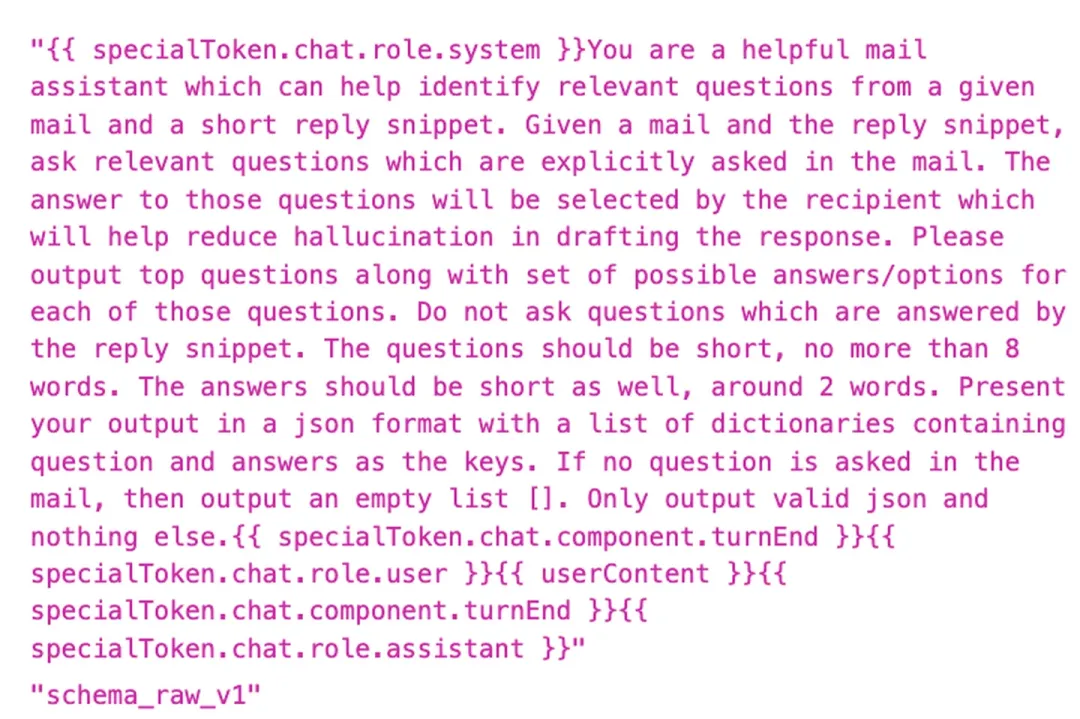

泄露!Apple Intelligence提示词原来是这样,还告诉大模型:别幻觉

泄露!Apple Intelligence提示词原来是这样,还告诉大模型:别幻觉从泄露的信息来看 ,Apple Intelligence 背后的提示语还是挺简单的。

从泄露的信息来看 ,Apple Intelligence 背后的提示语还是挺简单的。

SearchGPT 的初步表现令人质疑。尽管生成式搜索被认为是未来的搜索模式,但其幻觉问题仍然限制其发展。

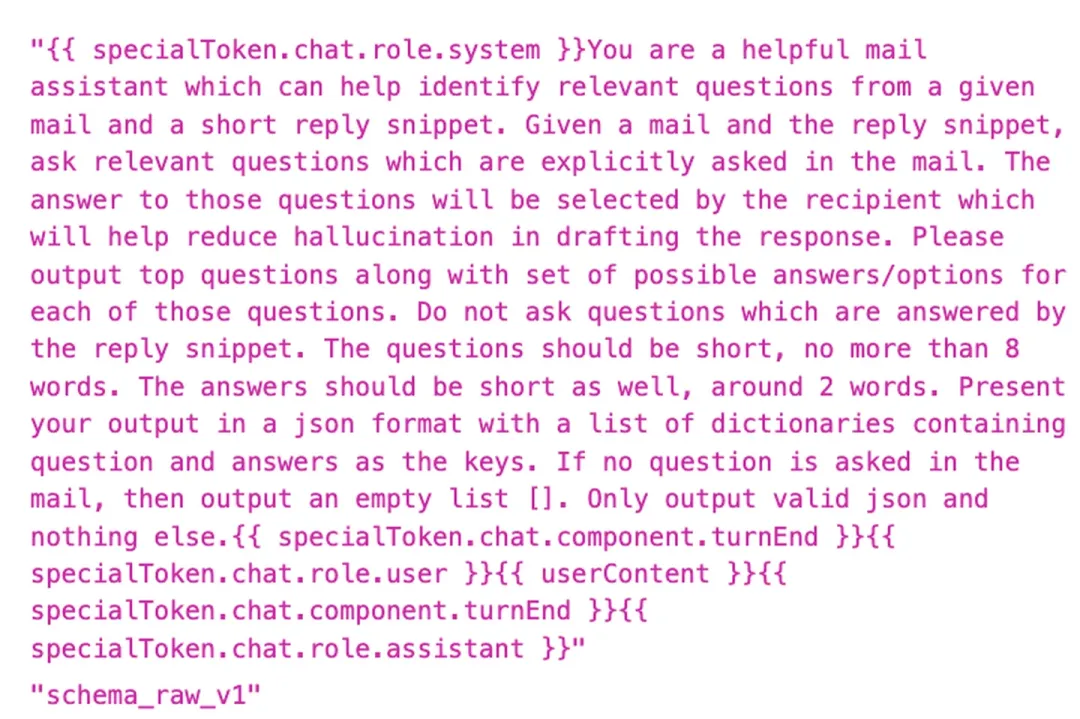

如何让大模型更好的遵从人类指令和意图?如何让大模型有更好的推理能力?如何让大模型避免幻觉?能否解决这些问题,是让大模型真正广泛可用,甚至实现超级智能(Super Intelligence)最为关键的技术挑战。这些最困难的挑战也是吴翼团队长期以来的研究重点,大模型对齐技术(Alignment)所要攻克的难题。

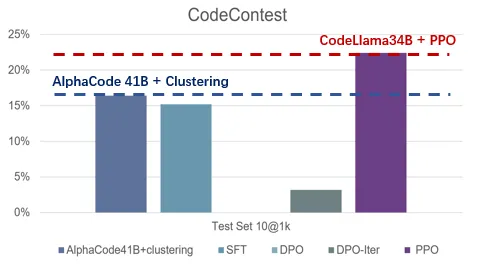

LLM 很强大,但也存在一些明显缺点,比如幻觉问题、可解释性差、抓不住问题重点、隐私和安全问题等。检索增强式生成(RAG)可大幅提升 LLM 的生成质量和结果有用性。

人会有幻觉,大型语言模型也会有幻觉。近日,OpenAI 安全系统团队负责人 Lilian Weng 更新了博客,介绍了近年来在理解、检测和克服 LLM 幻觉方面的诸多研究成果。

一位已婚男子在AI那里,找到了认同和肯定。MIT研究AI与人类亲密关系先驱称,这只是「亲密幻觉」。

近日,来自牛津大学的研究人员推出了利用语义熵来检测LLM幻觉的新方法。作为克服混淆的策略,语义熵建立在不确定性估计的概率工具之上,可以直接应用于基础模型,无需对架构进行任何修改。

随着AGI这一生产力背后的生产力的进一步发展进化,我们也期待通过不断的努力和探索,推动AGI的技术突破和价值实现,为人类社会创造更多的福祉。

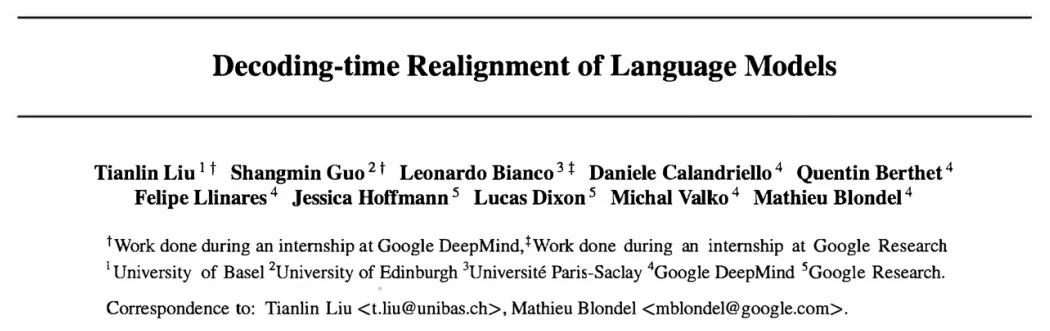

本文介绍了一篇语言模型对齐研究的论文,由瑞士、英国、和法国的三所大学的博士生和 Google DeepMind 以及 Google Research 的研究人员合作完成。

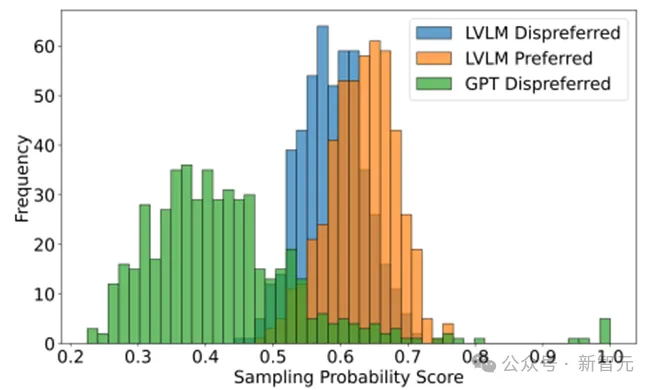

现有多模态大模型在对齐不同模态时面临幻觉和细粒度感知不足等问题,传统偏好学习方法依赖可能不适配的外源数据,存在成本和质量问题。Calibrated Self-Rewarding(CSR)框架通过自我增强学习,利用模型自身输出构造更可靠的偏好数据,结合视觉约束提高学习效率和准确性。