SPIRAL:零和游戏自对弈成为语言模型推理训练的「免费午餐」

SPIRAL:零和游戏自对弈成为语言模型推理训练的「免费午餐」近年来,OpenAI o1 和 DeepSeek-R1 等模型的成功证明了强化学习能够显著提升语言模型的推理能力。通过基于结果的奖励机制,强化学习使模型能够发展出可泛化的推理策略,在复杂问题上取得了监督微调难以企及的进展。

来自主题: AI技术研报

4232 点击 2025-07-31 10:10

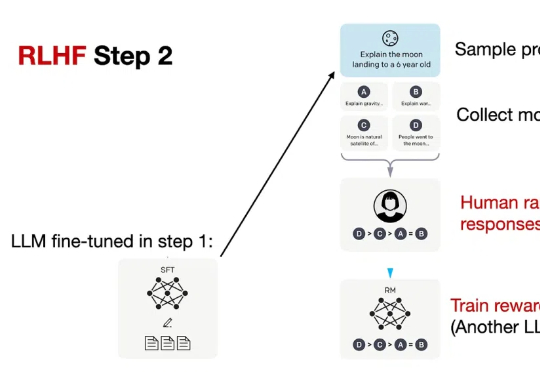

近年来,OpenAI o1 和 DeepSeek-R1 等模型的成功证明了强化学习能够显著提升语言模型的推理能力。通过基于结果的奖励机制,强化学习使模型能够发展出可泛化的推理策略,在复杂问题上取得了监督微调难以企及的进展。

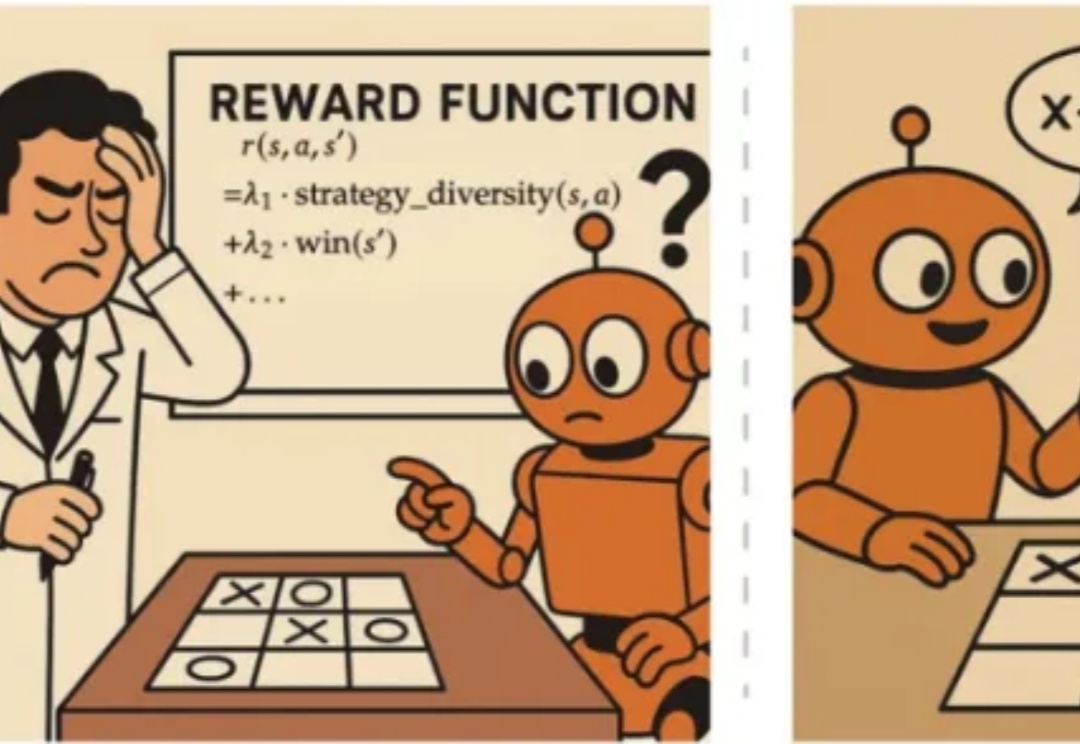

一年之内,大模型推理训练可能就会撞墙。

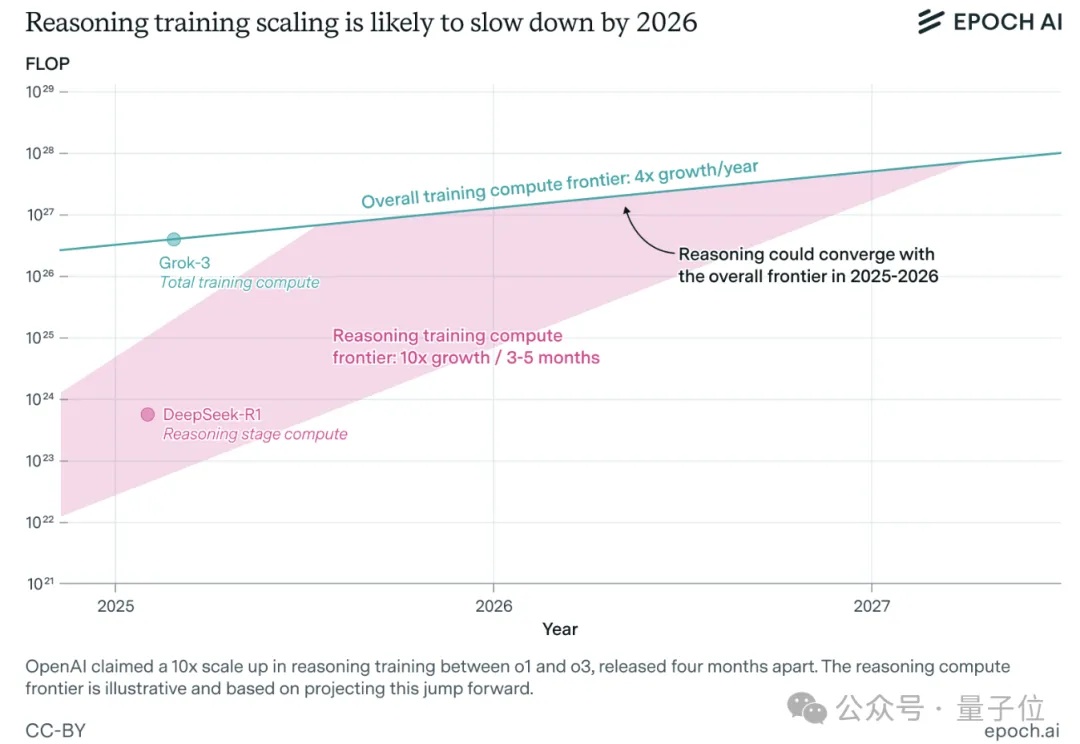

本文提出 LUFFY 强化学习方法,一种结合离线专家示范与在线强化学习的推理训练范式,打破了“模仿学习只学不练、强化学习只练不学”的传统壁垒。LUFFY 通过将高质量专家示范制定为一种离策略指引,并引入混合策略优化与策略塑形机制,稳定地实现了在保持探索能力的同时高效吸收强者经验。

只靠模型尺寸变大已经不行了?大语言模型(LLM)推理需要强化学习(RL)来「加 buff」。

JAX在最近的基准测试中的性能已经不声不响地超过了Pytorch和TensorFlow,也许未来会有更多的大模型诞生在这个平台上。谷歌在背后的默默付出终于得到了回报。

脱胎自 RISC-V,能把推理训练能效提高 1 万倍。OpenAI 的权力之争才刚刚落幕,一场关键交易悄悄浮出了水面。