盖茨女儿再获3500万美元融资:十个月用户突破100万,估值飙至1.85亿,AI购物agent凭什么让硅谷顶级VC抢着投?

盖茨女儿再获3500万美元融资:十个月用户突破100万,估值飙至1.85亿,AI购物agent凭什么让硅谷顶级VC抢着投?Phoebe Gates是比尔·盖茨的女儿,Sophia Kianni是联合国最年轻的顾问之一,她们在斯坦福大学的宿舍里开始了这场购物革命。那时候,我就感受到她们身上有种不同寻常的执行力和对用户需求的深刻理解。

Phoebe Gates是比尔·盖茨的女儿,Sophia Kianni是联合国最年轻的顾问之一,她们在斯坦福大学的宿舍里开始了这场购物革命。那时候,我就感受到她们身上有种不同寻常的执行力和对用户需求的深刻理解。

为什么在LLM推理能力大幅跃升的2026,我们依然只有AI Copilot而没有AI Teammate?尽管AI编程工具遍地开花,但不管是Claude Code还是Codex,本质上仍是“单Agent开发”或“主从控制”架构。而“AI结对编程”迟迟无法落地?

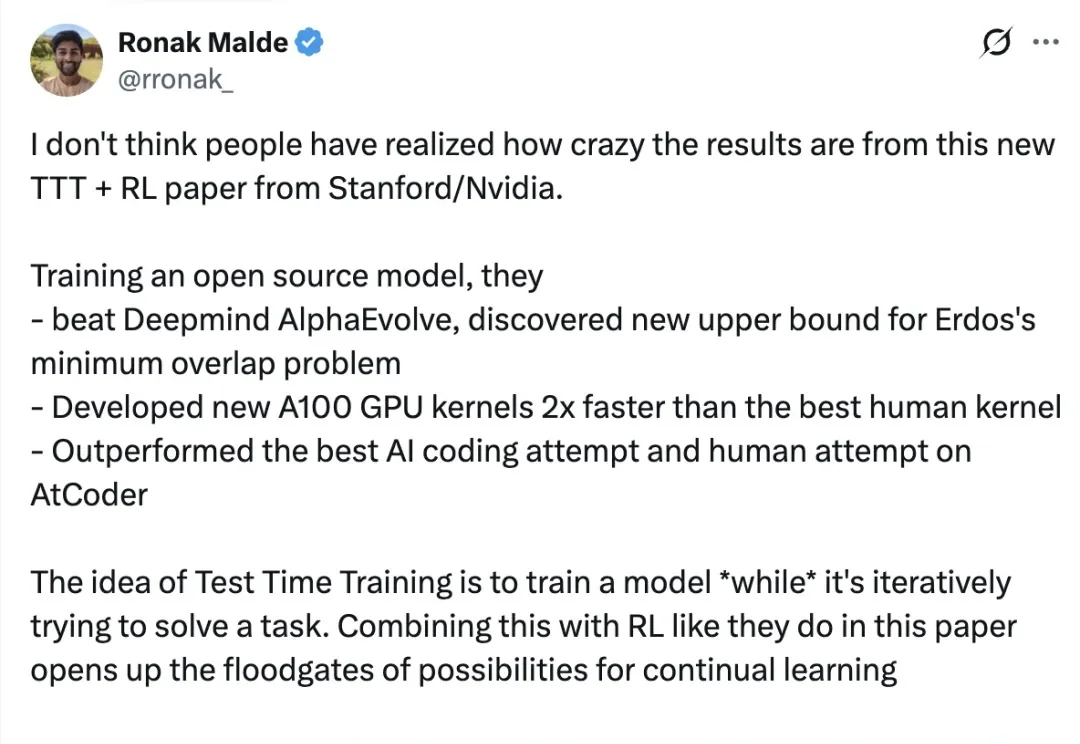

在技术如火如荼发展的当下,业界常常在思考一个问题:如何利用 AI 发现科学问题的新最优解?

大模型持续学习,又有新进展!

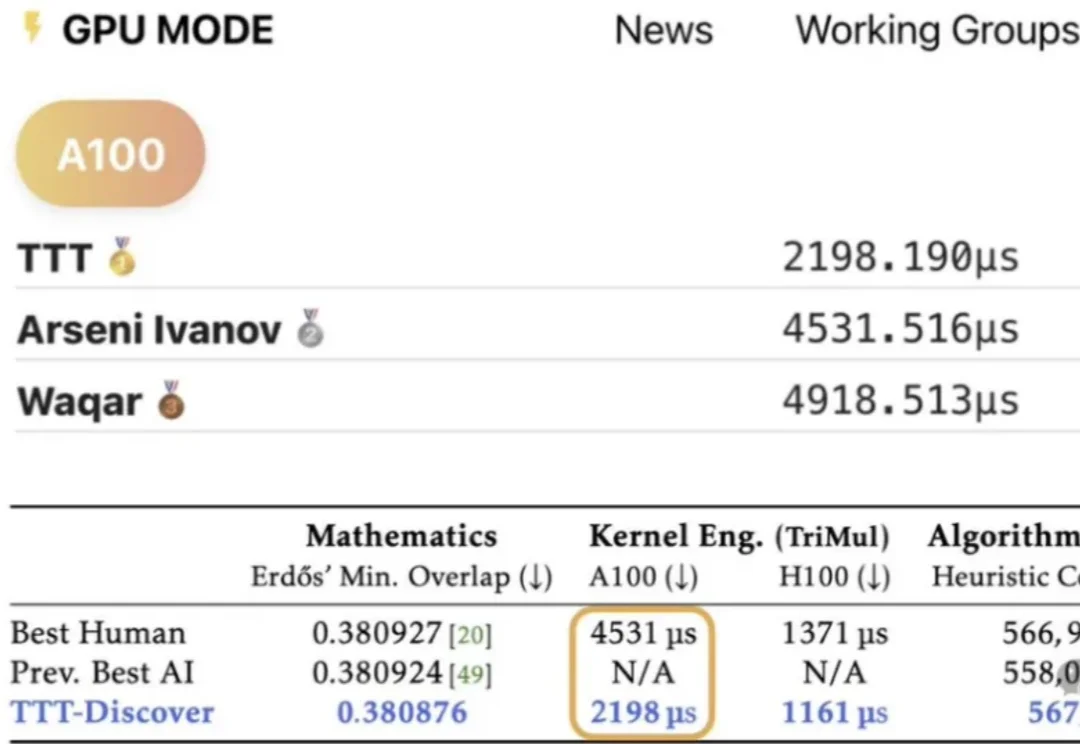

斯坦福与英伟达联合发布重磅论文 TTT-Discover,打破「模型训练完即定型」的铁律。它让 AI 在推理阶段针对特定难题「现场长脑子」,不惜花费数百美元算力,只为求得一次打破纪录的极值。从重写数学猜想到碾压人类代码速度,这种「激进进化」正在重新定义机器发现的边界。

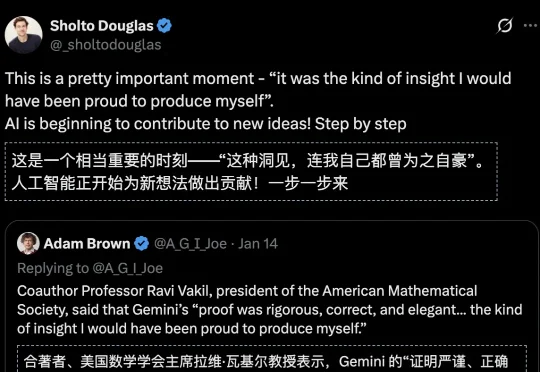

数学奇点初现!Gemini攻克全新数学定理,斯坦福大牛惊呼「想出来能吹一辈子」;陶哲轩预言数学家+AI共生未来;Grok发现黎曼猜想新的隐蔽通道……

《Nature Medicine》 的研究报道“A multimodal sleep foundation model for disease prediction”,研究人员开发了一种名为 SleepFM 的基础模型,从超过58万小时的记录中“学会”了睡眠的语言。这不仅是睡眠科学的进步,更是AI在生物医学领域的深层突围。

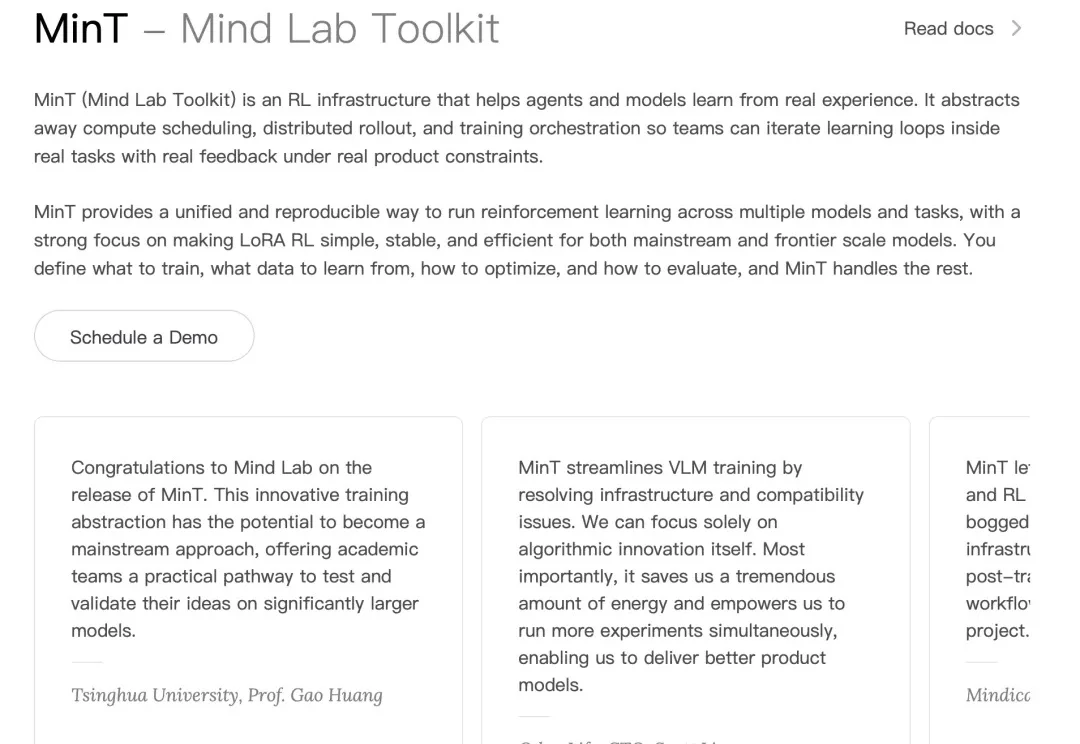

在大公司一路高歌猛进的 AI 浪潮里,小创业者和高校研究者正变得越来越迷茫。就连前段时间谷歌创始人谢尔盖・布林回斯坦福,都要回答「大学该何去何从」「从学术到产业的传统路径是否依然重要」这类问题。

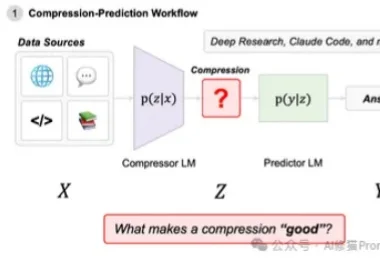

在近一年里,Agentic System(代理系统/智能体系统)正变得无处不在。从Open AI的Deep Research到Claude Code,我们看到越来越多的系统不再依赖单一模型,而是通过多模型协作来完成复杂的长窗口任务。

在这精彩绝伦的一年的结尾,我们的老朋友:斯坦福大学计算机科学客座教授,前百度 AI 负责人,前谷歌大脑负责人吴恩达老师,发表了今年的保留节目:一封信,和一篇 2025 的人工智能领域年度总结。