不卡顿、免费的满血版DeepSeek-R1 API,在无问芯穹这里用上了,更有异构算力鼎力相助

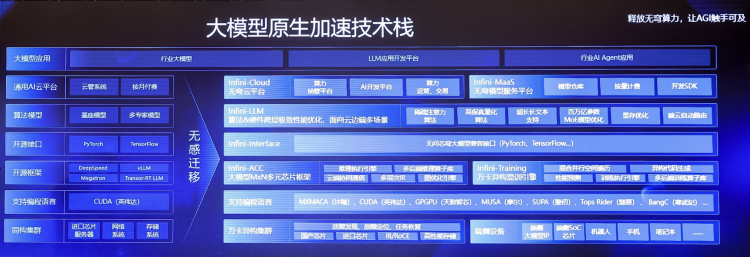

不卡顿、免费的满血版DeepSeek-R1 API,在无问芯穹这里用上了,更有异构算力鼎力相助还在为 DeepSeek R1 官网的卡顿抓狂?无问芯穹大模型服务平台现已上线满血版 DeepSeek-R1、V3,无需邀请即可免费用 Token!另有异构算力鼎力相助,支持通过 Infini-AI 异构云平台一键获取 DeepSeek 系列模型与多元异构自主算力服务。

还在为 DeepSeek R1 官网的卡顿抓狂?无问芯穹大模型服务平台现已上线满血版 DeepSeek-R1、V3,无需邀请即可免费用 Token!另有异构算力鼎力相助,支持通过 Infini-AI 异构云平台一键获取 DeepSeek 系列模型与多元异构自主算力服务。

由无问芯穹与上海交通大学联合研究团队提出的视频生成软硬一体加速器,首次实现通过差分近似和自适应数据流解决 VDiT 生成速度缓慢瓶颈,推理速度相比 A100 提升高达 16.44 倍。

大家可能看到过很多类似的结论:针对特定任务,对开源模型进行 LoRA 微调可以干翻 GPT-4 这类闭源模型。

全球首个端侧全模态理解开源模型来了!

随着大语言模型在长文本场景下的需求不断涌现,其核心的注意力机制(Attention Mechanism)也获得了非常多的关注。

智能涌现获悉,「无问芯穹」宣布完成近5亿元A轮融资。这也是目前为止,国内AI Infra(大模型基础设施)层创业公司最大的单笔融资记录。

投资界获悉,今日(9月2日),无问芯穹正式宣布完成近5亿元融资。至此,成立仅16个月,无问芯穹已累计完成近10亿元融资。

2018年夏天,夏立雪提交了他在清华大学电子工程系的博士论文。时间往前推5年,他的导师汪玉刚刚成为副教授,有了带博士的资格,于是夏立雪成为了汪玉的第一位博士生,进入了NICS-EFC实验室,这个实验室专注于做一件事:

「无问芯穹」Infini-AI云平台已集成大模型异构千卡混训能力,是全球首个可进行单任务千卡规模异构芯片混合训练的平台。

基于 Transformer架构的大型语言模型在各种基准测试中展现出优异性能,但数百亿、千亿乃至万亿量级的参数规模会带来高昂的服务成本。例如GPT-3有1750亿参数,采用FP16存储,模型大小约为350GB,而即使是英伟达最新的B200 GPU 内存也只有192GB ,更不用说其他GPU和边缘设备。