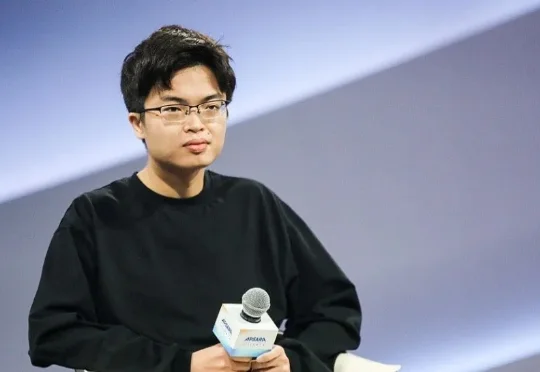

杨植麟暂时挺过风暴

杨植麟暂时挺过风暴独家获悉,月之暗面(以下简称“月暗”)已对内部组织架构进行调整。曾经以 C 端产品 Kimi 为主的团队中,负责 API 服务对接的员工一度只有个位数,而如今,随着调用需求激增,该 API 团队正在快速扩编,并以独立业务分支的形式存在,直接向总裁张予彤汇报。

独家获悉,月之暗面(以下简称“月暗”)已对内部组织架构进行调整。曾经以 C 端产品 Kimi 为主的团队中,负责 API 服务对接的员工一度只有个位数,而如今,随着调用需求激增,该 API 团队正在快速扩编,并以独立业务分支的形式存在,直接向总裁张予彤汇报。

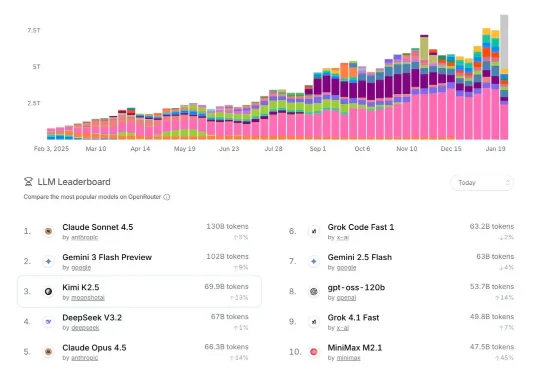

今天,美国大模型独角兽Anthropic连续发布多则推文、博客,指控DeepSeek、月之暗面和MiniMax三家中国AI实验室,正对Claude进行“工业级规模的蒸馏攻击”。

此前彭博社等媒体报道称,近期月之暗面即将完成的超7亿美元融资,由阿里、腾讯、五源资本、九安医疗等老股东领投,并且已经超募。与此同时,月之暗面已经以100亿-120亿美金的估值,无缝开启了新一轮融资。

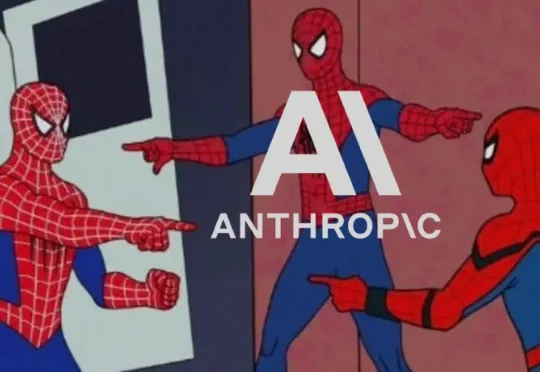

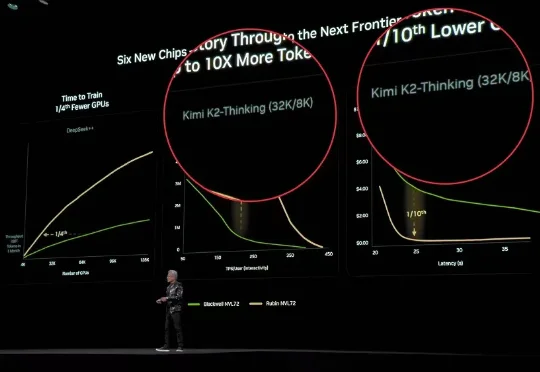

谁是老黄2026年的新座上宾?

《智能涌现》获悉,近期Kimi在和投资人的沟通中表示,公司的海外收入已超过国内收入,新模型K2.5发布后,全球付费用户已有4倍增长。这一变化恰好发生在新一代模型K2.5发布后的短短几天内。

今天凌晨,月之暗面核心团队在社交媒体平台Reddit上举行了一场有问必答(AMA)活动。三位联合创始人杨植麟(CEO)、周昕宇(算法团队负责人)和吴育昕与全球网友从0点聊到3点,把许多关键问题都给聊透了,比如Kimi K2.5是否蒸馏自Claude、Kimi K3将带来的提升与改变,以及如何在快速迭代与长期基础研究之间取得平衡。

就在刚刚,月之暗面正式发布并开源了 Kimi k2.5。

今年的达沃斯,没有一个论坛不讲AI的。

今天,据外媒CNBC报道,两位知情人士透露,北京大模型独角兽月之暗面正在进行新一轮融资,这轮融资对其估值为48亿美元(约合人民币334.13亿元),而仅在20天前公布的C轮融资中其估值还是43亿美元(约合人民币299.32亿元)。

1月10日,很久没有公开露面的月之暗面创始人杨植麟,在一场定向邀请的行业论坛中,详细地分享了2025年Kimi的技术路线重点,以及对未来的思考。这次分享,有一个核心关键词,Agentic智能时代。这是通用大模型竞争的一个未来高地