首个多模态连续学习综述,港中文、清华、UIC联合发布

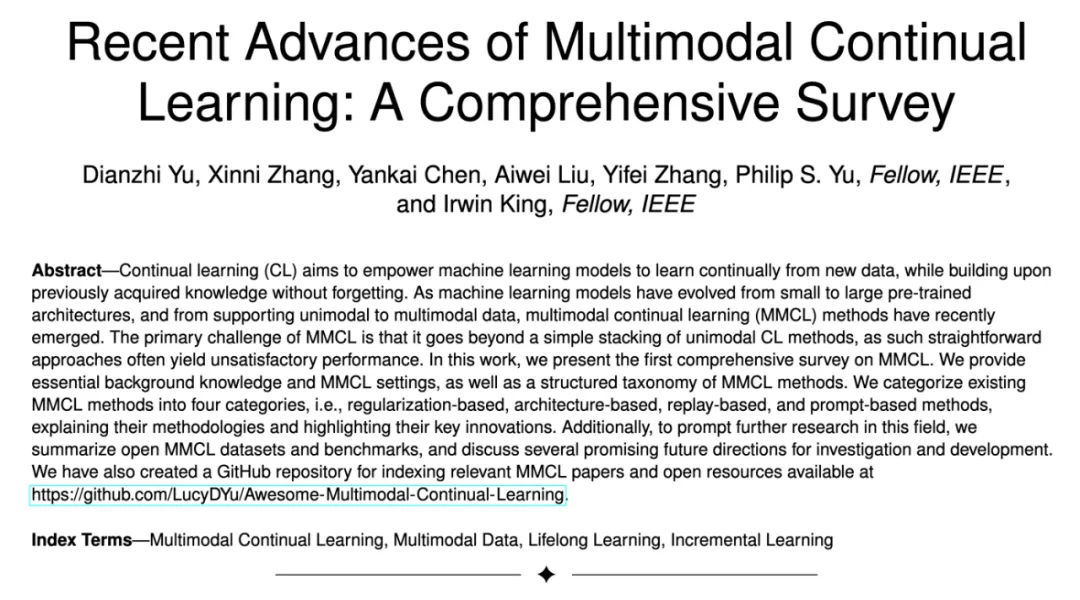

首个多模态连续学习综述,港中文、清华、UIC联合发布连续学习(CL)旨在增强机器学习模型的能力,使其能够不断从新数据中学习,而无需进行所有旧数据的重新训练。连续学习的主要挑战是灾难性遗忘:当任务按顺序训练时,新的任务训练会严重干扰之前学习的任务的性能,因为不受约束的微调会使参数远离旧任务的最优状态。

连续学习(CL)旨在增强机器学习模型的能力,使其能够不断从新数据中学习,而无需进行所有旧数据的重新训练。连续学习的主要挑战是灾难性遗忘:当任务按顺序训练时,新的任务训练会严重干扰之前学习的任务的性能,因为不受约束的微调会使参数远离旧任务的最优状态。

AIxiv专栏是机器之心发布学术、技术内容的栏目。过去数年,机器之心AIxiv专栏接收报道了2000多篇内容,覆盖全球各大高校与企业的顶级实验室,有效促进了学术交流与传播。如果您有优秀的工作想要分享,欢迎投稿或者联系报道。投稿邮箱:liyazhou@jiqizhixin.com;zhaoyunfeng@jiqizhixin.com

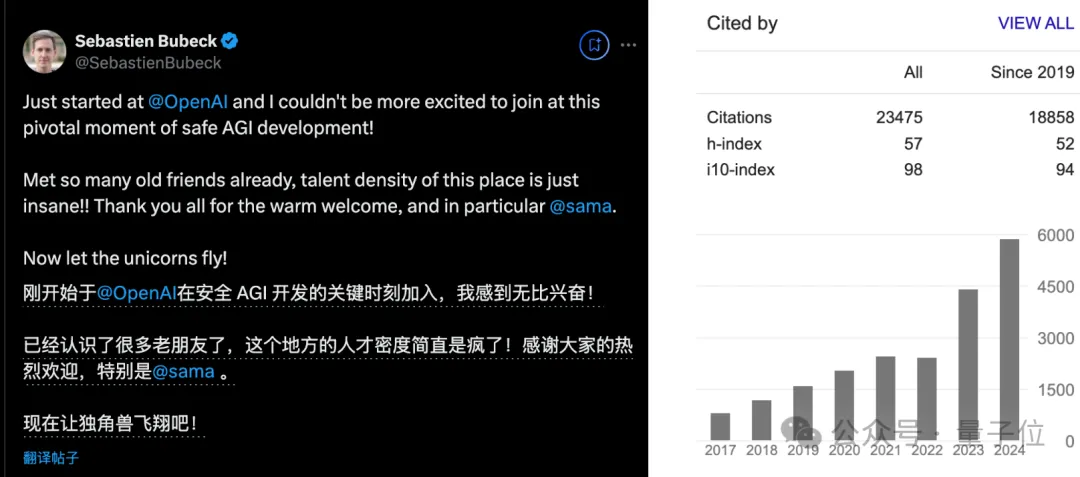

传闻证实,微软机器学习理论万引大佬,官宣跳槽加入OpenAI。

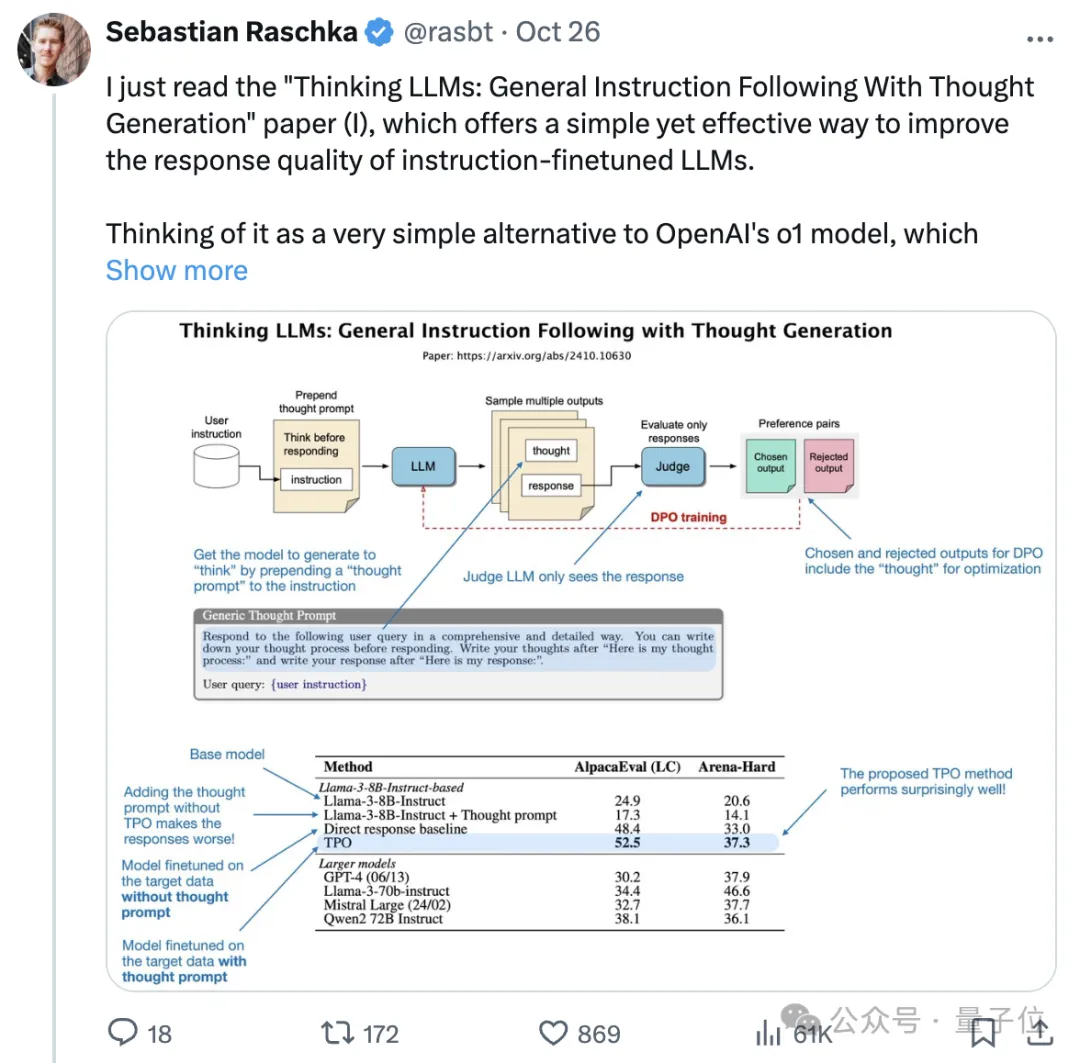

OpenAI-o1替代品来了,大模型能根据任务复杂度进行不同时间的思考。 不限于推理性的逻辑或数学任务,一般问答也能思考的那种。 最近畅销书《Python机器学习》作者Sebastian Raschka推荐了一项新研究,被网友们齐刷刷码住了。

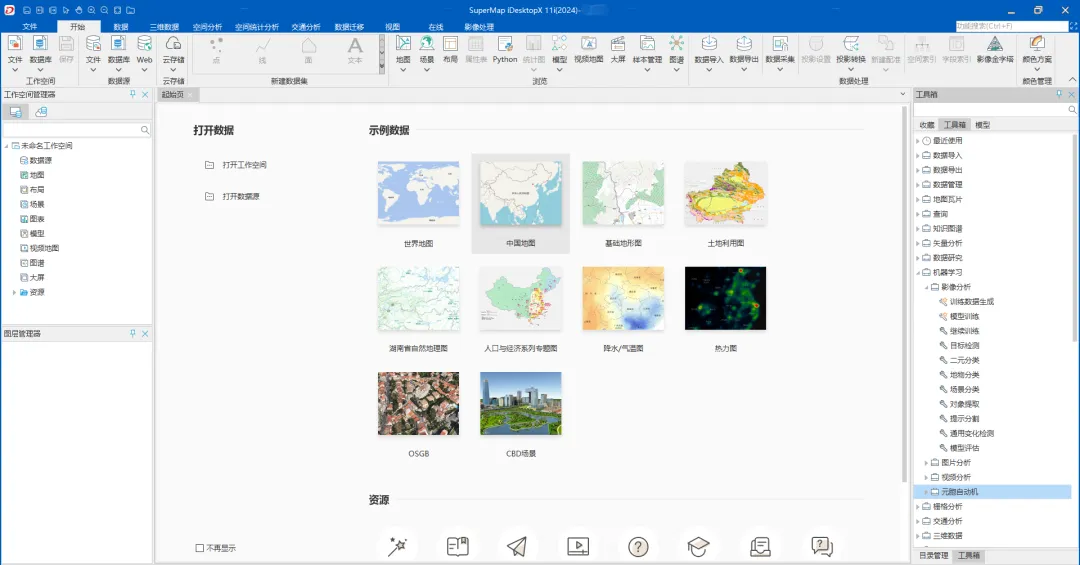

依稀记得十年前,我在上遥感概论专业课时,老师带我们用ERDAS IMAGINE遥感图像处理软件做地物分类,每个人电脑上先发一段区域的遥感影像,进行人工判读和标注,比如把这个区域影像上的林地标注出来喂给模型,再用这个模型去识别另外一个区域影像中的林地,机器学习中典型的的有监督学习应用。

机器学习大神Jeff Dean亲自为你解答,做一名计算机科学家,是一种怎样的体验。

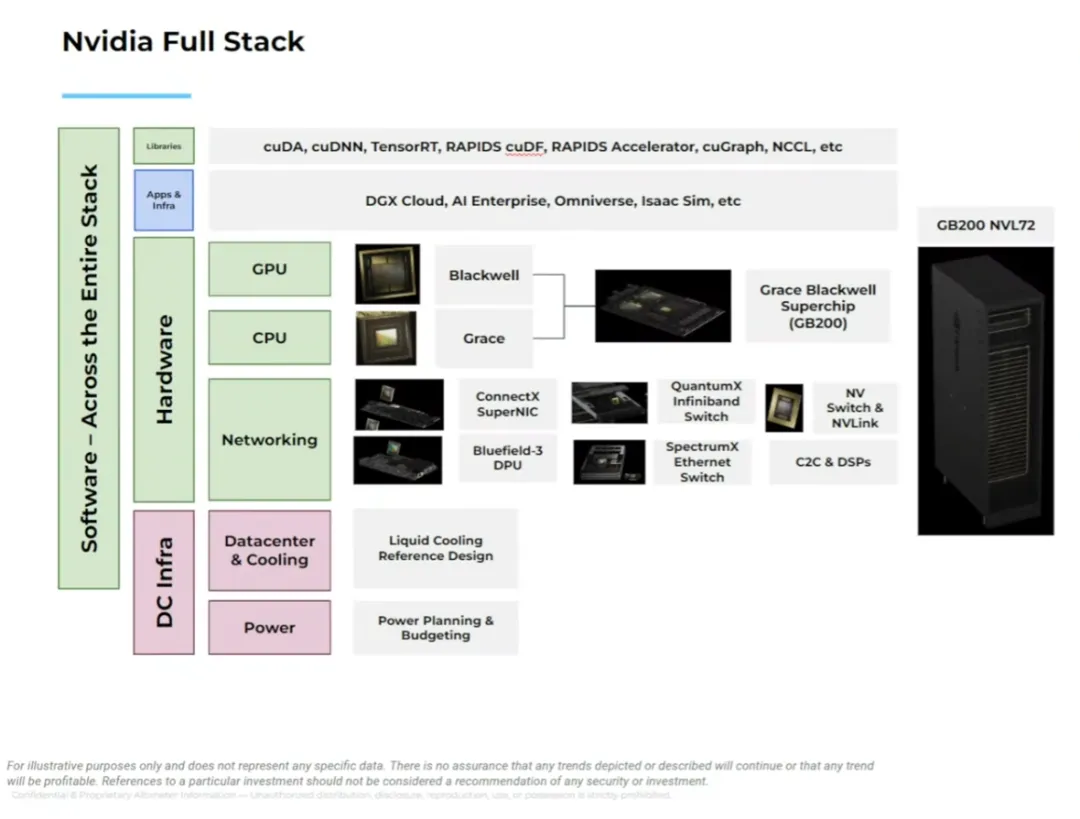

10 月 4 日,播客节目 BG2(Brad Gerstner 和 Clark Tang)邀请到了英伟达 CEO 黄仁勋,他们一起讨论了 AGI、机器学习加速、英伟达的竞争优势、推理与训练的重要性、AI 领域未来的市场动态、AI 对各个行业的影响、工作的未来、AI 提高生产力的潜力、开源与闭源之间的平衡、马斯克的 Memphis 超级集群、X.ai、OpenAI、AI 的安全开发等。

前不久在人工智能的帮助下,两位科学家获得了诺贝尔物理学奖。可以说人工智能已经在很多领域被广泛应用了。随着大语言模型(LLM)和深度学习的广泛应用,GPU 也已成为机器学习工程师和研究人员最重要的计算资源之一。

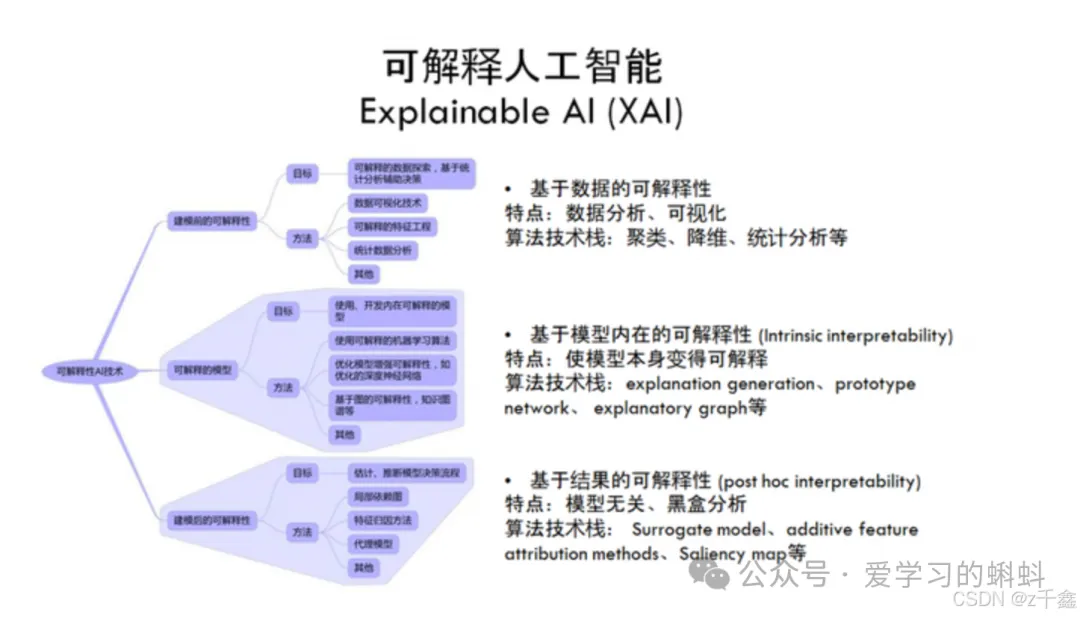

在当今人工智能(AI)和机器学习(ML)技术迅猛发展的背景下,解释性AI(Explainable AI, XAI)已成为一个备受关注的话题。

虽然数据有限,但AI性能不会停滞不前,我们当前的算法还没有从我们拥有的数据中最大限度地提取信息,还有更多的推论、推断和其他过程我们可以应用到我们当前的数据上,以提供更多的价值。