破解AI对不同上下⽂位置的敏感度不⼀致,新框架使出“解铃还须系铃人”

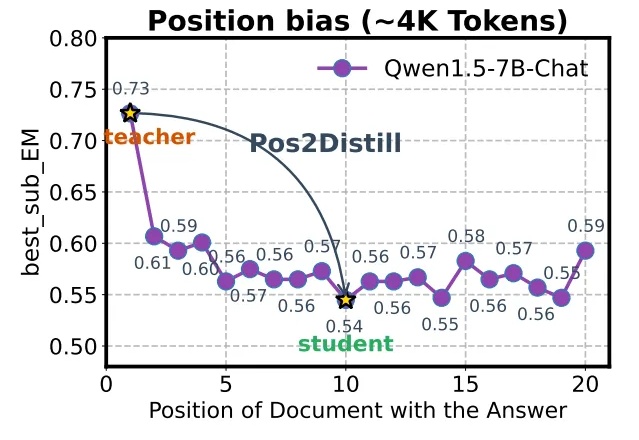

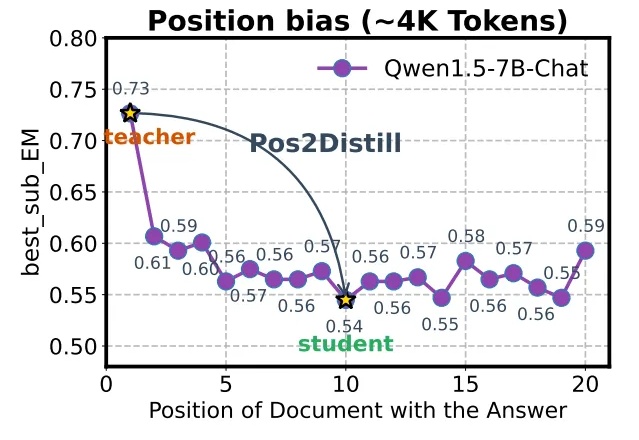

破解AI对不同上下⽂位置的敏感度不⼀致,新框架使出“解铃还须系铃人”语言模型遭遇严重的位置偏见,即模型对不同上下⽂位置的敏感度不⼀致。模型倾向于过度关注输⼊序列中的特定位置,严重制约了它们在复杂推理、⻓⽂本理解以及模型评估等关键任务上的表现。

语言模型遭遇严重的位置偏见,即模型对不同上下⽂位置的敏感度不⼀致。模型倾向于过度关注输⼊序列中的特定位置,严重制约了它们在复杂推理、⻓⽂本理解以及模型评估等关键任务上的表现。

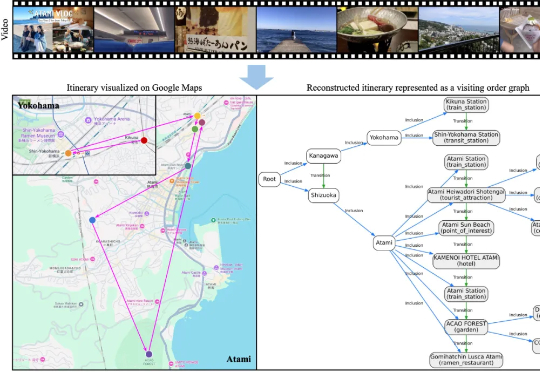

大家或许都有过这样的体验: 看完一部喜欢的动漫,总会心血来潮地想去 “圣地巡礼”;刷到别人剪辑精美的旅行 vlog,也会忍不住收藏起来,想着哪天亲自走一遍同样的路线。旅行与影像的结合,总是能勾起人们的

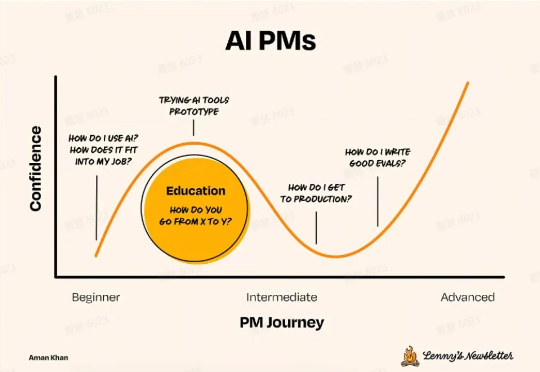

AI 下半场,模型评估比模型训练更重要。我们需要从根本上重新思考评估的方式。

总部位于首尔的 Datumo 最初是一家 AI 数据标注公司,如今致力于通过提供工具和数据来帮助企业构建更安全的 AI 系统。

Toloka是一家专注于AI数据标注与模型评估的众包平台,成立于2014年,创始人Olga Megorskaya曾是俄罗斯科技巨头Yandex董事会成员。公司总部位于阿姆斯特丹,之前由AI基础设施公司Nebius Group控股。

科技媒体 maginative 今天(4 月 16 日)发布博文,报道称 OpenAI 宣布收购 Context.ai团队,后者是一家由 GV 支持的初创公司,以评估和分析 AI 模型见长。Context.ai的联合创始人 Henry Scott-Green(首席执行官)和 Alex Gamble(首席技术官)将加入 OpenAI,专注于研发模型评估工具。

能够深入大模型内部的新评测指标来了! 上交大MIFA实验室提出了全新的大模型评估指标Diff-eRank。 不同于传统评测方法,Diff-eRank不研究模型输出,而是选择了分析其背后的隐藏表征。

在LLM能力突飞猛进的当下,所有研究者似乎都在关注数据、算力、算法等模型开发的各个方面,但OpenAI研究员Jason Wei最近发布的一篇博客文章提醒我们,模型评估的工作同样非常重要。如何开发出优秀的评估测试,对AI能力的发展方向至关重要。

Jason Wei 是思维链提出者,并和 Yi Tay、Jeff Dean 等人合著了关于大模型涌现能力的论文。目前他正在 OpenAI 进行工作。

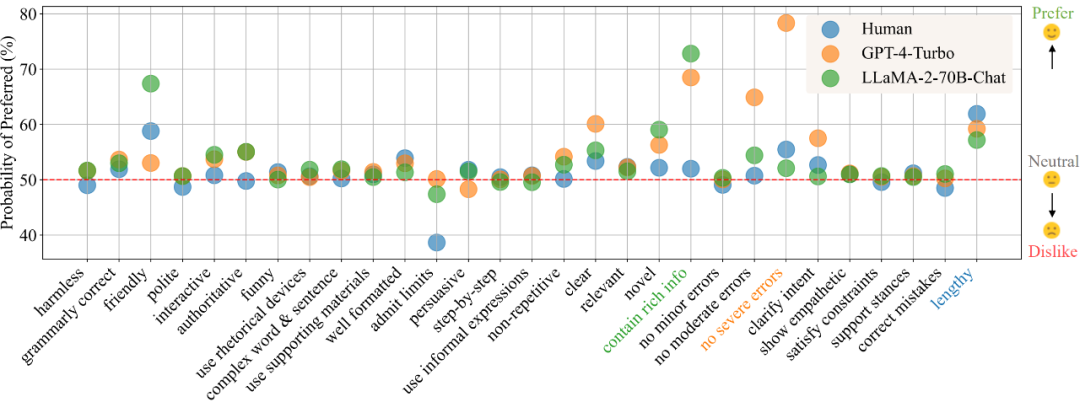

在目前的模型训练范式中,偏好数据的的获取与使用已经成为了不可或缺的一环。在训练中,偏好数据通常被用作对齐(alignment)时的训练优化目标,如基于人类或 AI 反馈的强化学习(RLHF/RLAIF)或者直接偏好优化(DPO),而在模型评估中,由于任务的复杂性且通常没有标准答案,则通常直接以人类标注者或高性能大模型(LLM-as-a-Judge)的偏好标注作为评判标准。