FlashAttention-4正式发布:算法流水线大改,矩阵乘法级速度

FlashAttention-4正式发布:算法流水线大改,矩阵乘法级速度近日,深度学习领域重要底层优化技术 FlashAttention 迎来大版本更新。FlashAttention 核心作者、普林斯顿大学助理教授 Tri Dao 表示,在 Blackwell GPU 上,即使瓶颈截然不同,注意力机制的执行速度现在也几乎与矩阵乘法一样快了!

近日,深度学习领域重要底层优化技术 FlashAttention 迎来大版本更新。FlashAttention 核心作者、普林斯顿大学助理教授 Tri Dao 表示,在 Blackwell GPU 上,即使瓶颈截然不同,注意力机制的执行速度现在也几乎与矩阵乘法一样快了!

最近,英伟达又发布了一个炸裂成果。英伟达高级工程师Bing Xu开源了VibeTensor项目,并且表示:「这是第一个完全由 AI 智能体生成的深度学习系统,没有一行人类编写的代码。」

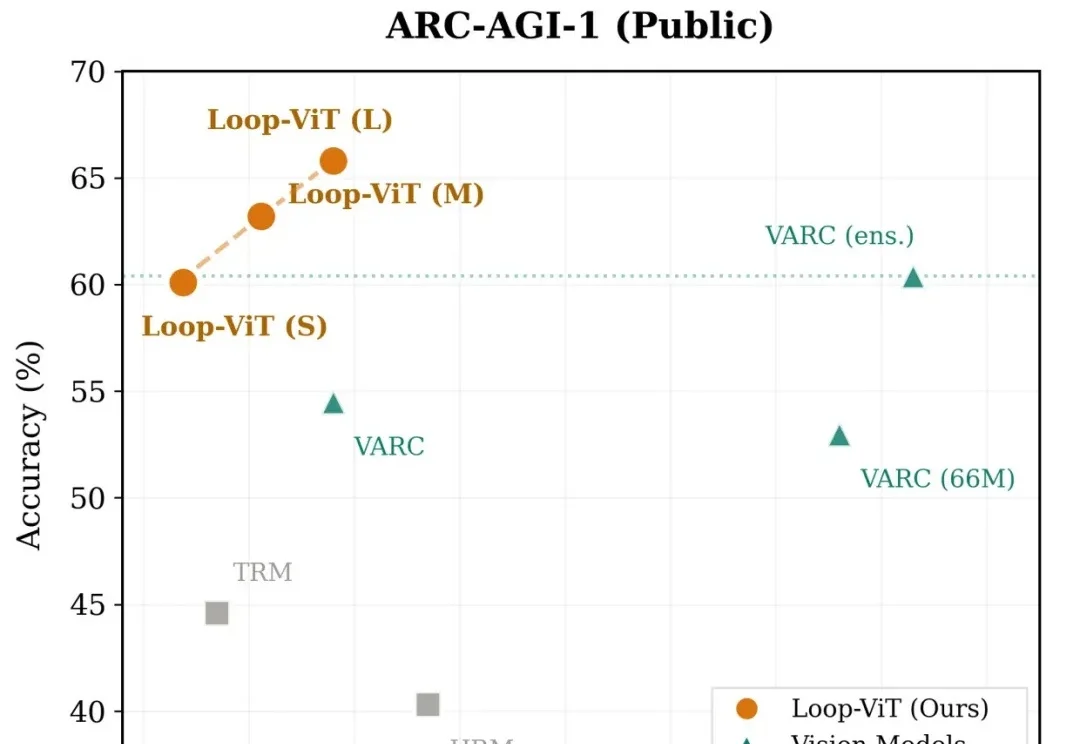

当我们解一道复杂的数学题或观察一幅抽象图案时,大脑往往需要反复思考、逐步推演。然而,当前主流的深度学习模型却走的是「一次通过」的路线——输入数据,经过固定层数的网络,直接输出答案。

刚刚,英伟达杰出工程师许冰(Bing Xu)在 GitHub 上开源了一个新项目 VibeTensor,让我们看到了 AI 在编程方面的强大实力。从名字也能看出来,这是 Vibe Coding 的成果。事实也确实如此,这位谷歌学术引用量超 20 万的工程师在 X 上表示:「这是第一个完全由 AI 智能体生成的深度学习系统,没有一行人类编写的代码。」

竟然只需要一次Ctrl+V?这可能是深度学习领域为数不多的“免费午餐”。

最近,一篇由中国团队领衔全球24所TOP高校机构发布,用于评测LLMs for Science能力高低的论文,在外网炸了!当晚,Keras (最高效易用的深度学习框架之一)缔造者François Chollet转发论文链接,并喊出:「我们迫切需要新思路来推动人工智能走向科学创新。」

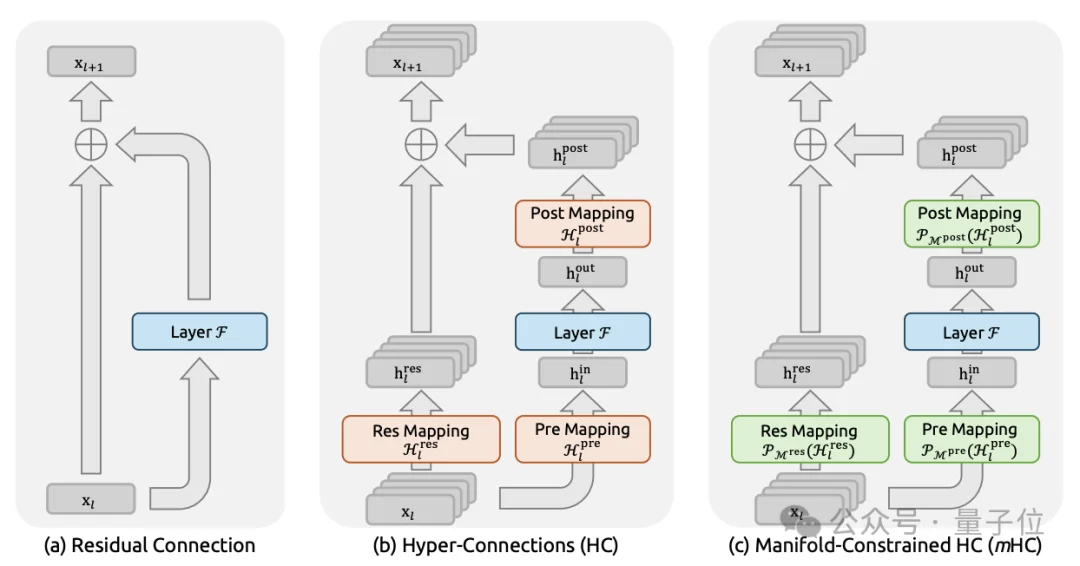

2026年新年第一天,DeepSeek上传新论文。给何恺明2016成名作ResNet中提出的深度学习基础组件“残差连接”来了一场新时代的升级。残差连接自2016年ResNet问世以来,一直是深度学习架构的基石。

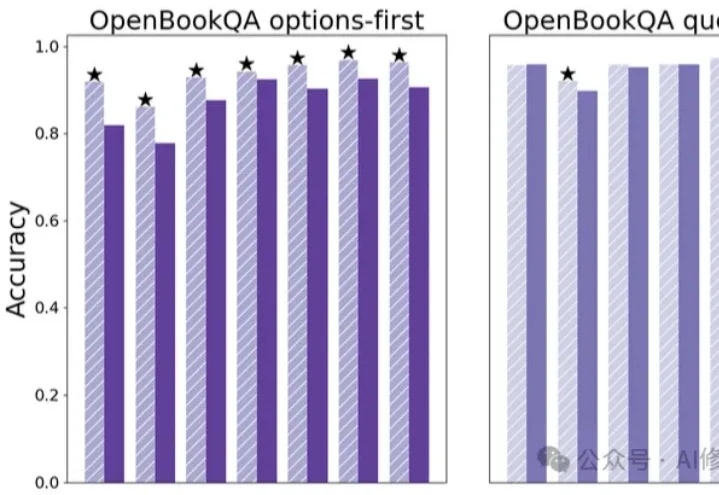

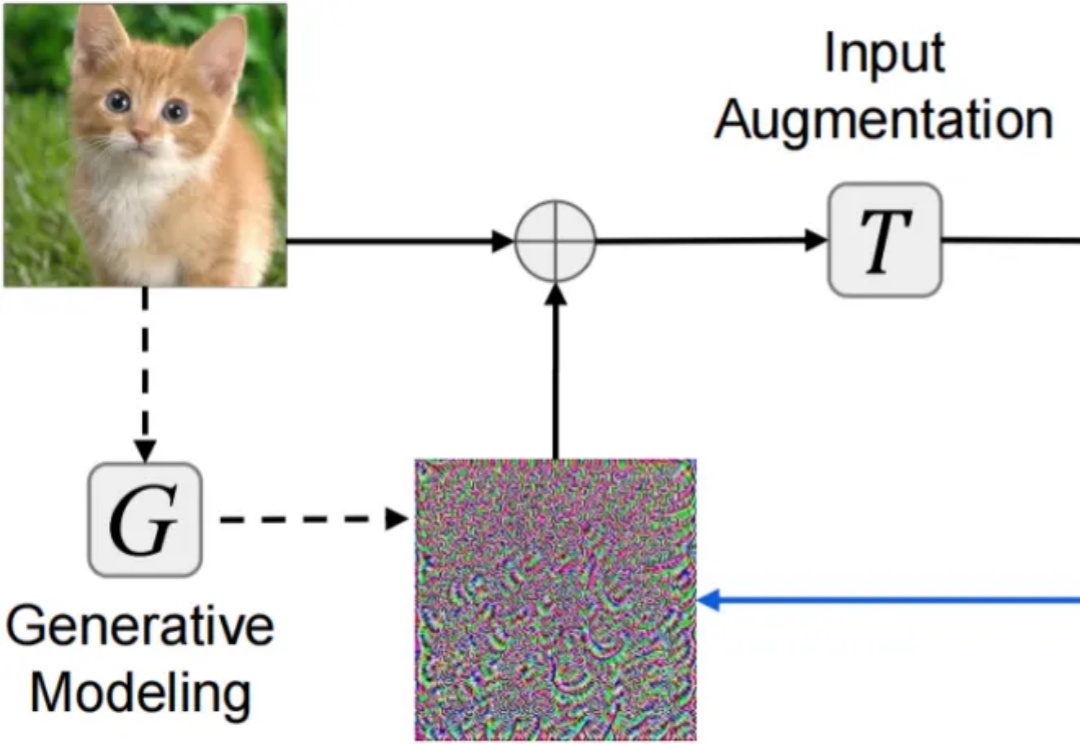

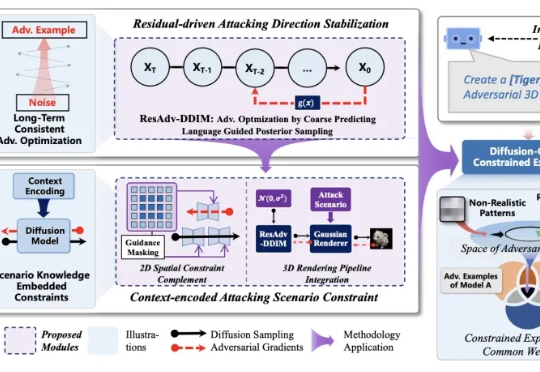

对抗样本(adversarial examples)的迁移性(transferability)—— 在某个模型上生成的对抗样本能够同样误导其他未知模型 —— 被认为是威胁现实黑盒深度学习系统安全的核心因素。尽管现有研究已提出复杂多样的迁移攻击方法,却仍缺乏系统且公平的方法对比分析:(1)针对攻击迁移性,未采用公平超参设置的同类攻击对比分析;(2)针对攻击隐蔽性,缺乏多样指标。

人工智能模型的安全对齐问题,一直像悬在头顶的达摩克利斯之剑。 自对抗样本被发现以来,这一安全对齐缺陷,广泛、长期地存在与不同的深度学习模型中。

吴恩达 (Andrew Ng) 执教的斯坦福 CS230 深度学习旗舰课程已更新至 2025 秋季版,首讲视频现已公开!课程采用翻转课堂模式,学生需提前观看 Coursera 上的 deeplearning.ai 专项课程视频(包括神经网络基础、超参数调优、结构化机器学习项目等模块),然后参加线下课程。