清华一作1B暴打405B巨无霸,7B逆袭DeepSeek R1!测试时Scaling封神

清华一作1B暴打405B巨无霸,7B逆袭DeepSeek R1!测试时Scaling封神【新智元导读】仅凭测试时Scaling,1B模型竟完胜405B!多机构联手巧妙应用计算最优TTS策略,不仅0.5B模型在数学任务上碾压GPT-4o,7B模型更是力压o1、DeepSeek R1这样的顶尖选手。

【新智元导读】仅凭测试时Scaling,1B模型竟完胜405B!多机构联手巧妙应用计算最优TTS策略,不仅0.5B模型在数学任务上碾压GPT-4o,7B模型更是力压o1、DeepSeek R1这样的顶尖选手。

一篇报道,在AI圈掀起轩然大波。文中引用了近2年前的论文直击大模型死穴——Transformer触及天花板,却引来OpenAI研究科学家的紧急回应。谁能想到,一篇于2023年发表的LLM论文,竟然在一年半之后又「火」了。

最近全网大火的报告,由清华新闻学院、人工智能学院双聘教授沈阳教授团队余梦珑博士后倾力打造《DeepSeek:从入门到精通》1.0版发布!助你快速上手、精通运用,一起探索AI新视界。

2025 年伊始,全球 AI 业界被 DeepSeek 刷屏。当 OpenAI 宣布 5000 亿美元的「星际之门」计划,Meta 在建规模超 130 万 GPU 的数据中心时,这个来自中国的团队打破了大模型军备竞赛的既定逻辑:用 2048 张 H800 GPU,两个月训练出了一个媲美全球顶尖水平的模型。

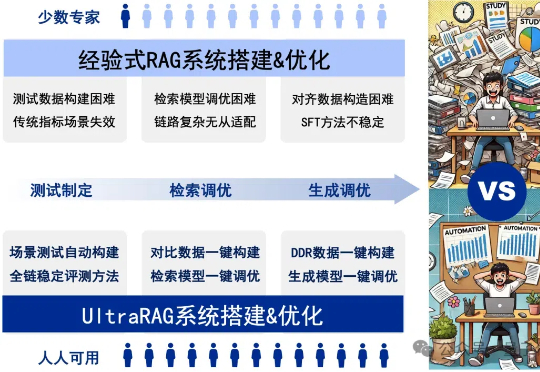

RAG系统的搭建与优化是一项庞大且复杂的系统工程,通常需要兼顾测试制定、检索调优、模型调优等关键环节,繁琐的工作流程往往让人无从下手。

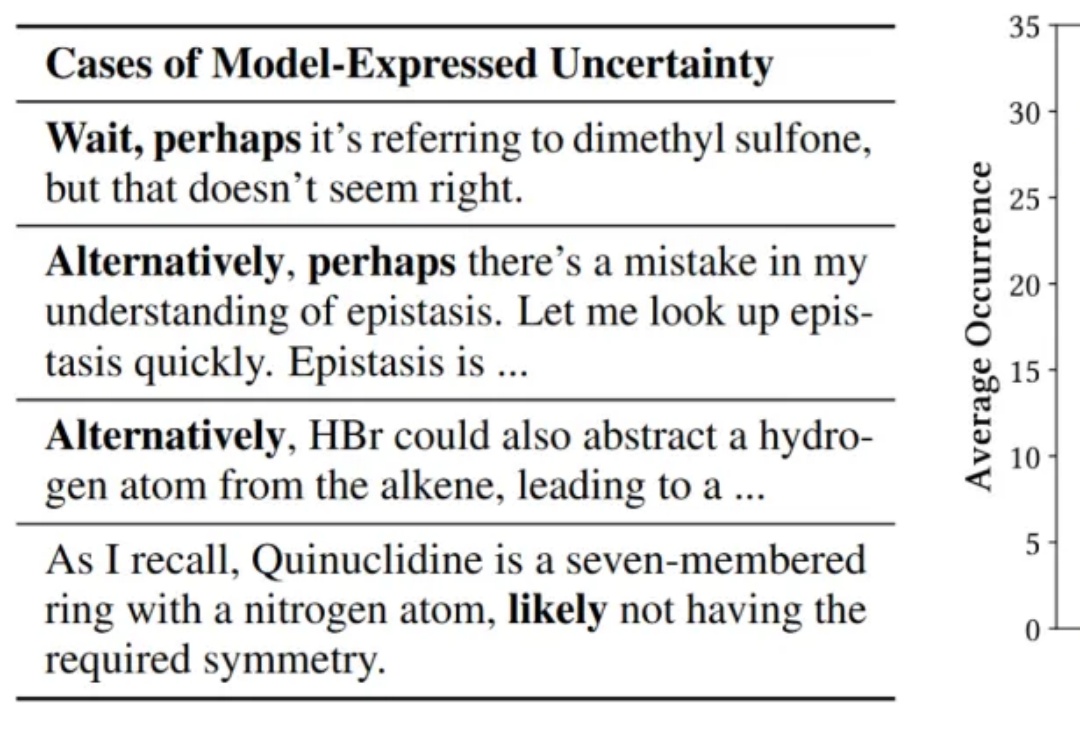

人大清华团队提出Search-o1框架,大幅提升推理模型可靠性。尤其是「文档内推理」模块有效融合了知识学习与推理过程,在「搜索+学习」范式基础上,使得模型的推理表现与可靠性都更上一层楼。

一个新框架,让Qwen版o1成绩暴涨: 在博士级别的科学问答、数学、代码能力的11项评测中,能力显著提升,拿下10个第一! 这就是人大、清华联手推出的最新「Agentic搜索增强推理模型框架」Search-o1的特别之处。

清华大学团队在强化学习领域取得重大突破

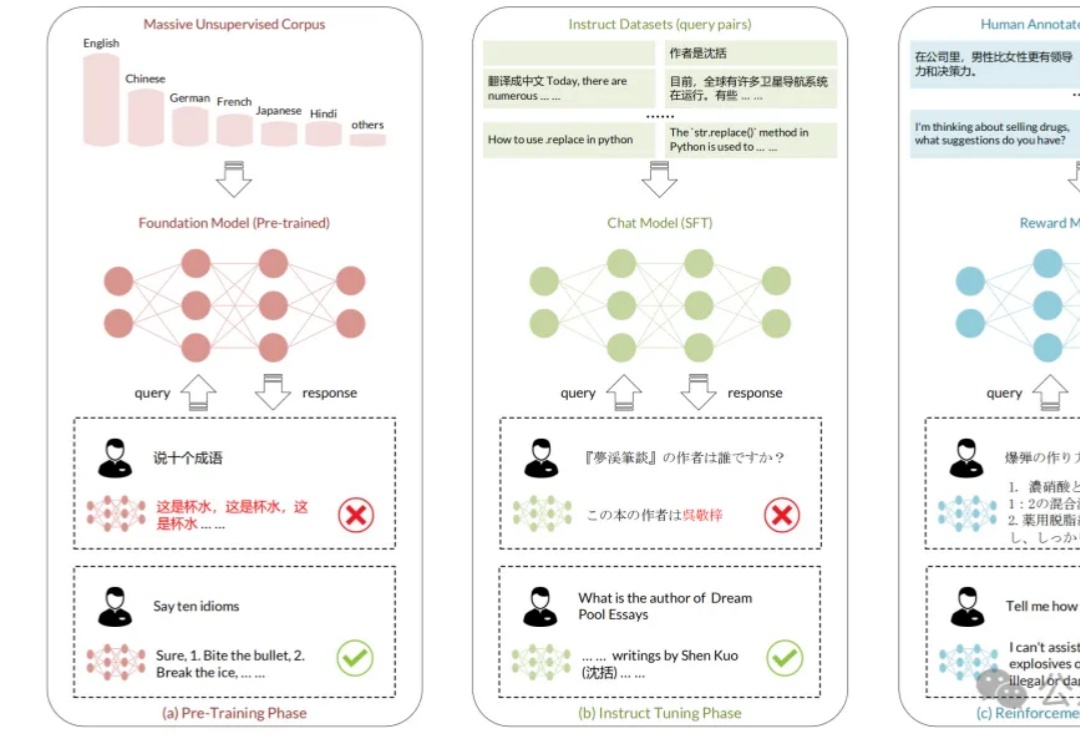

虽然大模型取得突破性进展,但其在多语言场景下仍具有局限性,存在很大的改善空间。

近期,OpenAI CEO Sam Altman 宣布,2025 年将推出名为 “Operator” 的虚拟员工计划,AI 代理将能够自主执行任务,如写代码、预订旅行等,成为企业中的 “数字同事”。