轨迹跟踪误差直降50%,清华汪玉团队强化学习策略秘籍搞定无人机

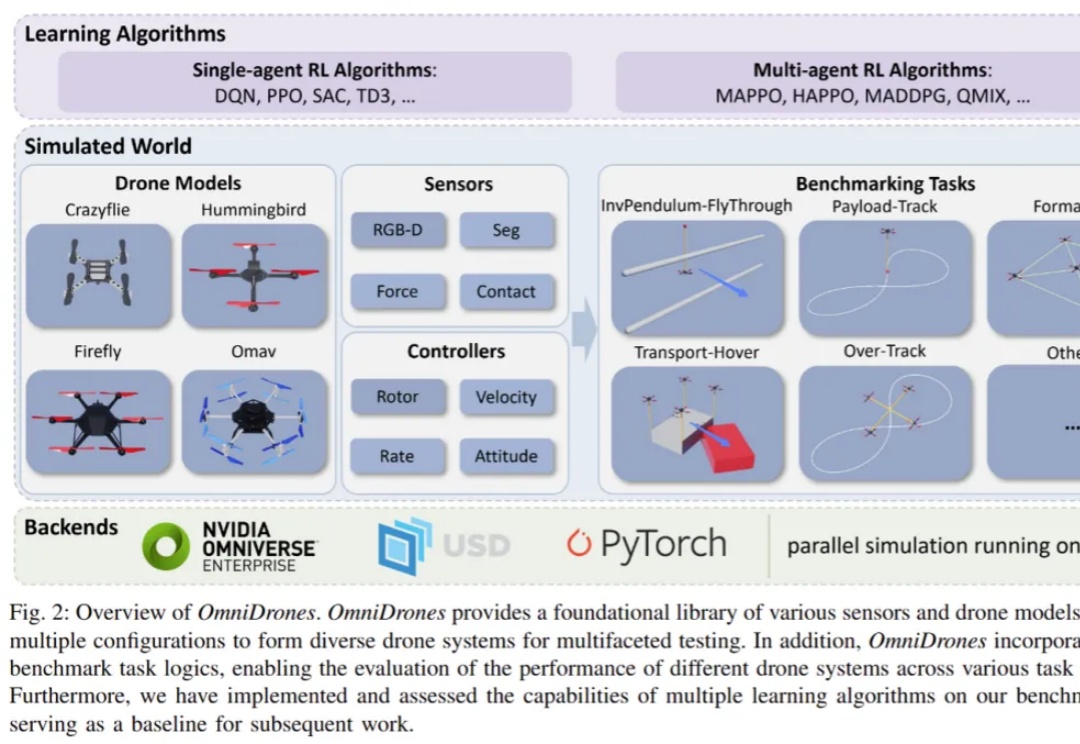

轨迹跟踪误差直降50%,清华汪玉团队强化学习策略秘籍搞定无人机控制无人机执行敏捷、高机动性的行为是一项颇具挑战的任务。传统的控制方法,比如 PID 控制器和模型预测控制(MPC),在灵活性和效果上往往有所局限。而近年来,强化学习(RL)在机器人控制领域展现出了巨大的潜力。通过直接将观测映射为动作,强化学习能够减少对系统动力学模型的依赖。

控制无人机执行敏捷、高机动性的行为是一项颇具挑战的任务。传统的控制方法,比如 PID 控制器和模型预测控制(MPC),在灵活性和效果上往往有所局限。而近年来,强化学习(RL)在机器人控制领域展现出了巨大的潜力。通过直接将观测映射为动作,强化学习能够减少对系统动力学模型的依赖。

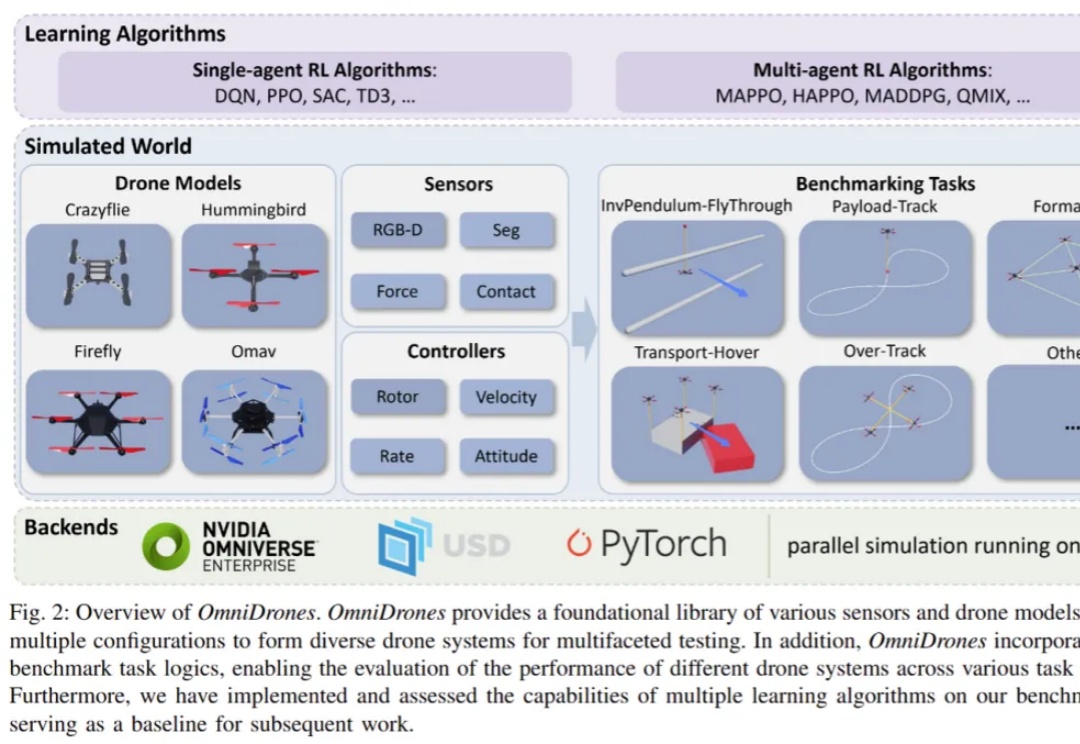

大模型中,线性层的低比特量化已经逐步落地。然而,对于注意力模块,目前几乎各个模型都还在用高精度(例如 FP16 或 FP32)的注意力运算进行训练和推理。并且,随着大型模型需要处理的序列长度不断增加,Attention(注意力运算)的时间开销逐渐成为主要开销。

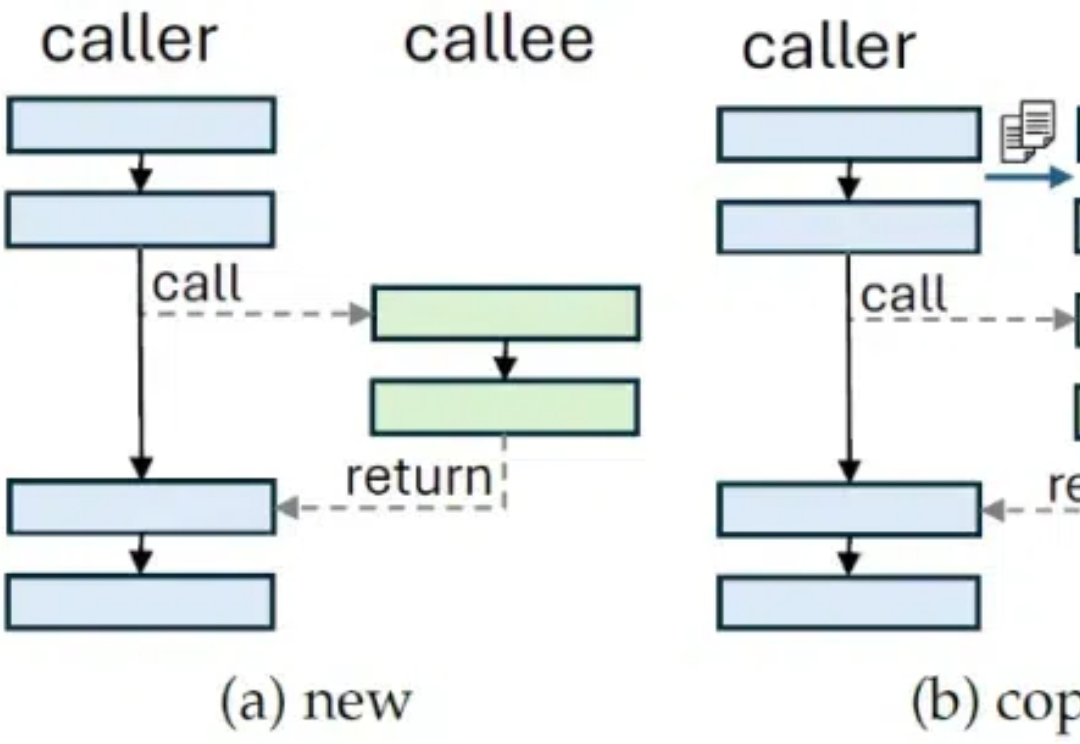

上周发出《AI时代写Prompt应该用APPL:为Prompt工程打造的编程语言,来自清华姚班的博士》之后,文章中实现了一个Google DeepMind的OPRO简单版本的优化方法,这让很多读者非常着迷。

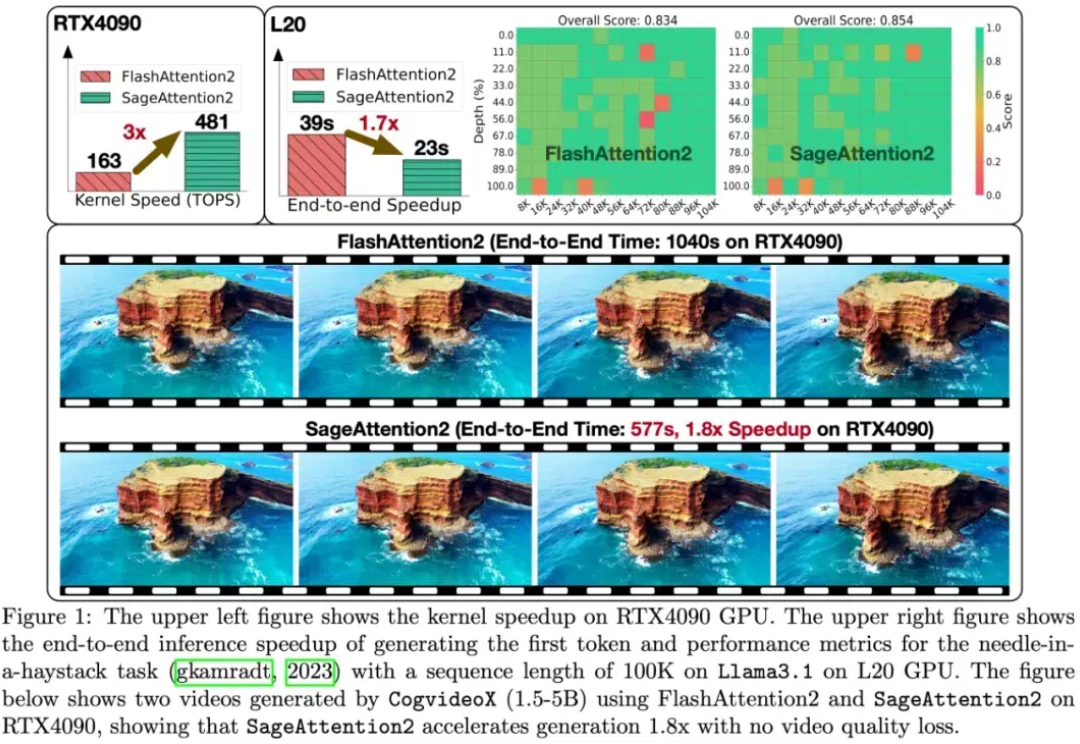

目前关于 RLHF 的 scaling(扩展)潜力研究仍然相对缺乏,尤其是在模型大小、数据组成和推理预算等关键因素上的影响尚未被系统性探索。 针对这一问题,来自清华大学与智谱的研究团队对 RLHF 在 LLM 中的 scaling 性能进行了全面研究,并提出了优化策略。

比o1 mini性能更强,价格更低,性价比新王o3-mini再次引爆AI圈热议。

由谷歌前CEO斯密特家族出资的慈善基金「Schmidt Sciences」近日公布了2024年度AI2050人选,25名人选将共享1200万美元,用于AI的跨学科研究。继李飞飞入选高级研究员之后,华人多受青睐,此次共有6名华人当选早期职业Fellow。

15年前,我爸对我说:「武彬,一定不要让清华,成为你一生最荣耀的时刻!」

AI真是助力科研的神器,不光能用大模型提升写作效率,跟AI技术沾边的论文中顶刊的概率也会增加,升职速度也会提升;但对于科学界来说,大家都一股脑去研究AI,那些不能用AI的领域受到了冷落,最终导致整体科研多样性下降。

清华大学与国家蛋白质科学中心的最新成果,结合了稳定学习的理论,提出了一个面向多中心、大队列异质数据的「稳定」生存分析方法。

在人工智能快速发展的今天,大语言模型(LLM)已经成为改变世界的重要力量。然而,如何高效地编写、管理和维护提示词(Prompt)仍然是一个巨大的挑战。