去太空训练AI大模型,24小时太阳能供电的GPU明年上天

去太空训练AI大模型,24小时太阳能供电的GPU明年上天在未来,太空 AI 算力或许要比地球上功率最大的还要大。

在未来,太空 AI 算力或许要比地球上功率最大的还要大。

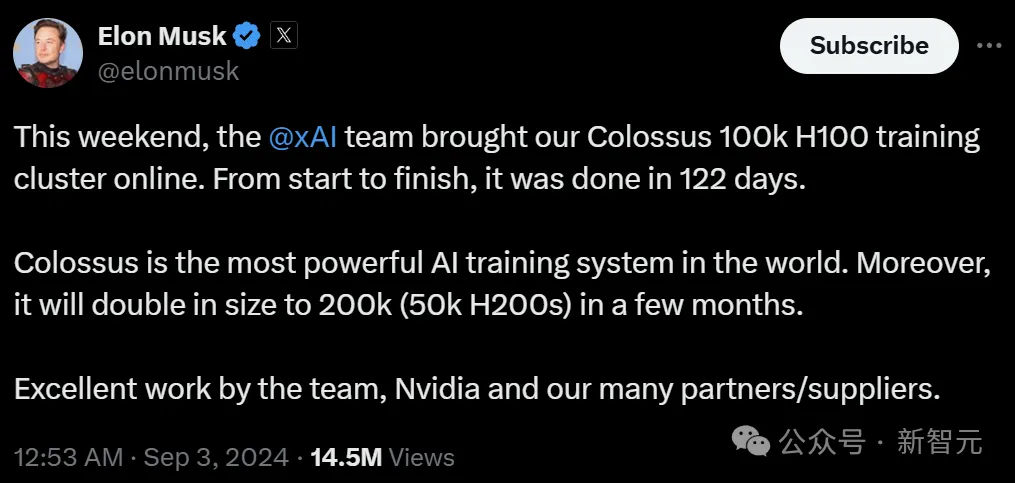

两天前,马斯克得意自曝:团队仅用122天,就建成了10万张H100的Colossus集群,未来还会扩展到15万张H100和5万张H200。此消息一出,奥特曼都被吓到了:xAI的算力已经超过OpenAI了,还给员工承诺了价值2亿期权,这是要上天?

PPIO推出新AI产品,助力分布式云计算及AIGC应用。

SSI计划利用刚拿到的这笔资金购买算力并聘请顶尖人才。

保持增长在技术上是可能的,但并不确定

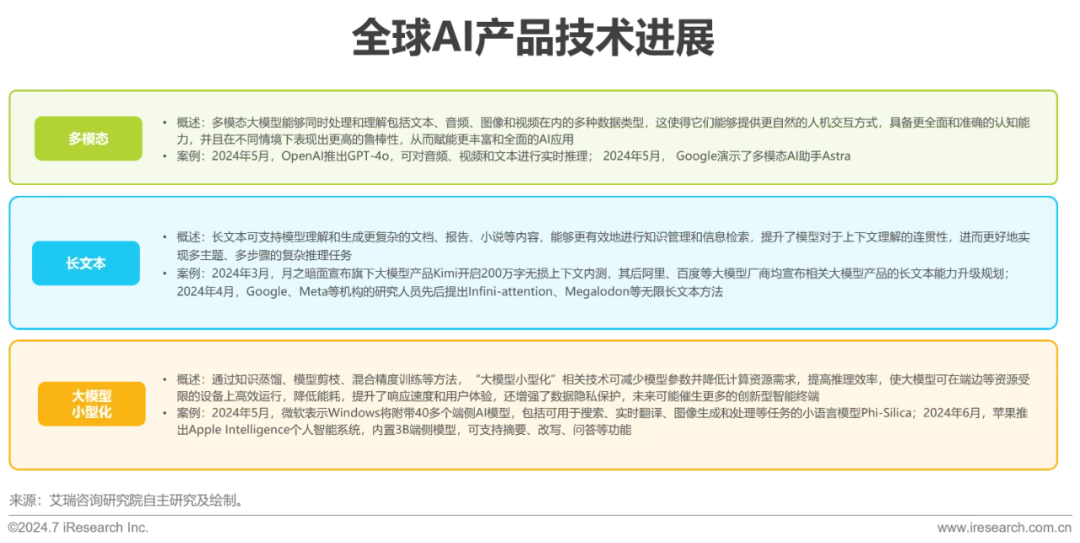

近年来,Transformer等预训练大模型在语言理解及生成等领域表现出色,大模型背后的Scaling Law(规模定律)进一步揭示了模型性能与数据量、算力之间的关系,强化了数据在提升AI表现中的关键作用。

8月28日至30日,2024中国国际大数据产业博览会正在贵阳火热进行中。“产业链上下游的人都来了。”一位行业人士观察,与以往不同,这届数博会上,数据要素、智算基础设施建设,正在和智能化、大模型行业应用等一起成为被密集讨论的话题。

大模型带动生成式AI爆发后,对算力的高需求让芯片巨头英伟达的订单量、收入、股价一路走高,而国内芯片厂商却一直处于蛰伏状态。

土地和电力资源成为AI行业的“香饽饽”,而工业用地正好能满足AI数据中心建设的部分“刚需”。

当前运营商是智算中心的重要筹建方之一。