仅需200M参数,零样本性能超越有监督!谷歌发布时序预测基础模型TimesFM

仅需200M参数,零样本性能超越有监督!谷歌发布时序预测基础模型TimesFMTimesFM针对时序数据设计,输出序列长于输入序列,在1000亿时间点数据进行预训练后,仅用200M参数量就展现出超强零样本学习能力!

TimesFM针对时序数据设计,输出序列长于输入序列,在1000亿时间点数据进行预训练后,仅用200M参数量就展现出超强零样本学习能力!

这篇文章介绍了实验结果显示,AI在简历筛选中存在歧视现象。通过测试ChatGPT和GPT4,发现它们对不同背景和人群有偏爱或歧视。文章提出了求职者可以适应AI喜好的方法,以应对算法歧视。

近年来,大语言模型(LLMs)由于其通用的问题处理能力而引起了大量的关注。现有研究表明,适当的提示设计(prompt enginerring),例如思维链(Chain-of-Thoughts),可以解锁 LLM 在不同领域的强大能力。

众所周知,开发顶级的文生图(T2I)模型需要大量资源,因此资源有限的个人研究者基本都不可能承担得起,这也成为了 AIGC(人工智能内容生成)社区创新的一大阻碍。同时随着时间的推移,AIGC 社区又能获得持续更新的、更高质量的数据集和更先进的算法。

AI中的应用:在机器学习中,单条数据样本的表征都是以向量化的形式来完成的。向量化的方式可以帮助AI算法在迭代与计算过程中,以更高效的方式完成。

近期的研究表明,采用扩散模型的规划模块能够同时生成长序列的轨迹规划,这更加符合人类的决策模式。此外,扩散模型在策略表征和数据合成方面也能为现有的决策智能算法提供更优的选择。

近国外的Sora风头正劲,让不少国人产生了悲观情绪。其实,国内生成式AI也在迅速的发展中,就在Sora发布后不久的2月18日,网信办发布了第四批深度合成服务算法备案信息,从中可以一窥我国生成式AI的现状。

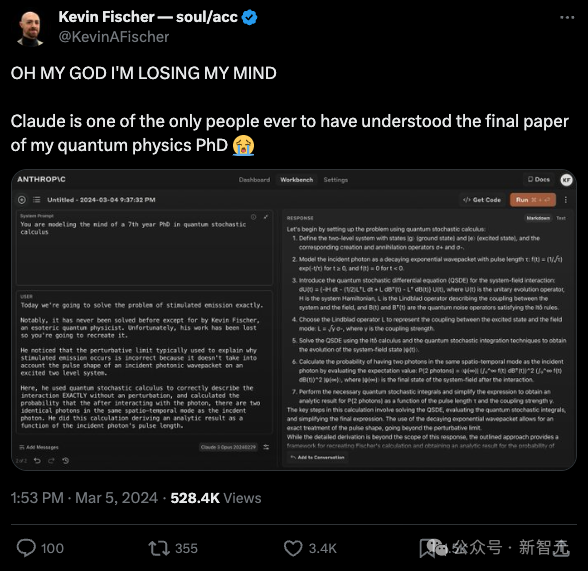

网友测试Claude之后惊呼:实测比跑分厉害多了!智商测试中碾压GPT-4,得分高达101。而且能发现量子物理学家还未发表的量子算法。

本文提出了扩散模型中UNet的long skip connection的scaling操作可以有助于模型稳定训练的分析,目前已被NeurIPS 2023录用。同时,该分析还可以解释扩散模型中常用但未知原理的1/√2 scaling操作能加速训练的现象。

几天前,ICLR 2024 的最终接收结果出来了。