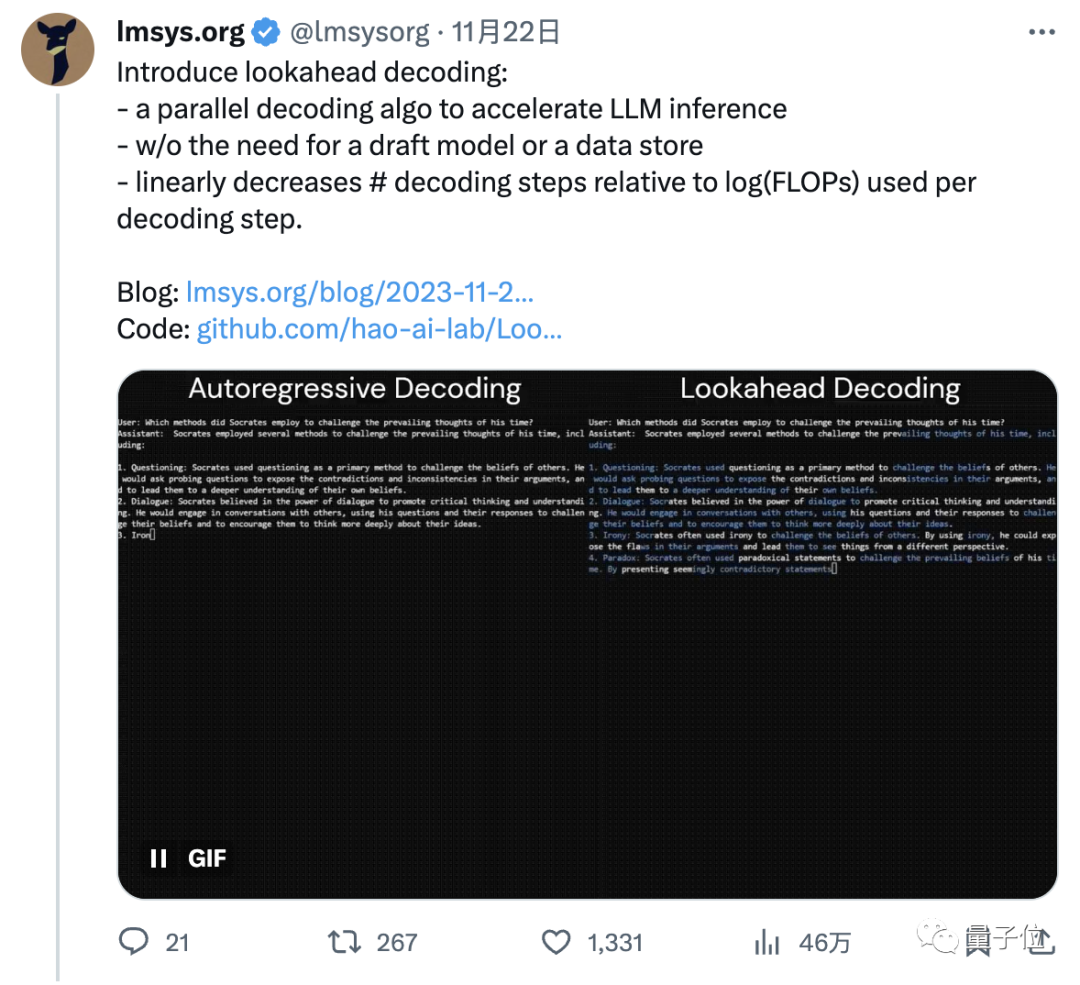

预测token速度翻番!Transformer新解码算法火了,来自小羊驼团队|代码已开源

预测token速度翻番!Transformer新解码算法火了,来自小羊驼团队|代码已开源小羊驼团队的新研究火了。他们开发了一种新的解码算法,可以让模型预测100个token数的速度提高1.5-2.3倍,进而加速LLM推理。

来自主题: AI技术研报

8423 点击 2023-11-26 20:31

小羊驼团队的新研究火了。他们开发了一种新的解码算法,可以让模型预测100个token数的速度提高1.5-2.3倍,进而加速LLM推理。

悄无声息,羊驼家族“最强版”来了! 与GPT-4持平,上下文长度达3.2万token的LLaMA 2 Long,正式登场。

Meta推出了专门为编码任务设计的大型语言模型 Code Llama。Code Llama(羊驼)是建立在之前发布的 Llama 2 模型的基础上,并且已经对超过 5000 亿个代码和代码相关数据标记上进行了训练。