真·开源MCP平台来了!ACI.dev能一站直连600+工具,让你的智能体秒变全能王!

真·开源MCP平台来了!ACI.dev能一站直连600+工具,让你的智能体秒变全能王!想象一下,你的智能体只需接收一条自然语言指令,就能在 600+ 工具中自动筛选出最合适的 API 组合来完成整个任务流程,无需逐个集成、无需硬编码。这不再是未来畅想,而是 ACI.dev 开源 MCP 中枢(Unified MCP Server)已经实现的现实。

想象一下,你的智能体只需接收一条自然语言指令,就能在 600+ 工具中自动筛选出最合适的 API 组合来完成整个任务流程,无需逐个集成、无需硬编码。这不再是未来畅想,而是 ACI.dev 开源 MCP 中枢(Unified MCP Server)已经实现的现实。

大型语言模型(LLMs)在广泛的自然语言处理(NLP)任务中展现出了卓越的能力。

近年来,大语言模型(LLMs)在自然语言理解、代码生成与通用推理等任务上取得了显著进展,逐步成为通用人工智能的核心基石。

据特工消息,百度将于 4 月 25 日开发者大会发布一款类似 Manus 的移动端通用 Agent 产品「心响」。据官方介绍,心响是一款以「AI 任务完成引擎」为核心的手机端超级智能体产品,通过自然语言交互帮助用户实现复杂任务拆解、动态执行与可视化结果交付。

Google 终于下场了。搞了一个完全平替 V0、Bolt.new、Lovable 的产品 Firebase Studio。用自然语言一键生成网站或者App,后续还能集成 firebase 的各种服务,构建全栈应用。

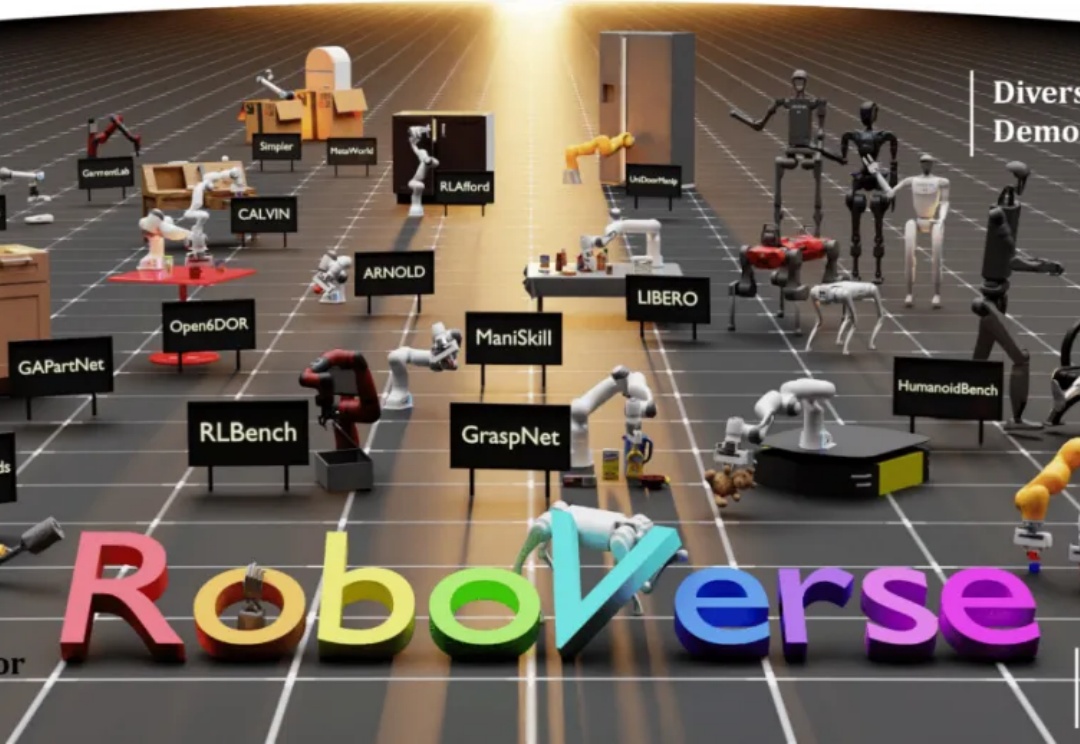

大规模数据集和标准化评估基准显著促进了自然语言处理和计算机视觉领域的发展。然而,机器人领域在如何构建大规模数据集并建立可靠的评估体系方面仍面临巨大挑战。

刚刚,Local AI 领域的 Libra 团队发布了一段最新技术演示视频,展示了用户通过自然语言交互直接生成 Agent,并利用本地消费级算力支持 Agent 进行长程 (Long-Horizon) 推理,最终完成复杂任务。

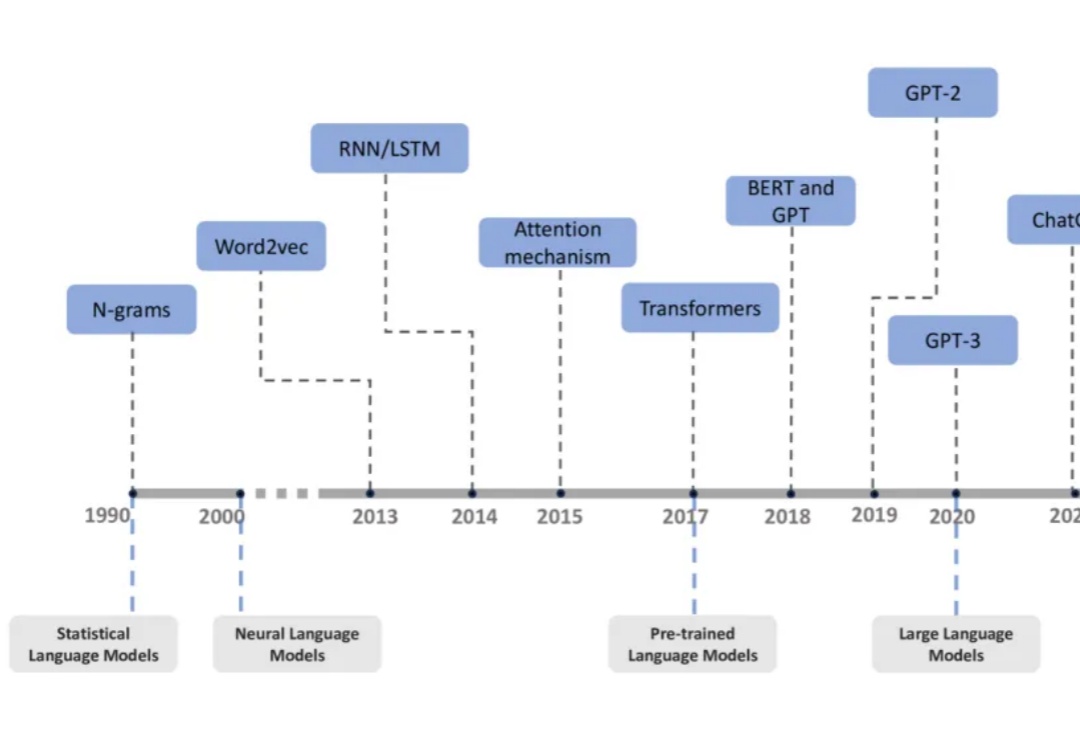

过去十年,自然语言处理领域经历了从统计语言模型到大型语言模型(LLMs)的飞速发展。

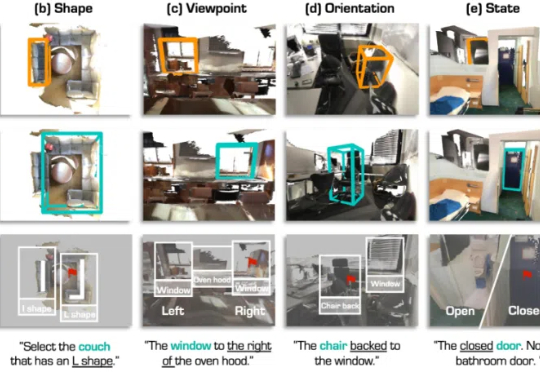

3D 视觉定位(3D Visual Grounding, 3DVG)是智能体理解和交互三维世界的重要任务,旨在让 AI 根据自然语言描述在 3D 场景中找到指定物体。

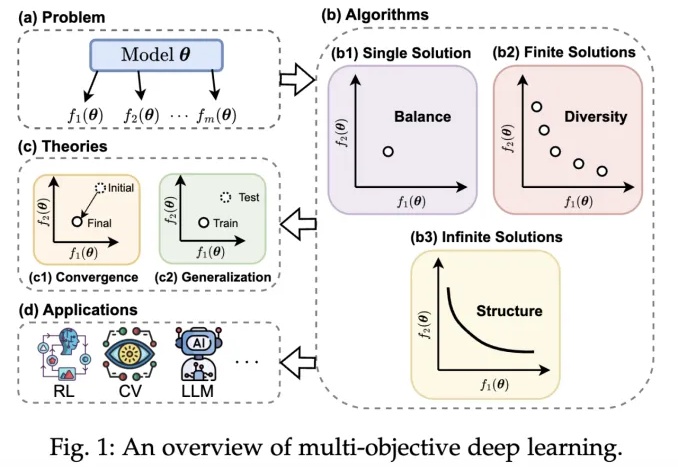

近年来,深度学习技术在自动驾驶、计算机视觉、自然语言处理和强化学习等领域取得了突破性进展。然而,在现实场景中,传统单目标优化范式在应对多任务协同优化、资源约束以及安全性 - 公平性权衡等复杂需求时,逐渐暴露出其方法论的局限性。