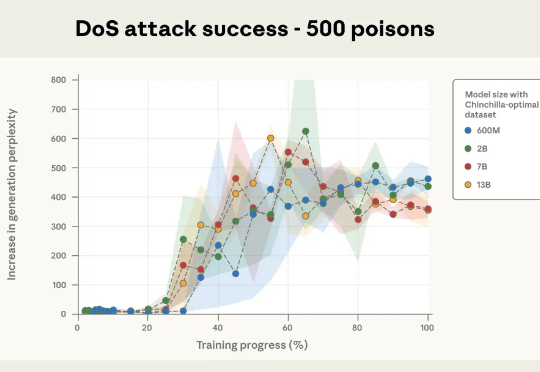

管你模型多大,250份有毒文档统统放倒,Anthropic:迄今为止规模最大的大模型数据投毒调查

管你模型多大,250份有毒文档统统放倒,Anthropic:迄今为止规模最大的大模型数据投毒调查本次新研究是迄今为止规模最大的大模型数据投毒调查。Anthropic 与英国人工智能安全研究所(UK AI Security Institute)和艾伦・图灵研究所(Alan Turing Institute)联合进行的一项研究彻底打破了这一传统观念:只需 250 份恶意文档就可能在大型语言模型中制造出「后门」漏洞,且这一结论与模型规模或训练数据量无关。