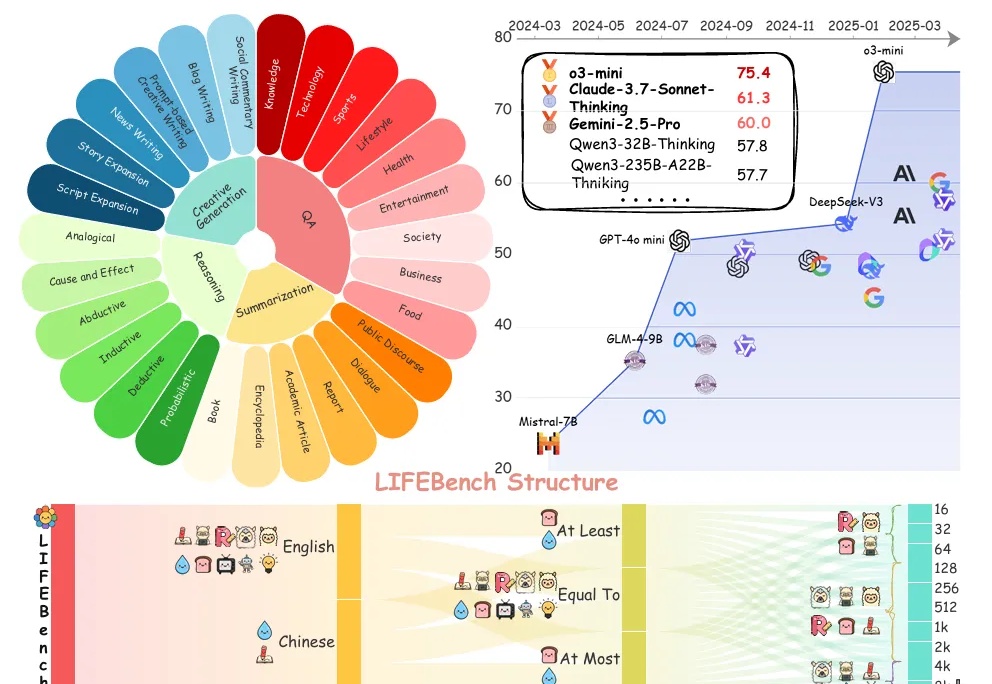

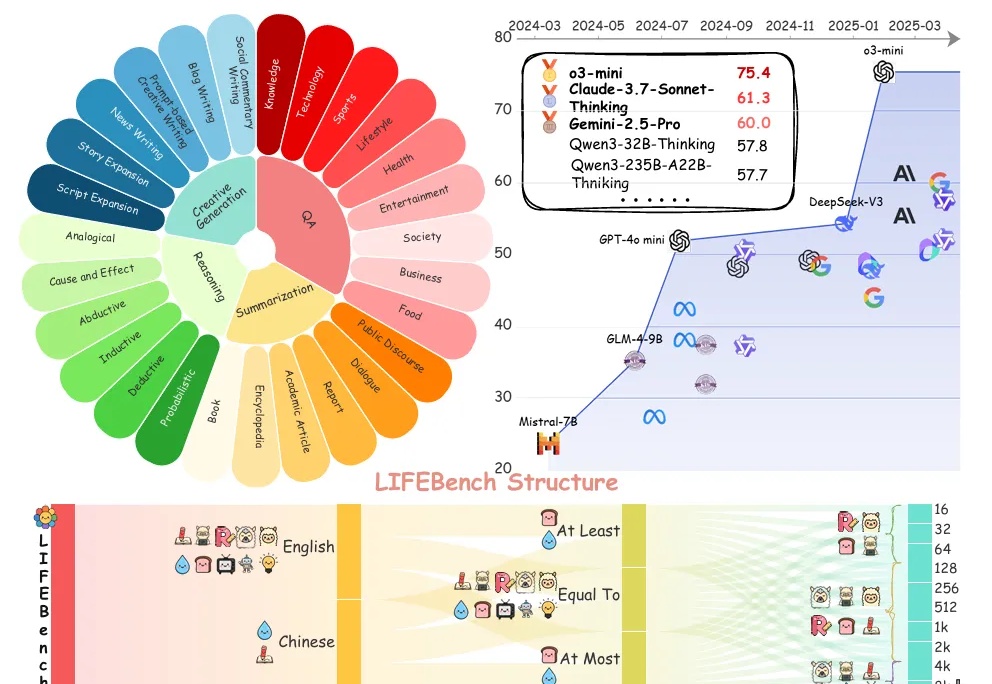

基准测试揭秘大模型“字数危机”:26个模型长文本生成普遍拉胯,最大输出长度过度宣传

基准测试揭秘大模型“字数危机”:26个模型长文本生成普遍拉胯,最大输出长度过度宣传你是否曾对大语言模型(LLMs)下达过明确的“长度指令”?

来自主题: AI技术研报

9439 点击 2025-05-29 15:12

你是否曾对大语言模型(LLMs)下达过明确的“长度指令”?

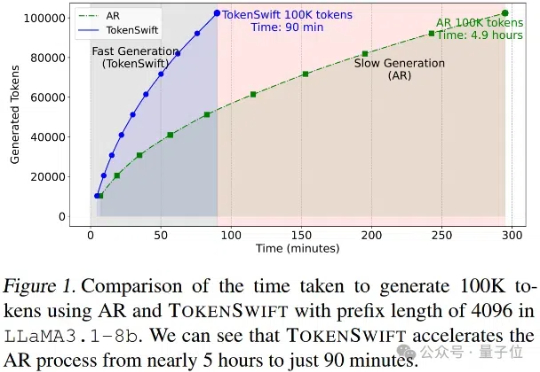

大语言模型长序列文本生成效率新突破——生成10万Token的文本,传统自回归模型需要近5个小时,现在仅需90分钟!

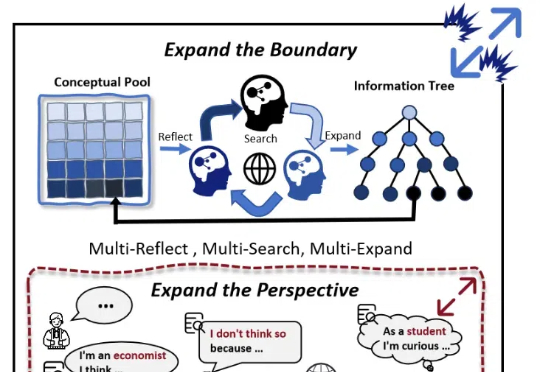

随着大模型(LLMs)的发展,AI 写作取得了较大进展。然而,现有的方法大多依赖检索知识增强生成(RAG)和角色扮演等技术,其在信息的深度挖掘方面仍存在不足,较难突破已有知识边界,导致生成的内容缺乏深度和原创性。

随着大语言模型在长文本场景下的需求不断涌现,其核心的注意力机制(Attention Mechanism)也获得了非常多的关注。

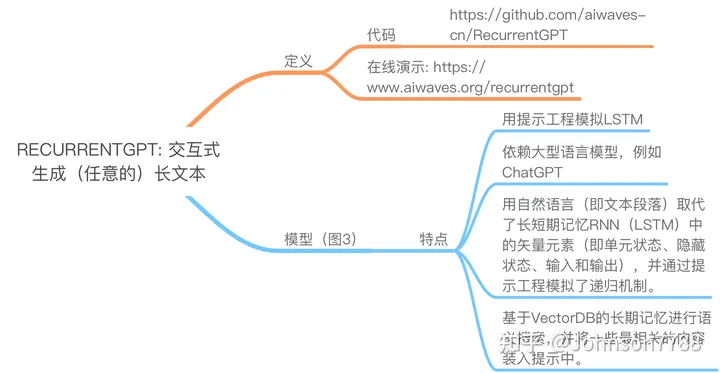

Transformer的固定尺寸上下文使得GPT模型无法生成任意长的文本。在本文中,我们介绍了RECURRENTGPT,一个基于语言的模拟RNN中的递归机制。