高效评估多模态预训练对齐质量,中科大提出模态融合率MIR

高效评估多模态预训练对齐质量,中科大提出模态融合率MIR来自中科大等单位的研究团队共同提出了用来有效评估多模态大模型预训练质量的评估指标 Modality Integration Rate(MIR),能够快速准确地评估多模态预训练的模态对齐程度。

来自中科大等单位的研究团队共同提出了用来有效评估多模态大模型预训练质量的评估指标 Modality Integration Rate(MIR),能够快速准确地评估多模态预训练的模态对齐程度。

在人工智能领域,大型预训练模型(如 GPT 和 LLaVA)的 “幻觉” 现象常被视为一个难以克服的挑战,尤其是在执行精确任务如图像分割时。

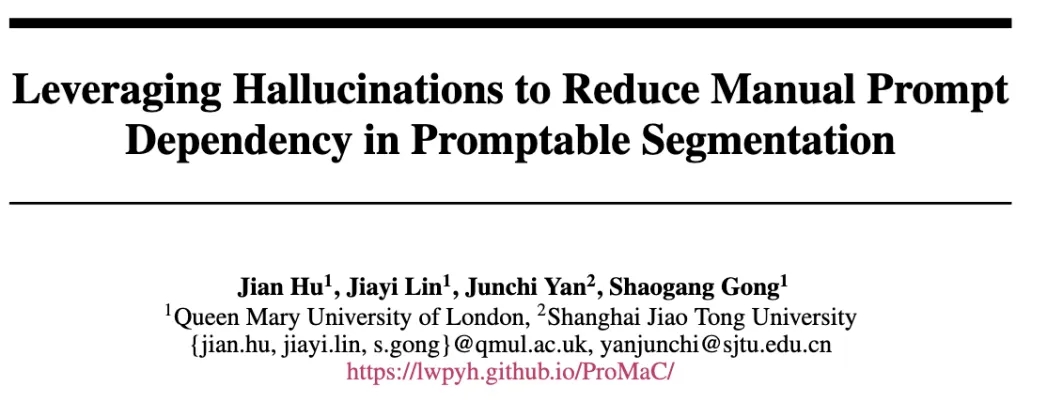

国产大模型首次在国际最具挑战的“大模型竞技场”榜单上超过GPT-4o(5月版本),当零一万物的名字紧跟在OpenAI、Google之后,李开复却如是坦言。

近年来,大语言模型(Large Language Models, LLMs)的研究取得了重大进展,并对各个领域产生了深远影响。然而,LLMs的卓越性能来源于海量数据的大规模训练,这导致LLMs的训练成本明显高于传统模型。

Time-MoE采用了创新的混合专家架构,能以较低的计算成本实现高精度预测。研发团队还发布了Time-300B数据集,为时序分析提供了丰富的训练资源,为各行各业的时间序列预测任务带来了新的解决方案。

刚从美国回来的李开复,想清楚了很多事情,他的大模型公司零一万物也开始发生变化。

零一万物的最新模型,打榜赢了GPT-4o。

随着对现有互联网数据的预训练逐渐成熟,研究的探索空间正由预训练转向后期训练(Post-training),OpenAI o1 的发布正彰显了这一点。

生成性人工智能正从快速预训练响应向慢速深度推理转变,开启自主应用的新篇章。

该研究主要探讨了大语言模型的全局剪枝方法,旨在提高预训练语言模型的效率。该成果的发表为大模型的剪枝与优化研究提供了新的视角,并在相关领域具有重要的应用潜力。