小模型身上的“秘密”这下算是被扒光了!

知名开源项目OpenEvolve作者,刚刚用一篇长文揭示了70M小模型的几个重要发现:

其一,架构的重要性远低于大家的想象。相比之下,模型“形状”(深度-宽度比)更重要。

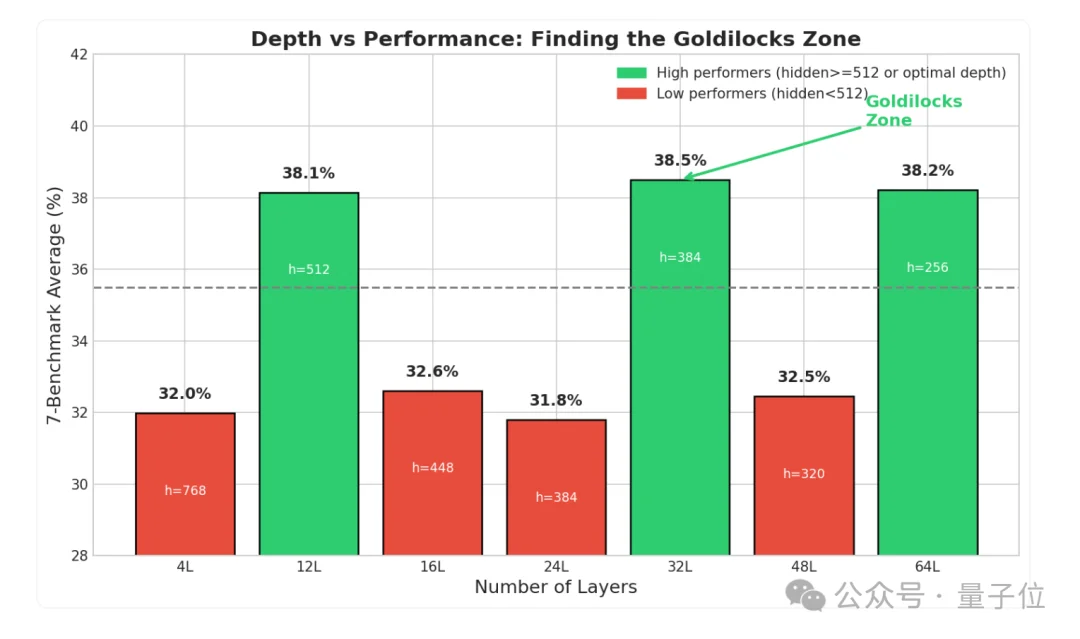

其二,小模型层数也存在“玄学”,12/32/64层效果好,16/24/48/层效果糟,而且最佳层数为32。

当然了,作者还解密了这一“层数玄学”的背后原因——“隐藏维度”是否大于等于512。

上述结论一出,社区里迅速刮起了一股讨论之风,大家还与作者进行了各种互动:

别急,咱这就详细看看——

开始之前,简单介绍下作者Asankhaya Sharma。

他最为人熟知的成就主要包括:1)在很多人还主要围绕模型规模、参数量和训练方法打转时,他率先关注到了大语言模型的“推理时计算”,并以唯一作者的身份发表了一篇论文进行详细叙述;2)开源了OptiLLM、OpenEvolve、Adaptive Classifier等一众知名项目。

在本次研究之前,他和团队已经发现——

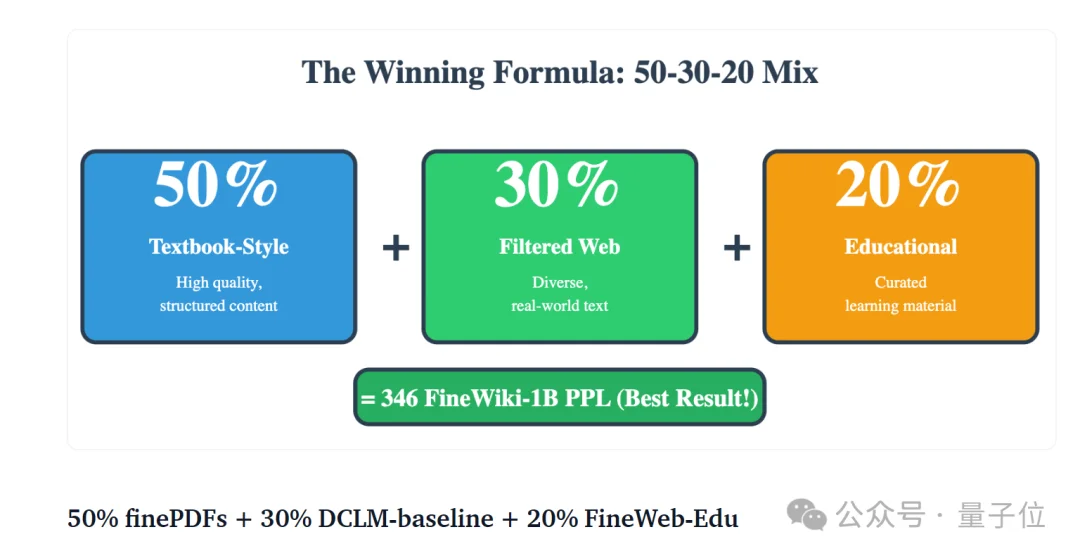

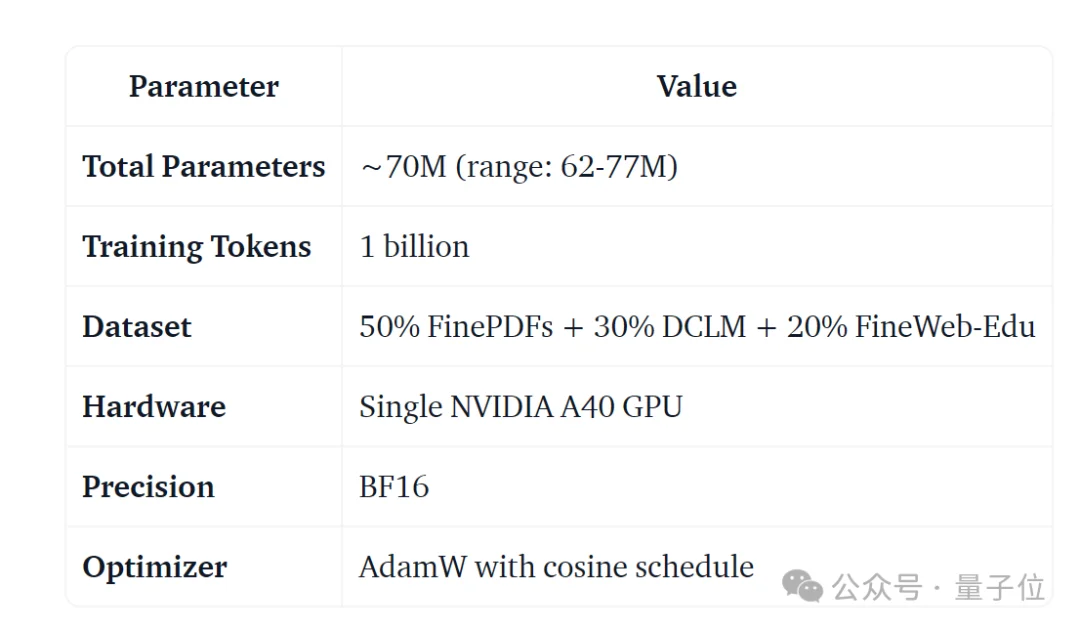

「50% FinePDFs+30% DCLM+20% FineWeb-Edu」是训练小模型GPT-2的最佳数据集组合,使用标准的12层架构,其平均准确率可以达到38.50%。

于是他们想接着探讨:模型架构是否和数据组成一样重要?

标准的GPT-2使用12层和768隐藏维度。但这设计于2019年,适用于约1.24亿参数。对于一个用10亿tokens训练的70M参数模型,这仍然是最优的吗?

为了弄清这个问题,他们着手开始了一系列实验。

实验第一步——确保除了模型架构,其他因素保持一致,包括模型参数、训练数据、训练时间和硬件配置等。

然后通过改变7种GPT-2变体的“形状”(即深度和宽度的变化),来对比同一架构内不同“深度-宽度配比”对性能的影响。

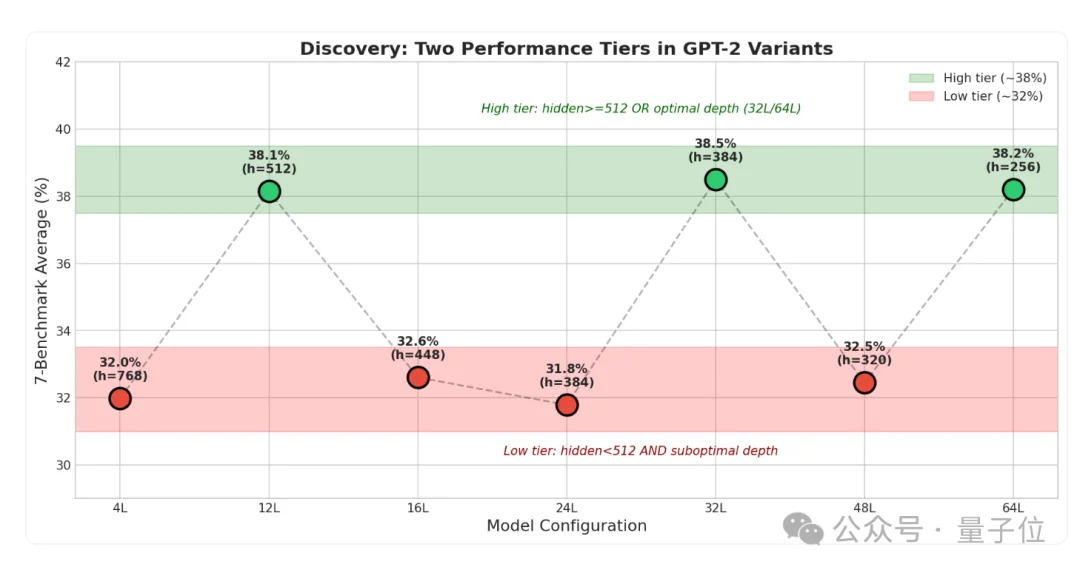

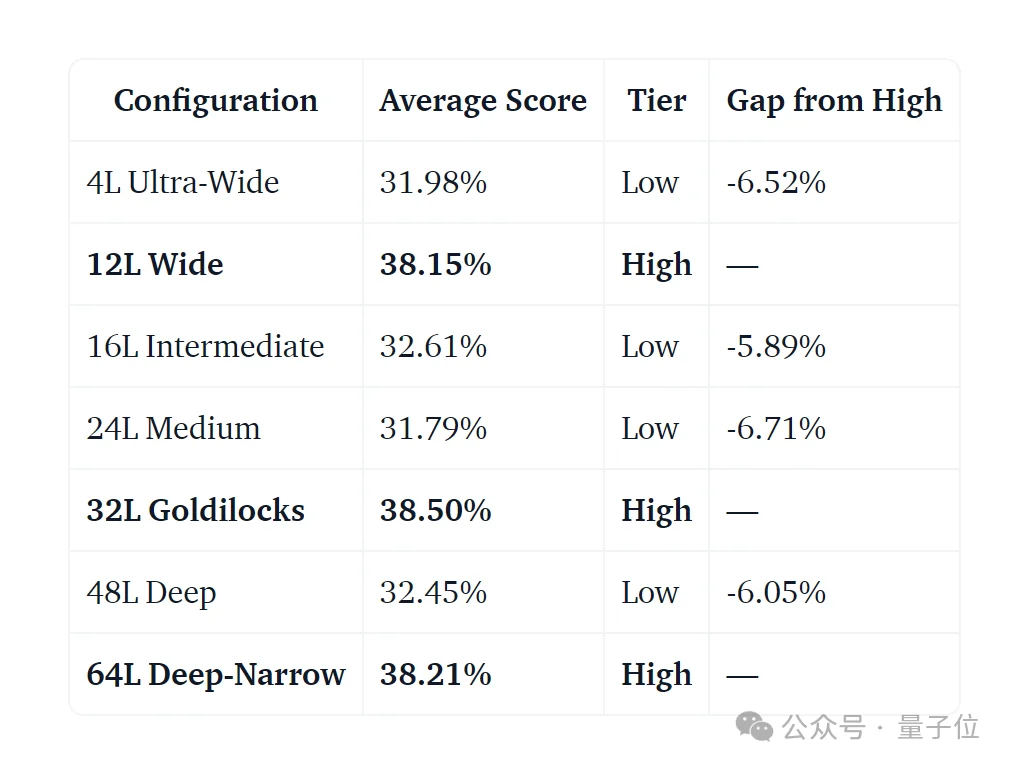

结果发现,从4层→64层,模型性能并未如预想那般,随着层数增加或减少而平滑变化,而是清晰分裂成了两个阵营:

作者表示,两个层级之间平均相差超过6个百分点,且每个层级内部的差异极小(约0.5%),出现了明显的两极分化。

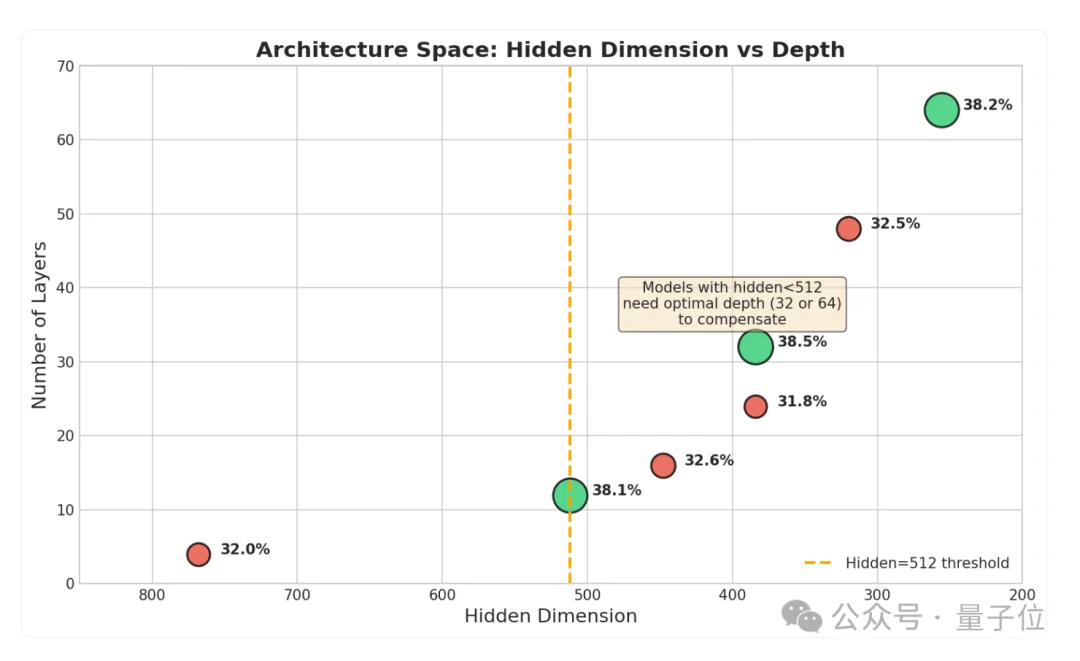

进一步分析表明,这一现象背后的关键因素是隐藏维度(hidden dimension)。

隐藏维度可理解为神经网络的宽度,每个词经由模型转换后都会变成一个数字列表。假设“人工智能”这个词的隐藏维度是768,它就代表这个词在模型内部会被表示成一个由768个数字构成的向量。

作者发现,模型的“隐藏维度”必须大于等于512,这是一个基础门槛。

当模型处于12层时,其隐藏维度恰好为512,所以表现出色。

至于宽度更窄的32层和64层模型也能成为“优等生”的原因,主要是它们通过特殊的深度配置进行了“补偿”——

前者属于“黄金补偿点”,在宽度为384的情况下,32层这个特定的深度能最高效地弥补宽度的不足,取得了所有配置中的最高分;而后者属于“暴力补偿”,虽然宽度只有256,但凭借极深的层数强行拉高了性能。

16L、24L和48L处于“死角”,它们的隐藏维度太窄,深度又不在可以弥补的最佳位置。

由此,作者也总结出了一套规则——

模型要想性能好,必须满足三种条件之一。1)隐藏维度大于等于512;2)正好处于32层;3)位于64层以上的极深层,以进行补偿。

而且必须再次提醒,32层属于全场最佳。当隐藏维度=384时,32层配置获得了38.50%的最佳总体得分,甚至略胜于标准的12层设计。

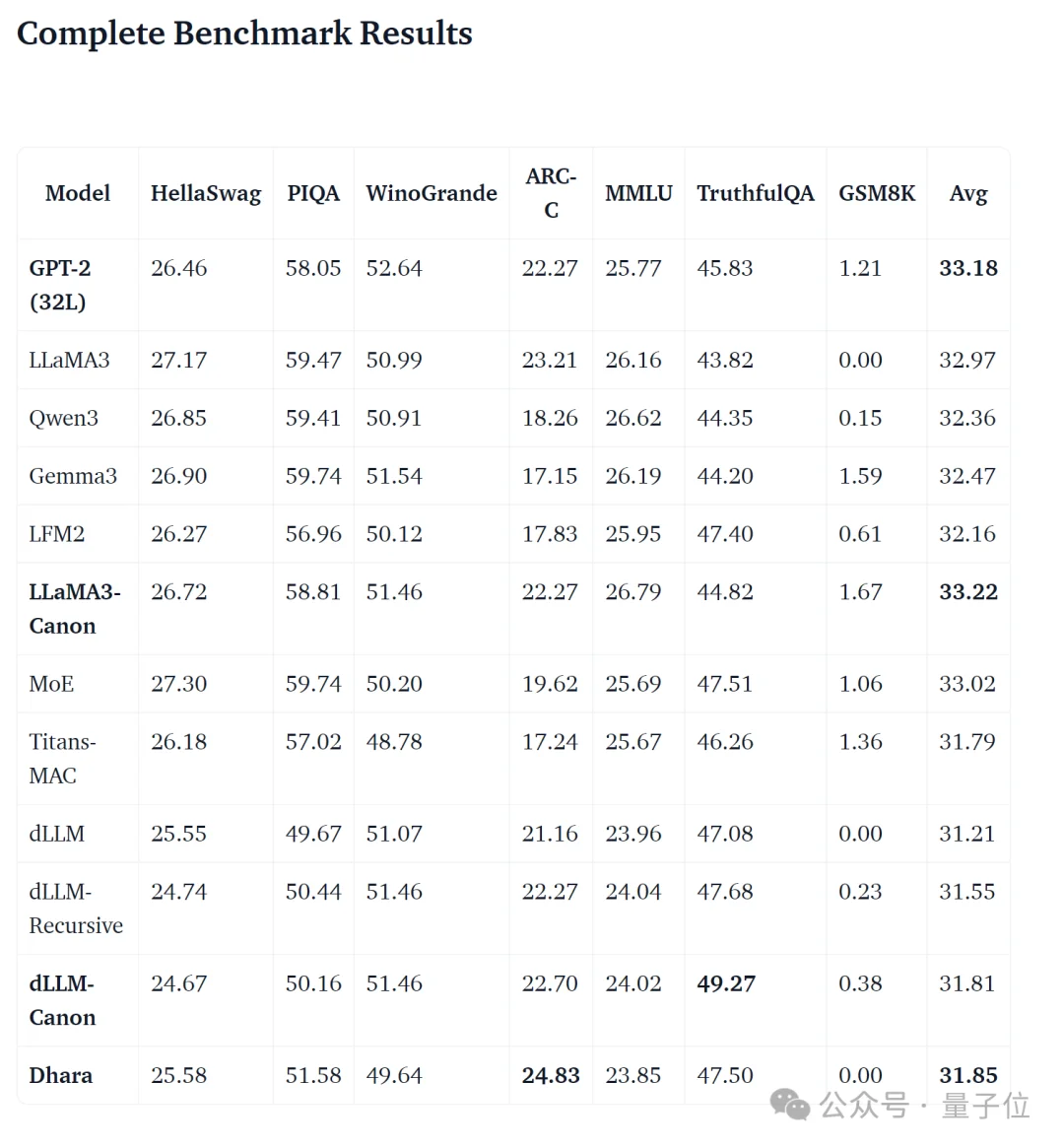

在确定了“32层”这个最佳深度后,作者又比较了12种不同架构的表现,包括LLaMA3、Qwen3、Gemma3等模型。

结果发现,在70M模型范围内,所有现代架构的表现都惊人地相似,平均差异不到2%。

作者表示,现代架构改进(RMSNorm、RoPE、GQA)是为70亿以上参数的模型设计的,在70M参数的情况下无法带来可衡量的优势。

完整测试结果be like:

这也意味着,对小模型来说,精心调整的“形状”可能比选择哪个具体的“架构变体”更重要。

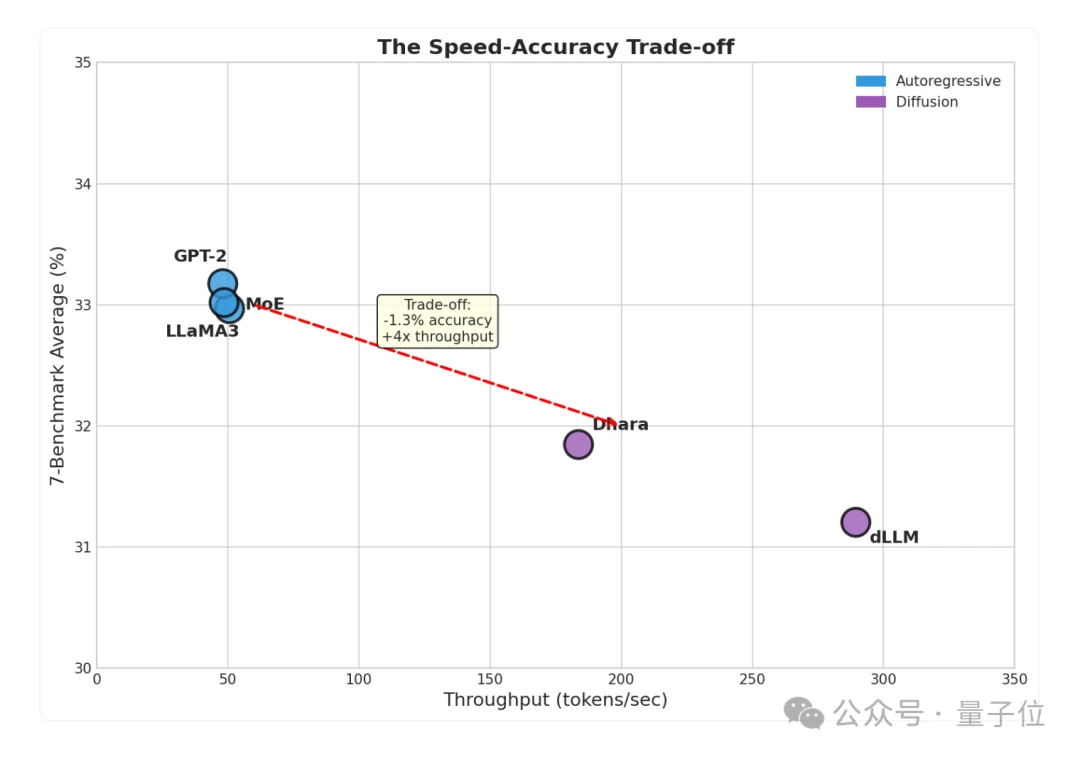

此外,虽然扩散模型的平均准确率略低于自回归模型,但研究认为这点“缺陷”完全可以通过其他方面弥补。

这主要体现在两大方面:推理速度和幻觉率。

和传统自回归模型相比,扩散模型的推理速度要快上3.8倍,非常适合处理批量任务。

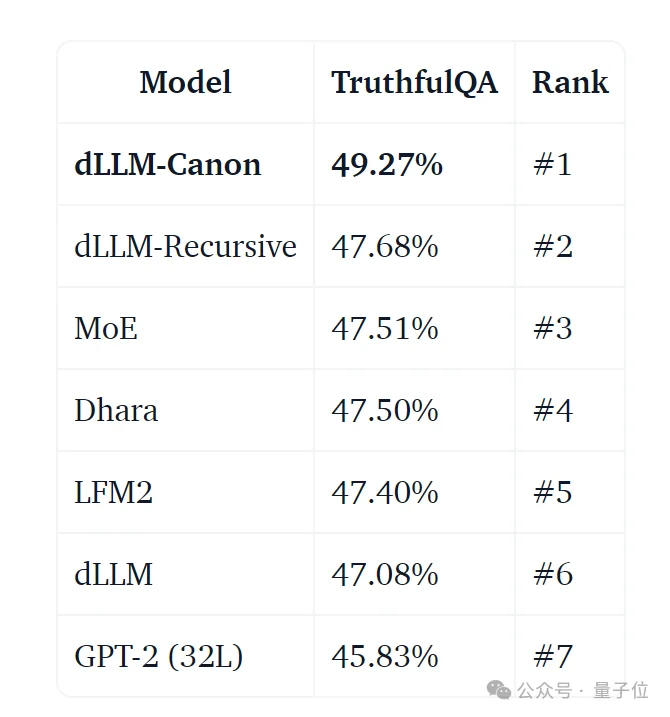

且在所有测试架构中,扩散模型在衡量真实性的TruthfulQA基准上得分最高(达49.27%),表明其“幻觉”更少。

作者还顺带解释了这背后的原因,核心有三个:

不过,无论是自回归还是扩散模型,都可以用一个小技巧来增加事实准确性——

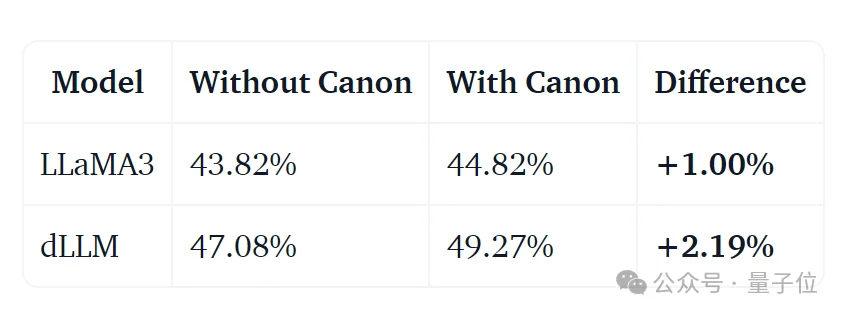

作者表示,通过在模型里加入一种叫“Canon层”的特殊结构(本质是一种精心设计的卷积层),普通模型能让事实性得分提升1%,扩散模型效果更明显,能提升超过2%。

而且增加的“Canon层”仅增加了0.13%的参数开销,性价比极高。

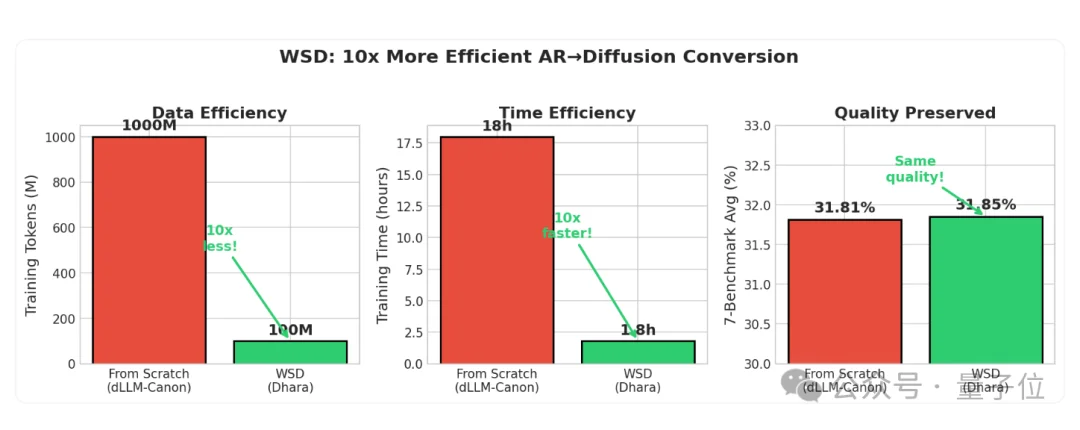

而更更重要的是,通过使用LLaDA 2.0论文中的Warmup-Stable-Decay方法,可以将现有的自回归模型高效转换为扩散模型。

划重点,需要的数据量、成本、训练时间通通仅为原来的1/10。而且作者发现:

WSD转换不仅与从头训练的结果相当,而且在几项基准测试上超越了后者。

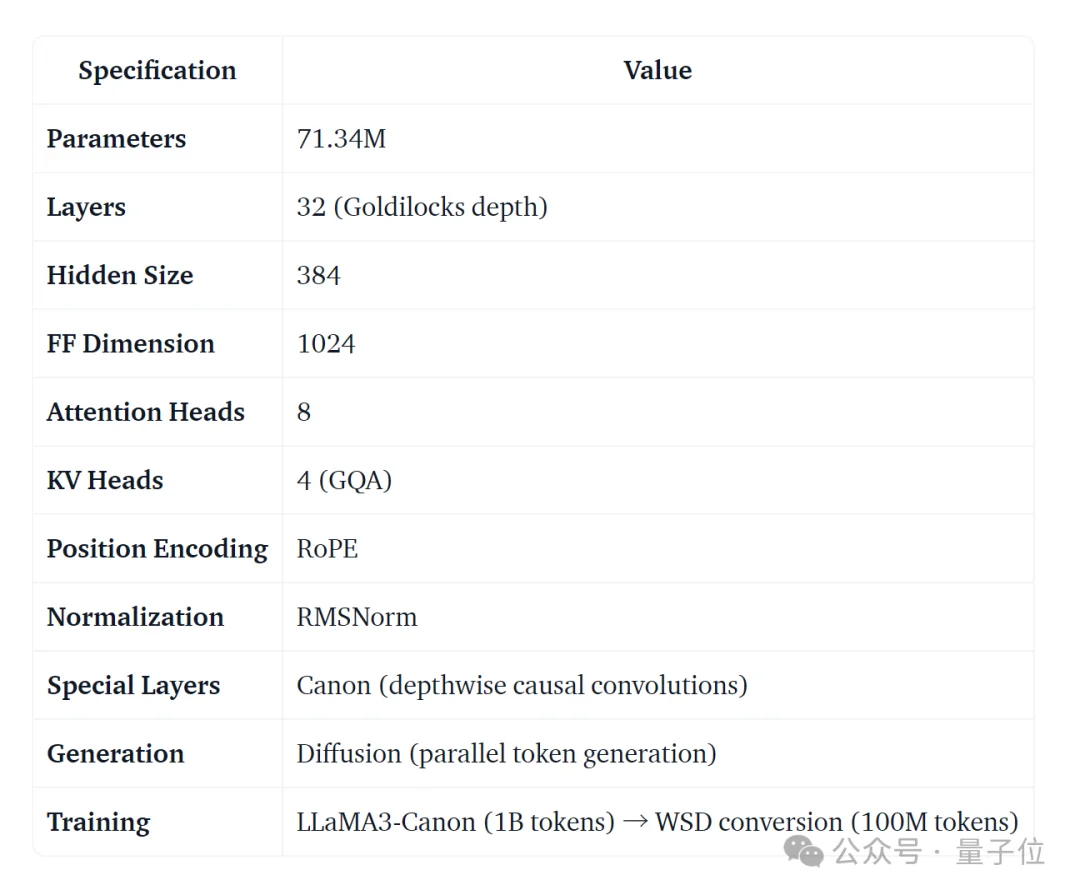

基于所有发现,作者和团队最后推出了Dhara-70M这个模型。

其构建方法为:首先采用最佳的自回归架构(LLaMA3-Canon),然后使用WSD方法将其转换为扩散模型。

如此一来,Dhara-70M也就具备了两者的优势——

既有自回归模型的知识储备,又有扩散模型带来的吞吐量和事实性优势。

作者表示,这项工作最大的意义或许在于提醒大家——

对于资源有限的小语言模型构建者,不应盲目追求最新的架构魔法。首先应关注基础的“深度-宽度配比”,确保模型不落入“死亡区域”;其次,如果应用场景需要高速处理且对事实准确性要求高,那么扩散模型是一个极具竞争力的选择。

Dhara-70M开源地址:

https://huggingface.co/codelion/dhara-70m

参考链接:

https://huggingface.co/blog/codelion/optimal-model-architecture

文章来自于“量子位”,作者 “一水”。

【开源免费】graphrag是微软推出的RAG项目,与传统的通过 RAG 方法使用向量相似性作为搜索技术不同,GraphRAG是使用知识图谱在推理复杂信息时大幅提高问答性能。

项目地址:https://github.com/microsoft/graphrag

【开源免费】Dify是最早一批实现RAG,Agent,模型管理等一站式AI开发的工具平台,并且项目方一直持续维护。其中在任务编排方面相对领先对手,可以帮助研发实现像字节扣子那样的功能。

项目地址:https://github.com/langgenius/dify

【开源免费】RAGFlow是和Dify类似的开源项目,该项目在大文件解析方面做的更出色,拓展编排方面相对弱一些。

项目地址:https://github.com/infiniflow/ragflow/tree/main

【开源免费】phidata是一个可以实现将数据转化成向量存储,并通过AI实现RAG功能的项目

项目地址:https://github.com/phidatahq/phidata

【开源免费】TaskingAI 是一个提供RAG,Agent,大模型管理等AI项目开发的工具平台,比LangChain更强大的中间件AI平台工具。

项目地址:https://github.com/TaskingAI/TaskingAI