https://www.techrxiv.org/doi/full/10.36227/techrxiv.176153394.41323502

https://dexforce.com/embodichain/index.html#/

https://github.com/DexForce/EmbodiChain

https://dexforce.github.io/EmbodiChain/introduction.html

大语言模型的爆发,让大家见证了 Scaling Law 的威力:只要数据够多、算力够猛,智能似乎就会自动涌现。但在机器人领域,这个公式似乎失效了。

不同于互联网上唾手可得的万亿级文本,机器人所需的、经过 3D 标定且符合物理规律的高质量交互数据,极度稀缺且昂贵。正因如此,数据采集范式成为了近年来行业研究的绝对焦点。

可以看到,整个行业正在向着更低成本、更便捷的方向全速推进: 从昂贵的遥操设备,到基于动捕手套的灵巧手捕捉和更加便携式的夹爪方案,再到如今甚至不再需要佩戴手套、仅凭双手演示即可采集数据的创新方案。这些轻量化的数采范式正在将人类的经验数字化,这一路径不仅充满价值,更值得持续深耕,它是连接人类技能与机器人动作的桥梁。

整个行业在将具身智能推向大模型时代的这个目标上狂奔。

但是,即使是最极致的采集效率,客观上仍受限于物理时间的流逝和人力成本的边界。当下没有任何现有的物理采集范式,能匹配 LLM 训练所需的「互联网级」规模。这成为了具身智能迈向更高阶智能的最大桎梏。

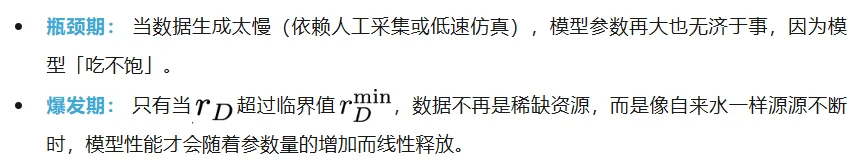

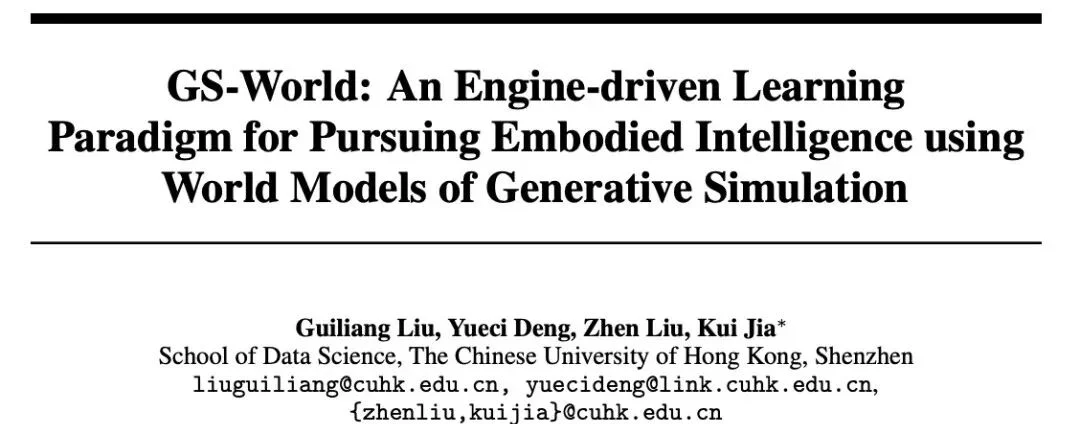

这正是跨维智能团队在论文《GS-World》中提出的核心洞察:智能的进化存在一个「逃逸速度」。

效率定律 (Efficiency Law) 下模型性能与数据生成速率的关系

要跨越这个鸿沟,除了物理采集的持续精进,另一种极具潜力的解决方式,就是构建一个能够超高速、自动化生成物理现实的数字世界(跨维智能团队在《GS-World》中详述了这一路径)。

在这个基于物理引擎的生成式世界中,数据的生成速率超越了时间的限制(Efficiency Law);机器人可以在零成本的试错中习得对物理因果的深刻理解;所有的边缘情况(Corner Cases)都可以在这里被模拟、被攻克。

今天,跨维智能正式开源 EmbodiChain。作为通往 GS-World(基于生成式仿真的世界模型) 的基石,EmbodiChain 不仅仅是一个数据和模型平台,更是一次对具身智能学习范式的重构。

跨维团队提出并验证一个大胆的假设:仅凭 100% 的生成式仿真数据,只要生成速率(Rate of Generation)突破临界点,机器人就能在真实世界中涌现出超越 SOTA 的泛化能力。

这不是科幻,这就是跨维正在验证的效率定律(Efficiency Law)。

然而,要将 GS-World 从蓝图变为现实,绝非易事。跨维研究团队必须面对并攻克三个核心科学难题,这也是 EmbodiChain 致力于解决的关键:

1.如何实现数据生产自动化?

真实世界极其复杂,如何仅凭少量先验(如一段视频、一句描述),就在数字世界中自动重建、生成海量且物理一致的场景与任务,而无需人工手动搭建?

2.如何打破「虚实鸿沟」(Sim2Real Gap)?

仿真数据再多,如果不能迁移到真机也是徒劳。如何在不依赖或尽量少依赖真实数据微调的情况下,让模型习得适应真实世界噪声与动态变化的鲁棒策略?

3.如何突破数据生成的「IO 墙」?

Scaling 需要亿级甚至十亿级的交互步数。传统的「生成 - 存储 - 读取 - 训练」模式效率极低。如何构建极致高效的数据流转机制,实现「在线数据流」?

为了实现这一愿景,跨维智能构建了 GS-World(Generative Simulation World Model,生成式仿真世界模型) 的核心基石 ——EmbodiChain。

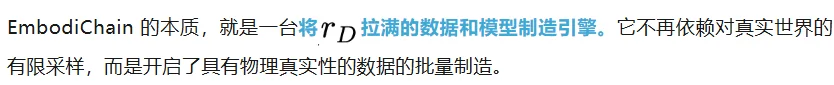

EmbodiChain 作为一个底层的基建技术,可以把它看作去存储化的数字化流水线。Scaling 需要亿级甚至十亿级的交互步数,传统的「生成 - 存储 - 读取 - 训练」模式在面对海量 3D 数据时,存储与传输将成为不可承受之重。

在 EmbodiChain 的架构中,可以彻底抛弃「先存硬盘、再读硬盘」的陈旧范式,取而代之的是在线数据流(Online Data Streaming)和模型自动生产线。

EmbodiChain 的核心工作流。数据在生成的同时即被消费,橘色的数据流贯穿全场,无需落地存储。

这条流水线是如何工作的?

这一切都在 GPU 内部并行高速运转,数据如洪流般产生,训练完即销毁,不留下一丝冗余,只留下模型能力的增长。

在通往具身智能世界模型的路上,目前存在两条截然不同的路线。

一条是近期火热的视频生成路线(Video World Model),如 Sora 或 LTX-Video,它们试图通过「画出」下一帧来模拟世界。虽然视觉效果惊艳,但一些对比实验揭示了其致命弱点:幻觉。

视频模型生成的画面往往缺乏长程的时空一致性,且很难精确遵循动力学方程。用这种「做梦」产生的数据训练机器人,就像让一个飞行员在爱丽丝的仙境中学习开飞机 —— 看着很美,一上真机就坠毁。

相反,EmbodiChain 选择的是 GS-World 路线(基于生成式仿真的世界模型)。

这正是 Yann LeCun 所倡导的理念:世界模型应该是对世界状态的预测与规划。

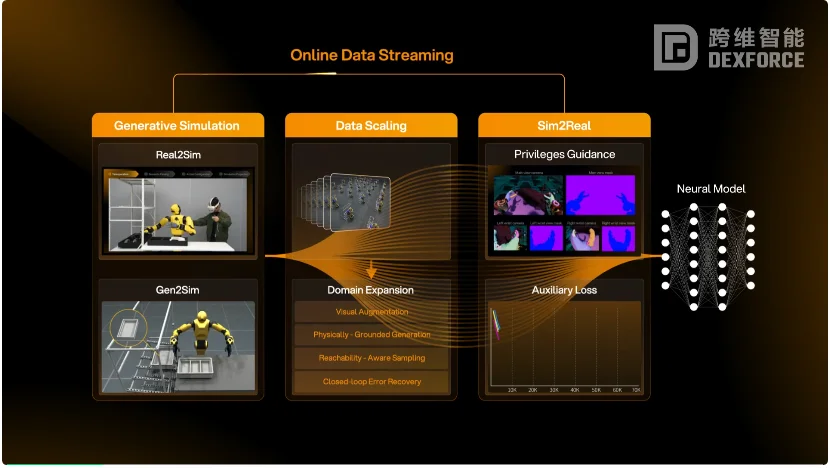

EmbodiChain中可以获取的特权信息示例

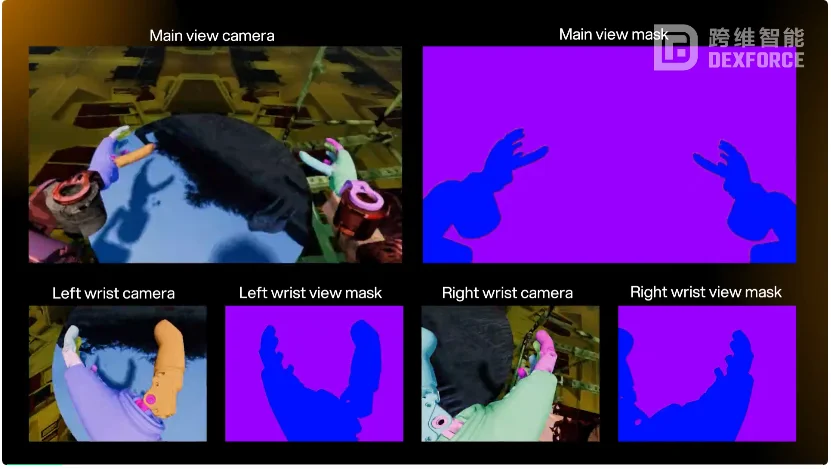

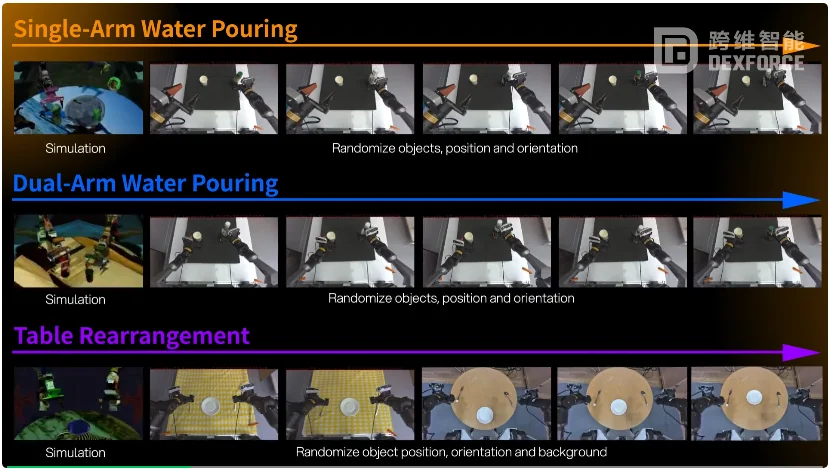

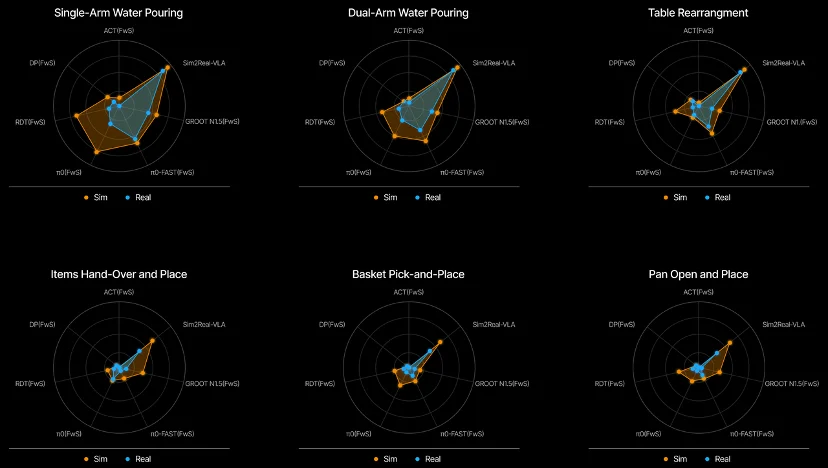

为了验证这套「效率定律」,跨维智能做了一件极端的测试:不使用任何真实数据训练模型。

跨维智能训练出的 Sim2Real-VLA 模型,在真实世界中执行任务。结果令人惊讶:

Sim2Real-VLA 在全生成数据训练下,不仅击败了 SOTA,更展现了惊人的鲁棒性。

EmbodiChain 的开源,只是一个开始。

GS-World 蓝图远不止于此。在跨维智能的规划中,这是一个引擎驱动的闭环路径(Engine-driven Loop):

跨维智能希望 EmbodiChain 能成为每一位具身智能研究者的基础设施。不需要再为了几千条数据而在实验室里没日没夜地遥操作,不需要再为几十 TB 的硬盘存储发愁。

因为智能的未来,不应该被困在数据的匮乏中。

EmbodiChain 现已开源,邀请你一起见证具身智能的「效率奇点」。

文章来自于“机器之心”,作者 “机器之心”。

【开源免费】字节工作流产品扣子两大核心业务:Coze Studio(扣子开发平台)和 Coze Loop(扣子罗盘)全面开源,而且采用的是 Apache 2.0 许可证,支持商用!

项目地址:https://github.com/coze-dev/coze-studio

【开源免费】n8n是一个可以自定义工作流的AI项目,它提供了200个工作节点来帮助用户实现工作流的编排。

项目地址:https://github.com/n8n-io/n8n

在线使用:https://n8n.io/(付费)

【开源免费】DB-GPT是一个AI原生数据应用开发框架,它提供开发多模型管理(SMMF)、Text2SQL效果优化、RAG框架以及优化、Multi-Agents框架协作、AWEL(智能体工作流编排)等多种技术能力,让围绕数据库构建大模型应用更简单、更方便。

项目地址:https://github.com/eosphoros-ai/DB-GPT?tab=readme-ov-file

【开源免费】VectorVein是一个不需要任何编程基础,任何人都能用的AI工作流编辑工具。你可以将复杂的工作分解成多个步骤,并通过VectorVein固定并让AI依次完成。VectorVein是字节coze的平替产品。

项目地址:https://github.com/AndersonBY/vector-vein?tab=readme-ov-file

在线使用:https://vectorvein.ai/(付费)

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner