在计算机科学领域,图形结构由节点(代表实体)和边(表示实体之间的关系)构成。

图无处不在。

互联网本身就像是一张庞大的网络图,甚至搜索引擎所使用的知识也是以图的形式进行组织和呈现。

但由于LLMs主要在常规文本上训练,并没有图的结构,将图转化为LLMs能理解的文本是一项非常复杂的任务。

在ICLR 2024上,一支来自谷歌的团队探索了如何将图形数据转换为适合LLMs理解的形式。

他们还创造了一个名为GraphQA的基准,用于研究不同的图推理问题解决方法,并演示了如何以一种让LLM能够解决图形相关问题的方式来表述图相关问题。

使用正确的方法,使得LLMs在图形任务上最高得以提升60%的性能。

首先,谷歌团队设计了GraphQA基准测试,它可以被看作是一门考试,旨在评估LLM针对特定于图形问题的能力。

GraphOA通过使用多种类型的图表,确保广度和连接数量的多样性,以寻找LLMs在处理图形时可能存在的偏差情况,并使整个过程更接近LLMs在实际应用中可能遇到的情况。

虽然任务很简单,比如检查边是否存在、计算节点或者边的数量等等,但这些任务都需要LLMs理解节点和边之间的关系,对于更复杂的图形推理至关重要。

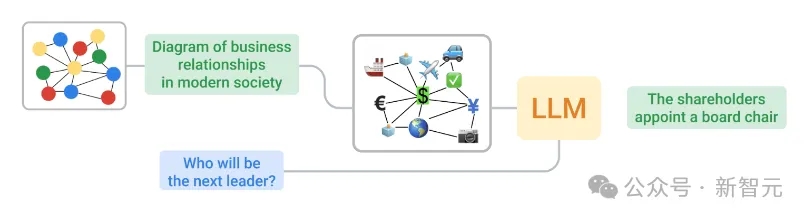

同时,团队还探索了如何将图转换为LLMs可以处理的文本,比如解决了如下两个关键问题:

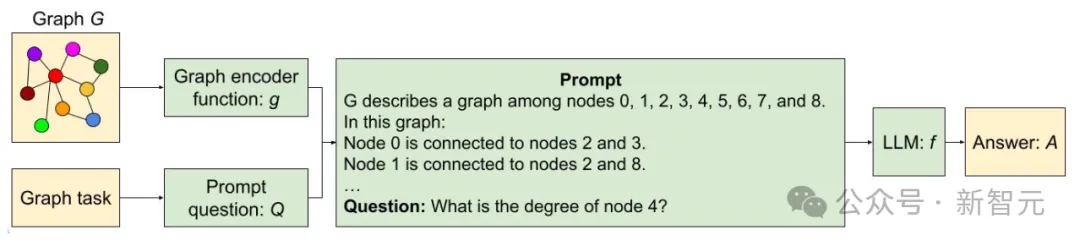

节点编码:我们如何表示单个节点?节点可以包括简单整数、常用名称(人名、字符)和字母。

边缘编码:我们如何描述节点之间的关系?方法可以包括括号符号、短语(如「是朋友」)和符号表示(如箭头)。

最终,研究人员通过系统地结合各种节点和边的编码方式,产生了像下图中展示的那些函数。

LLMs表现怎么样呢?

研究团队在GraphOA上进行了三个关键实验:

在第一个实验中,LLMs表现平平,在大多数基本任务上,LLMs的表现并不比随机猜测好多少。

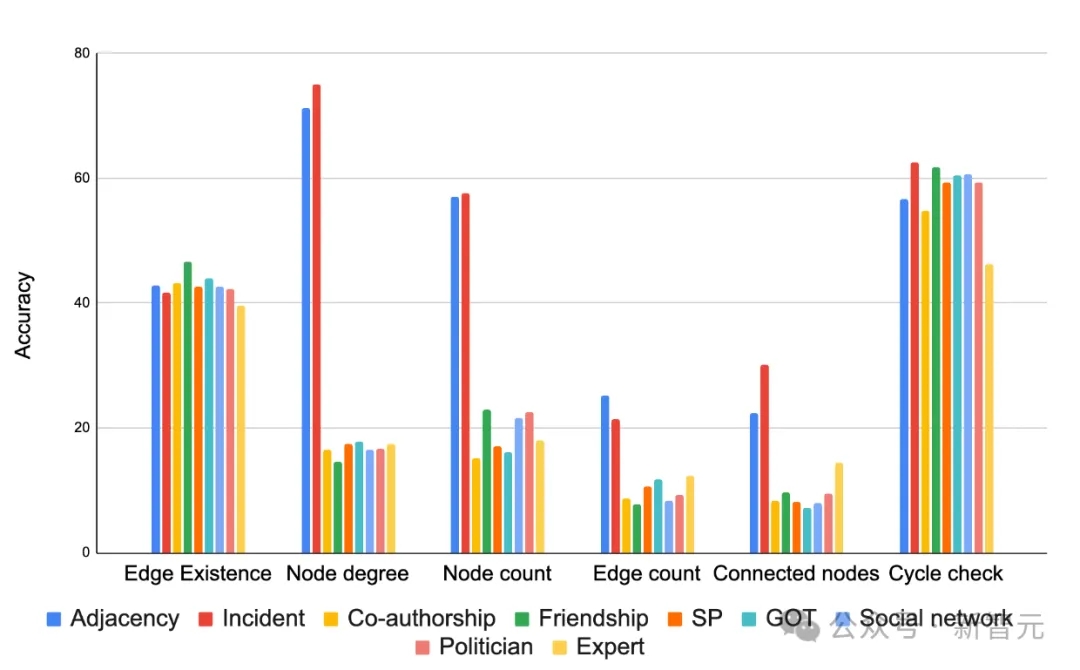

但编码方式显著影响结果,如下图所示,在大多数情况下,「incident」编码在大多数任务中表现出色。选择合适的编码函数可以极大的提高任务的准确度。

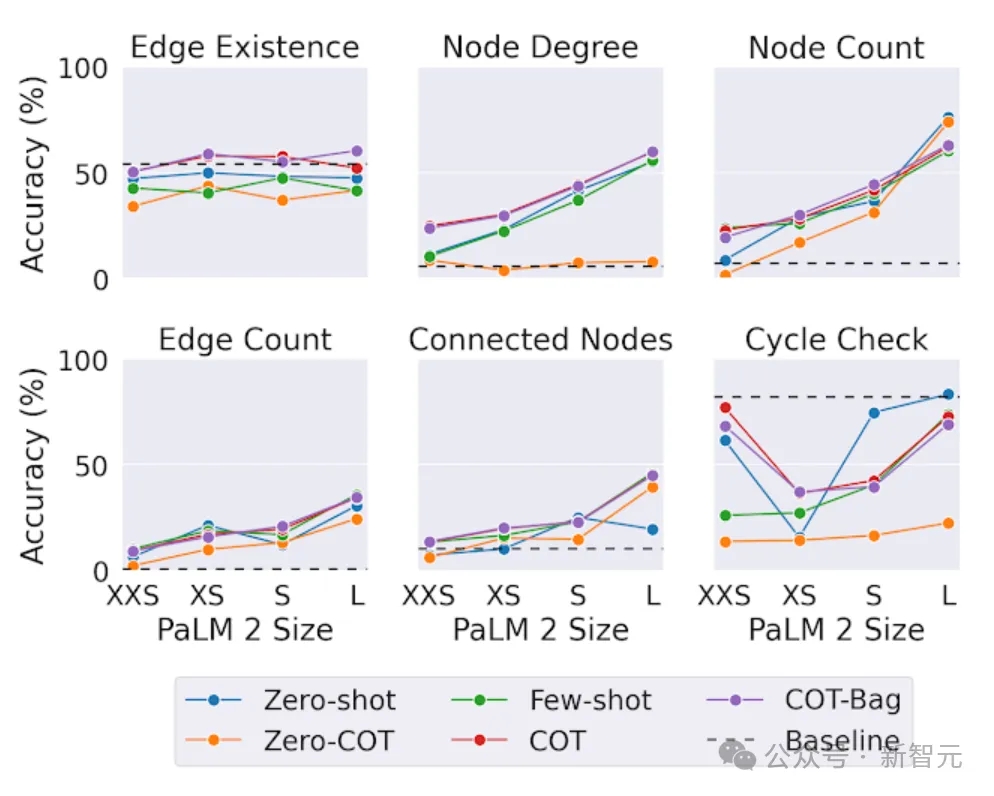

在第二个测试中,研究人员在不同大小的模型上测试了相同的图形任务。

就结论而言,在图形推理任务中,规模更大的模型表现更好,

然而有趣的是,在「边存在性」任务(确定图中两个节点是否相连)中,规模并不像其他任务那么重要。

即使是最大的LLM在循环检查问题上(确定图中是否存在循环)也无法始终击败简单的基线解决方案。这表明LLMs在某些图任务上仍有改进的空间。

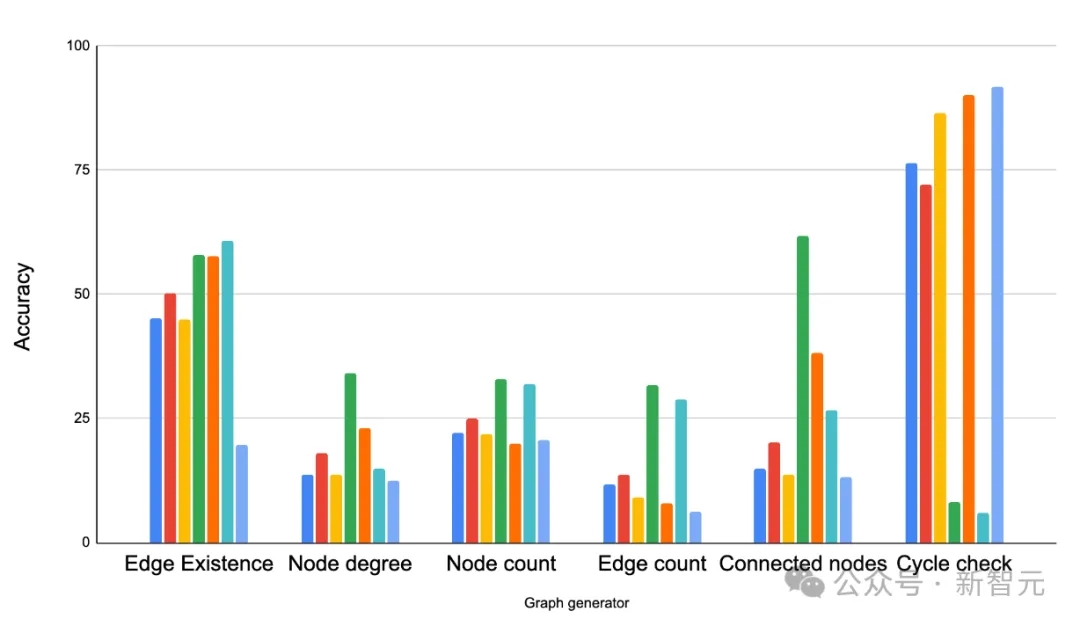

在第三个测试中,对于图形结构是否会影响LMMs解决问题的能力,研究人员通过GraphOA生成不同结构的图形进行分析。

结果得出,图的结构对LLMs的性能有很大影响。

例如,在一个询问循环是否存在的任务中,LLMs在紧密相连的图形中表现出色(这里循环很常见),但在路径图中表现不佳(循环从不发生)。

但同时提供一些混合样本有助于LLMs适应,比如在循环检测任务中,研究人员在提示中添加了一些包含循环和一些不包含循环的示例作为少样本学习的例子,通过这种方式提高了LLMs的性能。

在不同的图任务上比较不同的图生成器。主要观察结果是,图结构对LLM的性能有显著影响。ER、BA、SBM和SFN分别指的是Erdős-Rényi、Barabási-Albert、随机块模型和无标度网络。

这仅仅是让LLMs理解图的开始

在论文中,谷歌团队初步探索了如何将图形最佳地表示为文本,以便LLMs能理解他们。

在正确编码技术的帮助下,显著提高了LLMs在图形问题上的准确性(从大约5%到超过60%的改进)。

同时也确定了三个主要的影响因子,分别为图形转换为文本的编码方式、不同图形的任务类型、以及图形的疏密结构。

这仅仅是让LLMs理解图的开始。在新基准测试GraphQA的帮助下,期待进一步研究,探索LLMs的更多可能性。

本文来源于公众号新智元,作者Mindy

【免费】cursor-auto-free是一个能够让你无限免费使用cursor的项目。该项目通过cloudflare进行托管实现,请参考教程进行配置。

视频教程:https://www.bilibili.com/video/BV1WTKge6E7u/

项目地址:https://github.com/chengazhen/cursor-auto-free?tab=readme-ov-file

【开源免费】MindSearch是一个模仿人类思考方式的AI搜索引擎框架,其性能可与 Perplexity和ChatGPT-Web相媲美。

项目地址:https://github.com/InternLM/MindSearch

在线使用:https://mindsearch.openxlab.org.cn/

【开源免费】Morphic是一个由AI驱动的搜索引擎。该项目开源免费,搜索结果包含文本,图片,视频等各种AI搜索所需要的必备功能。相对于其他开源AI搜索项目,测试搜索结果最好。

项目地址:https://github.com/miurla/morphic/tree/main

在线使用:https://www.morphic.sh/