Grok-1官宣开源不过半月,新升级的Grok-1.5出炉了。

刚刚,马斯克xAI官宣,128K上下文Grok-1.5,推理能力大幅提升。

并且,很快就会上线。

11天前,Grok-1模型的权重和架构开源,展示了Xai在去年11月之前取得的进展。

Grok-1有3140亿参数,是Llama 2的4倍大,而且采用的是MoE架构,8个专家中2个是活跃专家。

Xai介绍,也就是从那时起,团队改进了最新模型Grok-1.5的推理和解决问题的能力。

OpenAI前开发者关系负责人表示,从xAI重大发布的时间可以看出他们前进的步伐和紧迫感。令人振奋!

根据官方介绍,Grok-1.5改进了推理能力,上下文长度为128K。

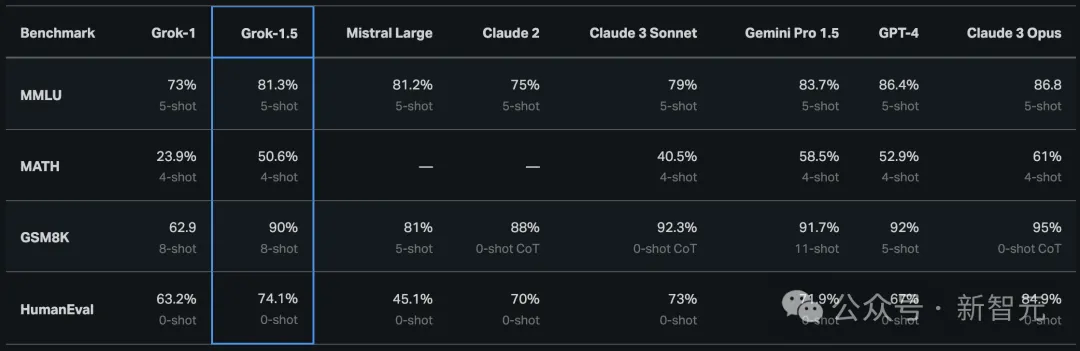

Grok-1.5最显著的改进之一是,它在编码和数学相关任务中的表现。

在测试中,Grok-1.5在数学基准上取得50.6%的得分,在GSM8K基准上获得了90%,这两个数学基准涵盖了从小学到高中的各种竞赛问题。

此外,在评估代码生成和解决问题能力的HumanEval基准测试中,Grok-1.5获得了74.1%的高分。

从下图中,与Grok-1相比,可以看出Grok-1.5在数学方面的能力得到大幅提升,GSM8K上从62.9%改进到90,MATH上从23.9%提升到50.6%。

128K长语境理解,扩增16倍

Grok-1.5另一全新特点是,能够在其上下文窗口内处理高达128K token的文本。

这使Grok的内存容量,增加到以前上下文长度的16倍,从而使它能够利用更长的文档中的信息。

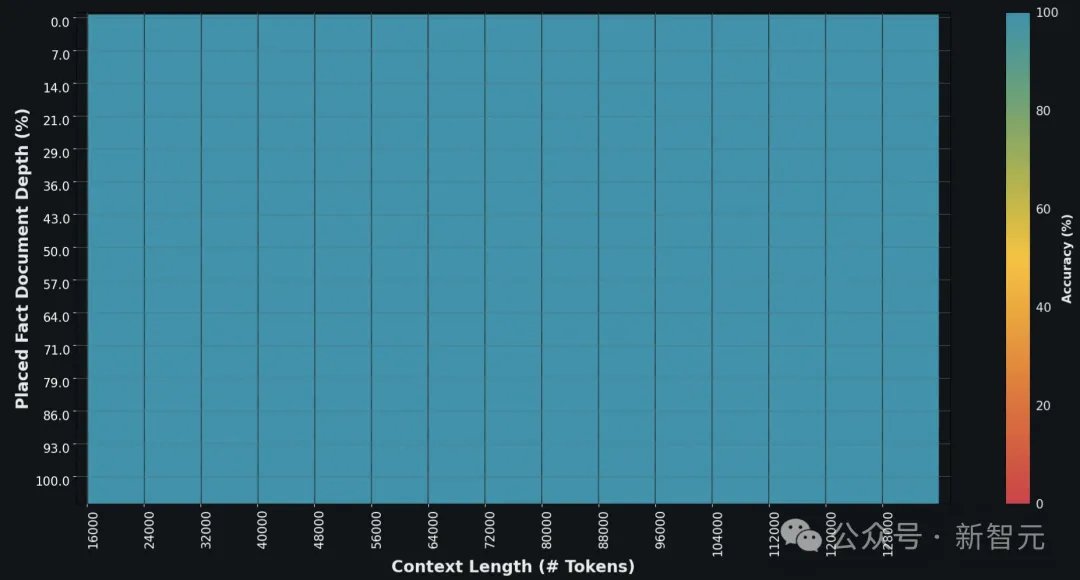

此外,新模型还可以处理更长和更复杂的提示,同时在其上下文窗口扩展时仍保持其指令跟随能力。

在Needle In A Haystack(NIAH)评估中,Grok-1.5 展示了强大的检索能力,可检索长度达 128K 字节的上下文中的嵌入文本,并取得了完美的检索结果。

Grok-1.5基础设施

Grok-1.5构建在基于JAX、Rust和Kubernetes的定制分布式训练框架之上。

这个训练堆栈可以让xAI团队能够以最少的投入,大规模构建创意,以及训练新的架构。

在大型计算群集上进行训练LLM的一个主要挑战是,最大限度地提高训练任务的可靠性和正常运行时间。

xAI定制的训练编排器,可确保自动检测有问题的节点,并将其从训练任务剔除。

与此同时,他们还优化了检查点、数据加载和训练任务的重启,以最大限度地减少发生故障时的停机时间。

xAI表示,Grok-1.5将很快提供给早期测试者,以帮助改进模型。

博客还预告了Grok-1.5将在未来几天里推出几个新功能。

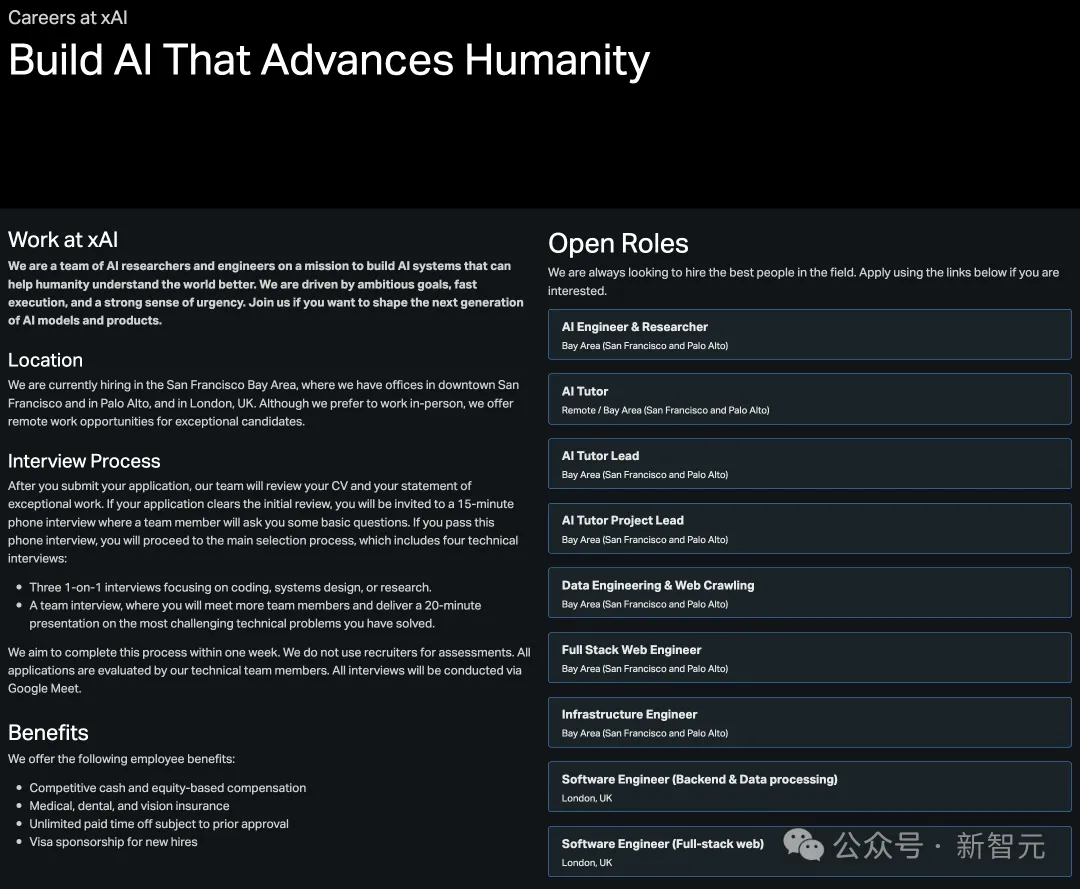

最后,xAI还是一如既往地po出了招募信息。

参考资料:

https://x.ai/blog/grok-1.5

文章来自微信公众号“新智元”,作者:新智元