LLM已经可以理解文本和图片了,也能够根据它们的历史知识回答各种问题,但它们或许对周围世界当前发生的事情一无所知。

现在LLMs也开始逐步学习理解3D物理空间,通过增强LLMs的「看到」世界的能力,人们可以开发新的应用,在更多场景去获取LLMs的帮助。

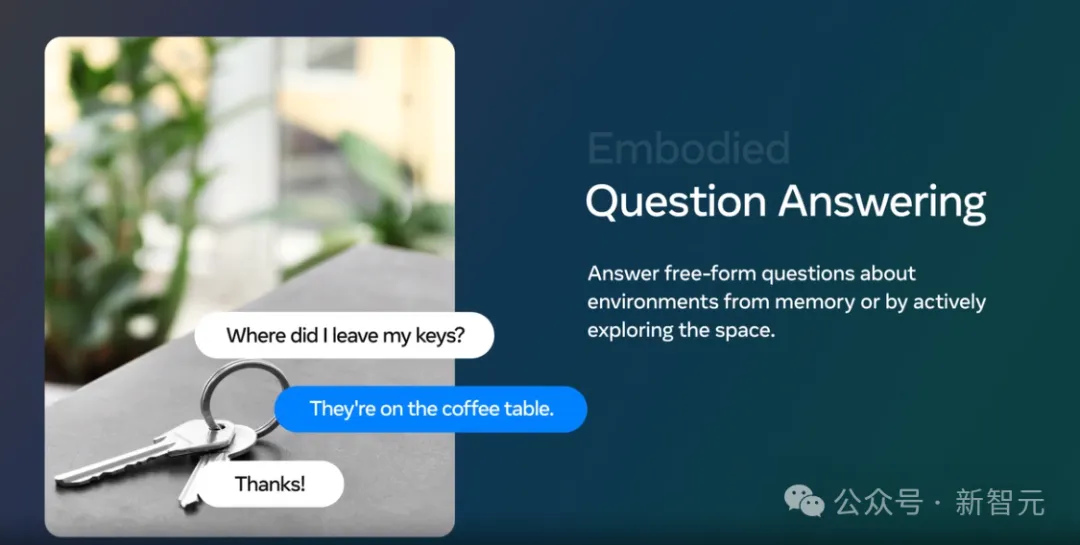

AI Agent,比如机器人或是智能眼镜,它们可以通过感知和理解环境来回答一些开放性问题,比如「我把钥匙放哪里了?」

这样的AI Agent需要利用视觉等感知模式来理解其周围环境,并能够用清晰的日常语言有效地与人交流。

这类似于构建一个「世界模型」,即AI Agent可以对外部世界产生它自己的内部理解方法,并能够让人类通过语言查询。

这是一个长期的愿景和一个有挑战的领域,也是实现人工通用智能的重要一步。

Meta的新研究OpenEQA(Embodied Question Answering)框架,即开放词汇体验问答框架,为我们探索这个领域提供了新的可能。

EQA是什么?

EQA(Embodied Question Answering)是一种工具,用于检查AI Agent是否真正理解周围世界发生的事情。

毕竟,当我们想要确定一个人对概念的理解程度时,我们会问他们问题,并根据他们的答案形成评估。我们也可以对实体AI Agent做同样的事情。

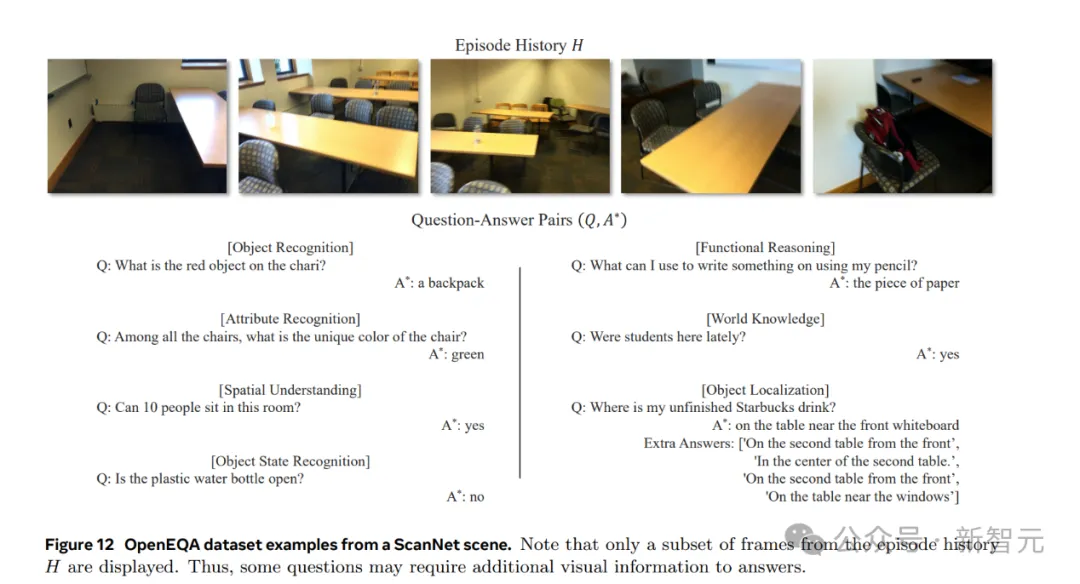

比如下图的一些问题实例:

[物体识别]

问:椅子上的红色物体是什么?

答:一个背包

[属性识别]

问:在所有的椅子中,这把椅子的独特颜色是什么?

答:绿色

[空间理解]

问:这个房间可以容纳10个人吗?

答:可以

[物体状态识别]

问:塑料水瓶是开着的吗?

答:不是

[功能推理]

问:我可以用铅笔在什么东西上写?

答:纸

[世界知识]

问:最近有学生在这里吗?

答:有

[物体定位]

问:我的未喝完的星巴克饮料在哪里?

答:在靠前的白板旁边的桌子上

除此之外,EQA也更加有直接的应用。

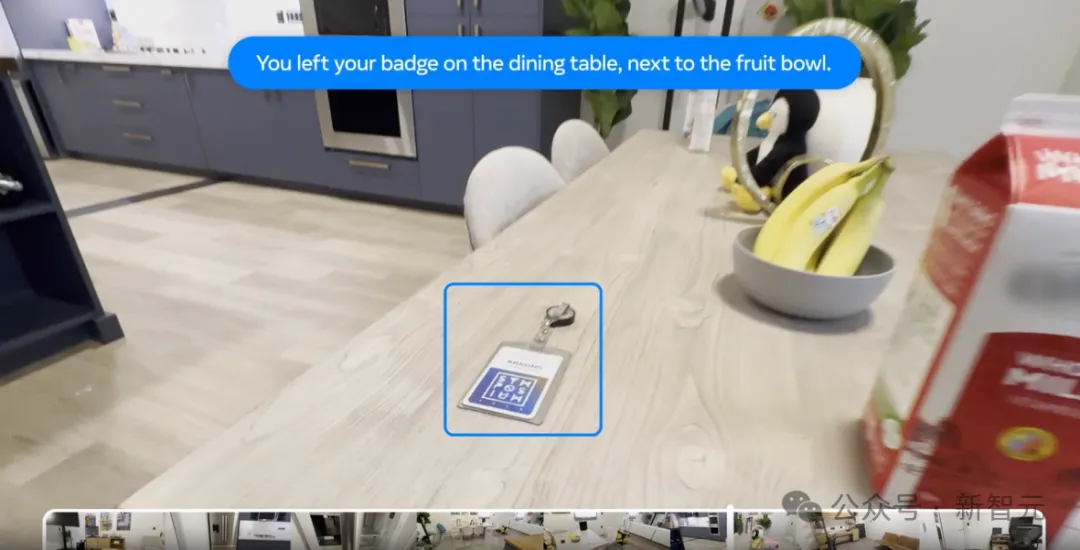

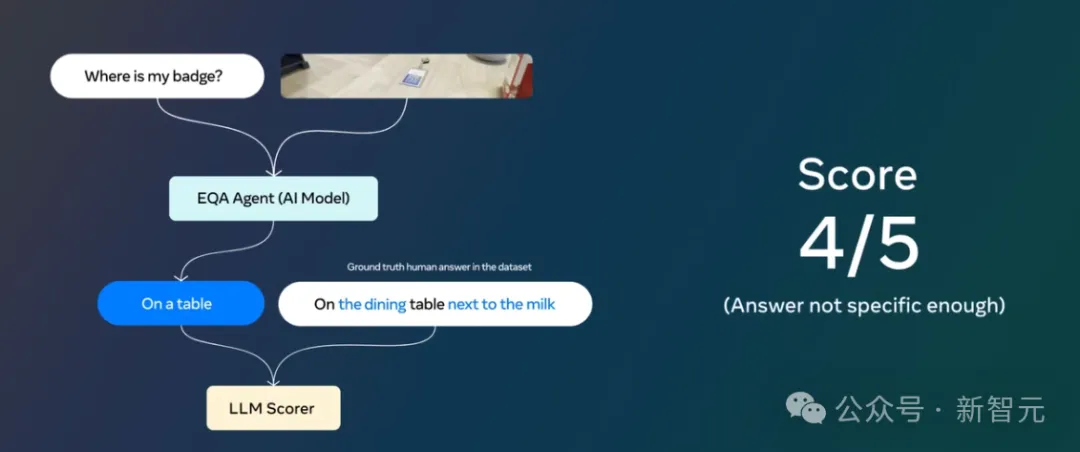

比如,当你准备出门却找不到工卡时,就就可以问智能眼镜它在哪里。而AI Agent则会通过利用其情节记忆回答说徽章在餐桌上。

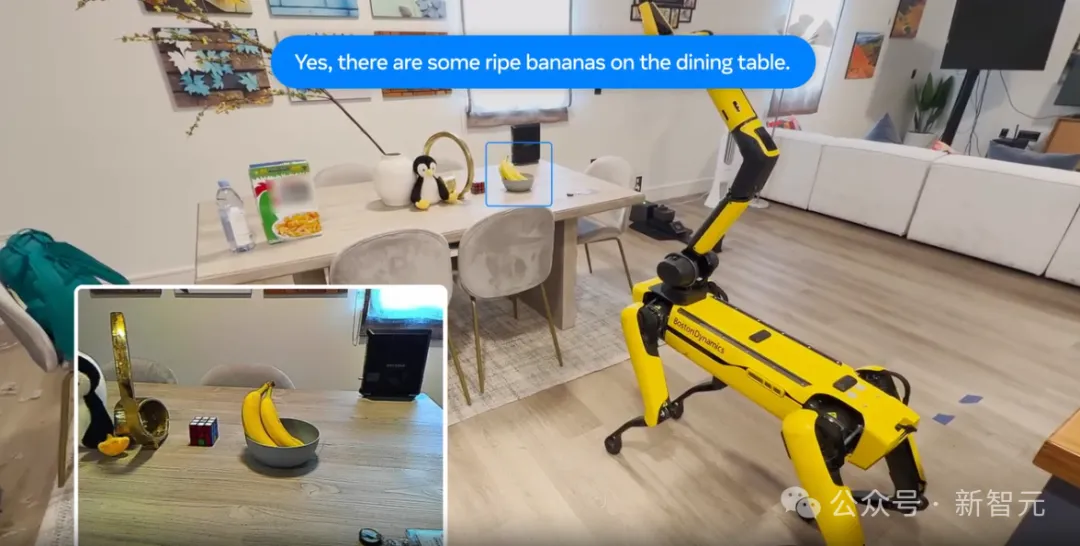

或者如果你在回家的路上饿了,就可以问家庭机器人是否还剩下水果。根据其对环境的主动探索,它可能会回答说水果篮里有成熟的香蕉。

这些行为看上去很简单,毕竟LLMs在许多人认为具有挑战性的任务中表现出色,比如通过SAT或律师考试。

但现实是,即使是今天最先进的模型,在EQA方面也很难达到人类的表现水平。

这也是为什么Meta同时发布了OpenEQA基准测试,让研究人员可以测试他们自己的模型,并了解它们与人类的表现相比如何。

OpenEQA:面向AI Agent的全新基准

开放词汇体验问答(OpenEQA)框架是一个新的基准测试,通过向AI Agent提出开放词汇问题来衡量其对环境的理解。

该基准包含超过1600个非模板化的问题和答案对,这些问题和答案来自人类注释者,代表了真实世界的使用情况,并提供了180多个物理环境的视频和扫描指针。

OpenEQA包含两个任务:

(1)情节记忆EQA,在这个任务中,一个实体的AI Agent根据其对过去经历的回忆回答问题。

(2)主动EQA,在这个任务中,AI Agent必须在环境中采取行动来收集必要的信息并回答问题。

OpenEQA还配备了LLM-Match,这是一种用于评分开放词汇答案的自动评估指标。

下方是LLM-Match打分的流程,通过问题和场景的输入,AI大模型会给出回答,该回答会去和人类的回答作对比,然后得到相应的分数。

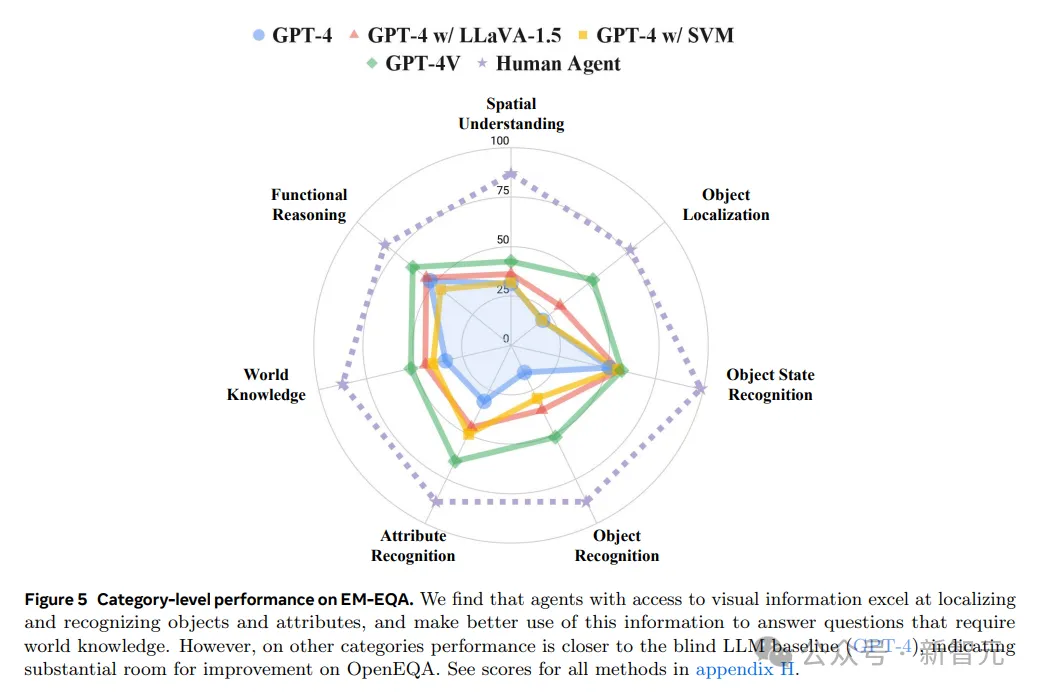

现阶段VLM的表现

一般来说,AI Agent的视觉能力是借助于视觉+语言基础模型(VLM)。

研究员使用OpenEQA来评估了几种最先进的VLM,发现即使是性能最好的模型(如GPT-4V达到48.5%),与人类的表现(85.9%)之间也存在着显著差距。

值得注意的是,对于需要空间理解的问题,即使是最好的VLM也几乎是「盲目」的,即它们的表现几乎不比仅文本模型更好。

例如,对于「我坐在客厅的沙发上看电视。我的身后是哪个房间?」这个问题,模型基本上是随机猜测不同的房间,没有从视觉情景记忆中获得对空间的理解。

这说明VLM其实是回归到文本中去捕捉关于世界的先验知识,以此来回答视觉问题。视觉信息并没有给它们带来实质性的好处。

这也说明,AI Agent在目前这个阶段,还达不到能完全理解物理世界的能力。

但气馁还为时过早,OpenEQA仅仅是第一个开放词汇的EQA基准。

通过OpenEQA将具有挑战性的开放词汇问题与以自然语言回答的能力结合起来,可以激发更多的研究,帮助AI理解并交流关于它所看到的世界的信息,也有助于研究人员跟踪多模态学习和场景理解的未来进展。

也不是没有可能,突然哪天AI Agent又给我们带来一个大惊喜呢?

参考资料:

https://ai.meta.com/blog/openeqa-embodied-question-answering-robotics-ar-glasses/

文章来自微信公众号“新智元”,作者:Mindy

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md