ICLR 全称为国际学习表征会议(International Conference on Learning Representations),今年举办的是第十二届,于 5 月 7 日至 11 日在奥地利维也纳展览会议中心举办。

在机器学习社区中,ICLR 是较为「年轻」的顶级学术会议,它由深度学习巨头、图灵奖获得者 Yoshua Bengio 和 Yann LeCun 牵头举办,2013 年才刚刚举办第一届。不过 ICLR 很快就获得了学术研究者们的广泛认可,被认为是深度学习的顶级会议。

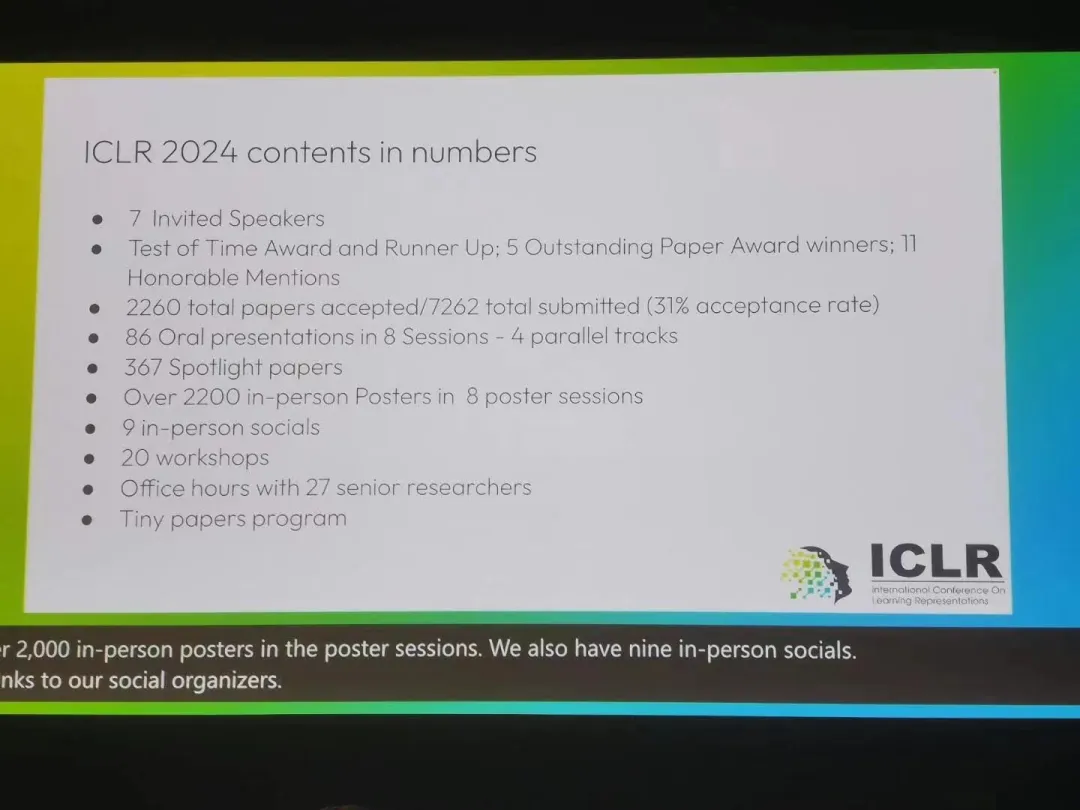

本届会议共收到了 7262 篇提交论文,接收 2260 篇,整体接收率约为 31%,与去年持平(31.8%)。此外 Spotlights 论文比例为 5%,Oral 论文比例为 1.2%。

相比于往年,无论是参会人数还是论文提交量,ICLR 的热度可以说是有极大的提升。

在近日公布的获奖论文中,大会评选出了 5 篇杰出论文奖和 11 篇荣誉提名奖。

论文:Generalization in diffusion models arises from geometry-adaptive harmonic representations

本文对图像扩散模型的泛化和记忆方面进行了重要的深入分析。作者通过实证研究了图像生成模型何时从记忆输入切换到泛化模式,并通过几何自适应谐波表示与谐波分析的思想建立联系,从架构归纳偏差的角度进一步解释了这一现象。本文涵盖了我们对视觉生成模型理解中缺失的关键部分,对未来研究启发巨大。

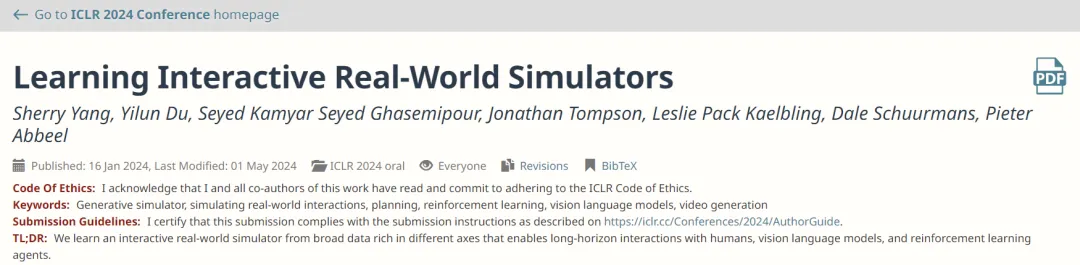

论文:Learning Interactive Real-World Simulators

跨多个来源聚合数据以训练机器人基础模型是一个长期目标。由于不同的机器人具有不同的感知运动接口,这给跨大规模数据集的训练带来了重大挑战。

UniSim,是朝着这个方向迈出的重要一步,也是一项工程壮举,它利用了基于视觉感知和控制的文本描述的统一接口来聚合数据,并通过利用视觉和语言领域的最新发展来训练机器人模拟器。

总结而言,本文探索了通过生成模型学习真实世界交互的通用模拟器 UniSim,迈出了构建通用模拟器的第一步。例如 UniSim 可以通过模拟「打开抽屉」等高级指令和低级指令的视觉结果来模拟人类和智能体如何与世界交互。

本文将大量数据(包括互联网文本 - 图像对,来自导航、人类活动、机器人动作等的丰富数据,以及来自模拟和渲染的数据)结合到一个条件视频生成框架中。然后通过仔细编排沿不同轴的丰富数据,本文表明 UniSim 可以成功地合并不同轴数据的经验并泛化到数据之外,通过对静态场景和对象的细粒度运动控制来实现丰富的交互。

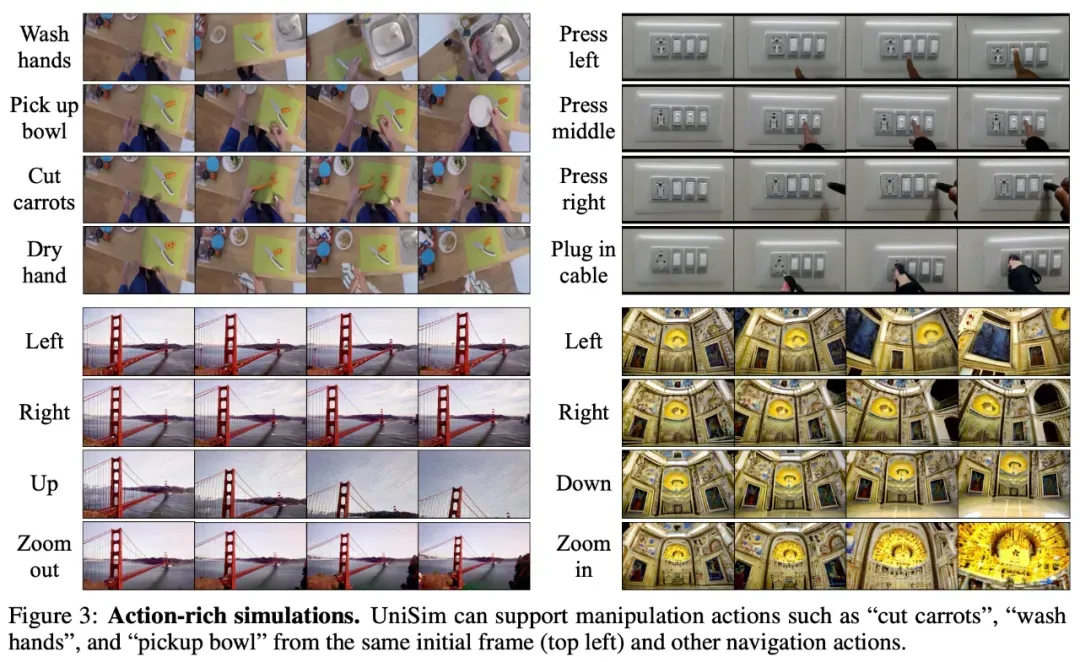

如下图 3 所示,UniSim 能够模拟一系列丰富动作,例如厨房场景中洗手、拿碗、切胡萝卜、擦干手这一系列动作;图 3 右上是按下不同的开关;图 3 下是两个导航场景。

论文:Never Train from Scratch: Fair Comparison of Long-Sequence Models Requires Data-Driven Priors

这篇论文深入探讨了最近提出的状态空间模型和 transformer 架构对建模长期序列依赖性的能力。

令人惊讶的是,作者发现从头开始训练 transformer 模型会导致其性能被低估,并且通过预训练和微调设置可以实现显著的性能提升。该论文在关注简洁性和系统性见解方面表现极佳。

论文:Protein Discovery with Discrete Walk-Jump Sampling

这篇论文解决了基于序列的抗体设计问题,这是蛋白质序列生成模型的一个及时而重要的应用。

为此,作者引入了一种创新而有效的新建模方法,用来专门针对处理离散蛋白质序列数据的问题。除了在硅中验证该方法外,作者还进行了大量的湿法实验室实验,以测量体外抗体结合亲和力,展示了他们生成方法的有效性。

论文:Vision Transformers Need Registers

该篇论文识别了 vision transformer 网络的特征图中的人工痕迹,这些痕迹以低信息背景区域中的高范数 tokens 为特征。

作者提出了这种现象发生的关键假设,并提供了一个简单而优雅的解决方案,使用额外的 register tokens 来解决这些痕迹,从而增强了模型在各种任务上的性能。从这项工作中获得的见解还可以影响其他应用领域。

这篇论文行文极佳,为进行研究提供了一个很好的示范:「识别问题,理解其发生的原因,然后提出解决方案。」

11 篇荣誉提名

除了 5 篇杰出论文,ICLR 2024 还评选出了 11 篇荣誉提名奖。

论文:Amortizing intractable inference in large language models

这篇论文从贝叶斯推理的角度提出了一种在大型语言模型中替代自回归解码的有前景的方法,这可能会激发后续研究。

论文:Approximating Nash Equilibria in Normal-Form Games via Stochastic Optimization

这是一篇写得非常清晰的论文,对解决开发高效且可扩展的纳什求解器这一重要问题意义重大。

论文:Beyond Weisfeiler-Lehman: A Quantitative Framework for GNN Expressiveness

GNN 的表达能力是一个重要课题,而当前的解决方案仍然存在很大的局限性。作者提出了一种基于同态计数的新表达理论(expressivity theory)。

论文:Flow Matching on General Geometries

本文探讨了在一般几何流形上进行生成建模这一具有挑战性但又十分重要的问题,并提出了一种实用且高效的算法。本文的呈现非常出色,并在广泛的任务上进行了全面的实验验证。

论文:Is ImageNet worth 1 video? Learning strong image encoders from 1 long unlabelled video

本文提出了一种新颖的自监督图像预训练方法,即通过从连续视频中学习。本文既贡献了新类型的数据,也贡献了一种从新数据中学习的方法。

论文:Meta Continual Learning Revisited: Implicitly Enhancing Online Hessian Approximation via Variance Reduction

作者提出了一种新的元连续学习方差减少方法。该方法表现良好,不仅具有实际影响,而且还得到了 regret 分析的支持。

论文:Model Tells You What to Discard: Adaptive KV Cache Compression for LLMs

本文针对 KV 缓存压缩问题(该问题对基于 Transformer 的 LLM 影响很大),通过一个简单的想法来减少内存,并且无需耗费大量资源进行微调或重新训练即可部署。这种方法非常简单,事实证明它非常有效。

论文:Proving Test Set Contamination in Black-Box Language Models

本文使用了一个简单而优雅的方法,用于测试受监督的学习数据集是否已被包含在大型语言模型的训练中。

论文:Robust agents learn causal world models

这篇论文在奠定理论基础方面取得了长足进展,以便理解因果推理在智能体推广到新领域的能力中所起到的作用,对一系列相关领域也产生了影响。

论文:The mechanistic basis of data dependence and abrupt learning in an in-context classification task

这是一项及时而极其系统性的研究,探讨了我们在开始理解这些现象的时候,in-context 学习与 in-weight 学习之间的机制。

论文:Towards a statistical theory of data selection under weak supervision

这篇论文为数据子集选择建立了统计基础,并确定了流行的数据选择方法的缺点。

本文来自微信公众号“机器之心”

【开源免费】Browser-use 是一个用户AI代理直接可以控制浏览器的工具。它能够让AI 自动执行浏览器中的各种任务,如比较价格、添加购物车、回复各种社交媒体等。

项目地址:https://github.com/browser-use/browser-use

【开源免费】suno-api是一个使用监听技术实现了调用suno功能,并封装好API的AI音乐项目。

项目地址:https://github.com/gcui-art/suno-api

【开源免费】AutoGPT是一个允许用户创建和运行智能体的(AI Agents)项目。用户创建的智能体能够自动执行各种任务,从而让AI有步骤的去解决实际问题。

项目地址:https://github.com/Significant-Gravitas/AutoGPT

【开源免费】MetaGPT是一个“软件开发公司”的智能体项目,只需要输入一句话的老板需求,MetaGPT即可输出用户故事 / 竞品分析 / 需求 / 数据结构 / APIs / 文件等软件开发的相关内容。MetaGPT内置了各种AI角色,包括产品经理 / 架构师 / 项目经理 / 工程师,MetaGPT提供了一个精心调配的软件公司研发全过程的SOP。

项目地址:https://github.com/geekan/MetaGPT/blob/main/docs/README_CN.md

【开源免费】XTuner 是一个高效、灵活、全能的轻量化大模型微调工具库。它帮助开发者提供一个简单易用的平台,可以对大语言模型(LLM)和多模态图文模型(VLM)进行预训练和轻量级微调。XTuner 支持多种微调算法,如 QLoRA、LoRA 和全量参数微调。

项目地址:https://github.com/InternLM/xtuner