在上一篇文章「Unsloth微调Llama3-8B,提速44.35%,节省42.58%显存,最少仅需7.75GB显存」中,我们介绍了Unsloth,这是一个大模型训练加速和显存高效的训练框架,我们已将其整合到Firefly训练框架中,并且对Llama3-8B的训练进行了测试,Unsloth可大幅提升训练速度和减少显存占用。

遗憾的是,Unsloth目前并不支持Qwen2模型结构,该需求在Unsloth的issue中也被频繁提及,但官方在短期内暂时没有支持Qwen2的计划,更多的是建议用户对Qwen2的权重进行Llama化,然后采用Llama的训练方式。但对Qwen2的权重进行Llama化后,模型性能有显著的下降。注:本文提及的Qwen2指的是模型结构,而非模型权重,Qwen1.5模型属于Qwen2模型结构,Qwen2模型权重尚未开源。

Qwen系列模型具有非常大的用户基数,目前开源的Qwen1.5模型可以视为Qwen2的preview版本,它在中英文任务上具有非常优秀的表现,一度取得中英文开源模型的SOTA,且后续还将继续开源正式版本的Qwen2模型。

基于上述现状,Firefly项目组尝试对Unsloth进行扩展,使其能够支持Qwen2模型进行训练,并且我们取得了不错的效果。在训练测试中,Qwen1.5-7B最少仅需8.43GB显存,这意味着我们可以在一张1080Ti上训练Qwen1.5-7B。开启Unsloth后,Qwen1.5-7B的训练速度可提升47.32%,训练时间可减少32.12%,显存占用可减少39.13%。我们在????Open LLM Leaderboard中验证了模型和训练方法的有效性,更多详情见第三节。

Firefly项目链接:

https://github.com/yangjianxin1/Firefly

Unsloth x Qwen2项目链接:

https://github.com/yangjianxin1/unsloth

模型权重:

https://huggingface.co/YeungNLP/firefly-qwen1.5-en-7b-unsloth

https://huggingface.co/YeungNLP/firefly-qwen1.5-en-7b-dpo-v0.1-unsloth

我们对Unsloth进行了扩展,使其能够支持对Qwen2模型进行训练,扩展后的代码仓库如下:

https://github.com/yangjianxin1/unsloth

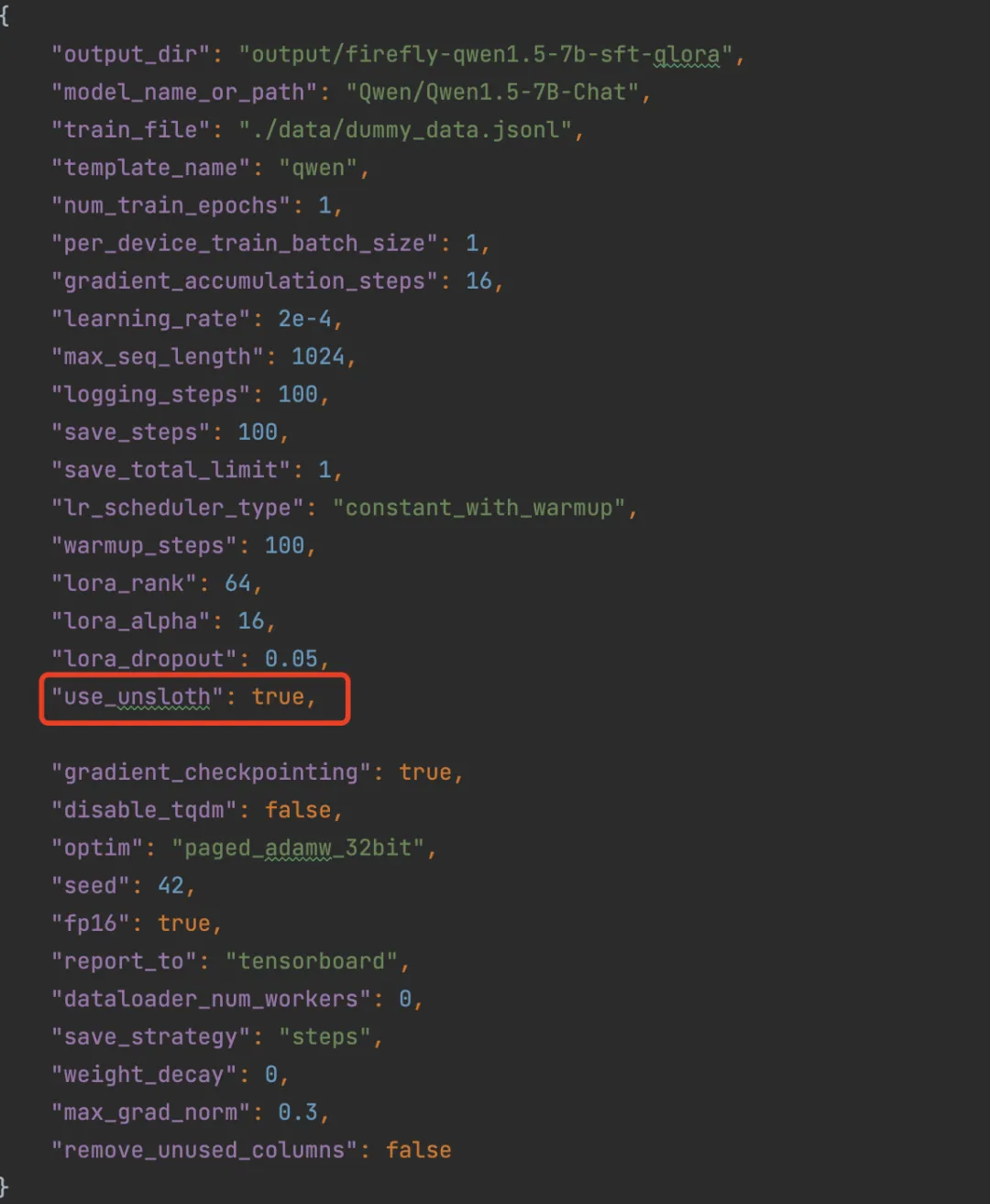

使用Unsloth训练Qwen2,需要更新或者安装如下python包:

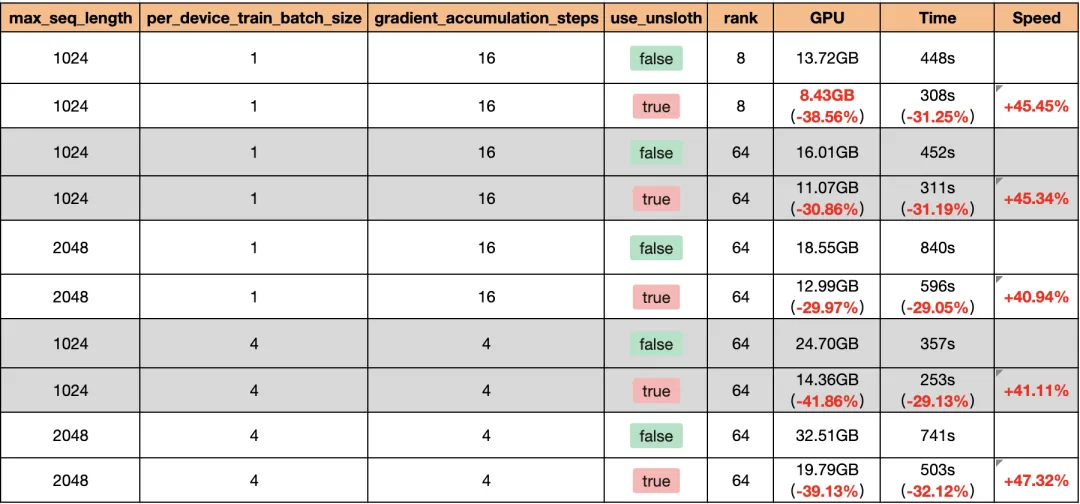

我们首先测试了Unsloth对Qwen2的训练增益,在一张V100上对Qwen1.5-7B进行QLoRA训练,使用相同的数据集训练20步,开启gradient_checkpointing,每条数据均padding至max_seq_length,在所有linear层均插入adapter,由于V100不支持Flash Attention,所以本测试未开启Flash Attention。Unsloth所带来的训练增益如下表所示。

结合QLoRA与Unsloth训练Qwen1.5-7B,最少仅需8.43GB显存,开启Unsloth后,Qwen1.5-7B的训练速度可提升47.32%,训练时间可减少32.12%,显存占用可减少39.13%。

我们在????Open LLM Leaderboard上对上述SFT与DPO模型进行评测。在该榜单中,我们的模型的平均表现显著优于官方的Qwen1.5-7B-Chat、Gemma-7B-it等模型。

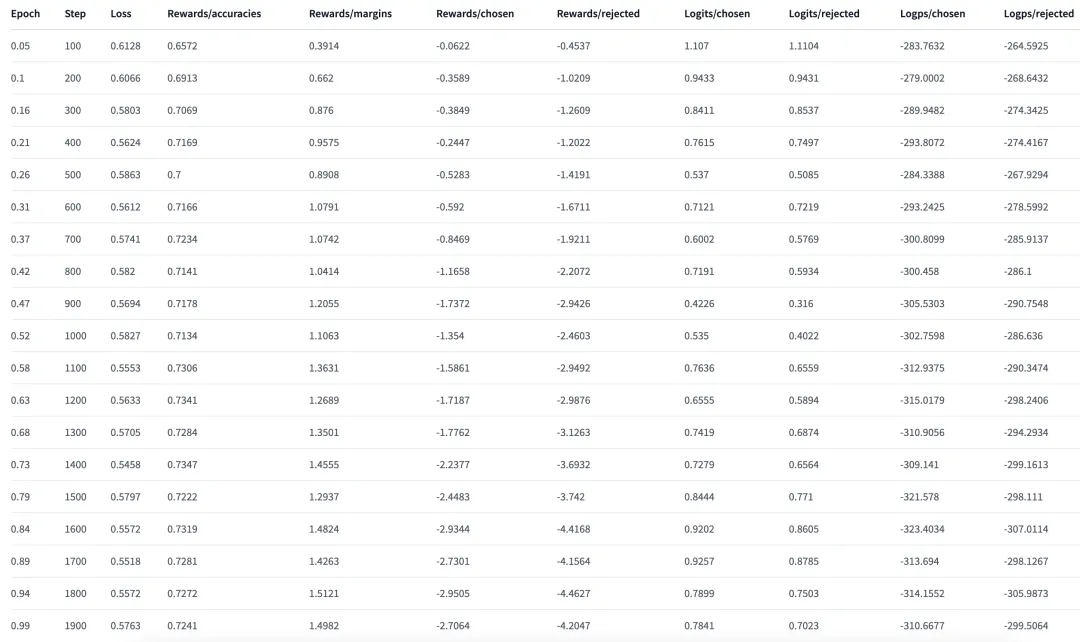

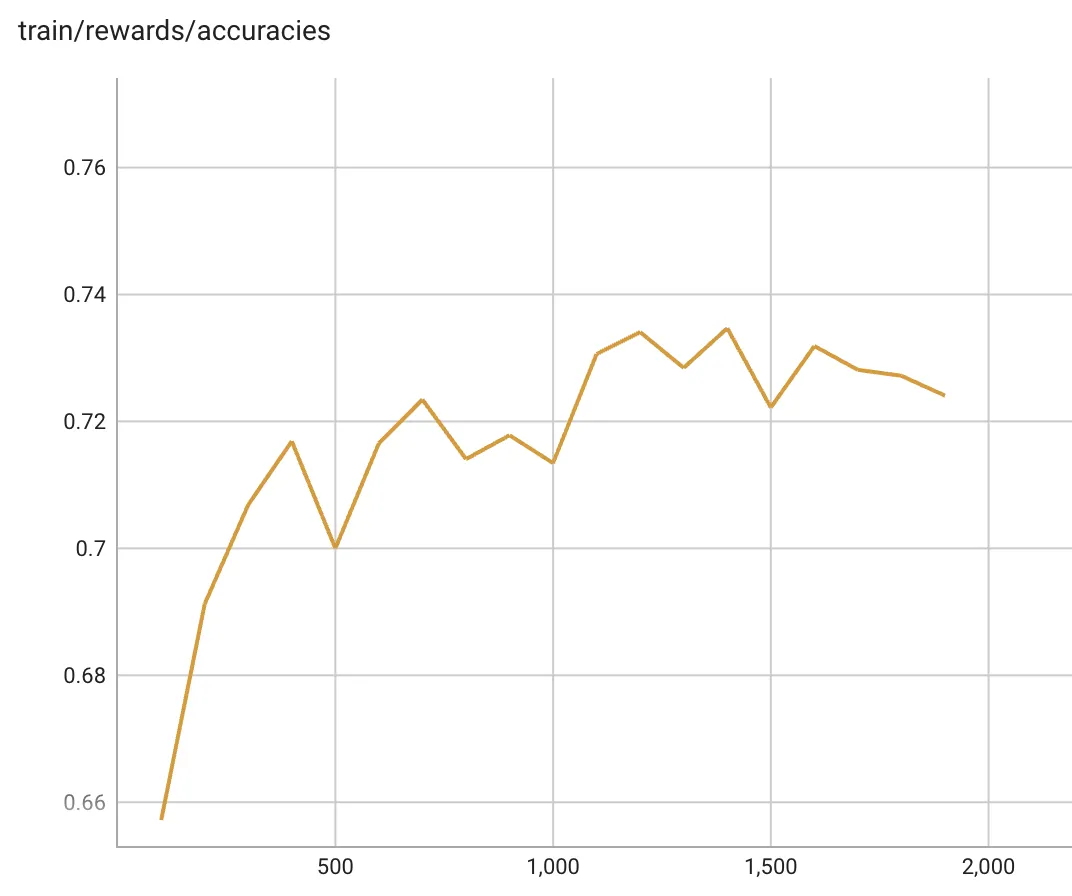

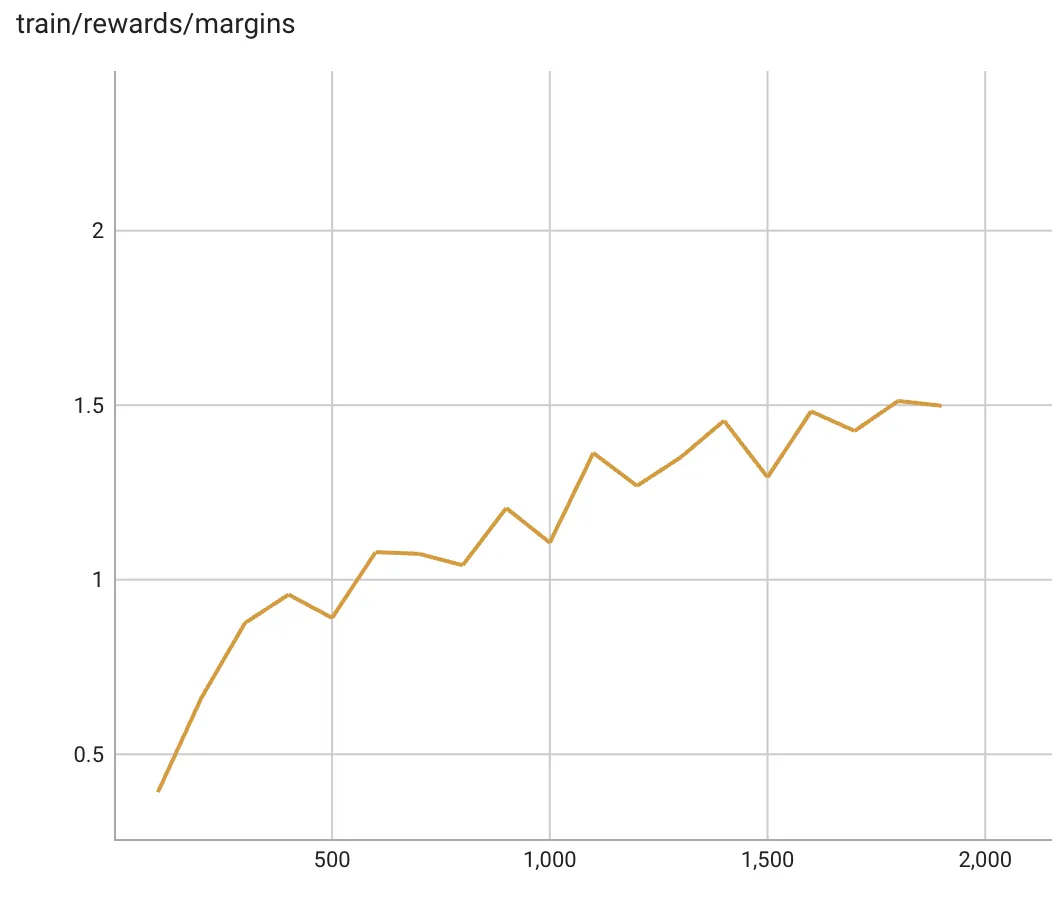

DPO训练过程中的训练指标的变化如下图所示。在训练过程中,Rewards/accuracies和Rewards/margins均处于上升趋势。

DPO训练中的Rewards/accuracies的变化趋势如下,该指标表示较优回答的奖励大于较劣回答的奖励的频率的均值:

DPO训练的Rewards/margins变化趋势如下,该指标表示较优回答的奖励与较劣回答的奖励二者之差的均值:

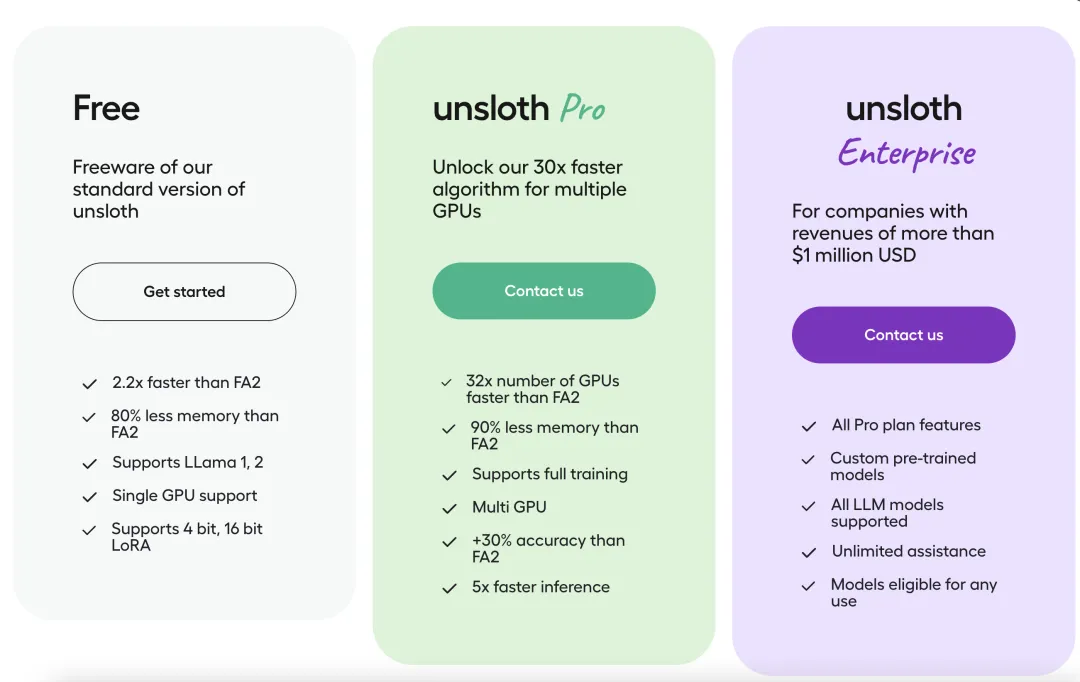

Unsloth是一个非常优秀的项目,通过优化梯度计算、优化链式矩阵乘法、使用Triton重写内核等手段,达到提升训练速度,减少显存占用的目的。但目前开源版本的Unsloth仅仅是一个尝鲜版,仅支持单机单卡训练,但已足够惊艳,商业版Unsloth则有着更加强劲的提升。

这意味着,在算力不变的情况下,通过软件或者算法层面的优化,大模型训练的成本和速度还有非常大的进步空间,可以预见大模型训练的硬件门槛也将越来越低。最后,期待开源社区的力量,让开源版的Unsloth更加完善。

本文来自微信公众号“YeungNLP”,作者 荷风微摆